- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

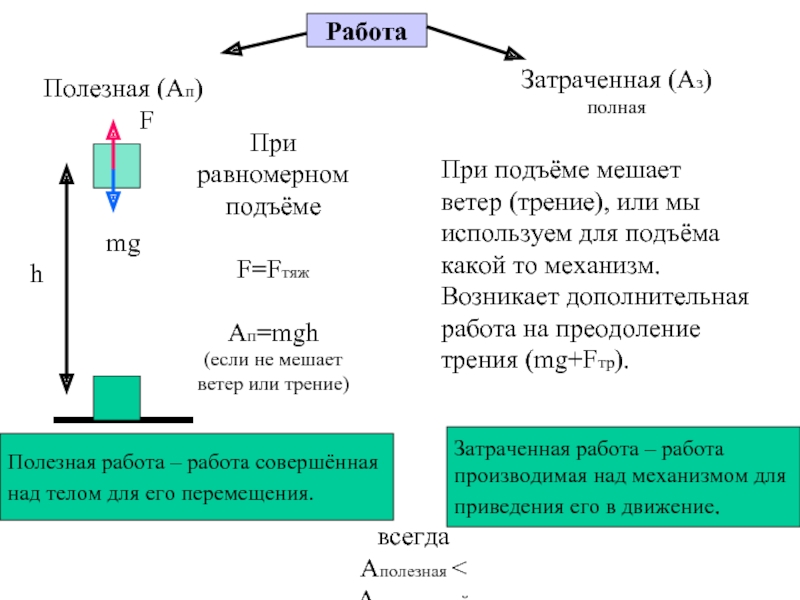

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Высокопроизводительные вычисления, закон Мура презентация

Содержание

- 1. Высокопроизводительные вычисления, закон Мура

- 2. Введение, закон Мура Рост производительности обеспечивался с

- 3. Первая часть произведения — количество инструкций,

- 4. Параллельность Процессор, который умеет сам определять независимые

- 5. Под параллельными вычислениями понимают обработку данных, при

- 6. При рассмотрении проблемы организации параллельных вычислений следует

- 7. Параллелизм на уровне данных Векторные процессоры относятся

- 8. Классификация вычислительных систем SISD (Single Instruction, Single

- 10. Мультиархитектуры MIMD (Multiple Instruction stream, Multiple Data

- 12. Мультипроцессор Мультипроцессор — это компьютерная система, которая содержит

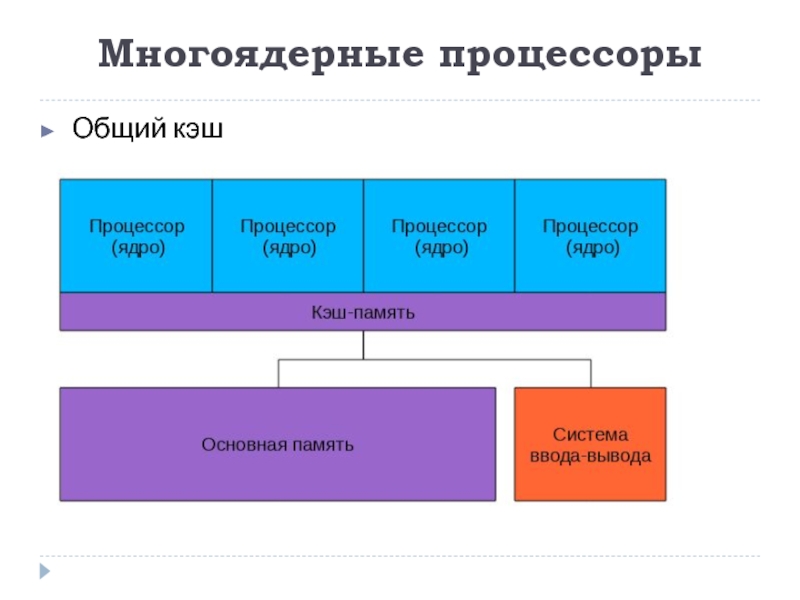

- 13. Многоядерные процессоры Общий кэш

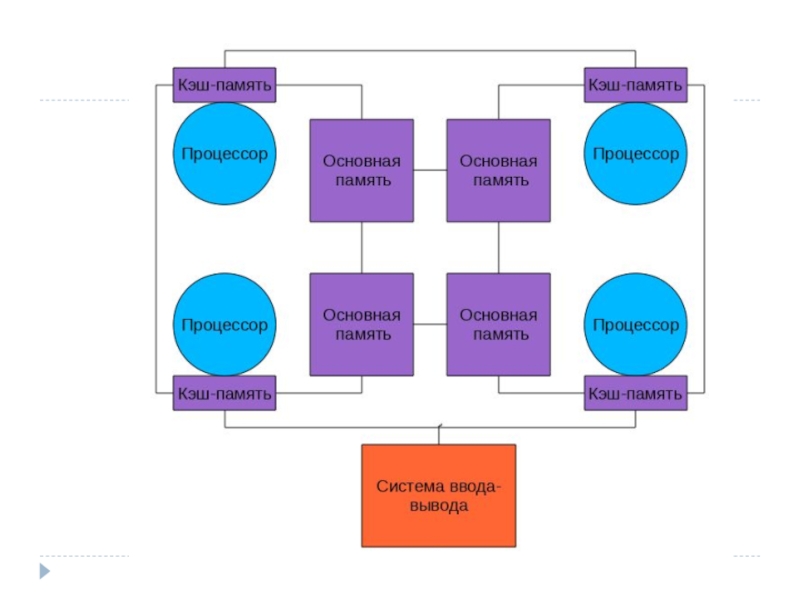

- 14. NUMA NUMA (Non-Uniform Memory Access — «неравномерный

Слайд 2Введение, закон Мура

Рост производительности обеспечивался с помощью уменьшения размеров элементов микропроцессоров.

Оказалось, частоту дальше повышать нельзя — растут токи утечки, процессоры перегреваются и обойти это не получается.

Закон Мура, по которому число транзисторов и связанная с ним производительность компьютеров удваивалась каждые полтора-два года оказался сомнительным.

Слайд 3

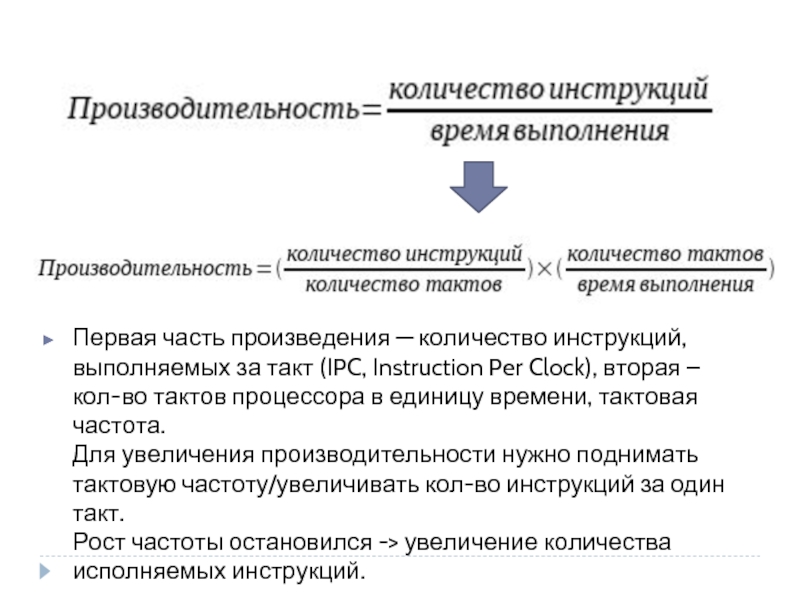

Первая часть произведения — количество инструкций, выполняемых за такт (IPC, Instruction

Слайд 4Параллельность

Процессор, который умеет сам определять независимые и непротиворечащие друг другу инструкции

Пример:

А=1

В=2

С=А+В

EPIC (explicitly parallel instruction computing) — микропроцессорная архитектура с явным параллелизмом команд. …..?

Hyper Threading …..?

Технологии параллелизма на уровне инструкций активно развивались в 90е и первую половину 2000х годов, но в настоящее время их потенциал практически исчерпан

Слайд 5Под параллельными вычислениями понимают обработку данных, при которой одновременно выполняется несколько

Дополнительной формой вычислений является конвейерная реализация обрабатывающих устройств.

Параллельность

Слайд 6При рассмотрении проблемы организации параллельных вычислений следует различать следующие возможные режимы

параллельное выполнение - в один и тот же момент времени может выполняться несколько команд обработки данных

распределенные вычисления - параллельная обработка данных, при которой используется несколько обрабатывающих устройств

многозадачный режим (режим разделения времени) - для выполнения процессов используется единственный процессор

Слайд 7Параллелизм на уровне данных

Векторные процессоры

относятся к SIMD — (single instruction, multiple data

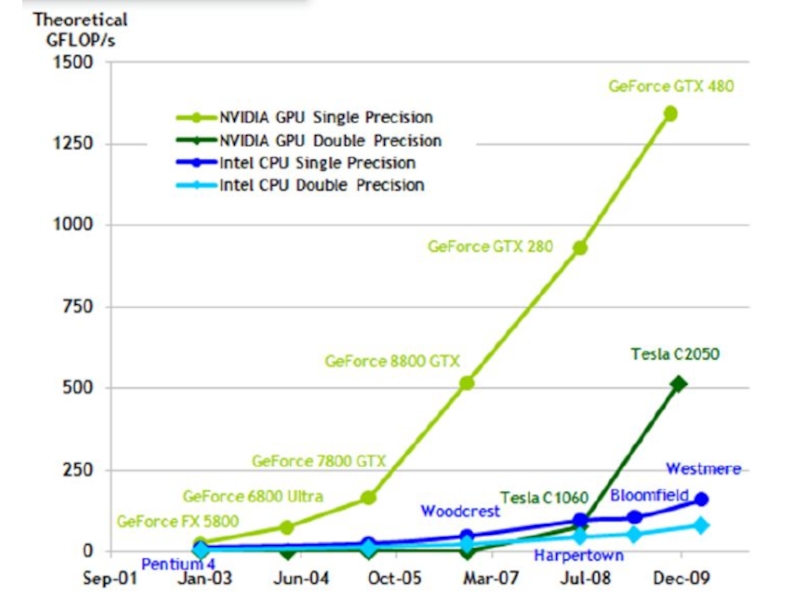

Графические процессоры

SIMT — (single instruction, multiple threads, одна инструкция — множество потоков). Так же как в SIMD операции производятся с массивами данных, но степеней свободы гораздо больше — для каждой ячейки обрабатываемых данных работает отдельная нить команд.

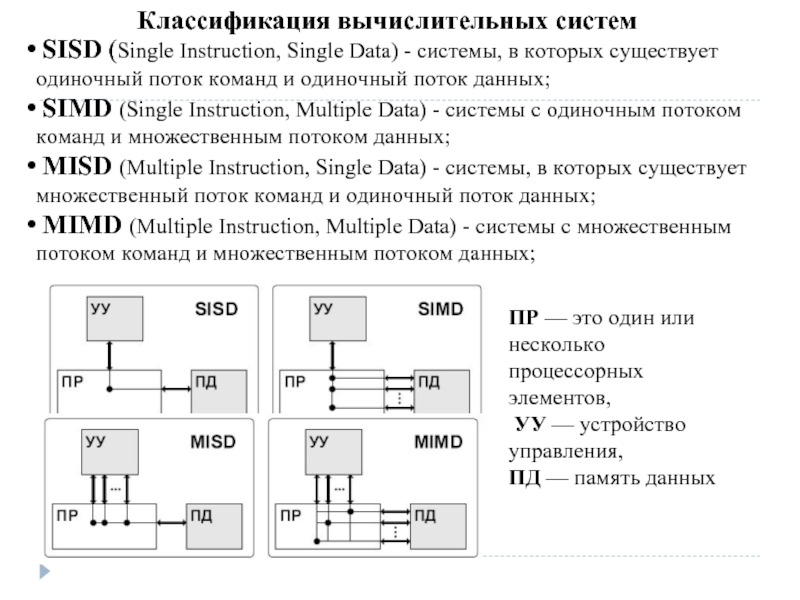

Слайд 8Классификация вычислительных систем

SISD (Single Instruction, Single Data) - системы, в которых

SIMD (Single Instruction, Multiple Data) - системы c одиночным потоком команд и множественным потоком данных;

MISD (Multiple Instruction, Single Data) - системы, в которых существует множественный поток команд и одиночный поток данных;

MIMD (Multiple Instruction, Multiple Data) - системы c множественным потоком команд и множественным потоком данных;

ПР — это один или несколько процессорных элементов,

УУ — устройство управления,

ПД — память данных

Слайд 10Мультиархитектуры

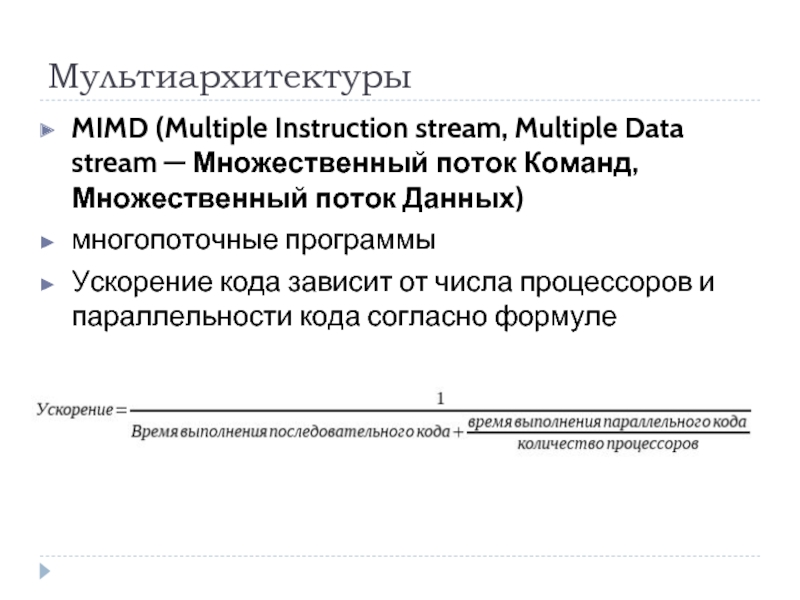

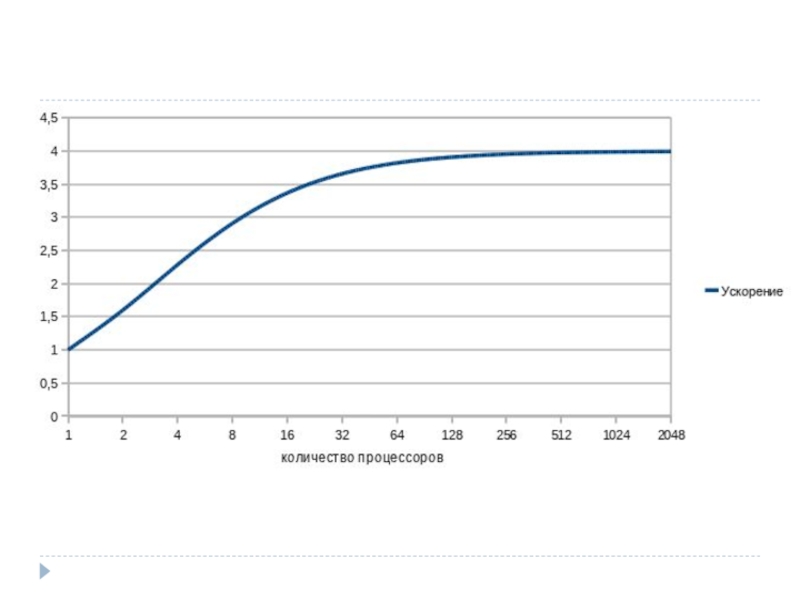

MIMD (Multiple Instruction stream, Multiple Data stream — Множественный поток Команд,

многопоточные программы

Ускорение кода зависит от числа процессоров и параллельности кода согласно формуле

Слайд 12Мультипроцессор

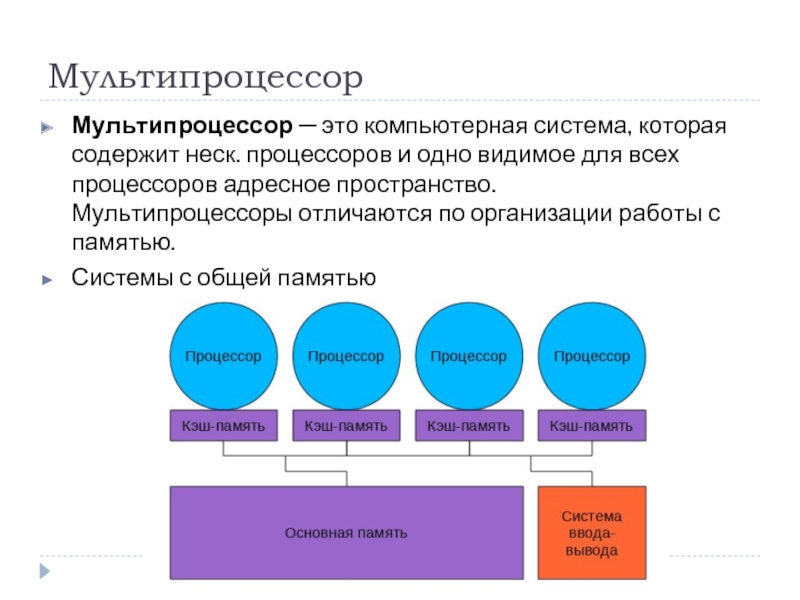

Мультипроцессор — это компьютерная система, которая содержит неск. процессоров и одно видимое

Системы с общей памятью