- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

OpenMP презентация

Содержание

- 1. OpenMP

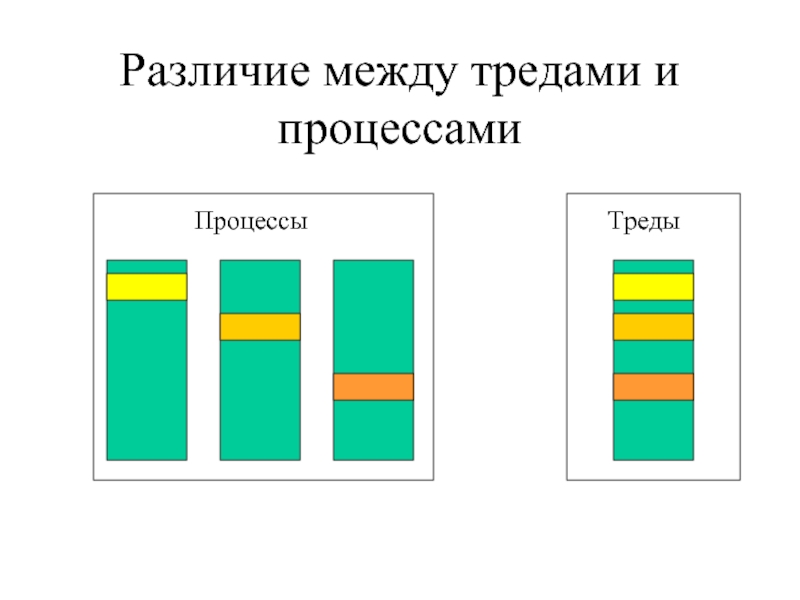

- 2. Различие между тредами и процессами

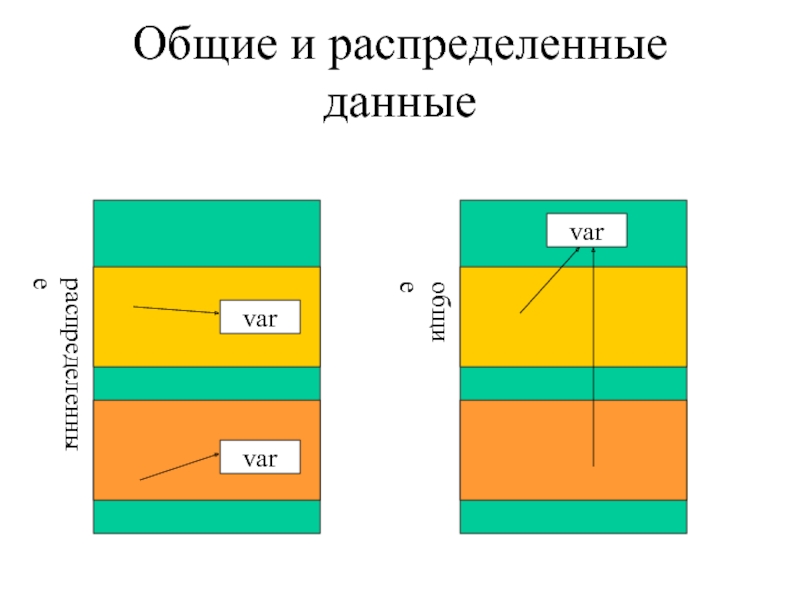

- 3. Общие и распределенные данные var var var распределенные общие

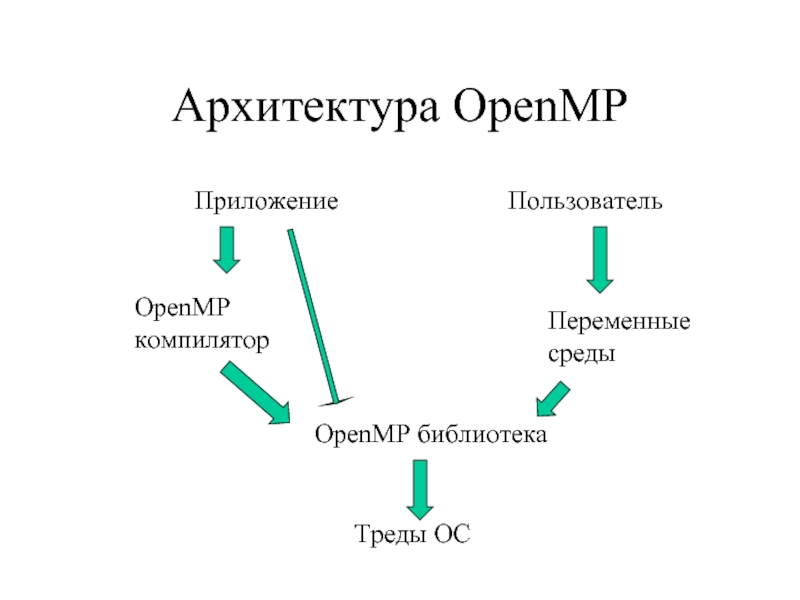

- 4. Архитектура OpenMP Приложение OpenMP компилятор

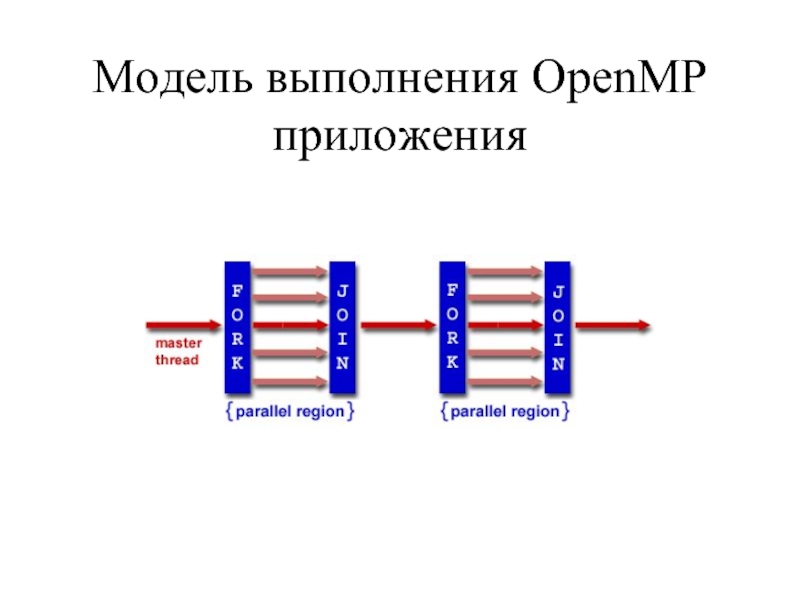

- 5. Модель выполнения OpenMP приложения

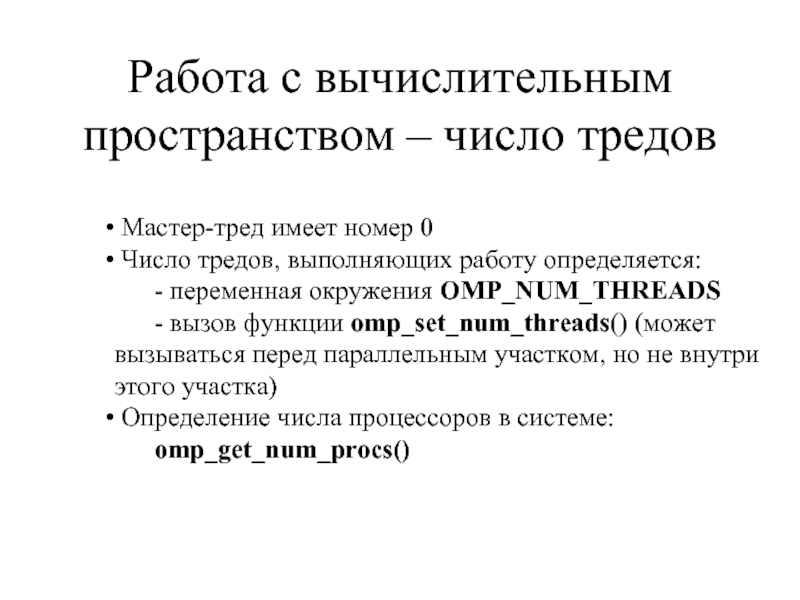

- 6. Работа с вычислительным пространством – число тредов

- 7. Работа с вычислительным пространством – динамическое определение

- 8. Определение числа процессоров, тредов и своих координат

- 9. #include #include #include main(int

- 10. Общий синтаксис директив OpenMP #pragma omp directive_name

- 11. Директива parallel Данная директива – единственный

- 12. #include main () {

- 13. Опции для данных Данные, видимые в области,

- 14. Опция firstprivate обладает той же семантикой,

- 15. Опция default Опция default задает опцию

- 16. опция reduction Опция reduction определяет что

- 17. Глобальные общие данные Проблема: опция private «работает»

- 18. Директива threadprivate #omp threadprivate (список глобальных переменных)

- 19. Опция copyin Опция copyin директивы

- 20. Управление распределением вычислений Для распределения вычислений

- 21. Директива for #pragma omp for [clause ...]

- 22. Директива предшествует циклу for канонического типа:

- 23. incr_expr ::= var ++ ++ var

- 24. Опция shedule директивы for Опция shedule допускает

- 25. Особенности опции schedule директивы for

- 26. #include #include #include main(int

- 27. #include #include #include #include

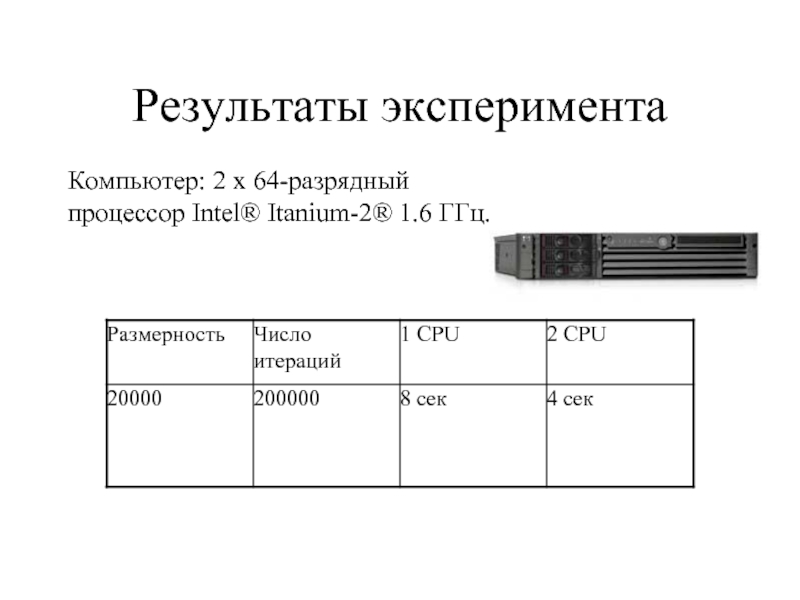

- 28. Результаты эксперимента Компьютер: 2 x 64-разрядный процессор Intel® Itanium-2® 1.6 ГГц.

- 29. Директива sections #pragma omp sections [clause ...]

- 30. Опция lastprivate обладает той же семантикой,

- 31. Директива single #pragma omp single [clause ...]

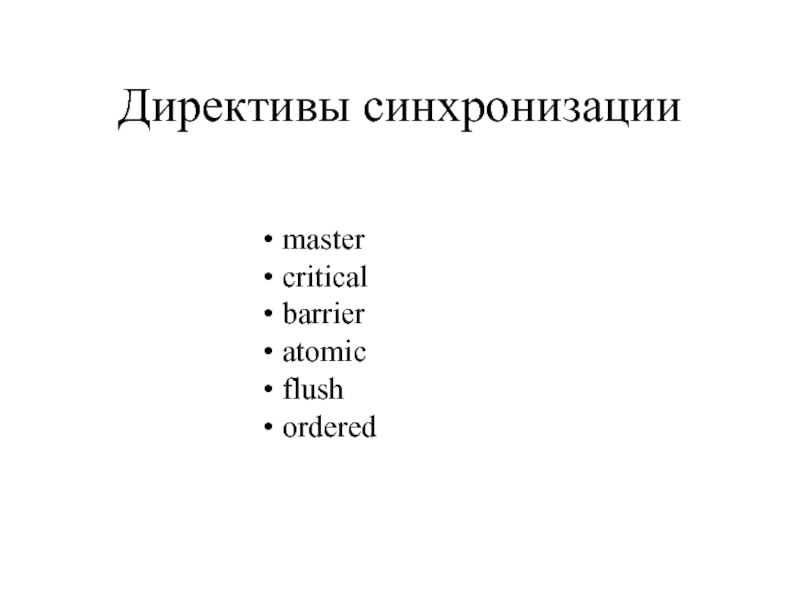

- 32. Директивы синхронизации master critical barrier atomic flush ordered

- 33. #pragma omp master определяет секцию кода, выполняемого

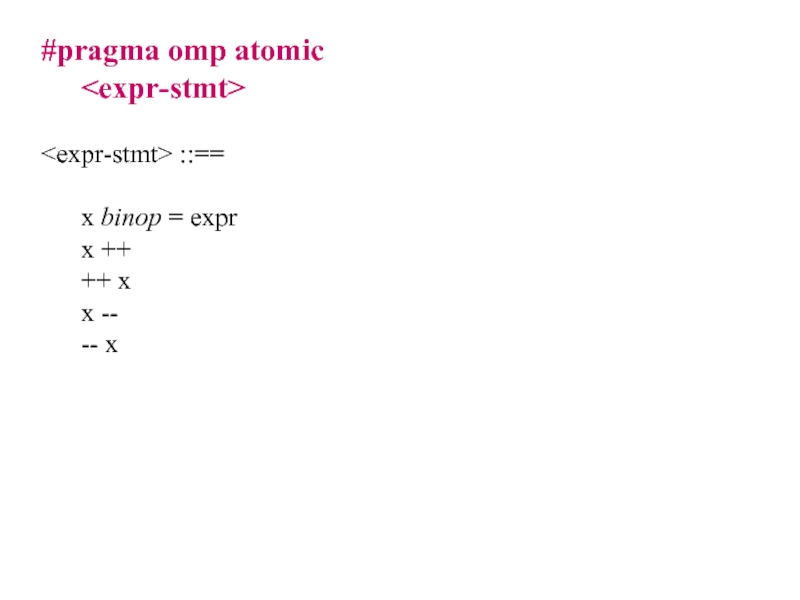

- 34. #pragma omp atomic ::==

- 35. #paragma omp flush [var-list] ::==

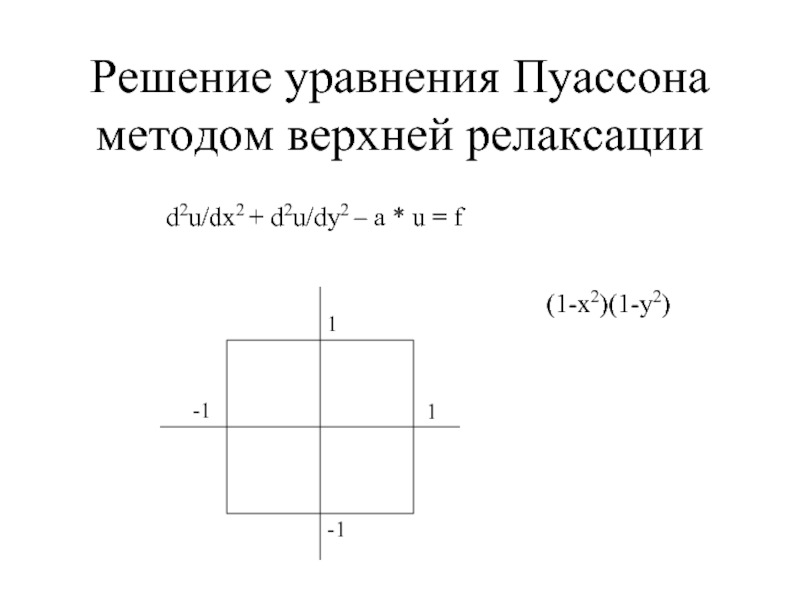

- 36. Решение уравнения Пуассона методом верхней релаксации d2u/dx2

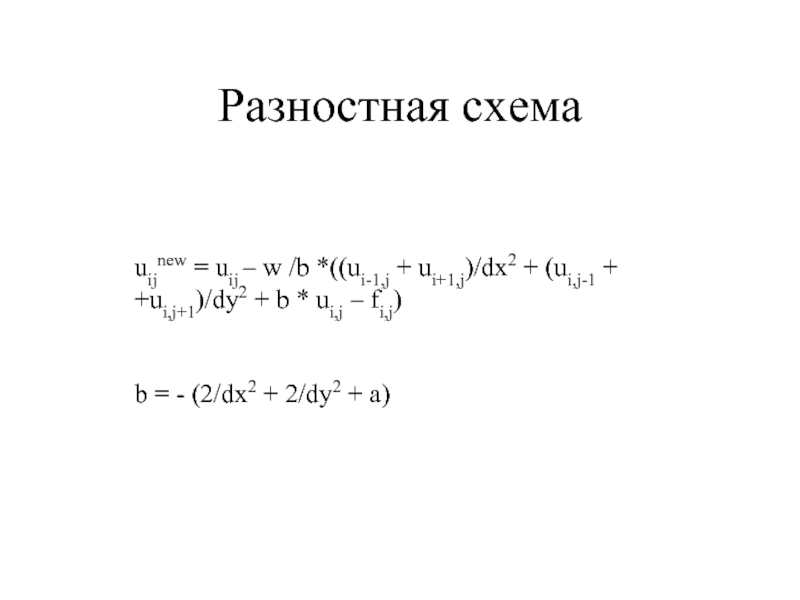

- 37. Разностная схема uijnew = uij – w

- 38. jacobi.f.txt

Слайд 4Архитектура OpenMP

Приложение

OpenMP

компилятор

OpenMP библиотека

Треды ОС

Пользователь

Переменные

среды

Слайд 6Работа с вычислительным пространством – число тредов

Мастер-тред имеет номер 0

- переменная окружения OMP_NUM_THREADS

- вызов функции omp_set_num_threads() (может вызываться перед параллельным участком, но не внутри этого участка)

Определение числа процессоров в системе: omp_get_num_procs()

Слайд 7Работа с вычислительным пространством – динамическое определение числа тредов

В некоторых случаях

Включить данную опцию можно с помощью переменной среды

OMP_DYNAMIC [TRUE, FALSE]

или с помощью функции omp_set_dynamic(int flag) (может вызываться перед параллельным участком, но не внутри этого участка)

Если flag != 0 , то механизм включается, в противном случае – выключается.

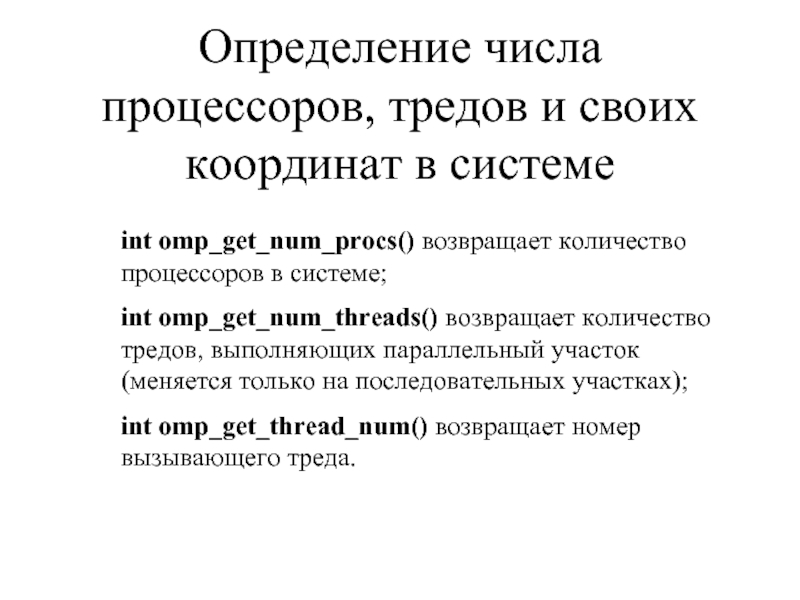

Слайд 8Определение числа процессоров, тредов и своих координат в системе

int omp_get_num_procs() возвращает

int omp_get_num_threads() возвращает количество тредов, выполняющих параллельный участок (меняется только на последовательных участках);

int omp_get_thread_num() возвращает номер вызывающего треда.

Слайд 9#include

#include

#include

main(int argc, char* argv[])

{

omp_set_num_threads(atoi(argv[1]));

printf("Total

#pragma omp parallel printf("Hello, World from thread %d of %d\n", omp_get_thread_num(), omp_get_num_threads()); }

Слайд 10Общий синтаксис директив OpenMP

#pragma omp directive_name [clause[clause ...]] newline

Действия, соответствующие директиве

непосредственно к структурному блоку, расположенному за

директивой. Структурным блоком может быть любой оператор,

имеющий единственный вход и единственный выход.

Если директива расположена на файловом уровне видимости, то

она применяется ко всему файлу.

Слайд 11Директива parallel

Данная директива – единственный способ инициировать

параллельное выполнение программы.

#pragma omp parallel

clause: if (scalar_expression)

private (list)

shared (list)

default (shared | none)

firstprivate (list)

reduction (operator: list)

copyin (list)

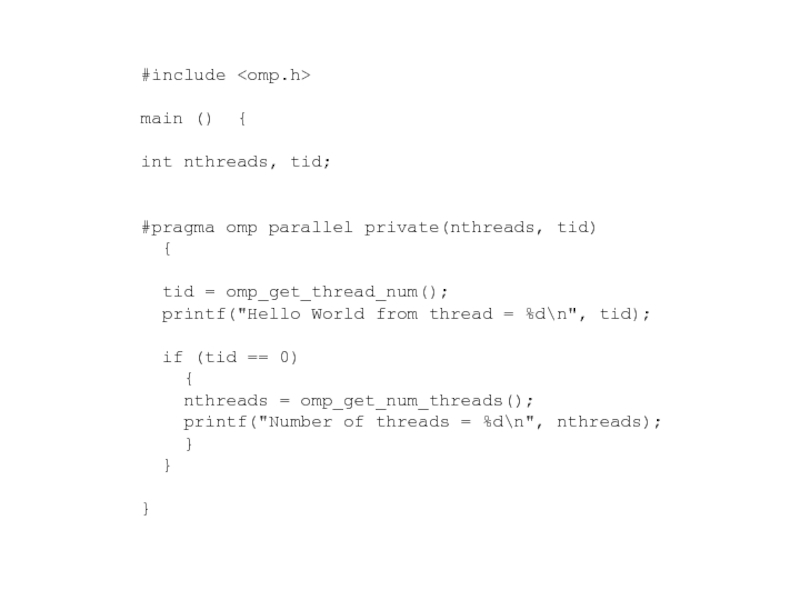

Слайд 12#include

main () {

int nthreads, tid;

#pragma omp parallel private(nthreads, tid)

{

printf("Hello World from thread = %d\n", tid);

if (tid == 0)

{

nthreads = omp_get_num_threads();

printf("Number of threads = %d\n", nthreads);

}

}

}

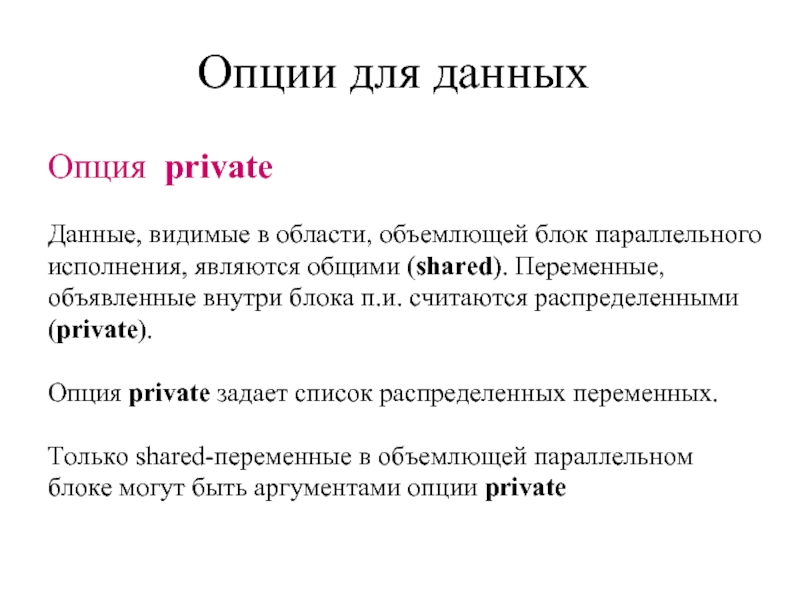

Слайд 13Опции для данных

Данные, видимые в области, объемлющей блок параллельного

исполнения, являются общими

объявленные внутри блока п.и. считаются распределенными

(private).

Опция private задает список распределенных переменных.

Только shared-переменные в объемлющей параллельном блоке могут быть аргументами опции private

Опция private

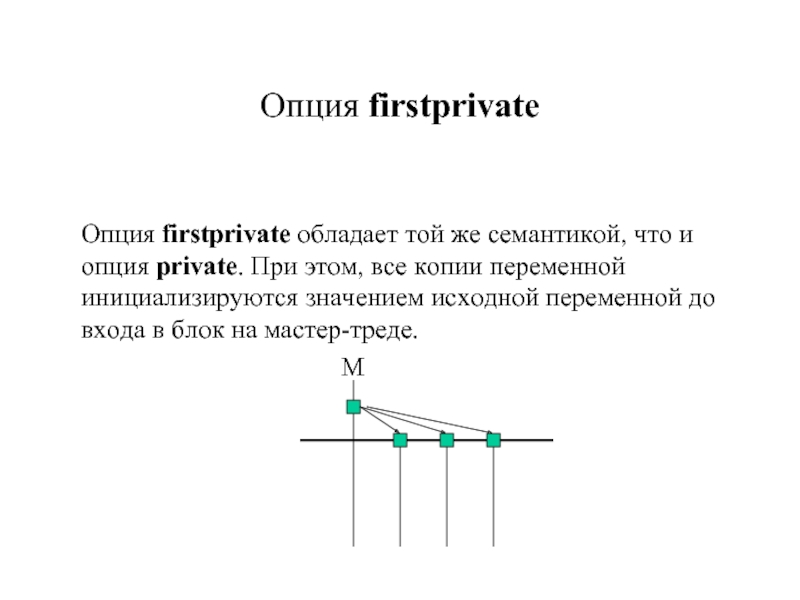

Слайд 14

Опция firstprivate обладает той же семантикой, что и

опция private. При

Опция firstprivate

М

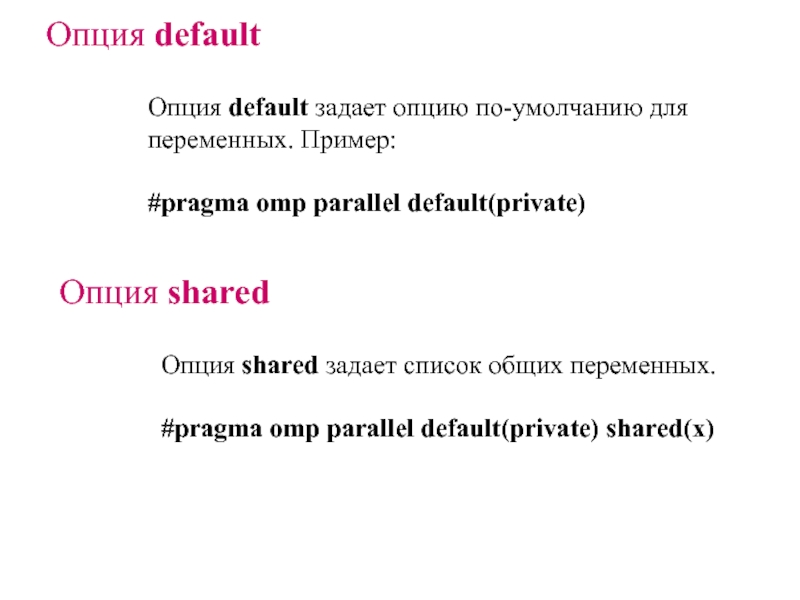

Слайд 15Опция default

Опция default задает опцию по-умолчанию для

переменных. Пример:

#pragma omp parallel default(private)

Опция

Опция shared задает список общих переменных.

#pragma omp parallel default(private) shared(x)

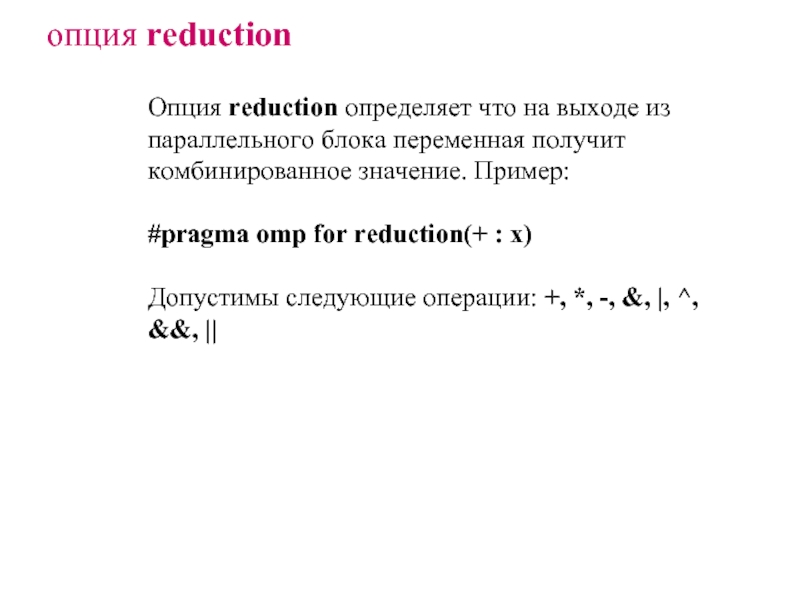

Слайд 16опция reduction

Опция reduction определяет что на выходе из параллельного блока переменная

#pragma omp for reduction(+ : x)

Допустимы следующие операции: +, *, -, &, |, ^, &&, ||

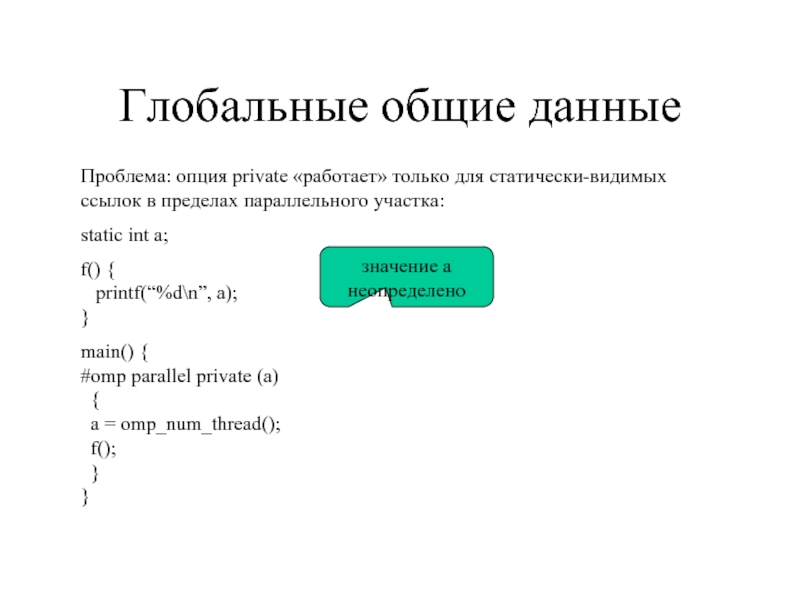

Слайд 17Глобальные общие данные

Проблема: опция private «работает» только для статически-видимых ссылок в

static int a;

f() { printf(“%d\n”, a); }

main() { #omp parallel private (a) { a = omp_num_thread(); f(); } }

значение a неопределено

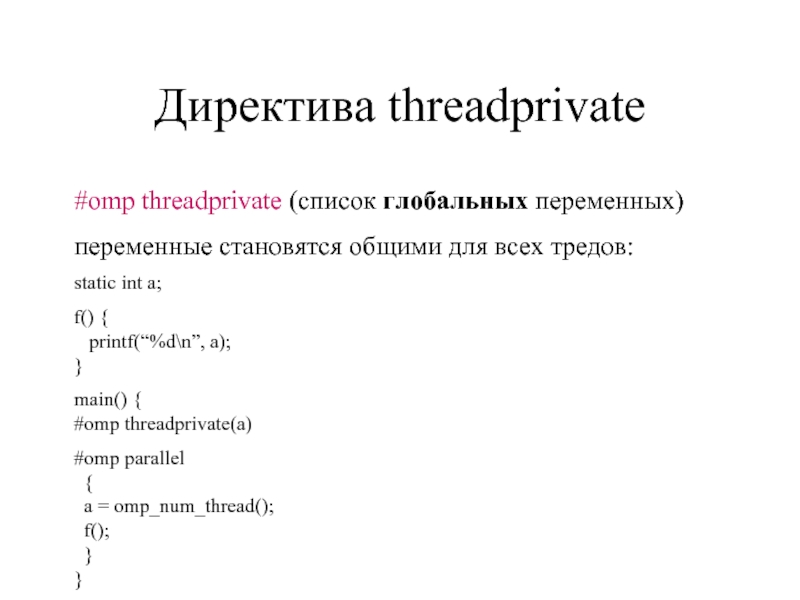

Слайд 18Директива threadprivate

#omp threadprivate (список глобальных переменных)

переменные становятся общими для всех тредов:

static

f() { printf(“%d\n”, a); }

main() { #omp threadprivate(a)

#omp parallel { a = omp_num_thread(); f(); } }

Слайд 19Опция copyin

Опция copyin директивы parallel определяет порядок инициализации threadprivate-переменных: эти

Слайд 20Управление распределением

вычислений

Для распределения вычислений применяются

конструкции:

for

sections

single

Слайд 21Директива for

#pragma omp for [clause ...]

clause:

ordered

private (list)

firstprivate (list)

lastprivate (list)

reduction (operator: list)

nowait

Слайд 22

Директива предшествует циклу for канонического типа:

for(init-expr, var logical_op b, incr_expr)

init_expr

logical_op >, <, >=, <=

Слайд 23incr_expr ::= var ++

++ var

var --

-- var

var += incr

var -=

var = incr + var

var = var + incr

var = var – incr

var переменная целого типа

incr, lb, b инварианты цикла целого типа

Слайд 24Опция shedule директивы for

Опция shedule допускает следующие аргументы:

static - распределение осуществляется

dynamic - распределение осуществляется динамически (тред,

закончивший выполнение, получает новую порцию итераций);

guided - аналогично dynamic, но на каждой следующей итерации

размер распределяемого блока итераций равен примерно общему

числу оставшихся итераций, деленному на число исполняемых

тредов, если это число больше заданного значения chunk, или

значению chunk в противном случае (крупнее порция – меньше синхронизаций)

runtime - распределение осуществляется во время выполнения

системой поддержки времени выполнения (параметр chunk не

задается) на основе переменных среды

Слайд 25Особенности опции schedule директивы for

аргумент chunk можноиспользовать только вместе с

по умолчанию chunk считается равным 1

распараллеливание с помощью опции runtime осуществляется используя значение переменной OMP_SCHEDULE Пример. setenv OMP_SCHEDULE “guided,4”

Слайд 26#include #include #include main(int argc, char* argv[]) { int n, iters, t,

Сложение (с умножением) векторов – последовательный вариант.

Слайд 27#include

#include

#include

#include

main(int argc, char* argv[])

{

int n, iters,

a = (double*)malloc(n * sizeof(double)); b = (double*)malloc(n * sizeof(double)); t = time(NULL); for(i = 0; i < iters; i ++) {

#pragma omp parallel for private(j), firstprivate(n) for(j = 0; j < n; j ++) { a[j] = a[j] + alpha * b[j]; } } t = time(NULL) - t; printf("parallel loop: %d seconds\n", t); }

Сложение (с умножением) векторов – параллельный вариант.

Слайд 29Директива sections

#pragma omp sections [clause ...]

structured_block

clause:

firstprivate (list)

lastprivate (list)

reduction (operator: list)

nowait

{

#pragma omp section

structured_block

#pragma omp section

structured_block

}

Слайд 30

Опция lastprivate обладает той же семантикой, что и

опция private. При

Опция lastprivate

М

Слайд 31Директива single

#pragma omp single [clause ...]

structured_block

Директива single определяет что последующий

блок

Слайд 33#pragma omp master

определяет секцию кода, выполняемого только master-тредом

#pragma omp critical [(name)]

определяет

#pragma omp barrier

определяет секцию кода, выполняемого только одним тредом в данный момент времени

Слайд 35#paragma omp flush [var-list]

::==

x binop = expr

x ++

++ x

x

-- x

Следующие содержат неявный flush: barrier, вход и выход из critical, ordered, выход из parallel, for, sections, single

Слайд 36Решение уравнения Пуассона

методом верхней релаксации

d2u/dx2 + d2u/dy2 – a * u

1

1

-1

-1

(1-x2)(1-y2)

Слайд 37Разностная схема

uijnew = uij – w /b *((ui-1,j + ui+1,j)/dx2 +

b = - (2/dx2 + 2/dy2 + a)

![#include #include #include main(int argc, char* argv[]) { omp_set_num_threads(atoi(argv[1])); printf(](/img/tmb/2/165006/f143b4c6b7d25875524bf3809753b715-800x.jpg)

![Общий синтаксис директив OpenMP#pragma omp directive_name [clause[clause ...]] newlineДействия, соответствующие директиве применяются непосредственно к структурному](/img/tmb/2/165006/6846dda8a2f83a5773f5bbe0198f37ca-800x.jpg)

![Директива parallelДанная директива – единственный способ инициироватьпараллельное выполнение программы.#pragma omp parallel [clause ...]clause:](/img/tmb/2/165006/b3abbc6cacf4ed50f212c9047d25ea11-800x.jpg)

![Директива for#pragma omp for [clause ...] clause: schedule (type [,chunk])](/img/tmb/2/165006/4d02b41f6a1ecd00c872d86c92fe9503-800x.jpg)

![#include #include #include main(int argc, char* argv[]) { int n, iters, t, i, j; double](/img/tmb/2/165006/a198565a7eea1507db9acb2c0ddf6817-800x.jpg)

![#include #include #include #include main(int argc, char* argv[]) { int n, iters, t, i, j;](/img/tmb/2/165006/fcb827205f95ed5110a41020524761bc-800x.jpg)

![Директива sections#pragma omp sections [clause ...]structured_blockclause: private (list)](/img/tmb/2/165006/e14e4f6635d74b505c2e3435e7404baa-800x.jpg)

![Директива single#pragma omp single [clause ...] structured_blockДиректива single определяет что последующийблок будет выполняться только одним тредом](/img/tmb/2/165006/f3ec5cd9f5d94f7e7c2e992551393bb0-800x.jpg)

![#pragma omp master определяет секцию кода, выполняемого только master-тредом#pragma omp critical [(name)] определяет секцию кода, выполняемого только](/img/tmb/2/165006/d02fc5e5bdc39159913e6cbcf5cb4be7-800x.jpg)

![#paragma omp flush [var-list] ::== x binop = expr x ++ ++ x x -- -- xСледующие содержат неявный](/img/tmb/2/165006/17fa48d30e05d5f6ef44e61128d777d1-800x.jpg)