- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Нейронные сети. Сеть Хопфилда презентация

Содержание

- 1. Нейронные сети. Сеть Хопфилда

- 2. Сети с обратными связями

- 3. Если, к примеру, входной вектор состоит из

- 4. Если найти такую функцию H(x), что то

- 5. Первое слагаемое обеспечивает стремление x к ближайшим

- 6. Веса не зависят от направления от i

- 7. Решение задач с помощью сетей Хопфилда; 1.Построить

- 8. Задача комбинаторной оптимизации В задачах комбинаторной

- 9. Если обозначить через dij расстояние между i-м

- 10. В данном случае в качестве энергии состояния

- 12. Величина γ регулирует “торг” между поиском маршрута

- 13. Таким образом находятся значения синаптических связей в

Слайд 2

Сети с обратными связями могут работать в качестве ассоциативной памяти. Это

Память с такой адресацией является весьма перспективной для создания систем искусственного интеллекта, систем распознавания речевых сигналов и изображений.

Пусть задано множество векторов , подлежащих запоминанию в нейросети. Критерий "похожести" векторов зависит от задачи и может быть весьма сложным.

Сеть Хопфилда

Слайд 3 Если, к примеру, входной вектор состоит из нескольких отсчетов сигнала во

Рассмотрим простейший случай, когда в качестве меры близости двух векторов используется их скалярное произведение . Чем более "похожи" вектора, тем больше мера близости. Тогда можно ожидать, что изменение вектора x с течением времени по закону

в конце концов приведет к тому, что x совпадет с наиболее похожим эталоном, т.е. требуемая ассоциация будет найдена.

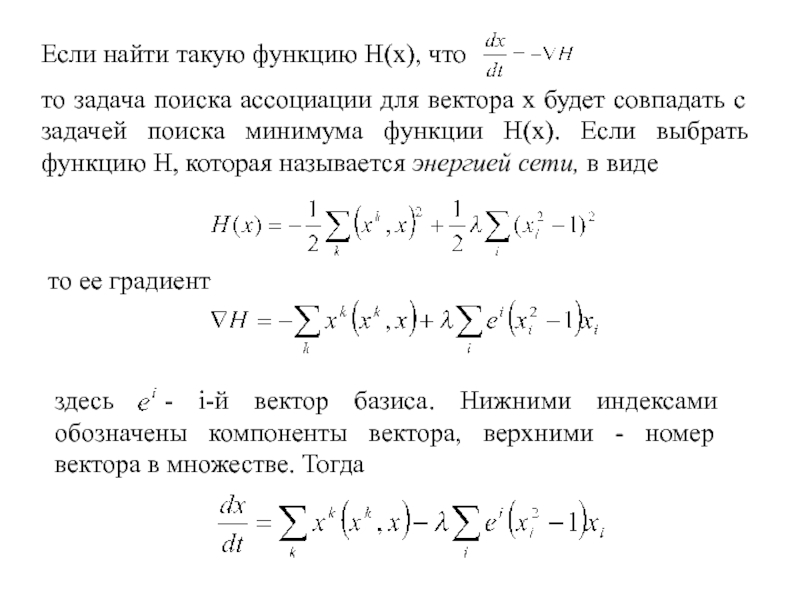

Слайд 4Если найти такую функцию H(x), что

то задача поиска ассоциации для вектора

то ее градиент

здесь - i-й вектор базиса. Нижними индексами обозначены компоненты вектора, верхними - номер вектора в множестве. Тогда

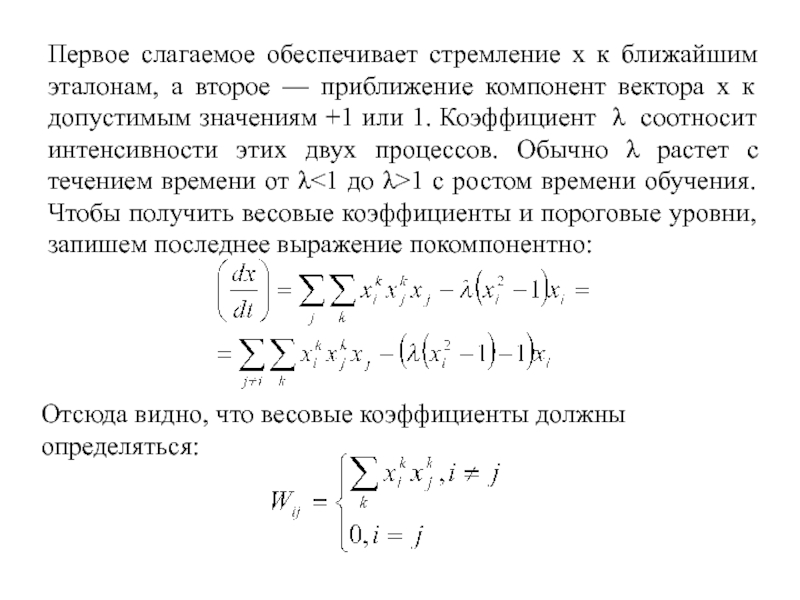

Слайд 5Первое слагаемое обеспечивает стремление x к ближайшим эталонам, а второе —

Отсюда видно, что весовые коэффициенты должны определяться:

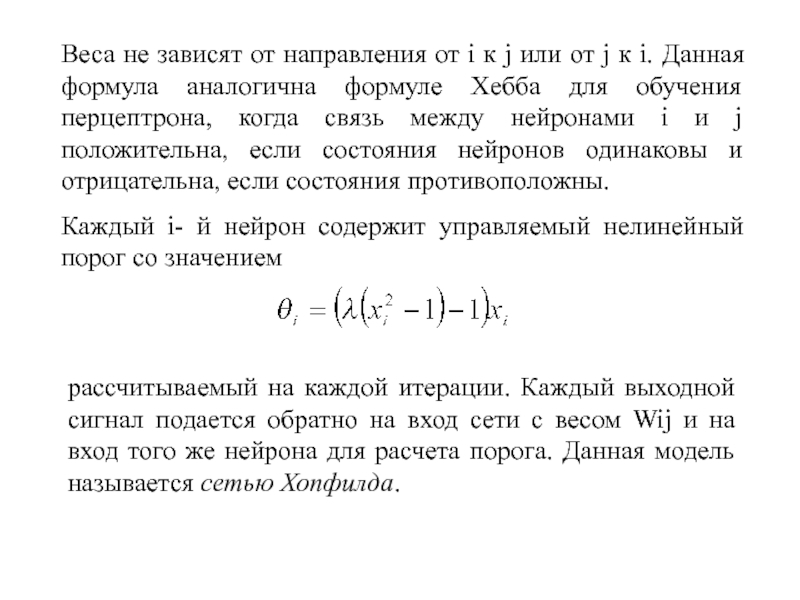

Слайд 6Веса не зависят от направления от i к j или от

Каждый i- й нейрон содержит управляемый нелинейный порог со значением

рассчитываемый на каждой итерации. Каждый выходной сигнал подается обратно на вход сети с весом Wij и на вход того же нейрона для расчета порога. Данная модель называется сетью Хопфилда.

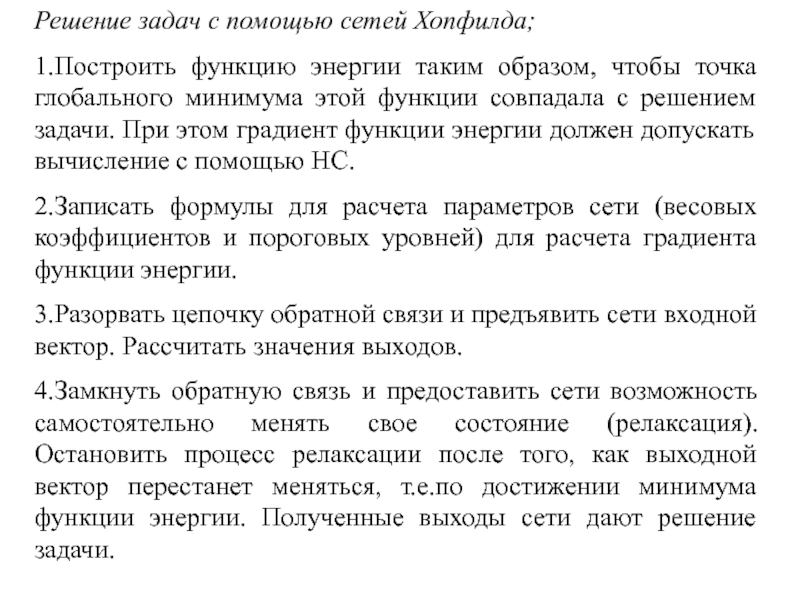

Слайд 7Решение задач с помощью сетей Хопфилда;

1.Построить функцию энергии таким образом, чтобы

2.Записать формулы для расчета параметров сети (весовых коэффициентов и пороговых уровней) для расчета градиента функции энергии.

3.Разорвать цепочку обратной связи и предъявить сети входной вектор. Рассчитать значения выходов.

4.Замкнуть обратную связь и предоставить сети возможность самостоятельно менять свое состояние (релаксация). Остановить процесс релаксации после того, как выходной вектор перестанет меняться, т.е.по достижении минимума функции энергии. Полученные выходы сети дают решение задачи.

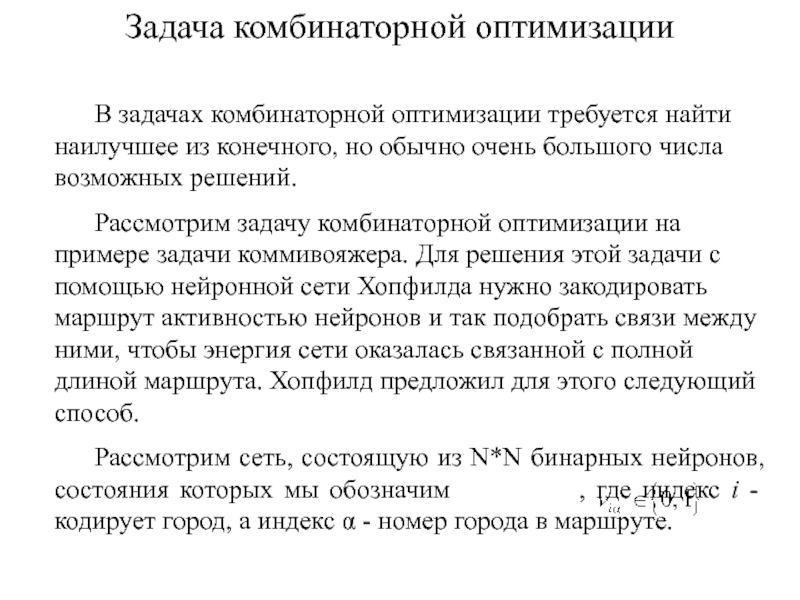

Слайд 8Задача комбинаторной оптимизации

В задачах комбинаторной оптимизации требуется найти наилучшее из

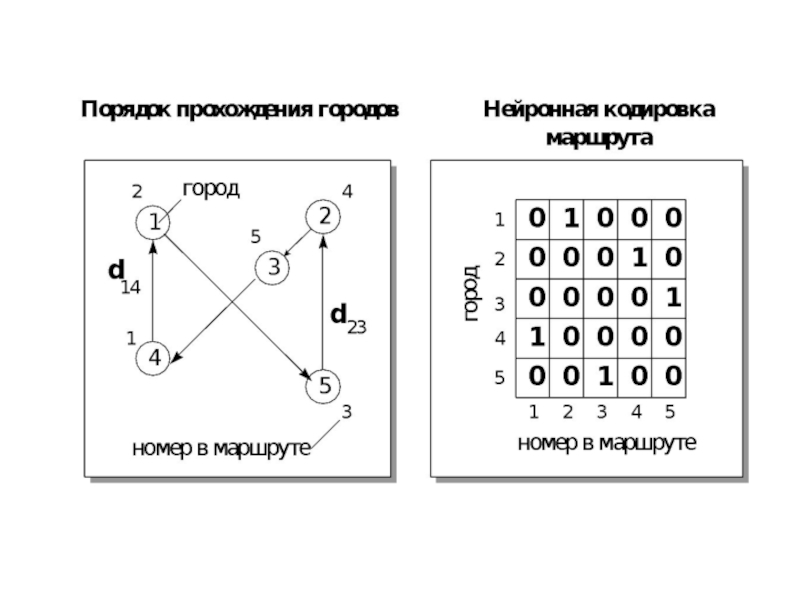

Рассмотрим задачу комбинаторной оптимизации на примере задачи коммивояжера. Для решения этой задачи с помощью нейронной сети Хопфилда нужно закодировать маршрут активностью нейронов и так подобрать связи между ними, чтобы энергия сети оказалась связанной с полной длиной маршрута. Хопфилд предложил для этого следующий способ.

Рассмотрим сеть, состоящую из N*N бинарных нейронов, состояния которых мы обозначим , где индекс i - кодирует город, а индекс α - номер города в маршруте.

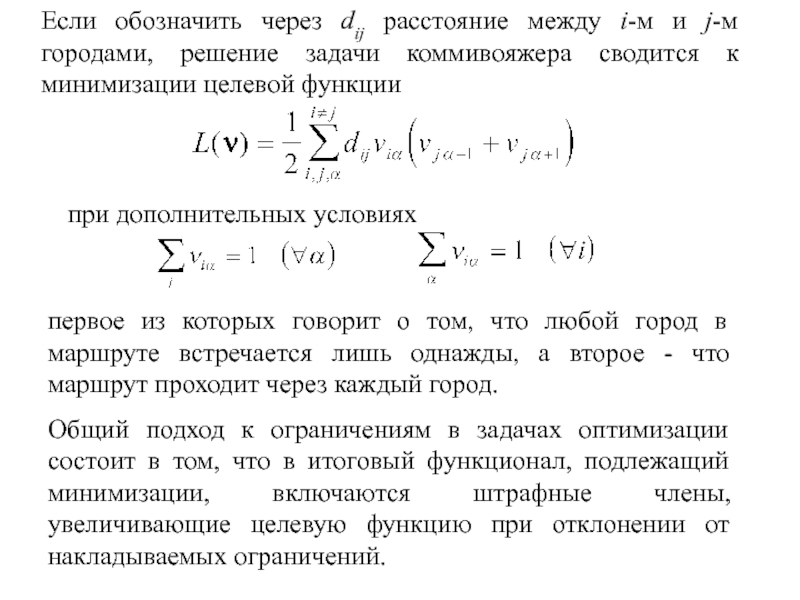

Слайд 9Если обозначить через dij расстояние между i-м и j-м городами, решение

при дополнительных условиях

первое из которых говорит о том, что любой город в маршруте встречается лишь однажды, а второе - что маршрут проходит через каждый город.

Общий подход к ограничениям в задачах оптимизации состоит в том, что в итоговый функционал, подлежащий минимизации, включаются штрафные члены, увеличивающие целевую функцию при отклонении от накладываемых ограничений.

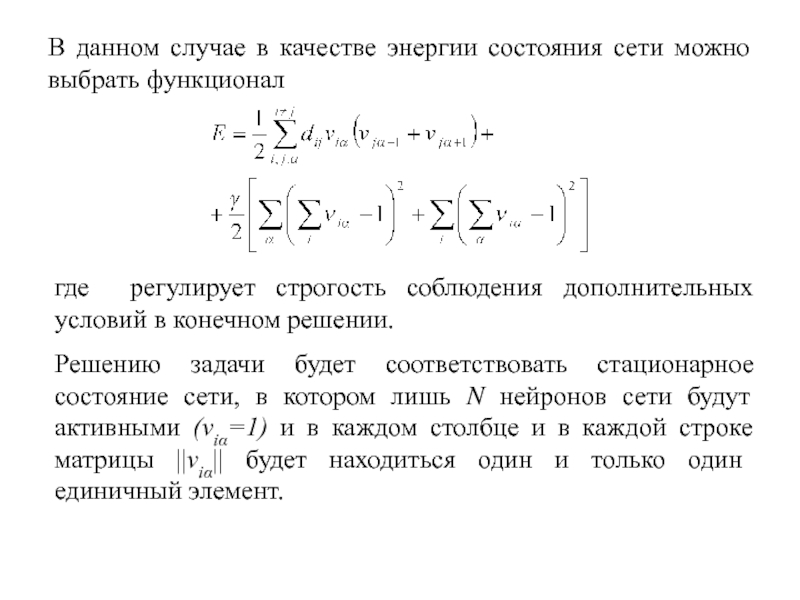

Слайд 10В данном случае в качестве энергии состояния сети можно выбрать функционал

где регулирует строгость соблюдения дополнительных условий в конечном решении.

Решению задачи будет соответствовать стационарное состояние сети, в котором лишь N нейронов сети будут активными (νiα=1) и в каждом столбце и в каждой строке матрицы ||νiα|| будет находиться один и только один единичный элемент.

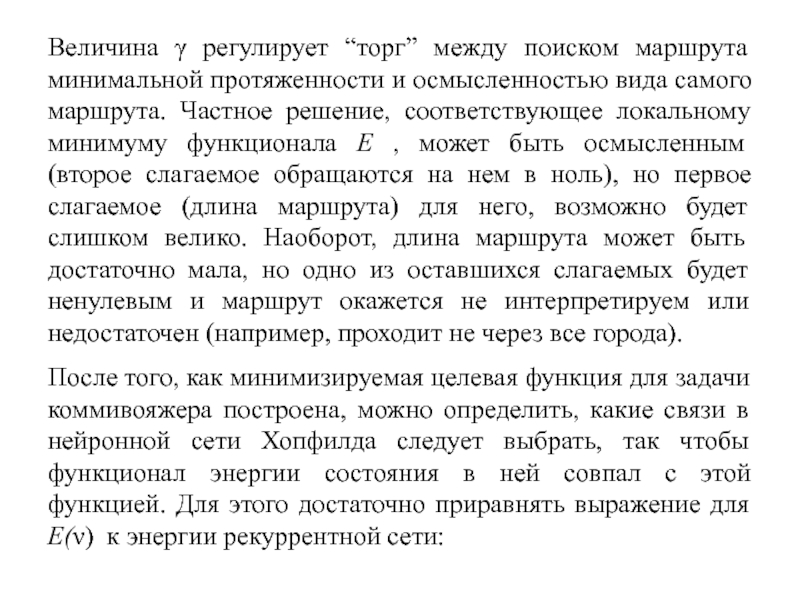

Слайд 12Величина γ регулирует “торг” между поиском маршрута минимальной протяженности и осмысленностью

После того, как минимизируемая целевая функция для задачи коммивояжера построена, можно определить, какие связи в нейронной сети Хопфилда следует выбрать, так чтобы функционал энергии состояния в ней совпал с этой функцией. Для этого достаточно приравнять выражение для E(ν) к энергии рекуррентной сети:

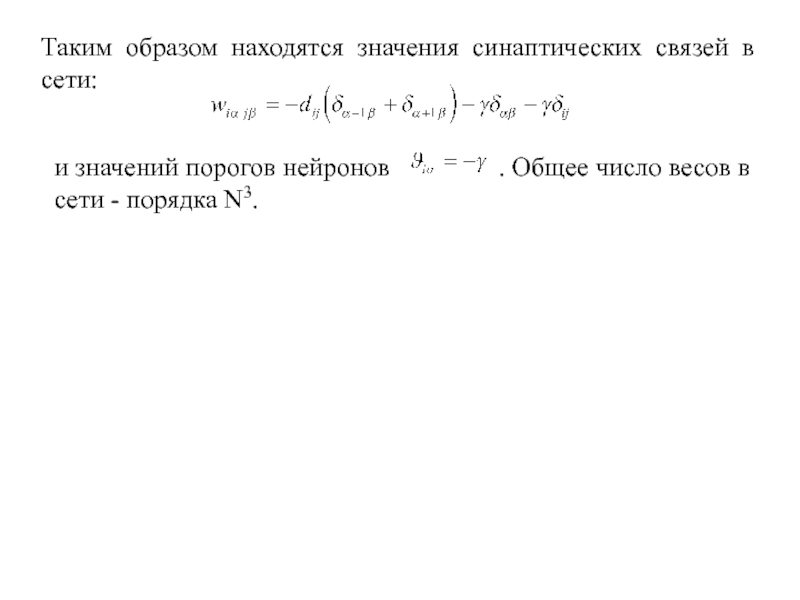

Слайд 13Таким образом находятся значения синаптических связей в сети:

и значений порогов нейронов