- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Нейронные сети презентация

Содержание

- 1. Нейронные сети

- 2. Литература

- 3. Искусственный интеллект В ХХ веке было сформулировано

- 4. Области искусственного интеллекта Искусственный интеллект Искусственный интеллект Искусственные нейронные сети

- 5. Простая задача распознавания 1998 год База

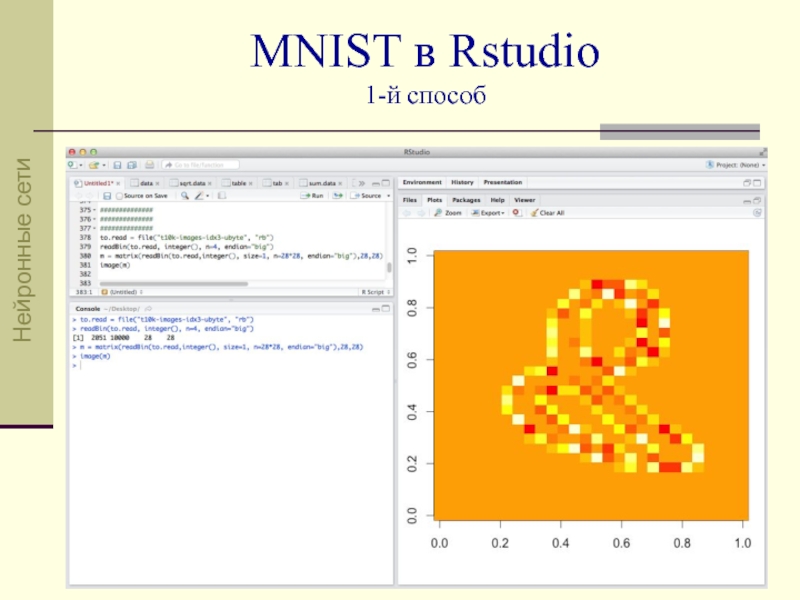

- 6. MNIST в Rstudio 1-й способ Нейронные сети

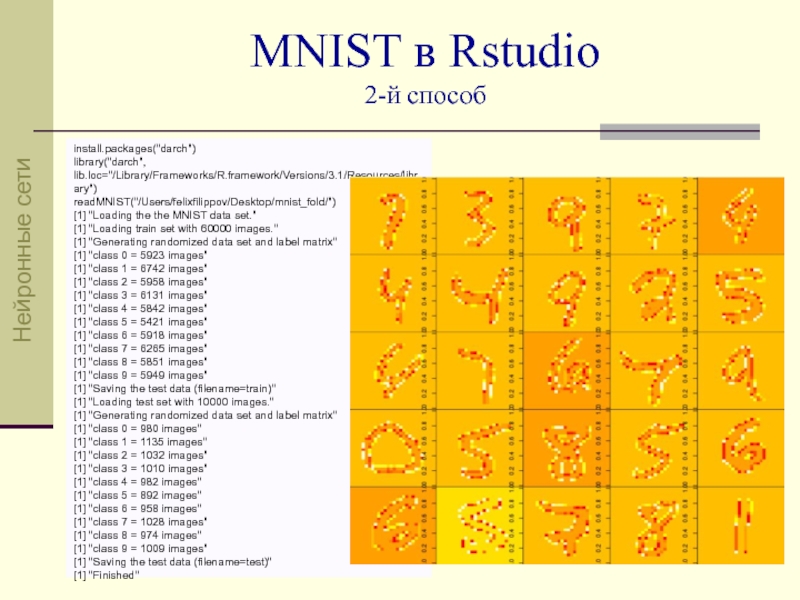

- 7. MNIST в Rstudio 2-й способ install.packages("darch")

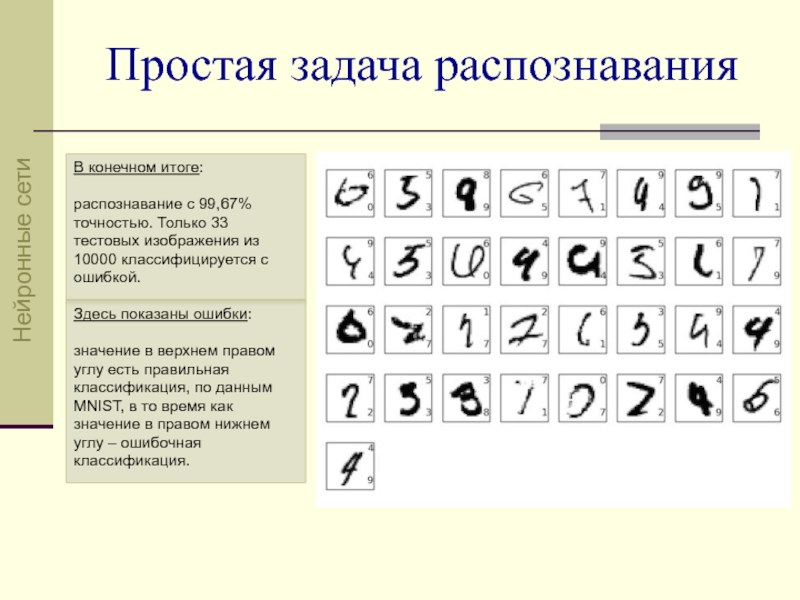

- 8. В конечном итоге: распознавание с

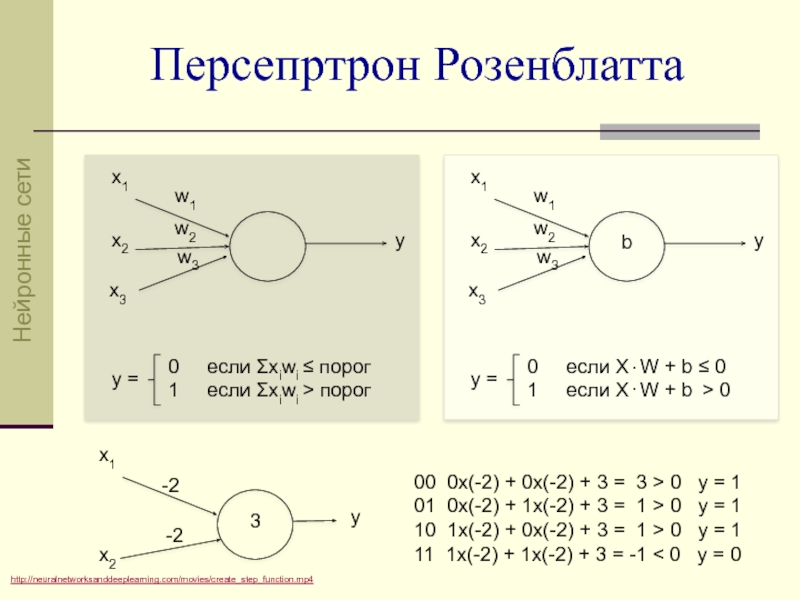

- 9. Персепртрон Розенблатта

- 10. http://habrahabr.ru/post/214109/ Мозг человека состоит приблизительно из

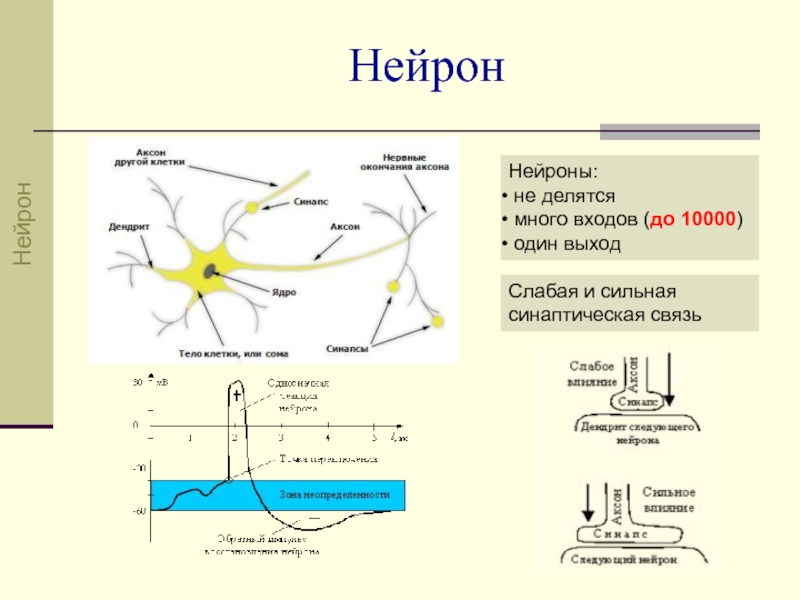

- 11. Нейрон Нейроны: не делятся много

- 12. синапсы тело аксон Функция активации линейная пороговая сигмоидная с = 2 Схема искусственного нейрона Нейрон

- 13. Каждый синапс характеризуется величиной синаптической связи –

- 14. Y = f(s) Функция активации нейрона Значение

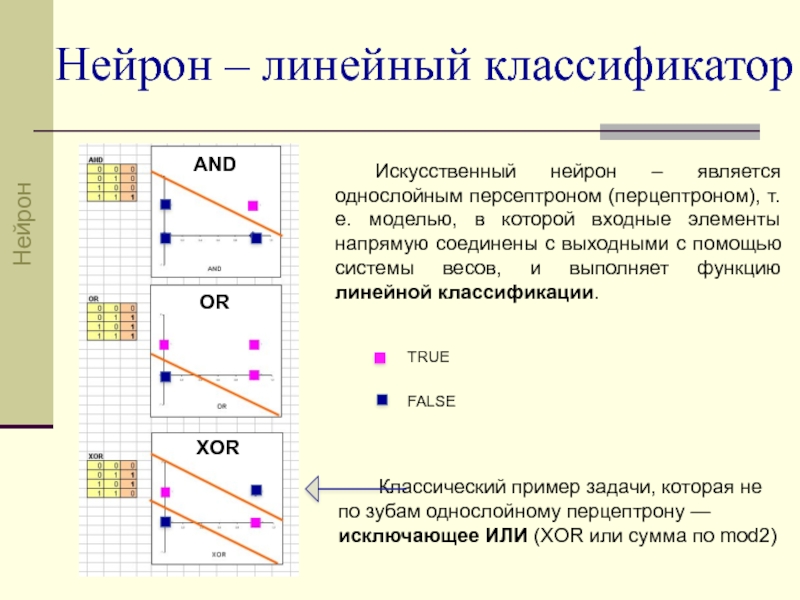

- 15. Нейрон – линейный классификатор Искусственный нейрон –

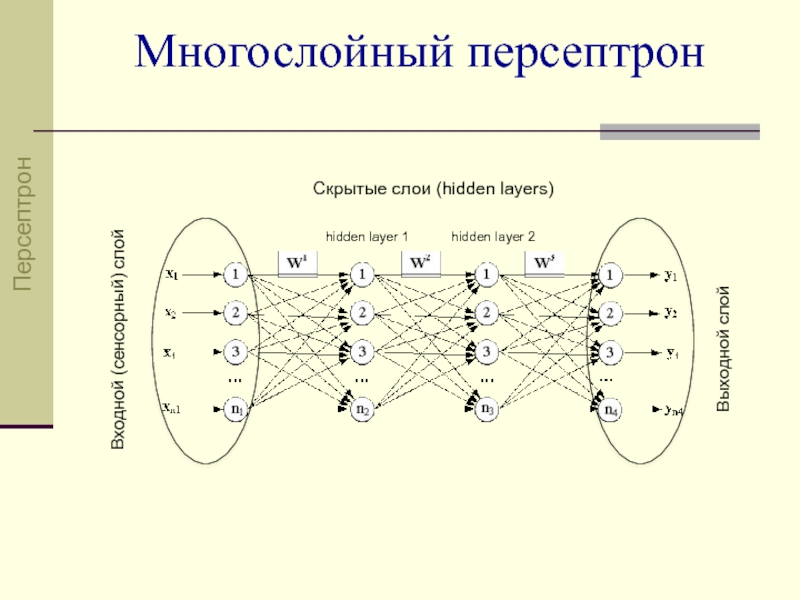

- 16. Входной (сенсорный) слой Скрытые слои (hidden layers)

- 17. Многослойный персептрон hidden = 4 Для решения

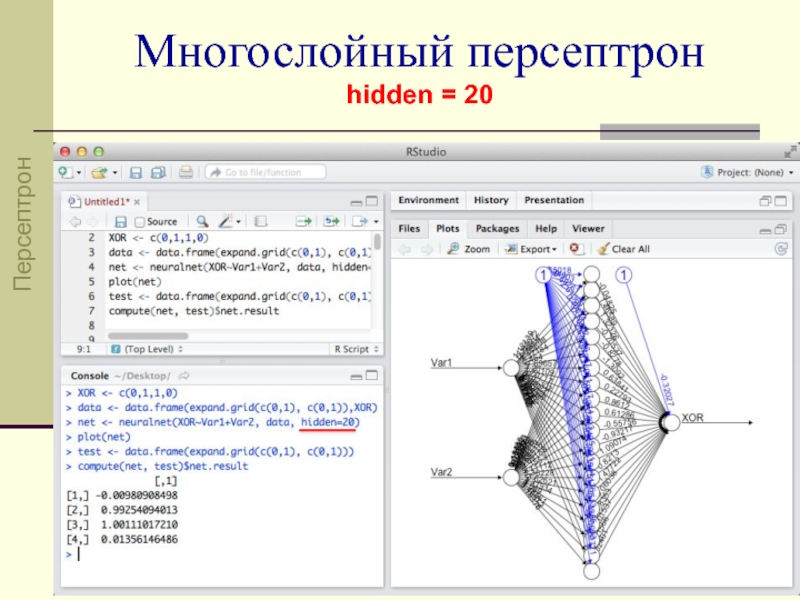

- 18. Многослойный персептрон hidden = 20 Персептрон

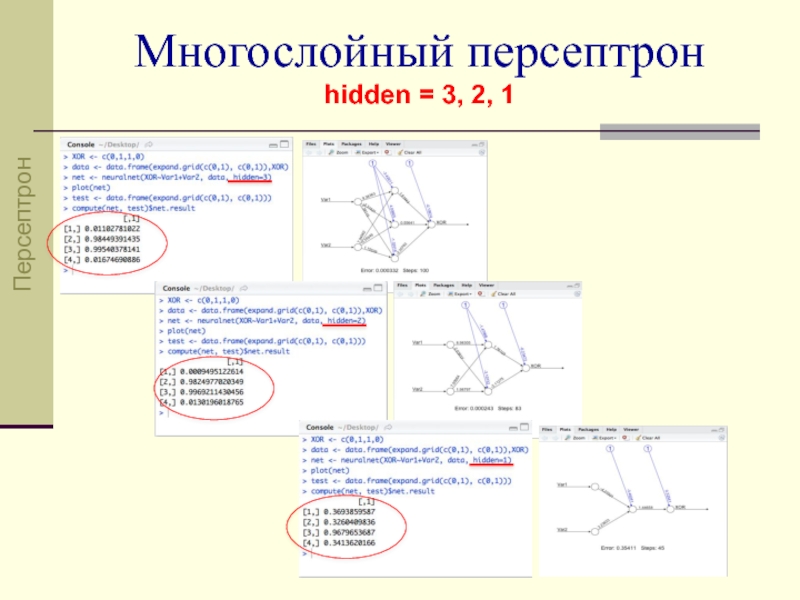

- 19. Многослойный персептрон hidden = 3, 2, 1 Персептрон

- 20. Многослойный персептрон hidden = 2 Функция XOR, AND и OR Персептрон

- 21. Работа нейронной сети 1 фаза) прямое распространение

- 22. http://robocraft.ru/blog/algorithm/560.html 1 слой 2 слой Выходной

- 23. http://robocraft.ru/blog/algorithm/560.html Выходной слой 2 слой 1

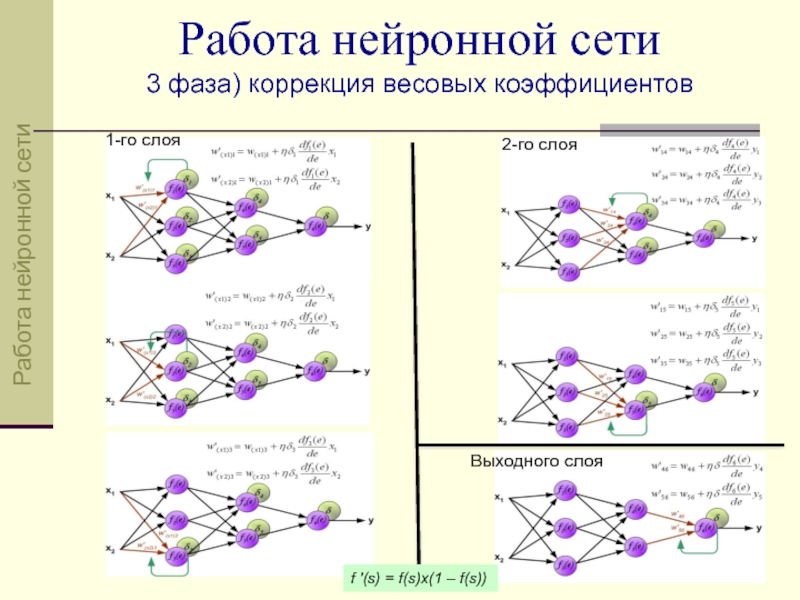

- 24. 1-го слоя 2-го слоя Выходного слоя f

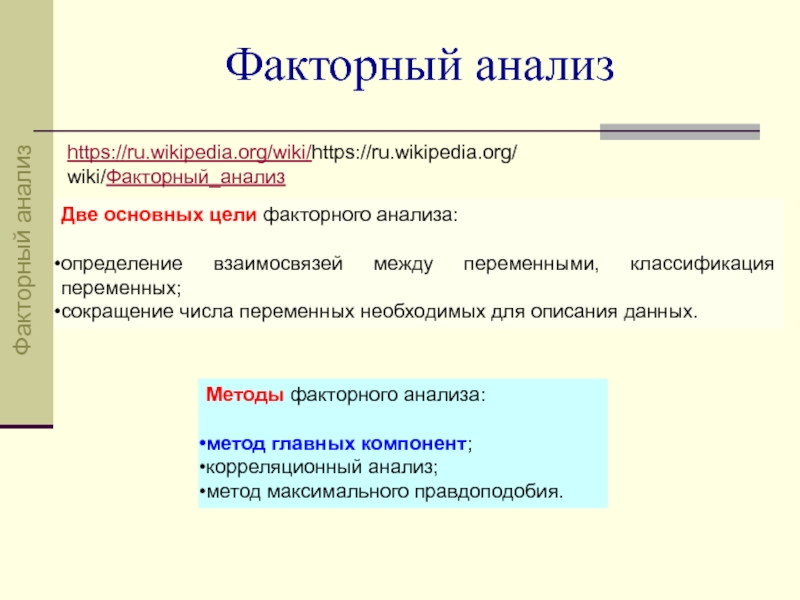

- 25. Факторный анализ https://ru.wikipedia.org/wiki/https://ru.wikipedia.org/wiki/Факторный_анализ Две основных цели

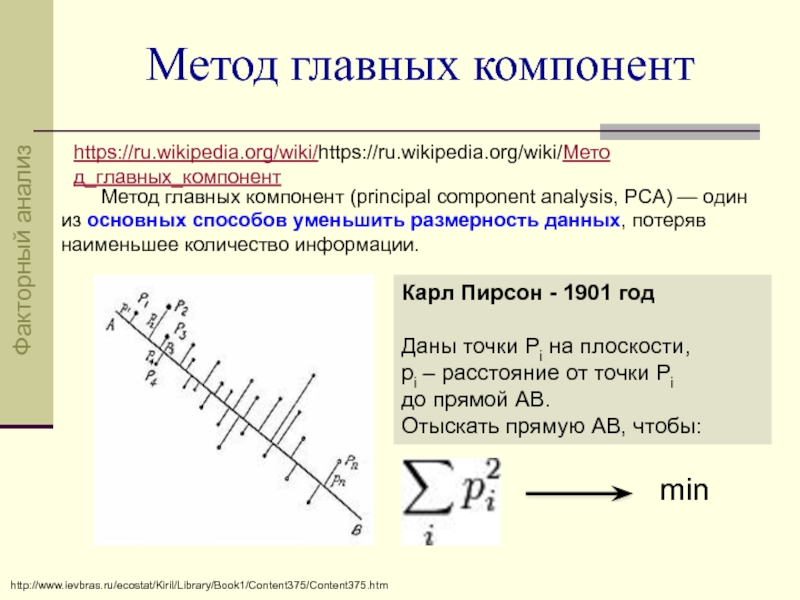

- 26. Метод главных компонент https://ru.wikipedia.org/wiki/https://ru.wikipedia.org/wiki/Метод_главных_компонент Метод главных

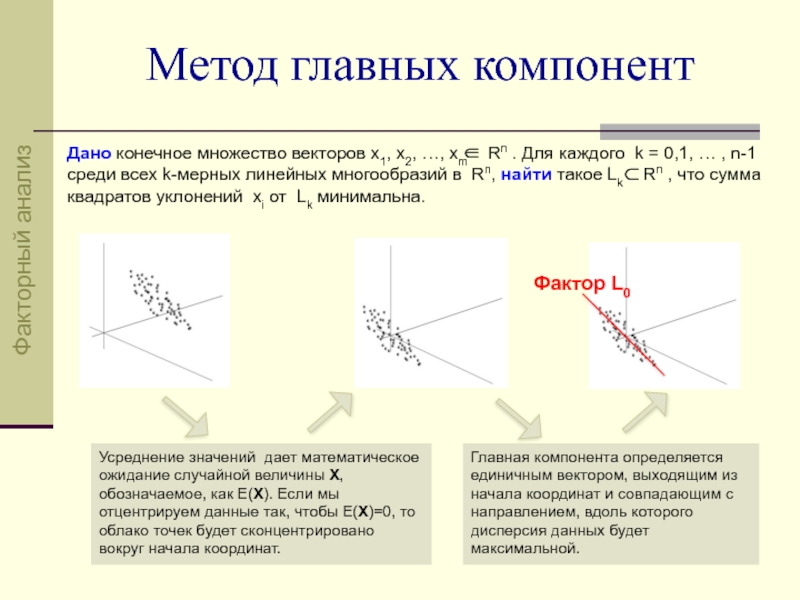

- 27. Метод главных компонент Дано конечное множество векторов

- 28. http://habrahabr.ru/post/224495/

- 29. Поиск главных компонент Факторный анализ

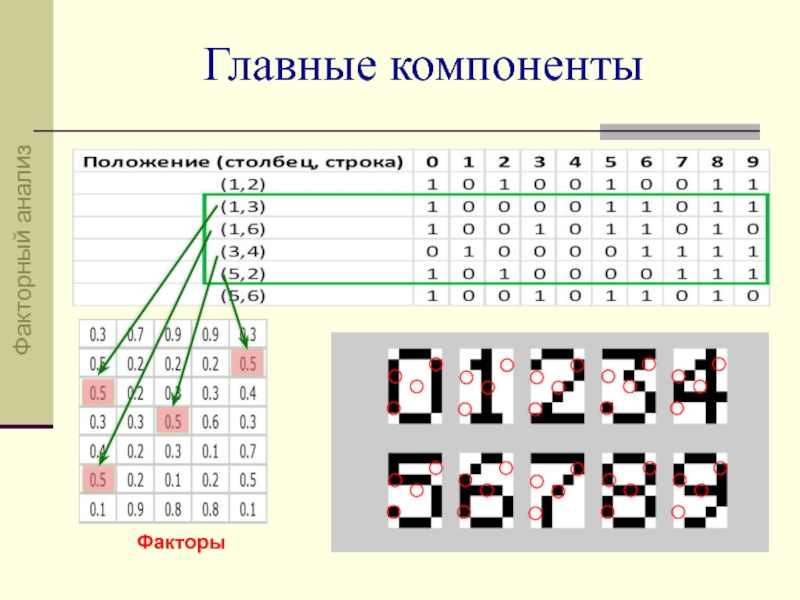

- 30. Главные компоненты Факторы

- 31. Если соотнести результат факторного анализа и образцы

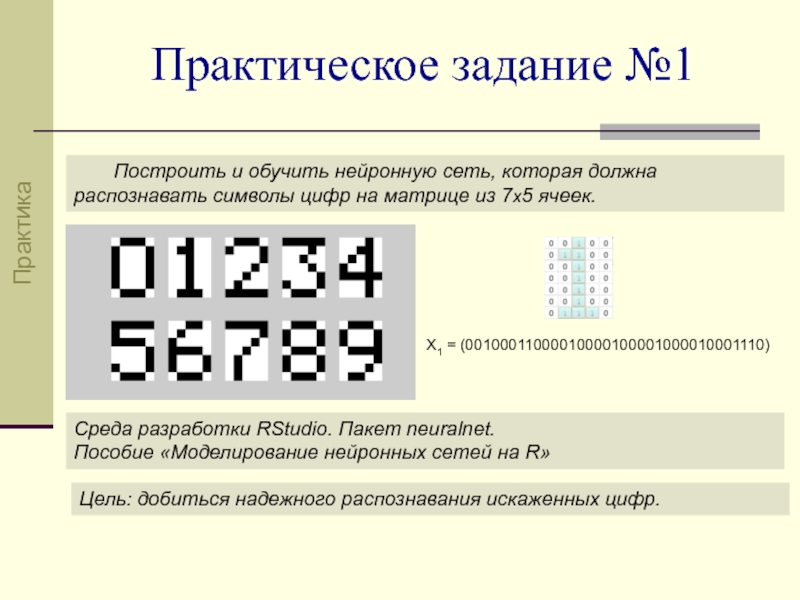

- 32. Практическое задание №1 Построить и обучить нейронную

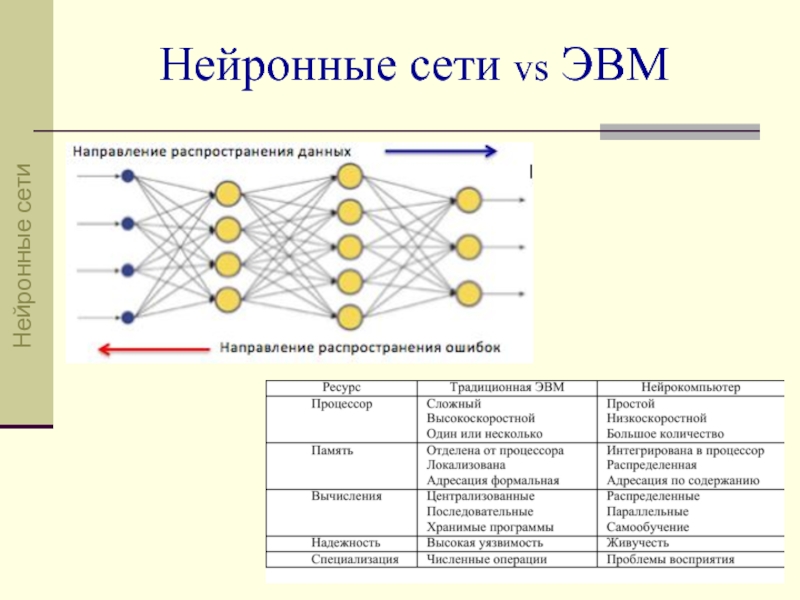

- 33. Нейронные сети Нейронные сети vs ЭВМ

- 34. Классификация нейронных сетей Нейронные сети Нейронные сети

- 35. Моделирование нейронных сетей на R (в RStudio)

- 36. Пакет NEURALNET AND

- 37. Пакет NEURALNET XOR

- 38. Пакет NNET ir

- 39. Пакет NeuralNetTools Функция garson() дает количественную оценку

- 40. Сверточная нейронная сеть Свёрточная нейронная сеть (convolutional

- 41. В основу CNN положено 2 основные идеи:

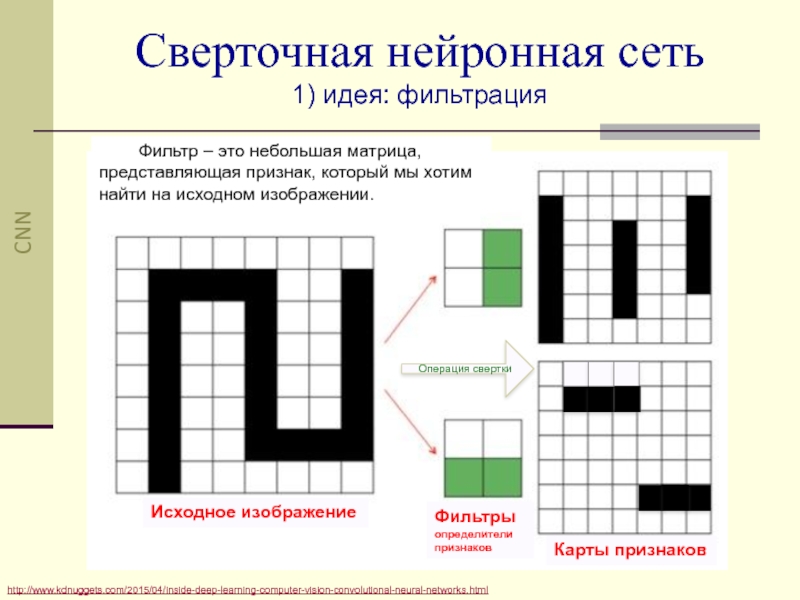

- 42. http://www.kdnuggets.com/2015/04/inside-deep-learning-computer-vision-convolutional-neural-networks.html Сверточная нейронная сеть 1) идея:

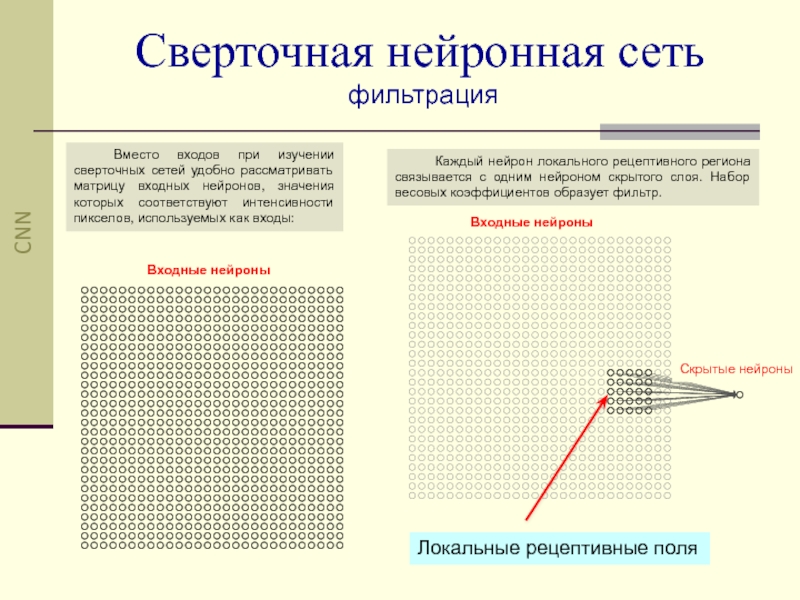

- 43. Вместо входов при изучении сверточных сетей удобно

- 44. Сверточная нейронная сеть сверточный слой (convolution layer)

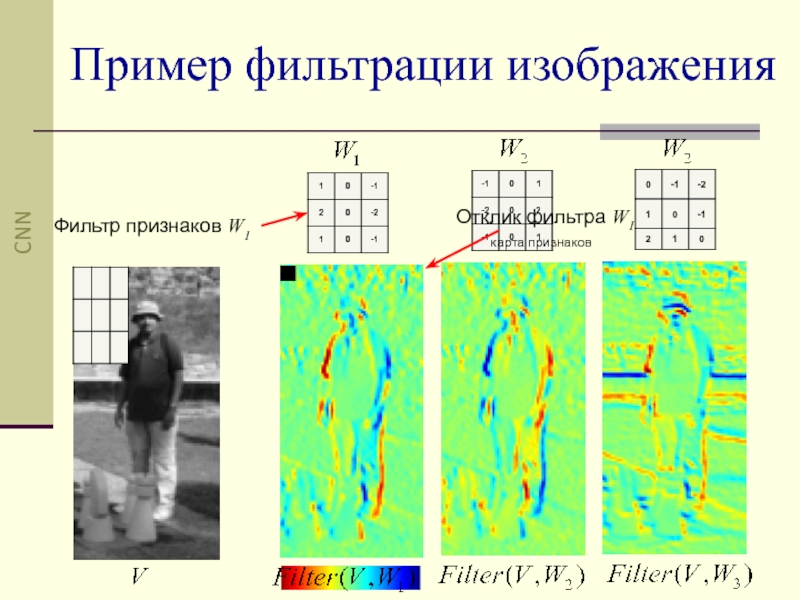

- 45. Пример фильтрации изображения Фильтр признаков W1

- 46. Если входное изображение 28 × 28, и

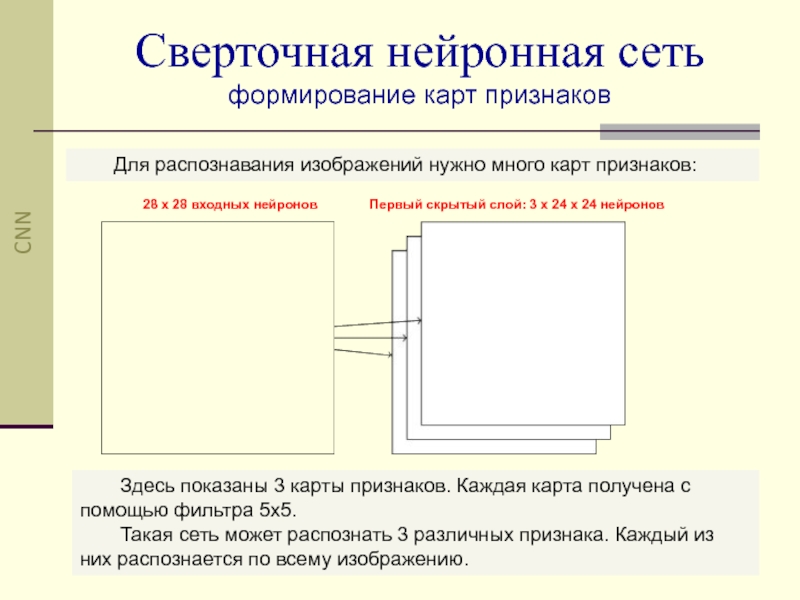

- 47. Для распознавания изображений нужно много карт признаков:

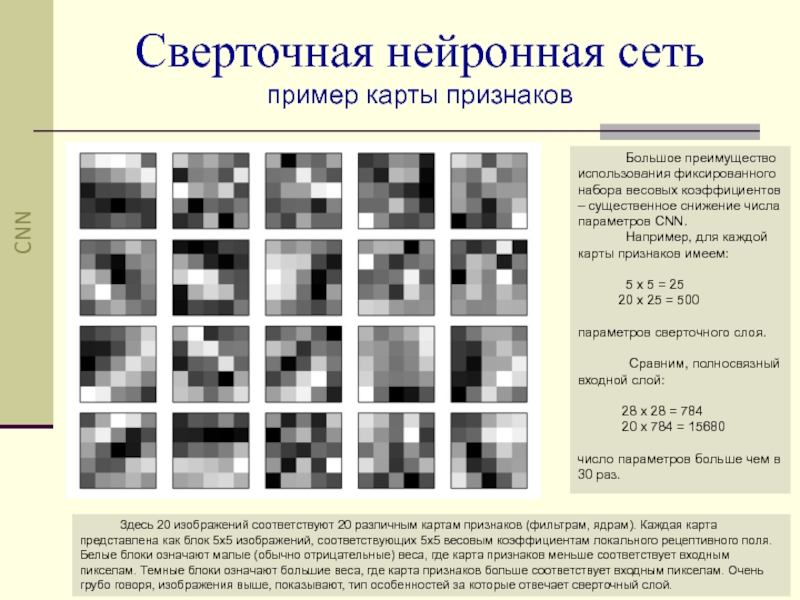

- 48. Здесь 20 изображений соответствуют 20 различным картам

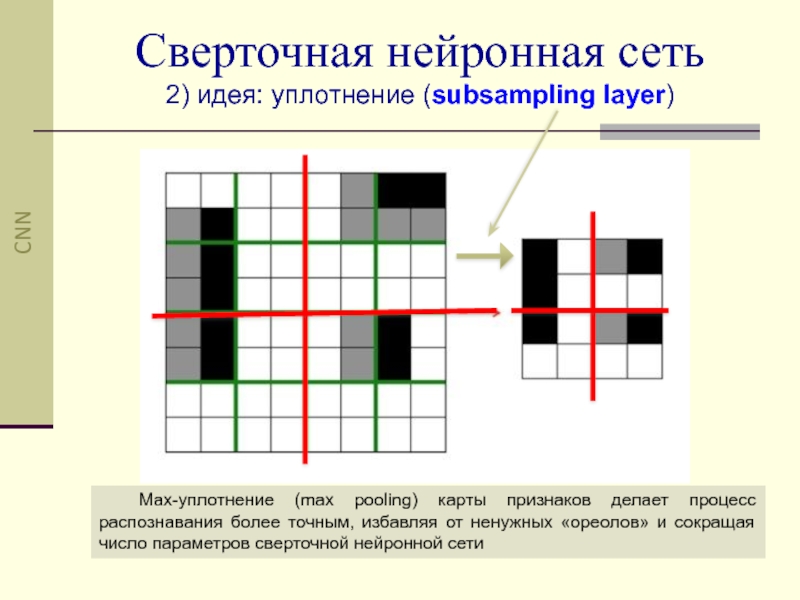

- 49. Сверточная нейронная сеть 2) идея: уплотнение (subsampling

- 50. Объединяющие слои следуют сразу после сверточных.

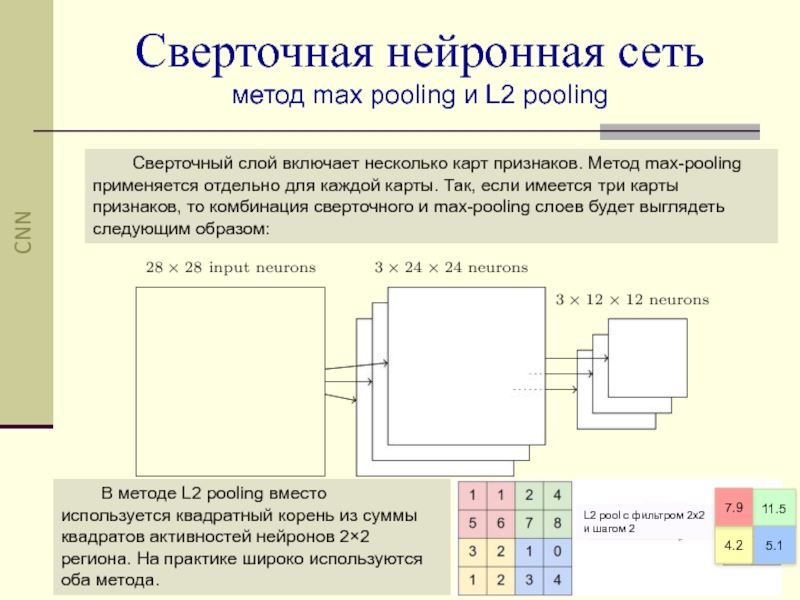

- 51. Сверточный слой включает несколько карт признаков. Метод

- 52. Фильтрация операция свертки Уплотнение max pooling, L2

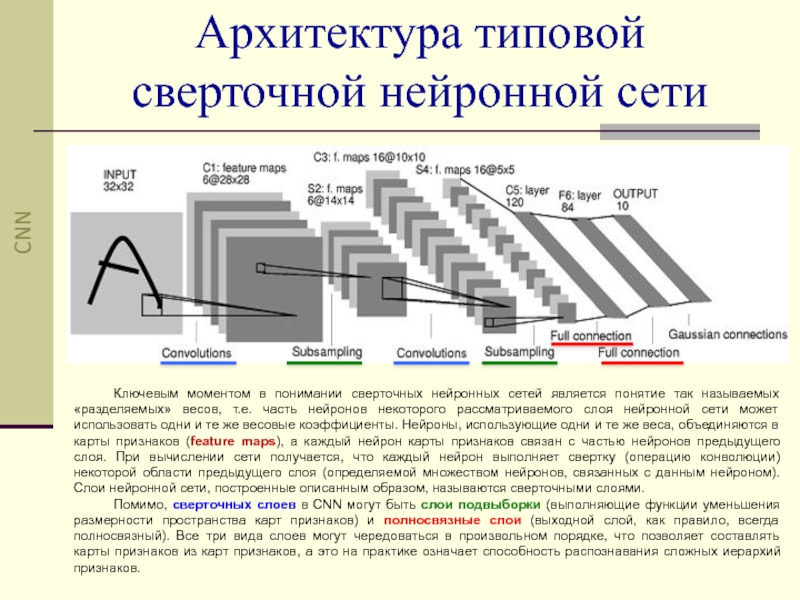

- 53. Архитектура типовой cверточной нейронной сети Ключевым моментом

- 54. Примеры карт признаков CNN

- 55. ImageNet данные 2011 года использовали 16 миллионов

- 56. http://cs.stanford.edu/people/karpathy/ilsvrc/ ILSVRC задача классификации Практика CNN

- 57. http://habrahabr.ru/company/nordavind/blog/206342/ ILSVRC задача обнаружения Практика CNN

- 58. ILSVRC задача обнаружения Практика CNN

- 59. ILSVRC задача обнаружения Практика CNN

- 60. ILSVRC задача обнаружения Практика CNN

- 61. ILSVRC задача обнаружения Практика CNN

- 62. ILSVRC задача обнаружения - лопаточка Практика CNN

- 63. ILSVRC задача обнаружения - ковш, черпак Практика CNN

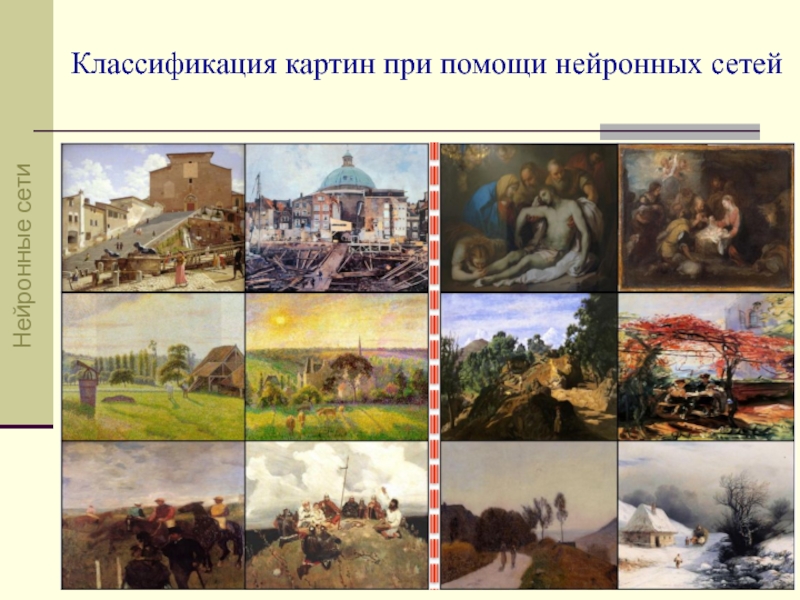

- 64. http://arxiv.org/pdf/1505.00855v1.pdf Классификация картин при помощи CNN

- 65. Коллекция Wikiart Практика CNN

- 66. Классификация картин при помощи нейронных сетей http://datareview.info/article/obzor-nauchnoy-publikatsii-klassifikatsiya-kartin-pri-pomoshhi-neyronnyih-setey/ Стили Жанры Художники Практика CNN

- 67. Нейронные сети Классификация картин при помощи нейронных сетей

- 68. Нейронные сети Классификация картин при помощи нейронных сетей

- 69. Направления исследований в области искусственного интеллекта

- 70. Искусственный интеллект Нейрочипы http://citforum.ru/hardware/neurocomp/neyrocomp_04.shtml http://2013.nscf.ru/TesisAll/Plenar/13_1520_GalyshkinAI_P13.pdf

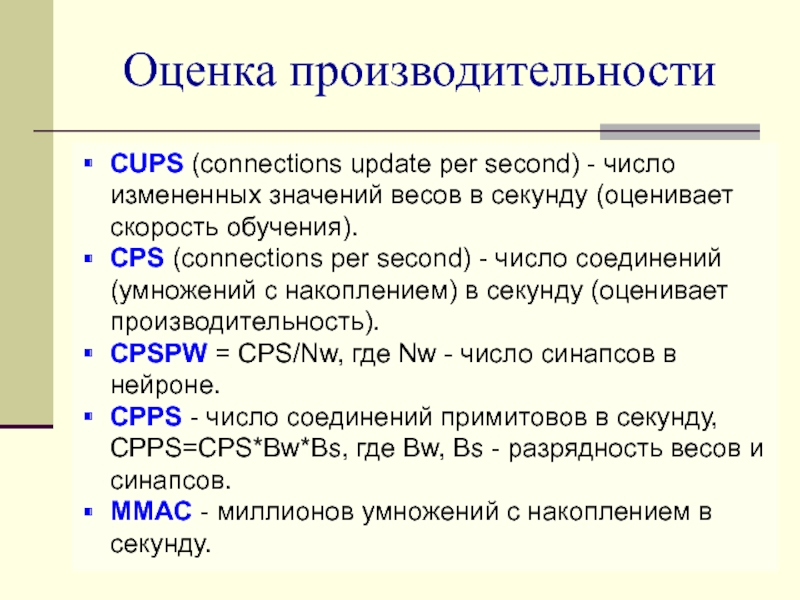

- 71. CUPS (connections update per second) - число

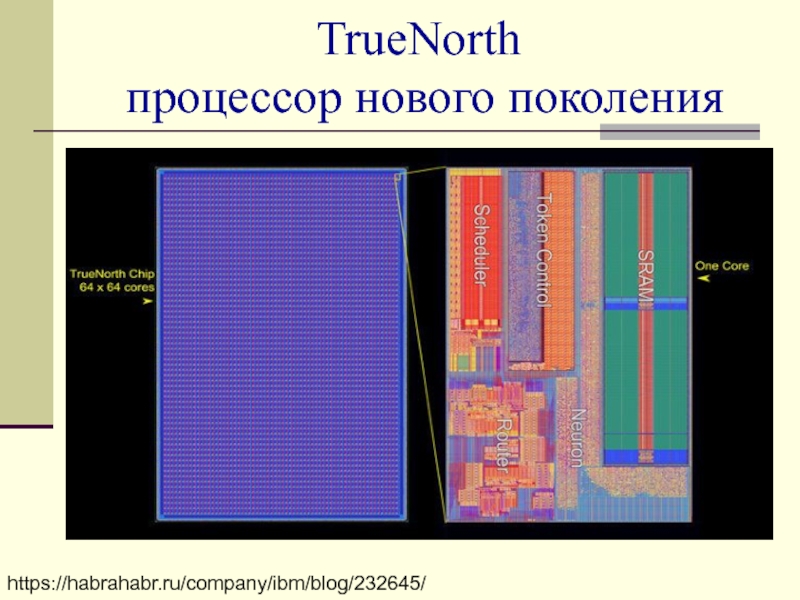

- 72. https://habrahabr.ru/company/ibm/blog/232645/ TrueNorth процессор нового поколения

- 73. TrueNorth процессор нового поколения

- 74. Compass — система симуляции новой компьютерной архитектуры

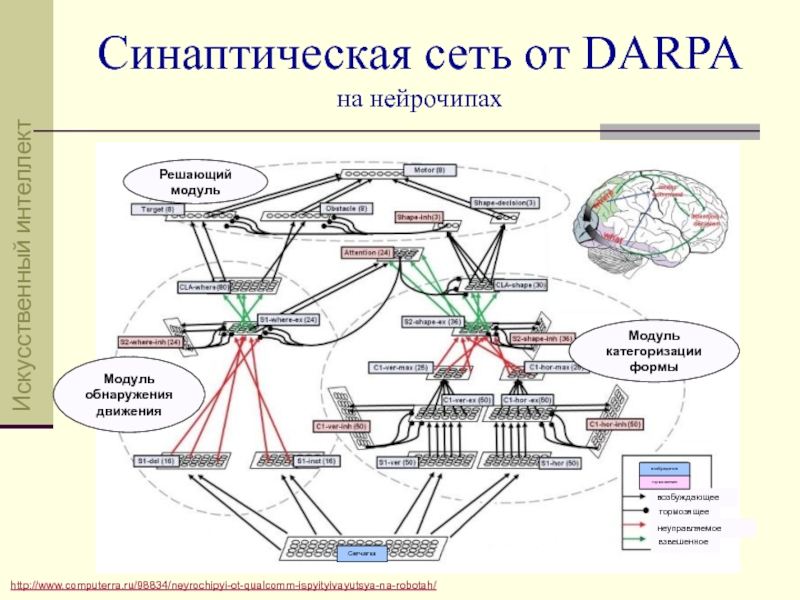

- 75. http://www.computerra.ru/98834/neyrochipyi-ot-qualcomm-ispyityivayutsya-na-robotah/ Модуль обнаружения движения Решающий

- 76. Найди лицо! Вот Оно! Нейронные сети

- 77. Нейронные сети Классификация картин при помощи нейронных сетей

- 78. Нейронные сети Классификация картин при помощи нейронных сетей

- 79. СПАСИБО ЗА ВНИМАНИЕ!

Слайд 1

СПбГУТ им. проф. М.А.Бонч-Бруевича

Нейронные сети

К.т.н., доцент кафедры ИУС

Феликс Васильевич Филиппов

Слайд 3Искусственный интеллект

В ХХ веке было сформулировано понятие искусственного интеллекта и предложен

Истоком этого определения явился знаменитый тест, предложенный британским математиком и одним из первых исследователей в области компьютерных наук Аланом Тьюрингом. В данном тесте экспериментатор пытается определить, является ли человеком или компьютерной программой то "лицо", с которым он обменивается сообщениями с помощью дистанционной клавиатуры.

Искусственный интеллект

Слайд 4Области искусственного интеллекта

Искусственный интеллект

Искусственный интеллект

Искусственные

нейронные

сети

Слайд 5Простая задача распознавания

1998 год

База данных MNIST включает 60,000 тренировочных

рукописных изображений

и 10,000 проверочных изображений.

2010 год

0,27% ошибки CNN

MNIST - Mixed National Institute of

Standards and Technology

https://en.wikipedia.org/wiki/MNIST_database

http://yann.lecun.com/exdb/mnist/

Нейронные сети

Слайд 7MNIST в Rstudio

2-й способ

install.packages("darch")

library("darch", lib.loc="/Library/Frameworks/R.framework/Versions/3.1/Resources/library")

readMNIST("/Users/felixfilippov/Desktop/mnist_fold/")

[1] "Loading the the MNIST data set."

[1]

[1] "Generating randomized data set and label matrix"

[1] "class 0 = 5923 images"

[1] "class 1 = 6742 images"

[1] "class 2 = 5958 images"

[1] "class 3 = 6131 images"

[1] "class 4 = 5842 images"

[1] "class 5 = 5421 images"

[1] "class 6 = 5918 images"

[1] "class 7 = 6265 images"

[1] "class 8 = 5851 images"

[1] "class 9 = 5949 images"

[1] "Saving the test data (filename=train)"

[1] "Loading test set with 10000 images."

[1] "Generating randomized data set and label matrix"

[1] "class 0 = 980 images"

[1] "class 1 = 1135 images"

[1] "class 2 = 1032 images"

[1] "class 3 = 1010 images"

[1] "class 4 = 982 images"

[1] "class 5 = 892 images"

[1] "class 6 = 958 images"

[1] "class 7 = 1028 images"

[1] "class 8 = 974 images"

[1] "class 9 = 1009 images"

[1] "Saving the test data (filename=test)"

[1] "Finished"

Нейронные сети

Слайд 8В конечном итоге:

распознавание с 99,67% точностью. Только 33 тестовых изображения

Здесь показаны ошибки:

значение в верхнем правом углу есть правильная классификация, по данным MNIST, в то время как значение в правом нижнем углу – ошибочная классификация.

Простая задача распознавания

Нейронные сети

Слайд 9Персепртрон Розенблатта

y =

0 если

1 если Σxiwi > порог

x1

x2

x3

y

w1

w2

w3

y =

0 если X W + b ≤ 0

1 если X W + b > 0

x1

x2

x3

y

w1

w2

w3

b

.

.

x1

x2

-2

3

-2

00 0x(-2) + 0x(-2) + 3 = 3 > 0 y = 1

01 0x(-2) + 1x(-2) + 3 = 1 > 0 y = 1

10 1x(-2) + 0x(-2) + 3 = 1 > 0 y = 1

11 1x(-2) + 1x(-2) + 3 = -1 < 0 y = 0

y

http://neuralnetworksanddeeplearning.com/movies/create_step_function.mp4

Нейронные сети

Слайд 10http://habrahabr.ru/post/214109/

Мозг человека состоит приблизительно из 86 миллиардов нейронов, соединенных многочисленными

Мозг

http://habrahabr.ru/post/108483/

Нейронные сети

Слайд 11Нейрон

Нейроны:

не делятся

много входов (до 10000)

один выход

Слабая и сильная

Нейрон

Слайд 12синапсы

тело

аксон

Функция активации

линейная

пороговая

сигмоидная

с = 2

Схема искусственного нейрона

Нейрон

Слайд 13 Каждый синапс характеризуется величиной синаптической связи – её также называют весом

По физическому смыслу, вес синаптической связи – это электрическая проводимость данного синапса.

float s = 0;

for(int i = 0; i < n; i++) {

s += x[i]*w[i];

}

Состояние нейрона

Нейрон

Слайд 14Y = f(s)

Функция активации нейрона

Значение на выходе нейрона – это функция

Чаще всего, используется логистическая функция или функция S-образного вида (сигмоид):

Одна из причин, по которой сигмоид используется в нейронных сетях, это простое выражение его производной через саму функцию (которое позволило существенно сократить вычислительную сложность метода обратного распространения ошибки, сделав его применимым на практике):

f '(s) = f(s)x(1 – f(s))

f(s) = 1/(1 + e-as)

Нейрон

Слайд 15Нейрон – линейный классификатор

Искусственный нейрон – является однослойным персептроном (перцептроном), т.е.

Классический пример задачи, которая не по зубам однослойному перцептрону — исключающее ИЛИ (XOR или сумма по mod2)

TRUE

FALSE

AND

OR

XOR

Нейрон

Слайд 16Входной (сенсорный) слой

Скрытые слои (hidden layers)

Выходной слой

Многослойный персептрон

Персептрон

hidden layer 1

hidden layer

Слайд 17Многослойный персептрон

hidden = 4

Для решения задачи XOR, многослойный персептрон будет иметь

Персептрон

Слайд 21Работа нейронной сети

1 фаза) прямое распространение сигнала

2 фаза) обратное распространение ошибки

3

Три фазы работы нейронной сети при обучении:

Работа нейронной сети

Слайд 22http://robocraft.ru/blog/algorithm/560.html

1 слой

2 слой

Выходной слой

Работа нейронной сети

1 фаза) прямое распространение сигнала

Работа

Слайд 23http://robocraft.ru/blog/algorithm/560.html

Выходной слой

2 слой

1 слой

Работа нейронной сети

2 фаза) обратное распространение ошибки

Работа

Слайд 241-го слоя

2-го слоя

Выходного слоя

f '(s) = f(s)x(1 – f(s))

Работа нейронной сети

3

Работа нейронной сети

Слайд 25Факторный анализ

https://ru.wikipedia.org/wiki/https://ru.wikipedia.org/wiki/Факторный_анализ

Две основных цели факторного анализа:

определение взаимосвязей между переменными, классификация

сокращение числа переменных необходимых для описания данных.

Методы факторного анализа:

метод главных компонент;

корреляционный анализ;

метод максимального правдоподобия.

Факторный анализ

Слайд 26Метод главных компонент

https://ru.wikipedia.org/wiki/https://ru.wikipedia.org/wiki/Метод_главных_компонент

Метод главных компонент (principal component analysis, PCA) —

min

Карл Пирсон - 1901 год

Даны точки Pi на плоскости,

рi – расстояние от точки Pi

до прямой АВ.

Отыскать прямую АВ, чтобы:

Факторный анализ

http://www.ievbras.ru/ecostat/Kiril/Library/Book1/Content375/Content375.htm

Слайд 27Метод главных компонент

Дано конечное множество векторов x1, x2, …, xm

∈

⊂

Усреднение значений дает математическое ожидание случайной величины X, обозначаемое, как E(X). Если мы отцентрируем данные так, чтобы E(X)=0, то облако точек будет сконцентрировано вокруг начала координат.

Главная компонента определяется единичным вектором, выходящим из начала координат и совпадающим с направлением, вдоль которого дисперсия данных будет максимальной.

Фактор L0

Факторный анализ

Слайд 28http://habrahabr.ru/post/224495/

Анализ пиксельных компонент

Строим матричный образ каждой цифры.

2. Находим матрицу

ческого для всех

образов.

1,2

1,3

1,6

3,4

5,2

5,6

Кандидаты

на главные компоненты

Факторный анализ

Слайд 31 Если соотнести результат факторного анализа и образцы обучающей выборки, то можно

— фактор 1 — признаки данной области относятся к фону изображения (покров);

и — факторы 2 и 3 — области перехода от наблюдаемого

объекта к фону;

— фактор 4 — критерии данной области относятся непосредственно к наблюдаемому объекту;

— фактор 5 — возможные артефакты изображения. Некоторые входные образы содержали полосу снизу.

http://habrahabr.ru/post/139899/

Факторный анализ изображений

Факторный анализ

Слайд 32Практическое задание №1

Построить и обучить нейронную сеть, которая должна распознавать символы

Среда разработки RStudio. Пакет neuralnet.

Пособие «Моделирование нейронных сетей на R»

X1 = (00100011000010000100001000010001110)

Цель: добиться надежного распознавания искаженных цифр.

Практика

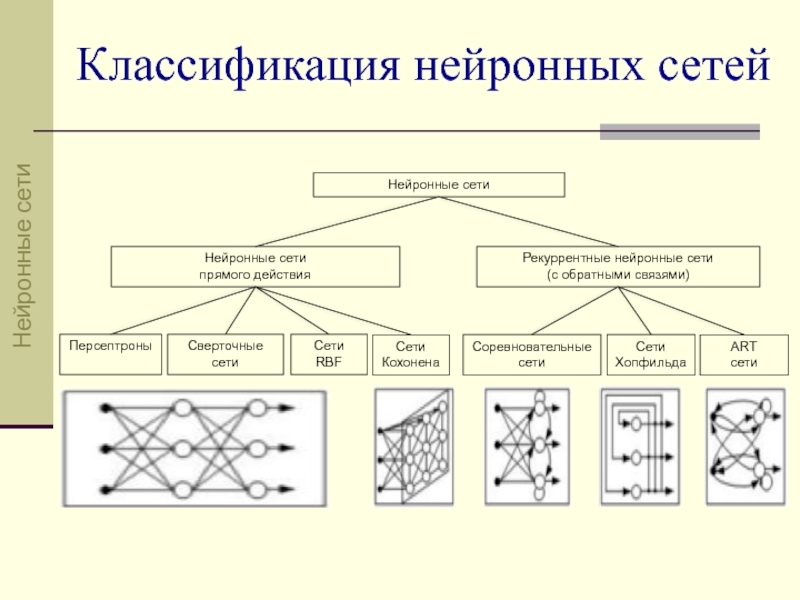

Слайд 34Классификация нейронных сетей

Нейронные сети

Нейронные сети

Нейронные сети

прямого действия

Рекуррентные нейронные сети

(с

Персептроны

Сверточные

сети

Сети

Кохонена

Сети

RBF

Соревновательные сети

Сети

Хопфильда

ART

сети

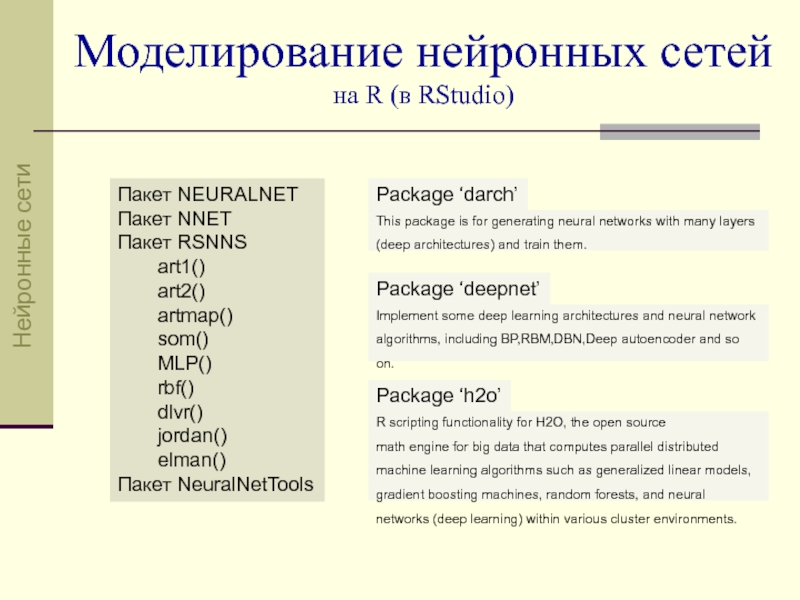

Слайд 35Моделирование нейронных сетей на R (в RStudio)

Пакет NEURALNET

Пакет NNET

Пакет RSNNS

art1()

art2()

artmap()

som()

MLP()

rbf()

dlvr()

jordan()

elman()

Пакет NeuralNetTools

Package ‘darch’

This package is for generating neural networks with many layers (deep architectures) and train them.

Implement some deep learning architectures and neural network algorithms, including BP,RBM,DBN,Deep autoencoder and so on.

R scripting functionality for H2O, the open source

math engine for big data that computes parallel distributed machine learning algorithms such as generalized linear models, gradient boosting machines, random forests, and neural networks (deep learning) within various cluster environments.

Package ‘deepnet’

Package ‘h2o’

Нейронные сети

Слайд 36Пакет NEURALNET

AND

net <- neuralnet(AND+OR~Var1+Var2+Var3, binary.data, hidden=0, linear.output=FALSE)

Var1 Var2 Var3 AND OR

1 0 0 0 0 0

2 1 0 0 0 1

3 0 1 0 0 1

4 1 1 0 0 1

5 0 0 1 0 1

6 1 0 1 0 1

7 0 1 1 0 1

8 1 1 1 1 1

Нейронные сети

Слайд 37Пакет NEURALNET

XOR

plot(net.xor, col.hidden = "red", col.intercept = "green",col.entry="dark green",

col.entry.synapse = "blue",col.out.synapse="red", col.out="yellow", fontsize=16)

Нейронные сети

Слайд 38Пакет NNET

ir

samp <- c(sample(1:50,25), sample(51:100,25), sample(101:150,25))

ir1 <- nnet(ir[samp,], targets[samp,], size = 2, rang = 0.1, decay = 5e-4, maxit = 200)

plot.nnet(ir1)

Нейронные сети

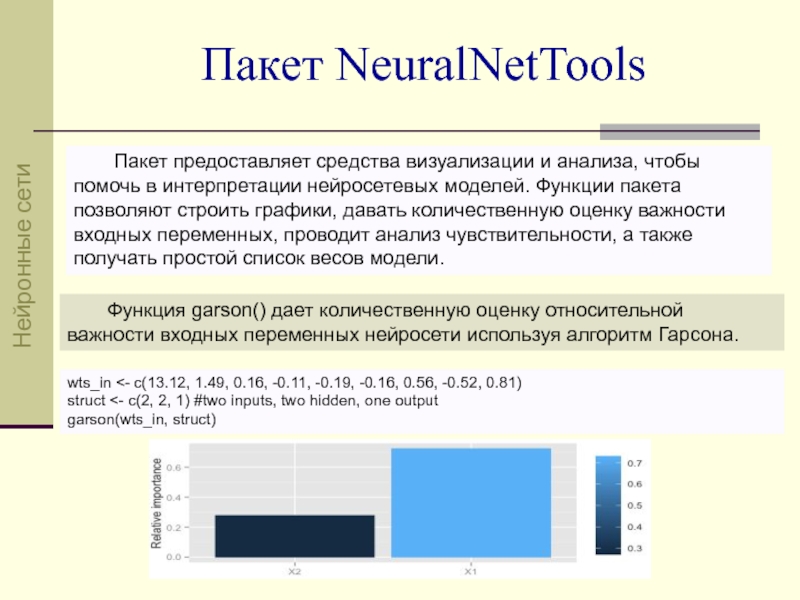

Слайд 39Пакет NeuralNetTools

Функция garson() дает количественную оценку относительной важности входных переменных нейросети

Пакет предоставляет средства визуализации и анализа, чтобы помочь в интерпретации нейросетевых моделей. Функции пакета позволяют строить графики, давать количественную оценку важности входных переменных, проводит анализ чувствительности, а также получать простой список весов модели.

wts_in <- c(13.12, 1.49, 0.16, -0.11, -0.19, -0.16, 0.56, -0.52, 0.81)

struct <- c(2, 2, 1) #two inputs, two hidden, one output

garson(wts_in, struct)

Нейронные сети

Слайд 40Сверточная нейронная сеть

Свёрточная нейронная сеть (convolutional neural network, CNN) — специальная

CNN технология построена по аналогии с принципами работы зрительной коры головного мозга, в которой были открыты так называемые простые клетки, реагирующие на прямые линии под разными углами, и сложные клетки, реакция которых связана с активацией определённого набора простых клеток.

Идея CNN заключается в чередовании сверточных слоев (convolution layers) и слоев подвыборки (subsampling layers).

CNN

Слайд 41В основу CNN положено 2 основные идеи:

1) идея:

(операция свертки)

2) идея: уплотнение

(max-pooling)

Сверточная нейронная сеть

CNN

Слайд 42http://www.kdnuggets.com/2015/04/inside-deep-learning-computer-vision-convolutional-neural-networks.html

Сверточная нейронная сеть

1) идея: фильтрация

Фильтры

определители

признаков

Карты признаков

Исходное изображение

Операция свертки

Фильтр – это

CNN

Слайд 43 Вместо входов при изучении сверточных сетей удобно рассматривать матрицу входных нейронов,

Каждый нейрон локального рецептивного региона связывается с одним нейроном скрытого слоя. Набор весовых коэффициентов образует фильтр.

Локальные рецептивные поля

Сверточная нейронная сеть

фильтрация

Входные нейроны

Входные нейроны

Скрытые нейроны

CNN

Слайд 44Сверточная нейронная сеть

сверточный слой (convolution layer)

На схеме слой нейронов сети представляет

Нейрон на карте признаков активируется, если фильтр определил подходящий признак в соответствующей позиции на предыдущем слое.

Карта признаков

Исходное изображение

(или карта признаков)

Сверточные

признаки

(convolved features)

x1

x0

x1

x0

x1

x0

x1

x0

x1

Фильтр

CNN

Слайд 46Если входное изображение 28 × 28, и локальный рецептивный регион 5

stride length

длина шага = 1

Сверточная нейронная сеть

формирование карты признаков

Входные нейроны

Входные нейроны

Первый скрытый слой

Первый скрытый слой

Фильтр не сканирует!

Фильтр – это связи с весами рецептивного региона анализируемого слоя с нейроном сверточного признака скрытого слоя.

Каждый элемент (признак) карты признаков сформирован своим единым для карты фильтром.

Рецептивный регион

Сверточный признак

Карта признаков

CNN

Слайд 47 Для распознавания изображений нужно много карт признаков:

Здесь показаны 3 карты признаков.

Такая сеть может распознать 3 различных признака. Каждый из них распознается по всему изображению.

Сверточная нейронная сеть

формирование карт признаков

28 х 28 входных нейронов

Первый скрытый слой: 3 х 24 х 24 нейронов

CNN

Слайд 48 Здесь 20 изображений соответствуют 20 различным картам признаков (фильтрам, ядрам). Каждая

Большое преимущество использования фиксированного набора весовых коэффициентов – существенное снижение числа параметров CNN.

Например, для каждой карты признаков имеем:

5 х 5 = 25

20 х 25 = 500

параметров сверточного слоя.

Сравним, полносвязный входной слой:

28 х 28 = 784

20 х 784 = 15680

число параметров больше чем в 30 раз.

Сверточная нейронная сеть

пример карты признаков

CNN

Слайд 49Сверточная нейронная сеть

2) идея: уплотнение (subsampling layer)

Max-уплотнение (max pooling) карты признаков

CNN

Слайд 50 Объединяющие слои следуют сразу после сверточных.

Объединяющий слой обрабатывает карту признаков

Общая процедура объединения, известная как max-pooling, просто берет значение максимально активизированного нейрона из определенного региона, например 2×2.

Поскольку сверточный слой включает 24×24 нейрона, после операции max-pooling получится 12×12 нейронов объединяющего слоя.

Сверточная нейронная сеть

метод max pooling

CNN

Max pool с фильтром 2х2

и шагом 2

Слайд 51 Сверточный слой включает несколько карт признаков. Метод max-pooling применяется отдельно для

В методе L2 pooling вместо используется квадратный корень из суммы квадратов активностей нейронов 2×2 региона. На практике широко используются оба метода.

Сверточная нейронная сеть

метод max pooling и L2 pooling

CNN

L2 pool с фильтром 2х2

и шагом 2

11.5

4.2

5.1

7.9

Слайд 52Фильтрация

операция свертки

Уплотнение

max pooling, L2 pooling

subsampling layer

convolution layer

Карта признаков

Карта признаков

Карта признаков

Исходное изображение

входные

MNIST

Простейшая CNN

фильтрация + уплотнение + распознавание

0

1

2

3

4

5

6

7

8

9

выходные

нейроны

CNN

Слайд 53Архитектура типовой cверточной нейронной сети

Ключевым моментом в понимании сверточных нейронных сетей

Помимо, сверточных слоев в CNN могут быть слои подвыборки (выполняющие функции уменьшения размерности пространства карт признаков) и полносвязные слои (выходной слой, как правило, всегда полносвязный). Все три вида слоев могут чередоваться в произвольном порядке, что позволяет составлять карты признаков из карт признаков, а это на практике означает способность распознавания сложных иерархий признаков.

CNN

Слайд 55 ImageNet данные 2011 года использовали 16 миллионов полноцветных изображений в 20000

ILSVRC - ImageNet Large Scale Visual Recognition Challenge

задача распознавания (классификации)

задача обнаружения

http://www.image-net.org/challenges/LSVRC/ - 2010, 2011, 2012, 2013, 2014, 2015

ILSVRC

Практика CNN

Слайд 64http://arxiv.org/pdf/1505.00855v1.pdf

Классификация картин при помощи CNN

Коллекция Wikiart содержит более 80000 картин

Ученые из Ратгерского университета (США, штат Нью-Джерси) научили нейронную сеть классифицировать произведения мирового искусства по жанрам, стилям и художникам.

Практика CNN

Слайд 66Классификация картин при помощи нейронных сетей

http://datareview.info/article/obzor-nauchnoy-publikatsii-klassifikatsiya-kartin-pri-pomoshhi-neyronnyih-setey/

Стили

Жанры

Художники

Практика CNN

Слайд 69Направления исследований

в области искусственного интеллекта

http://globalscience.ru/article/read/21348

Компания IBM создала модель из 530

"Это стало воплощением нашего видения проекта DARPA SyNAPSE, соединившим в себе нанотехнологии, нейробиологию и суперкомпьютеры для создания основы новой когнитивной компьютерной архитектуры, которая дополнит существующие сегодня фон-Неймановские машины"

"Вычисления (нейроны), память (синапсы) и сообщения (аксоны, дендриты), математически абстрагированы от биологических подробностей, для достижения максимизации функциональности (практичность, применяемость) и минимизации расходов (энергия, пространство, простой)"

Искусственный интеллект

Слайд 70Искусственный интеллект

Нейрочипы

http://citforum.ru/hardware/neurocomp/neyrocomp_04.shtml

http://2013.nscf.ru/TesisAll/Plenar/13_1520_GalyshkinAI_P13.pdf

Слайд 71CUPS (connections update per second) - число измененных значений весов в

CPS (connections per second) - число соединений (умножений с накоплением) в секунду (оценивает производительность).

CPSPW = CPS/Nw, где Nw - число синапсов в нейроне.

CPPS - число соединений примитовов в секунду, CPPS=CPS*Bw*Bs, где Bw, Bs - разрядность весов и синапсов.

MMAC - миллионов умножений с накоплением в секунду.

Оценка производительности

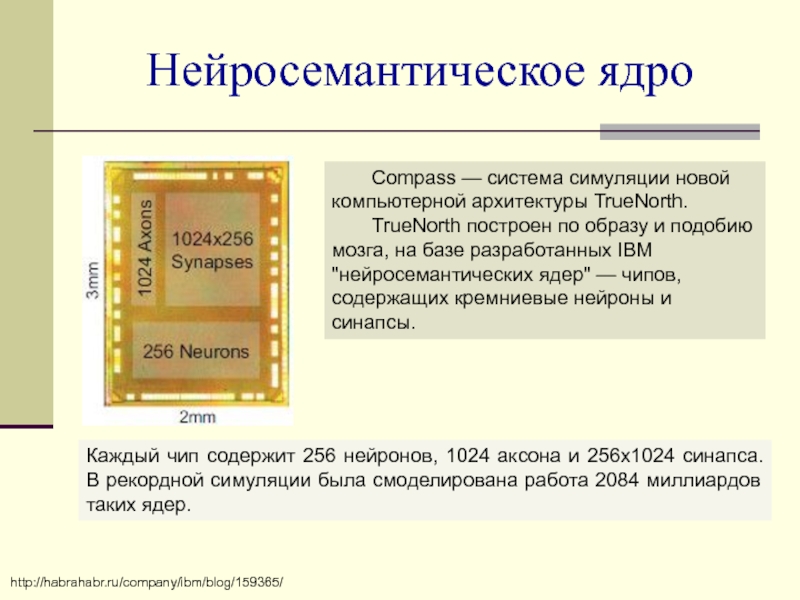

Слайд 74 Compass — система симуляции новой компьютерной архитектуры TrueNorth.

TrueNorth построен по

Каждый чип содержит 256 нейронов, 1024 аксона и 256х1024 синапса. В рекордной симуляции была смоделирована работа 2084 миллиардов таких ядер.

http://habrahabr.ru/company/ibm/blog/159365/

Нейросемантическое ядро