к.ф.-м.н., н.с. лаборатории Параллельных информационных технологий НИВЦ МГУ

- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Введение в параллельные вычисления. Технология программирования MPI (день второй) презентация

Содержание

- 1. Введение в параллельные вычисления. Технология программирования MPI (день второй)

- 2. MPI MPI - Message Passing Interface, интерфейс

- 3. MPI Префикс MPI_ . include ‘mpif.h’

- 4. MPI Каждый процесс может одновременно входить в

- 5. MPI Сообщение — набор данных некоторого типа. Атрибуты

- 6. MPI В последнем аргументе (в Си –

- 7. MPI MPI_INIT(IERR) INTEGER IERR Инициализация параллельной части

- 8. MPI MPI_FINALIZE(IERR) INTEGER IERR Завершение параллельной части

- 9. MPI Общая схема MPI-программы: PROGRAM EXAMPLE INCLUDE

- 10. MPI MPI_INITIALIZED(FLAG, IERR) LOGICAL FLAG INTEGER IERR

- 11. MPI MPI_COMM_SIZE(COMM, SIZE, IERR) INTEGER COMM, SIZE,

- 12. MPI MPI_COMM_RANK(COMM, RANK, IERR) INTEGER COMM, RANK,

- 13. MPI DOUBLE PRECISION MPI_WTIME(IERR) INTEGER IERR Функция

- 14. MPI DOUBLE PRECISION MPI_WTICK(IERR) INTEGER IERR Функция возвращает разрешение таймера в секундах.

- 15. MPI PROGRAM EXAMPLE INCLUDE ‘mpif.h’ INTEGER

- 16. MPI MPI_SEND(BUF, COUNT, DATATYPE, DEST, MSGTAG, COMM,

- 17. MPI Типы данных: MPI_INTEGER – INTEGER MPI_REAL

- 18. MPI Модификации функции MPI_SEND: MPI_BSEND — передача

- 19. MPI MPI_BUFFER_ATTACH(BUF, SIZE, IERR) BUF(*) INTEGER

- 20. MPI MPI_BUFFER_DETACH(BUF, SIZE, IERR) BUF(*) INTEGER

- 21. MPI MPI_RECV(BUF, COUNT, DATATYPE, SOURCE, MSGTAG, COMM,

- 22. MPI Вместо аргументов SOURCE и MSGTAG можно

- 23. MPI Параметры принятого сообщения всегда можно определить

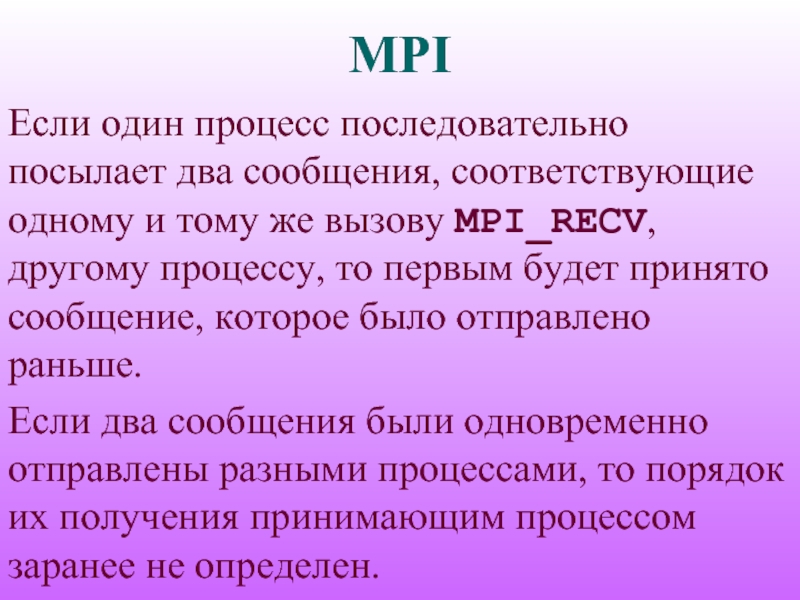

- 24. MPI Если один процесс последовательно посылает два

- 25. MPI MPI_GET_COUNT(STATUS, DATATYPE, COUNT, IERR) INTEGER COUNT,

- 26. MPI MPI_PROBE(SOURCE, MSGTAG, COMM, STATUS, IERR) INTEGER

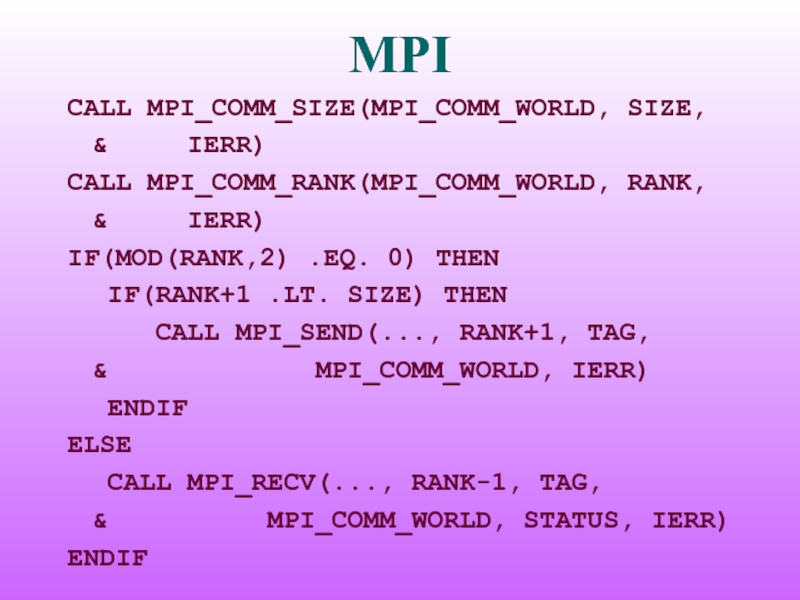

- 27. MPI CALL MPI_COMM_SIZE(MPI_COMM_WORLD, SIZE, &

Слайд 1Введение в параллельные вычисления. Технология программирования MPI (день второй)

Антонов Александр Сергеевич,

Слайд 2MPI

MPI - Message Passing Interface, интерфейс передачи сообщений.

Стандарт MPI 1.1.

Более 120

функций.

SPMD-модель параллельного программирования.

SPMD-модель параллельного программирования.

Слайд 3MPI

Префикс MPI_ .

include ‘mpif.h’

(mpi.h для языка Си)

Процессы, посылка сообщений.

Группы процессов, коммуникаторы.

MPI_COMM_WORLD

Слайд 4MPI

Каждый процесс может одновременно входить в разные коммуникаторы.

Два основных атрибута процесса:

коммуникатор (группа) и номер процесса в коммуникаторе (группе).

Если группа содержит n процессов, то номер любого процесса в данной группе лежит в пределах от 0 до n – 1.

Если группа содержит n процессов, то номер любого процесса в данной группе лежит в пределах от 0 до n – 1.

Слайд 5MPI

Сообщение — набор данных некоторого типа.

Атрибуты сообщения: номер процесса-отправителя, номер процесса-получателя, идентификатор

сообщения и др.

Идентификатор сообщения - целое неотрицательное число в диапазоне от 0 до 32767.

Для работы с атрибутами сообщений введен массив MPI_STATUS.

Идентификатор сообщения - целое неотрицательное число в диапазоне от 0 до 32767.

Для работы с атрибутами сообщений введен массив MPI_STATUS.

Слайд 6MPI

В последнем аргументе (в Си – возвращаемое значение функции) большинство функций

MPI возвращают информацию об успешности завершения.

В случае успешного выполнения функция вернет значение MPI_SUCCESS, иначе —код ошибки.

Предопределенные значения, соответствующие различным ошибочным ситуациям, определены в файле mpif.h

В случае успешного выполнения функция вернет значение MPI_SUCCESS, иначе —код ошибки.

Предопределенные значения, соответствующие различным ошибочным ситуациям, определены в файле mpif.h

Слайд 7MPI

MPI_INIT(IERR)

INTEGER IERR

Инициализация параллельной части программы. Все другие функции MPI могут быть

вызваны только после вызова MPI_INIT. Инициализация параллельной части для каждого приложения должна выполняться только один раз.

Слайд 8MPI

MPI_FINALIZE(IERR)

INTEGER IERR

Завершение параллельной части приложения. Все последующие обращения к любым MPI-функциям,

в том числе к MPI_INIT, запрещены. К моменту вызова MPI_FINALIZE каждым процессом программы все действия, требующие его участия в обмене сообщениями, должны быть завершены.

Слайд 9MPI

Общая схема MPI-программы:

PROGRAM EXAMPLE

INCLUDE ‘mpif.h’

INTEGER IERR

…

CALL MPI_INIT(IERR)

…

CALL MPI_FINALIZE(IERR)

…

END

Слайд 10MPI

MPI_INITIALIZED(FLAG, IERR)

LOGICAL FLAG

INTEGER IERR

В аргументе FLAG возвращает .TRUE., если вызвана из

параллельной части приложения, и .FALSE. в противном случае. Единственная MPI-функция, которую можно вызвать до вызова MPI_INIT.

Слайд 11MPI

MPI_COMM_SIZE(COMM, SIZE, IERR)

INTEGER COMM, SIZE, IERR

В аргументе SIZE возвращает число параллельных

процессов в коммуникаторе COMM.

Слайд 12MPI

MPI_COMM_RANK(COMM, RANK, IERR)

INTEGER COMM, RANK, IERR

В аргументе RANK возвращает номер

процесса

в коммуникаторе COMM в диапазоне от 0 до SIZE-1.

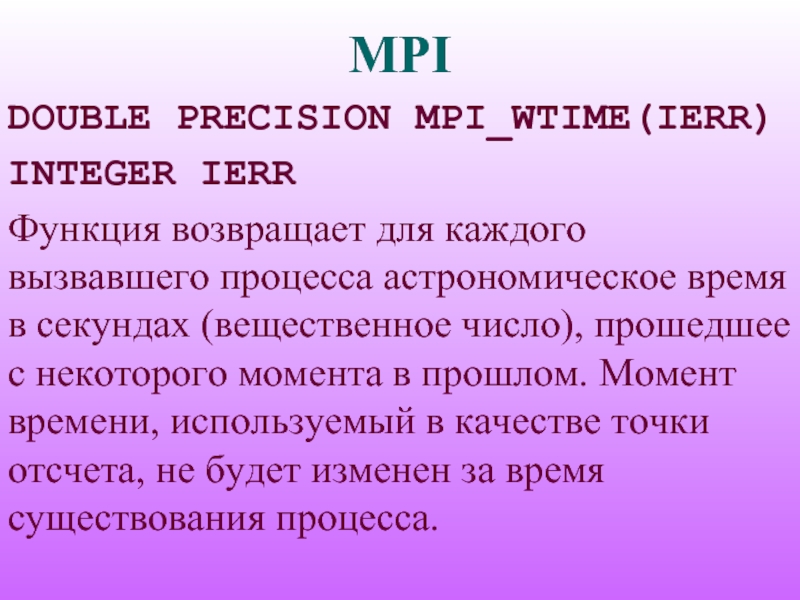

Слайд 13MPI

DOUBLE PRECISION MPI_WTIME(IERR)

INTEGER IERR

Функция возвращает для каждого вызвавшего процесса астрономическое время

в секундах (вещественное число), прошедшее с некоторого момента в прошлом. Момент времени, используемый в качестве точки отсчета, не будет изменен за время существования процесса.

Слайд 14MPI

DOUBLE PRECISION MPI_WTICK(IERR)

INTEGER IERR

Функция возвращает разрешение таймера в секундах.

Слайд 15MPI

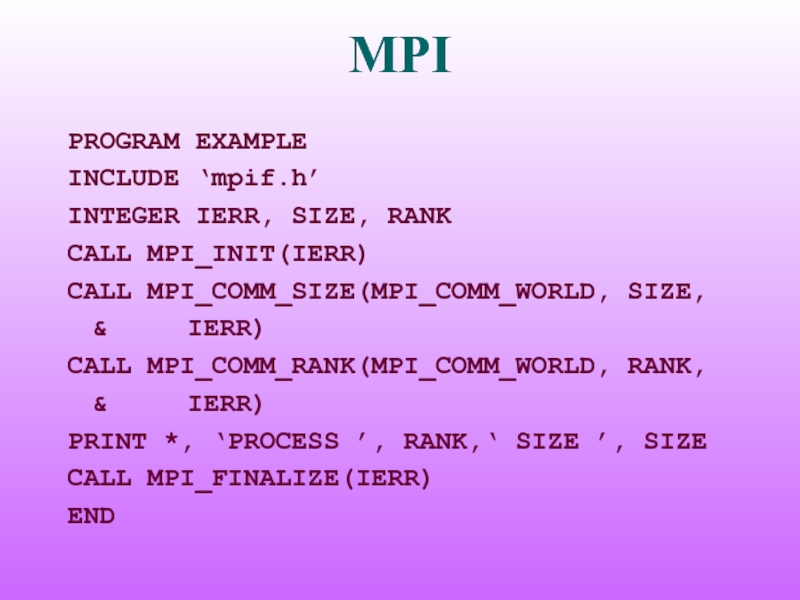

PROGRAM EXAMPLE

INCLUDE ‘mpif.h’

INTEGER IERR, SIZE, RANK

CALL MPI_INIT(IERR)

CALL MPI_COMM_SIZE(MPI_COMM_WORLD, SIZE,

& IERR)

CALL MPI_COMM_RANK(MPI_COMM_WORLD, RANK,

& IERR)

PRINT *, ‘PROCESS ’, RANK,‘ SIZE ’, SIZE

CALL MPI_FINALIZE(IERR)

END

CALL MPI_COMM_RANK(MPI_COMM_WORLD, RANK,

& IERR)

PRINT *, ‘PROCESS ’, RANK,‘ SIZE ’, SIZE

CALL MPI_FINALIZE(IERR)

END

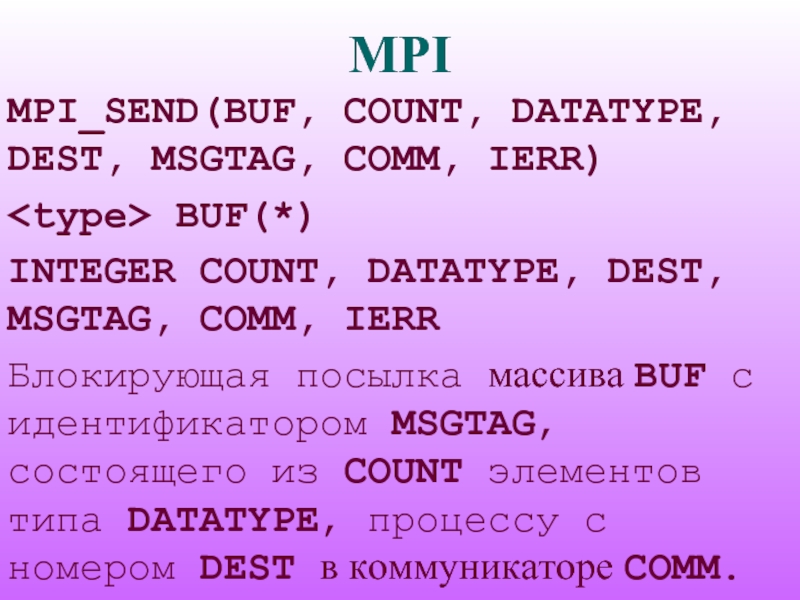

Слайд 16MPI

MPI_SEND(BUF, COUNT, DATATYPE, DEST, MSGTAG, COMM, IERR)

BUF(*)

INTEGER COUNT, DATATYPE, DEST,

MSGTAG, COMM, IERR

Блокирующая посылка массива BUF с идентификатором MSGTAG, состоящего из COUNT элементов типа DATATYPE, процессу с номером DEST в коммуникаторе COMM.

Блокирующая посылка массива BUF с идентификатором MSGTAG, состоящего из COUNT элементов типа DATATYPE, процессу с номером DEST в коммуникаторе COMM.

Слайд 17MPI

Типы данных:

MPI_INTEGER – INTEGER

MPI_REAL – REAL

MPI_DOUBLE_PRECISION – DOUBLE PRECISION

MPI_COMPLES – COMPLEX

MPI_LOGICAL

– LOGICAL

MPI_CHARACTER – CHARACTER(1)

MPI_BYTE – 8 бит

MPI_PACKED – тип для упакованных данных.

MPI_CHARACTER – CHARACTER(1)

MPI_BYTE – 8 бит

MPI_PACKED – тип для упакованных данных.

Слайд 18MPI

Модификации функции MPI_SEND:

MPI_BSEND — передача сообщения с буферизацией.

MPI_SSEND — передача сообщения с синхронизацией.

MPI_RSEND

— передача сообщения по готовности.

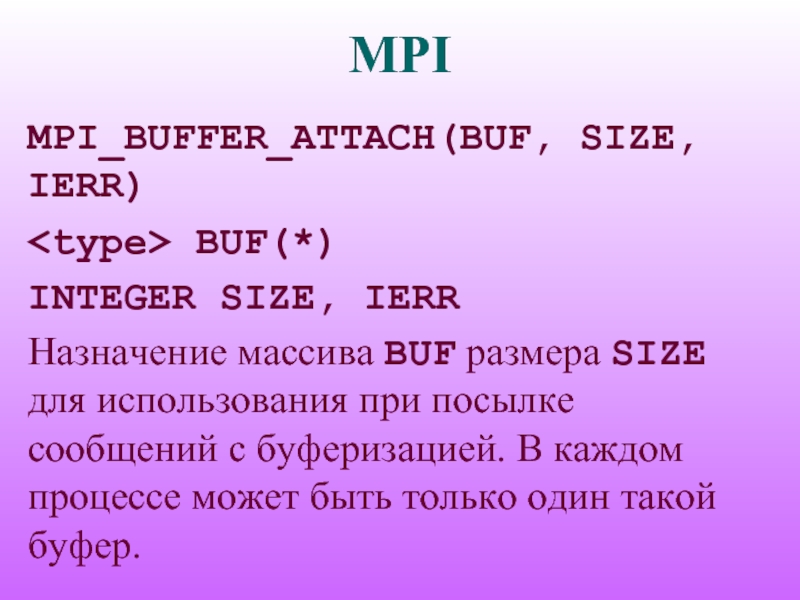

Слайд 19MPI

MPI_BUFFER_ATTACH(BUF, SIZE, IERR)

BUF(*)

INTEGER SIZE, IERR

Назначение массива BUF размера SIZE для

использования при посылке сообщений с буферизацией. В каждом процессе может быть только один такой буфер.

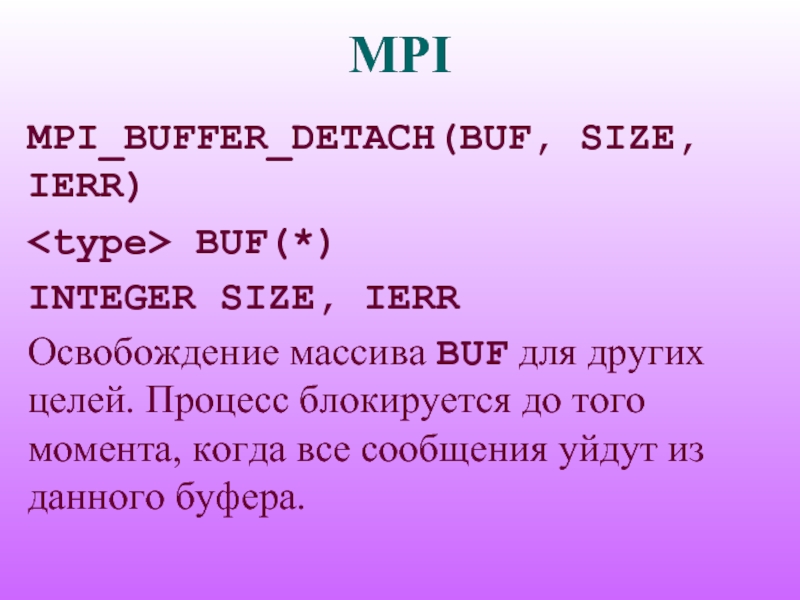

Слайд 20MPI

MPI_BUFFER_DETACH(BUF, SIZE, IERR)

BUF(*)

INTEGER SIZE, IERR

Освобождение массива BUF для других целей.

Процесс блокируется до того момента, когда все сообщения уйдут из данного буфера.

Слайд 21MPI

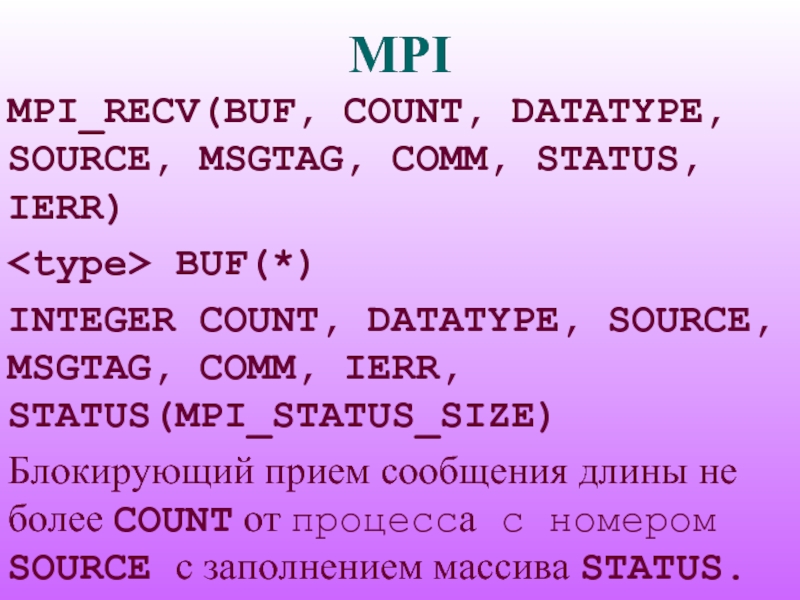

MPI_RECV(BUF, COUNT, DATATYPE, SOURCE, MSGTAG, COMM, STATUS, IERR)

BUF(*)

INTEGER COUNT, DATATYPE,

SOURCE, MSGTAG, COMM, IERR, STATUS(MPI_STATUS_SIZE)

Блокирующий прием сообщения длины не более COUNT от процесса с номером SOURCE с заполнением массива STATUS.

Блокирующий прием сообщения длины не более COUNT от процесса с номером SOURCE с заполнением массива STATUS.

Слайд 22MPI

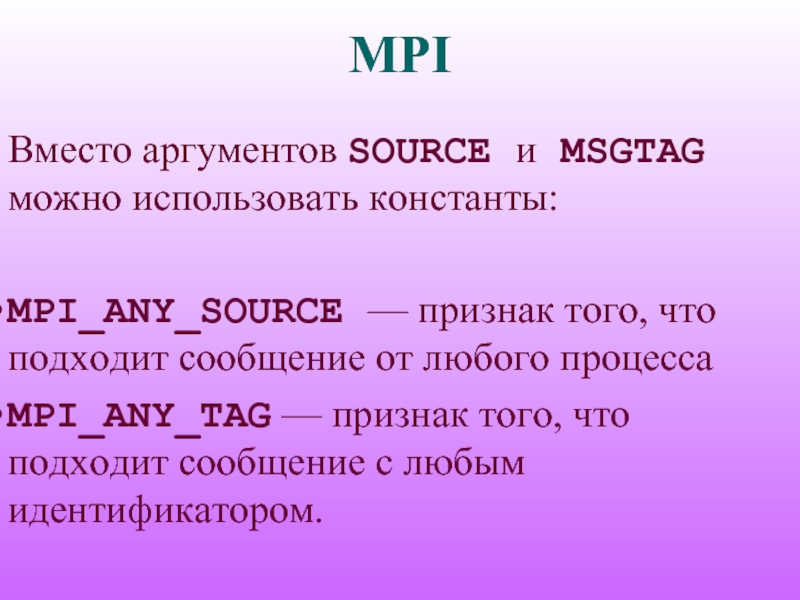

Вместо аргументов SOURCE и MSGTAG можно использовать константы:

MPI_ANY_SOURCE — признак того, что подходит

сообщение от любого процесса

MPI_ANY_TAG — признак того, что подходит сообщение с любым идентификатором.

MPI_ANY_TAG — признак того, что подходит сообщение с любым идентификатором.

Слайд 23MPI

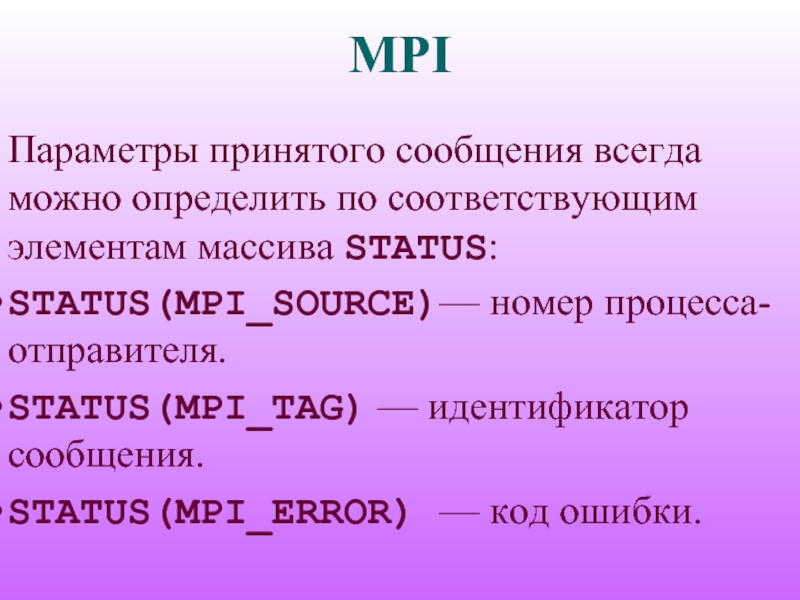

Параметры принятого сообщения всегда можно определить по соответствующим элементам массива STATUS:

STATUS(MPI_SOURCE)— номер

процесса-отправителя.

STATUS(MPI_TAG) — идентификатор сообщения.

STATUS(MPI_ERROR) — код ошибки.

STATUS(MPI_TAG) — идентификатор сообщения.

STATUS(MPI_ERROR) — код ошибки.

Слайд 24MPI

Если один процесс последовательно посылает два сообщения, соответствующие одному и тому

же вызову MPI_RECV, другому процессу, то первым будет принято сообщение, которое было отправлено раньше.

Если два сообщения были одновременно отправлены разными процессами, то порядок их получения принимающим процессом заранее не определен.

Если два сообщения были одновременно отправлены разными процессами, то порядок их получения принимающим процессом заранее не определен.

Слайд 25MPI

MPI_GET_COUNT(STATUS, DATATYPE, COUNT, IERR)

INTEGER COUNT, DATATYPE, IERR, STATUS(MPI_STATUS_SIZE)

По значению параметра STATUS

функция определяет число COUNT уже принятых (после обращения к MPI_RECV) или принимаемых (после обращения к MPI_PROBE или MPI_IPROBE) элементов сообщения типа DATATYPE.

Слайд 26MPI

MPI_PROBE(SOURCE, MSGTAG, COMM, STATUS, IERR)

INTEGER SOURCE, MSGTAG, COMM, IERR, STATUS(MPI_STATUS_SIZE)

Получение в

массиве STATUS информации о структуре ожидаемого сообщения с блокировкой. Возврата не произойдет, пока сообщение с подходящим идентификатором и номером процесса-отправителя не будет доступно для получения.

Слайд 27MPI

CALL MPI_COMM_SIZE(MPI_COMM_WORLD, SIZE,

& IERR)

CALL MPI_COMM_RANK(MPI_COMM_WORLD, RANK,

& IERR)

IF(MOD(RANK,2) .EQ. 0) THEN

IF(RANK+1 .LT. SIZE) THEN

CALL MPI_SEND(..., RANK+1, TAG,

& MPI_COMM_WORLD, IERR)

ENDIF

ELSE

CALL MPI_RECV(..., RANK-1, TAG,

& MPI_COMM_WORLD, STATUS, IERR)

ENDIF

IF(MOD(RANK,2) .EQ. 0) THEN

IF(RANK+1 .LT. SIZE) THEN

CALL MPI_SEND(..., RANK+1, TAG,

& MPI_COMM_WORLD, IERR)

ENDIF

ELSE

CALL MPI_RECV(..., RANK-1, TAG,

& MPI_COMM_WORLD, STATUS, IERR)

ENDIF