- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

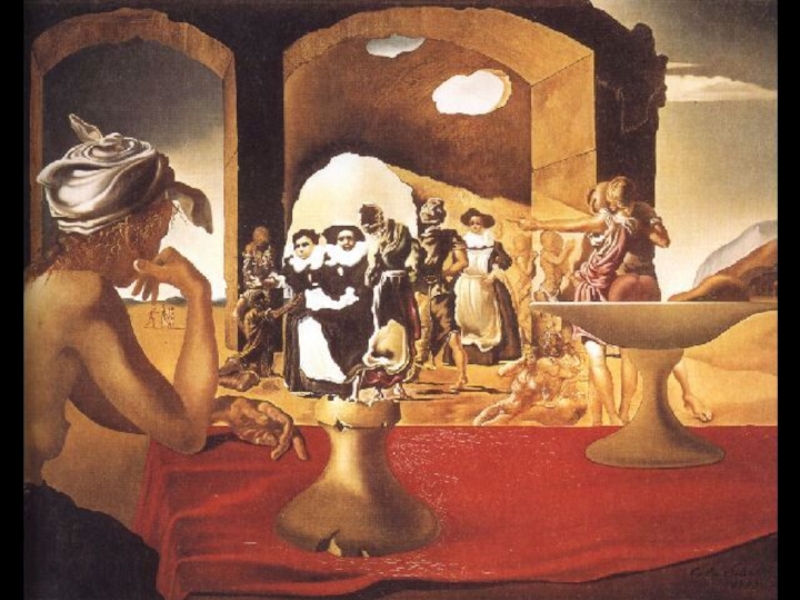

Нейронные сети. StatSoft Russia презентация

Содержание

- 1. Нейронные сети. StatSoft Russia

- 4. Физическая аналогия

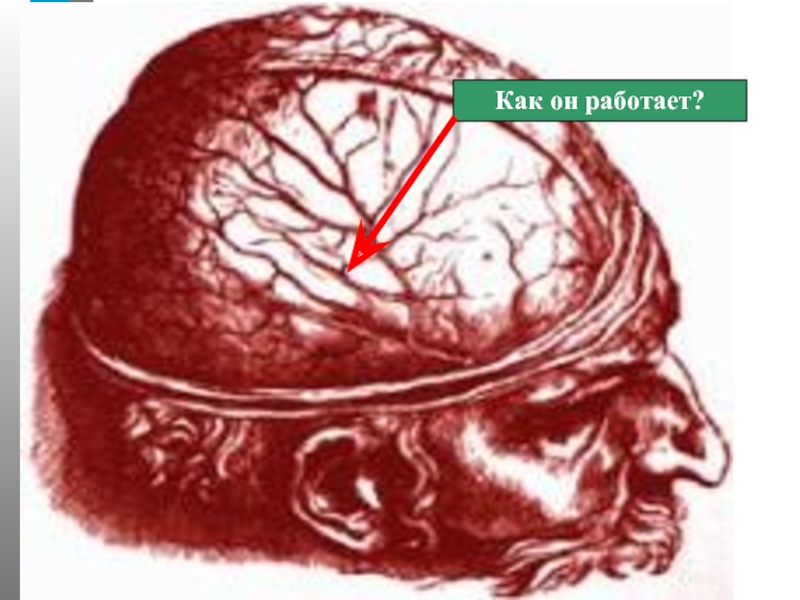

- 5. Как он работает?

- 6. Современная биология: Клетка - элементарный процессор, способный

- 8. Интересные данные Тело клетки имеет размер 3

- 10. Нервная ткань: Лишена регенерации Её нейроны способны

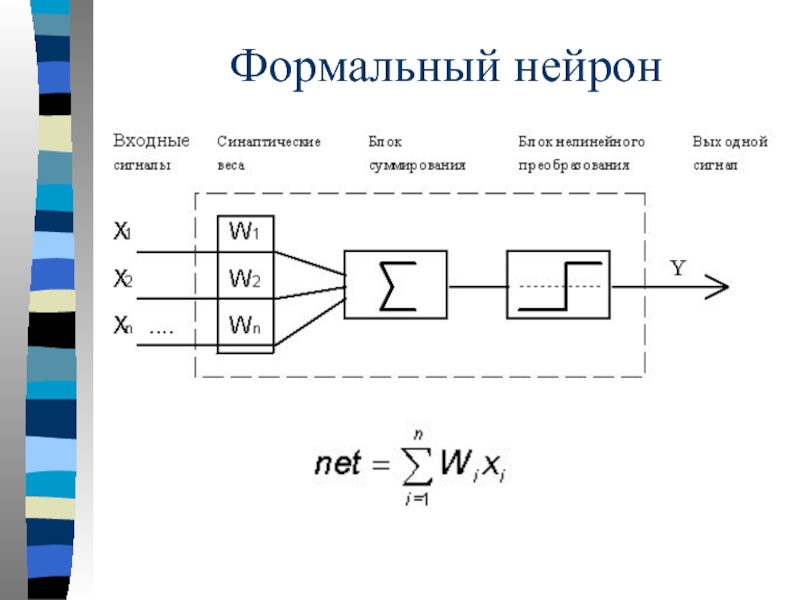

- 11. Формальный нейрон

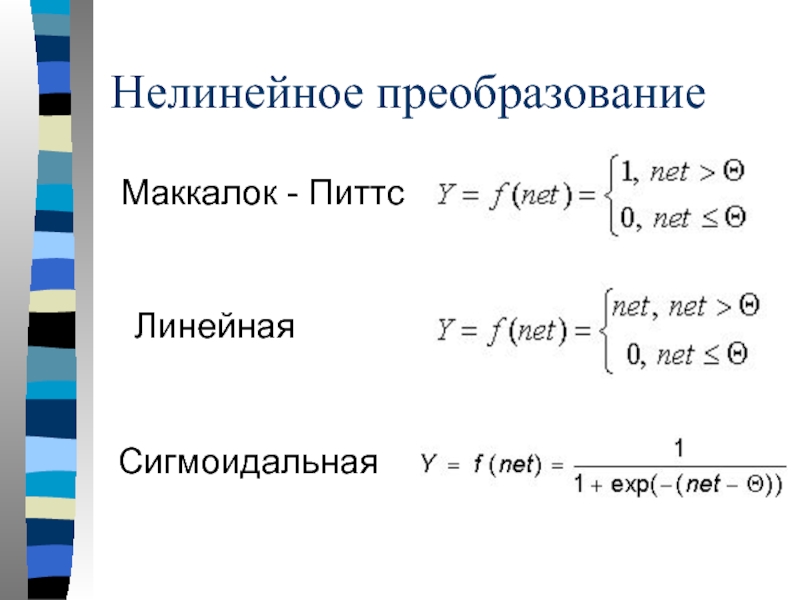

- 12. Нелинейное преобразование Маккалок - Питтс Линейная Сигмоидальная

- 13. Перцептрон Розенблата S- сенсорные, А - ассоциативные,

- 14. Обучение сети Обучить нейронную сеть это значит,

- 15. Обучение перцептрона Начальные значения весов

- 16. Обучение перцептрона Вычисляется вектор ошибки,

- 17. Обучение перцептрона Вектор весов модифицируется

- 18. Параметры Обучение проводится для всех обучающих векторов.

- 19. Возможности применения Теорема о полноте:

- 20. Этапы построения сети Выбор архитектуры сети Число

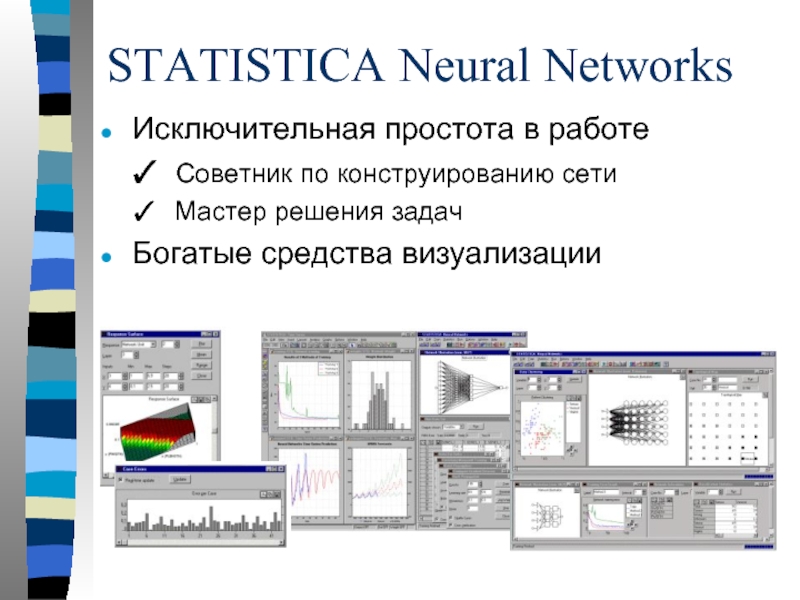

- 21. STATISTICA Neural Networks Программный пакет для создания

- 22. Исключительная простота в работе Советник по

- 23. STATISTICA Neural Networks: работа с данными Структура

- 24. STATISTICA Neural Networks: построение сетей Создание и

- 25. STATISTICA Neural Networks: обучение сетей Большой выбор

- 26. STATISTICA Neural Networks: работа с сетью Оценки

- 27. STATISTICA Neural Network: дополнительные функции Генетический алгоритм

- 28. STATISTICA Neural Networks: создание приложений Взаимодействие с

- 29. Прогнозирование результатов выборов президента США

- 30. Условия моделирования Предвыборные компании кандидатов отработаны добросовестно

- 31. Входные данные Правящая партия у власти более

- 32. Входные данные Кандидат от правящей партии был

- 33. Входные данные Во время правления были существенные

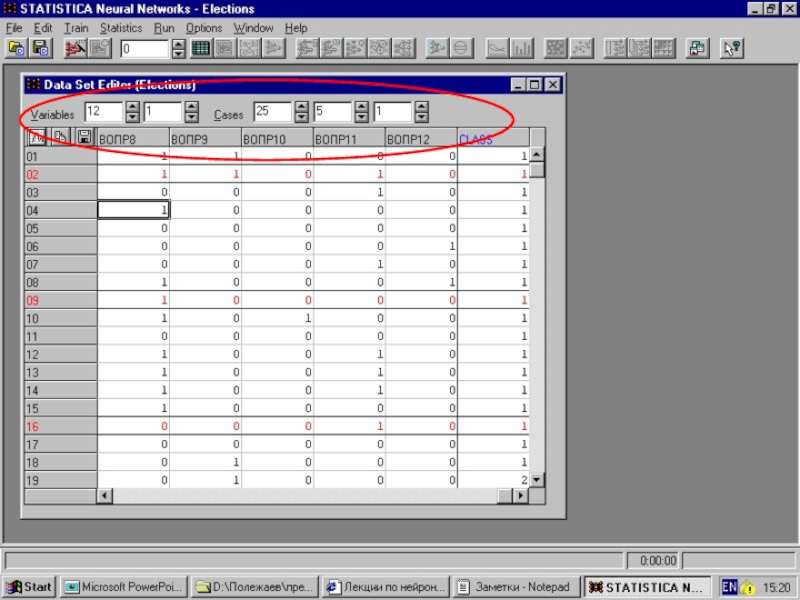

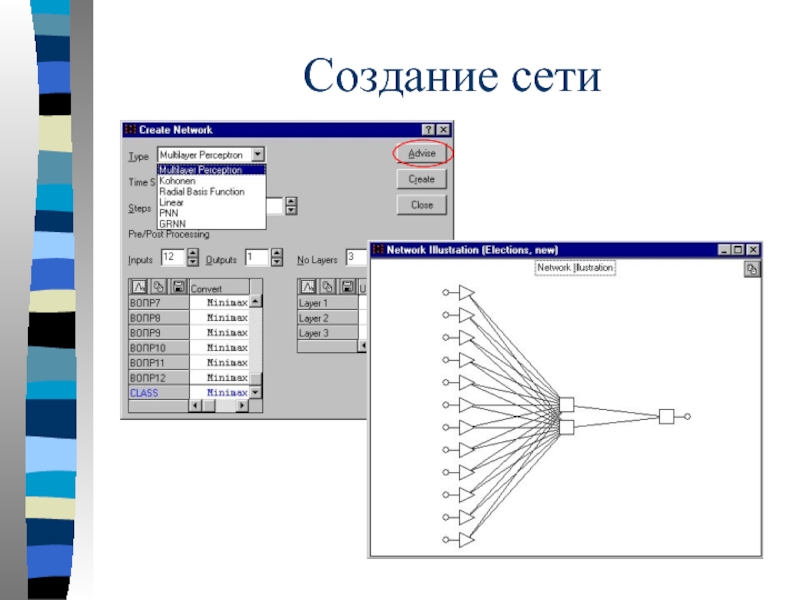

- 35. Создание сети

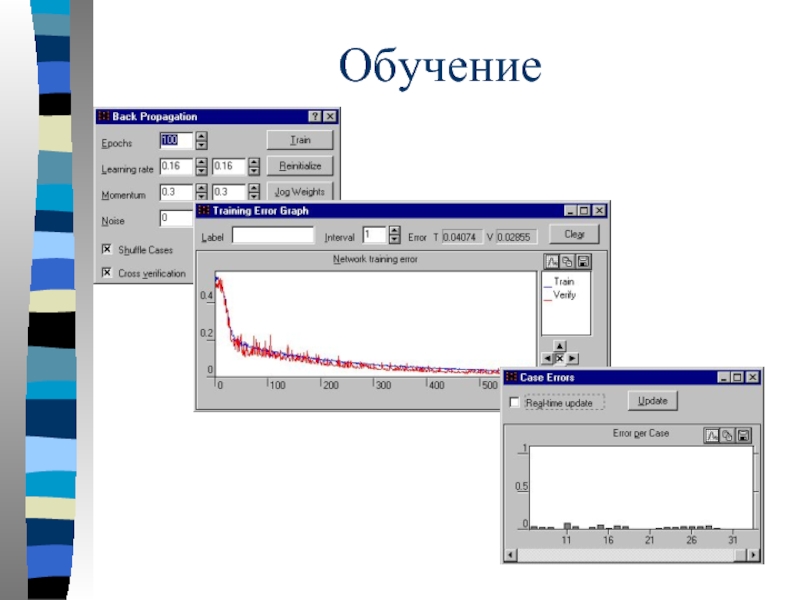

- 36. Обучение

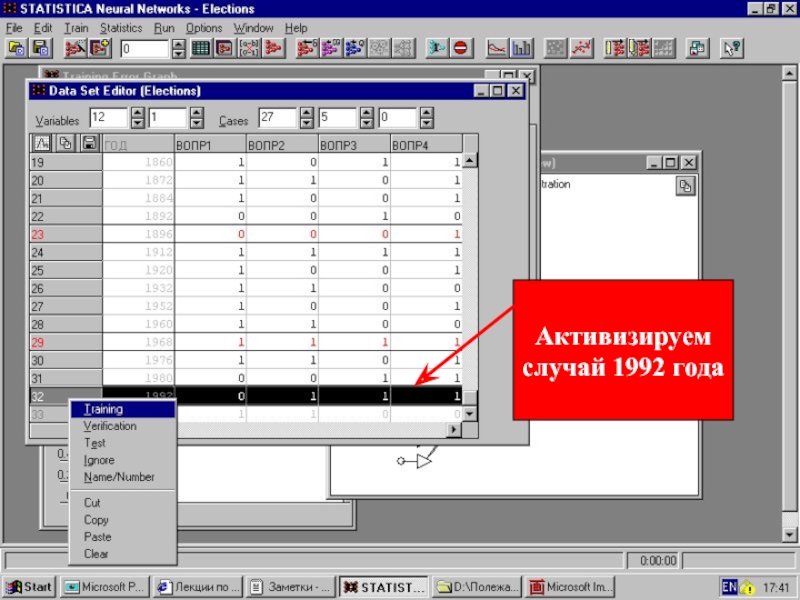

- 37. Активизируем случай 1992 года

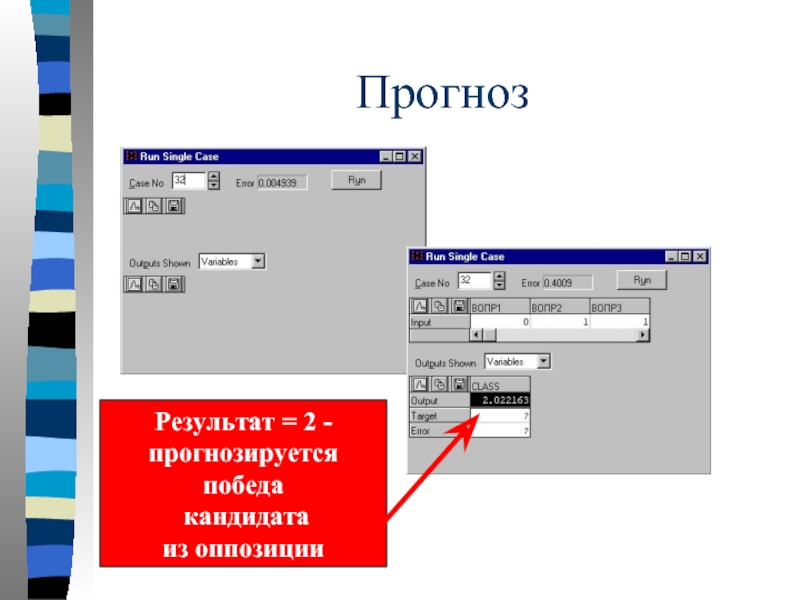

- 38. Прогноз Результат = 2 - прогнозируется победа кандидата из оппозиции

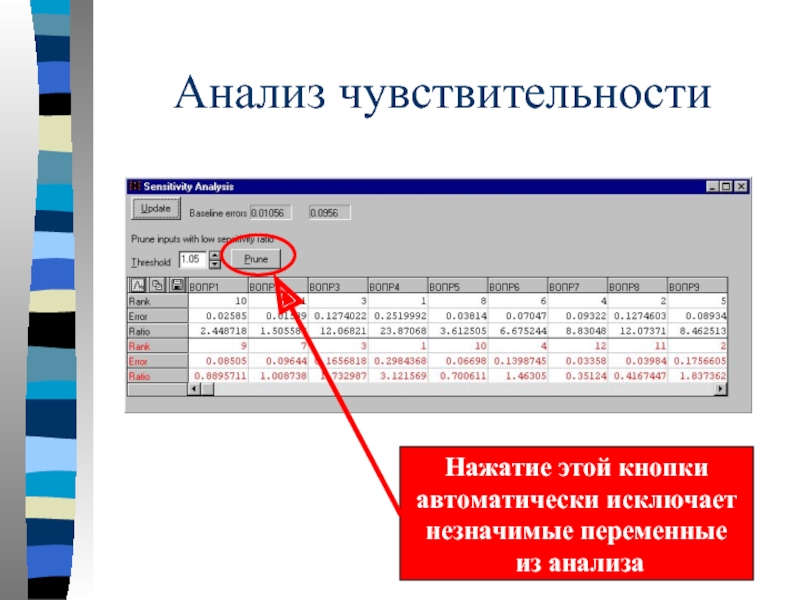

- 39. Анализ чувствительности Нажатие этой кнопки автоматически исключает незначимые переменные из анализа

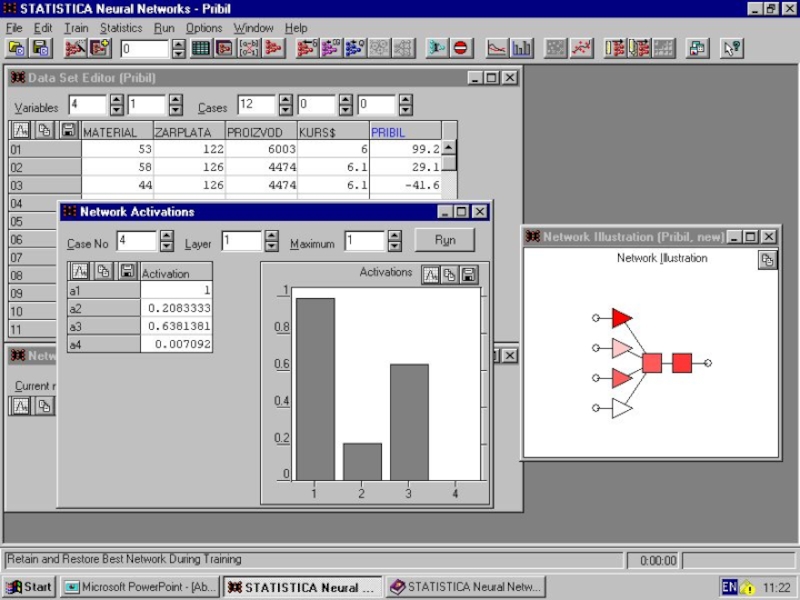

- 40. На основе экспертных данных выявить факторы, наиболее влияющие на прибыль предприятия

- 41. Представлены факторы Затраты на материалы Объем зарплаты Производительность труда Курс доллара США

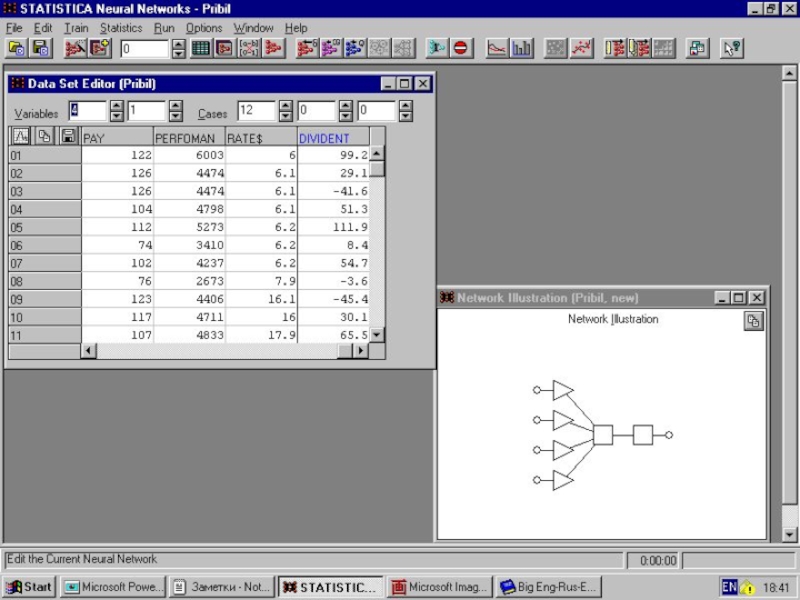

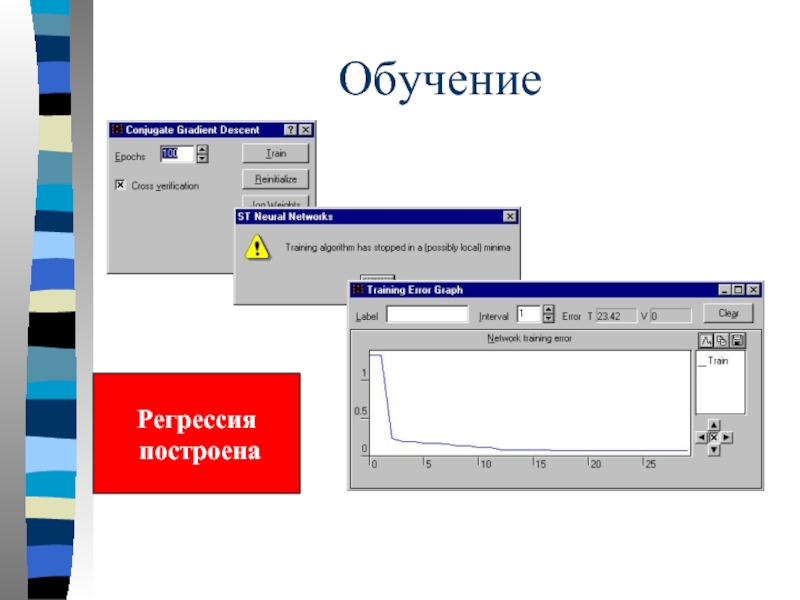

- 43. Обучение Регрессия построена

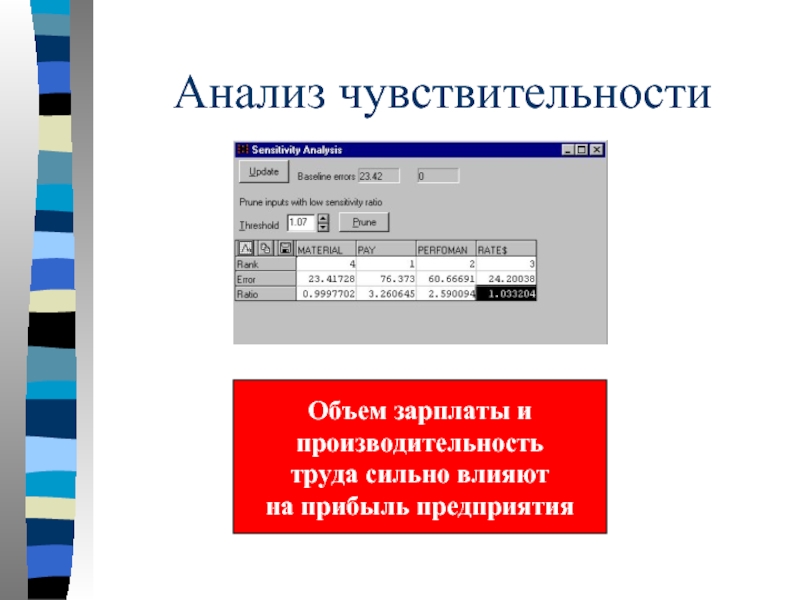

- 44. Анализ чувствительности Объем зарплаты и производительность труда сильно влияют на прибыль предприятия

- 46. Анализ и прогнозирование объема продаж сетей автозаправочных станций в США

- 47. График временного ряда

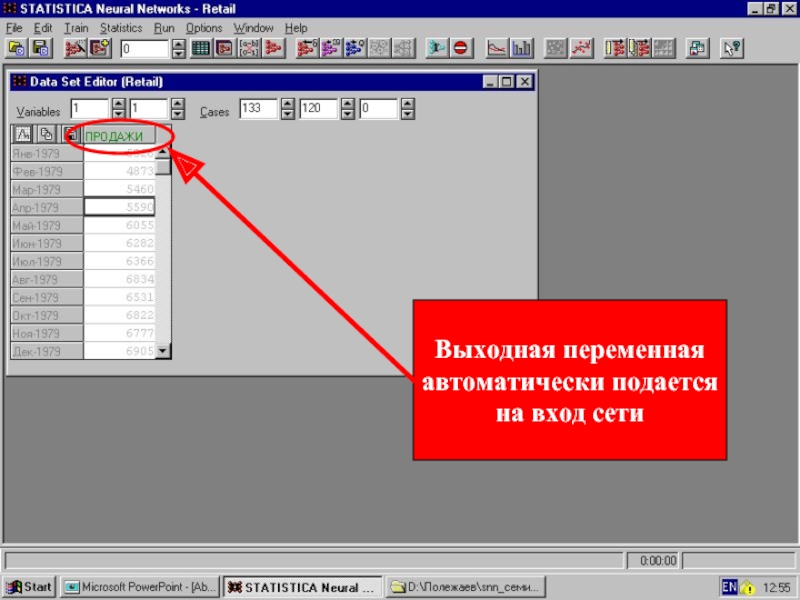

- 48. Выходная переменная автоматически подается на вход сети

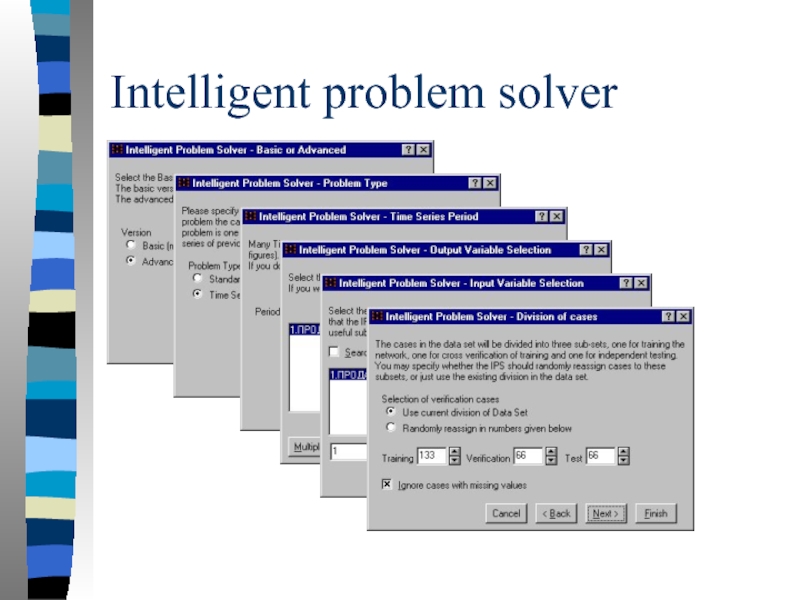

- 49. Intelligent problem solver

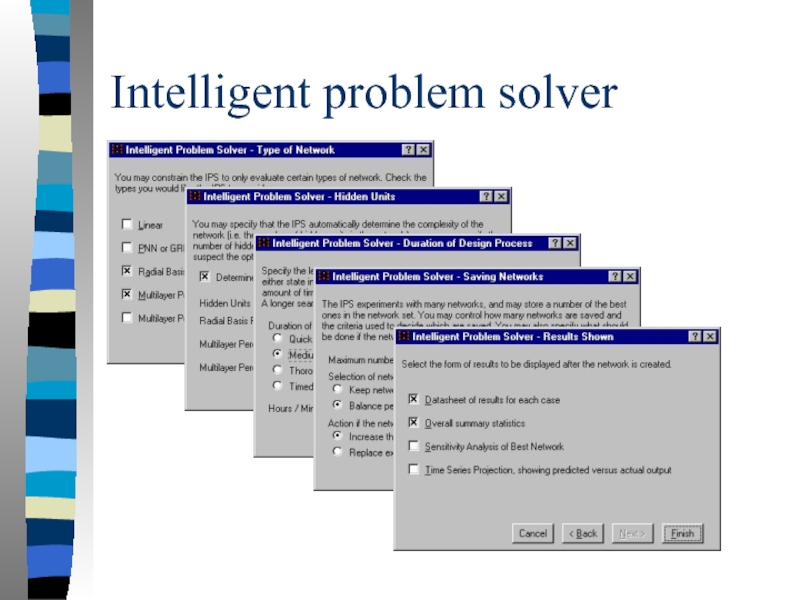

- 50. Intelligent problem solver

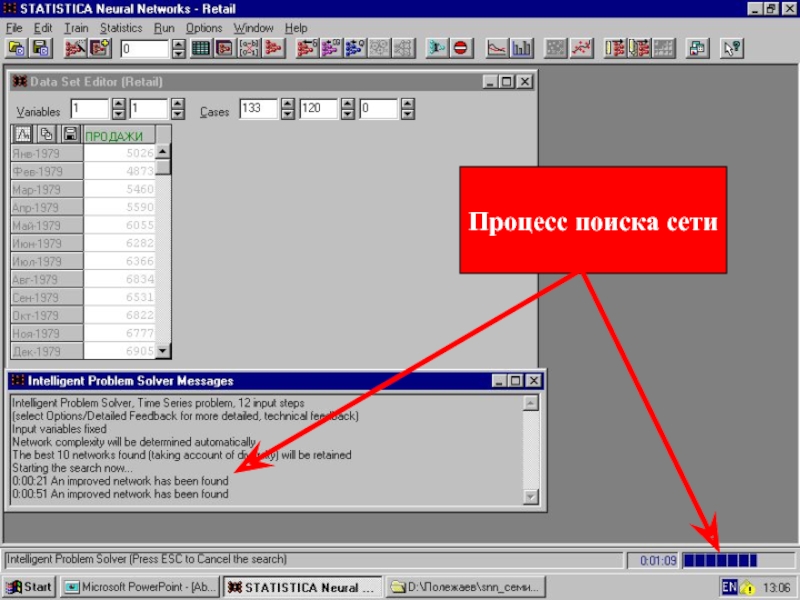

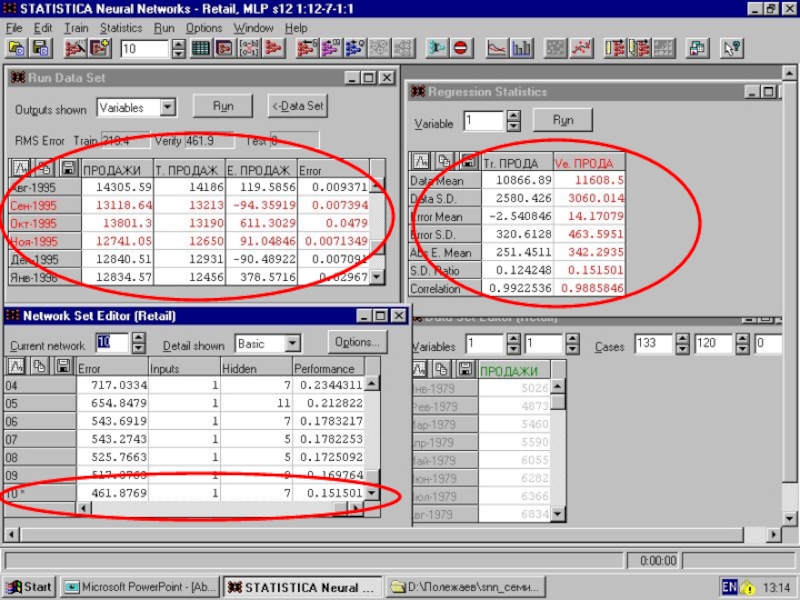

- 51. Процесс поиска сети

- 53. Обсуждение результатов Глубина прогноза Отправная точка

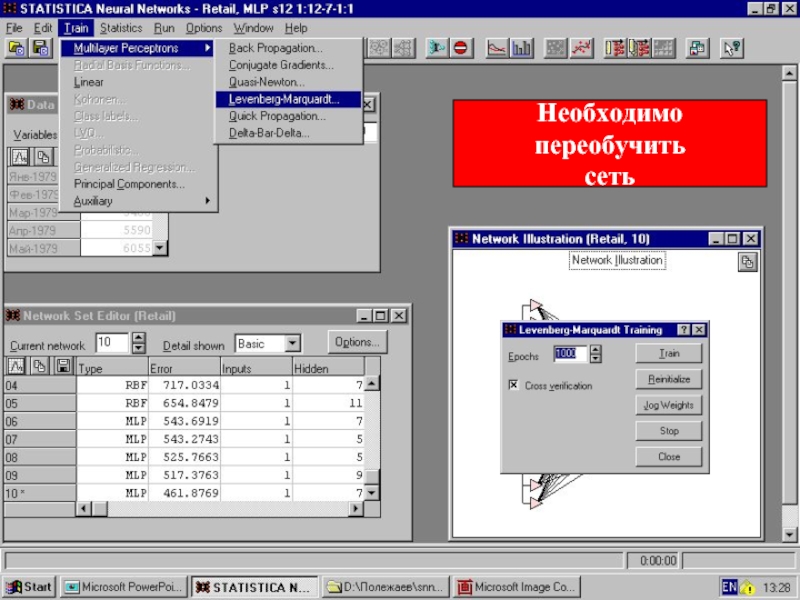

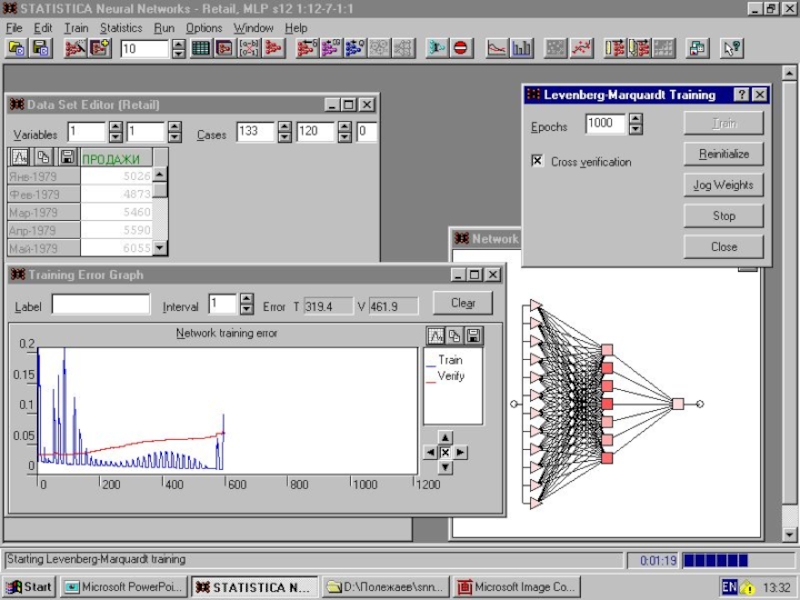

- 54. Необходимо переобучить сеть

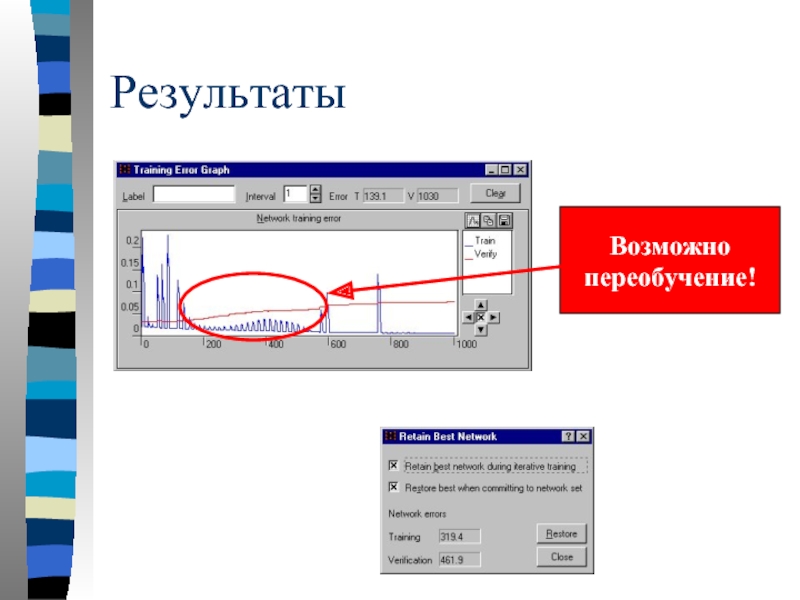

- 56. Результаты Возможно переобучение!

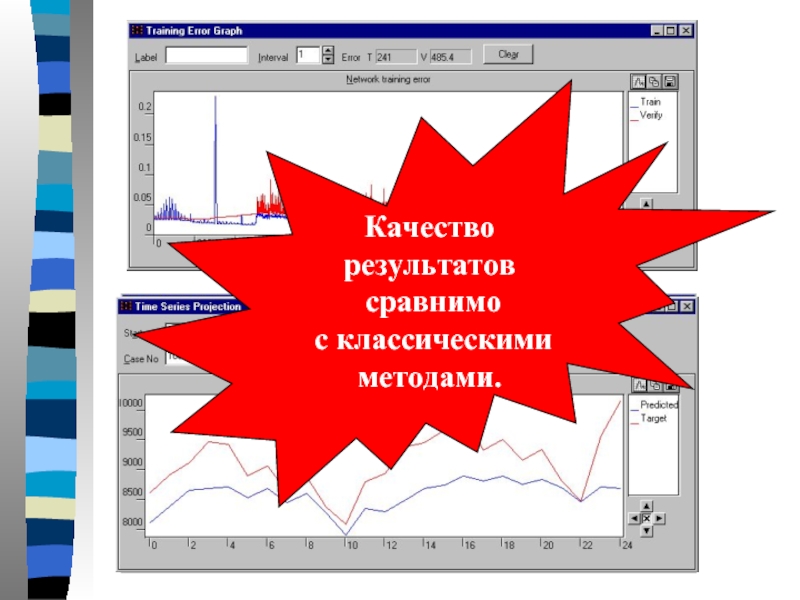

- 57. Качество результатов сравнимо с классическими методами.

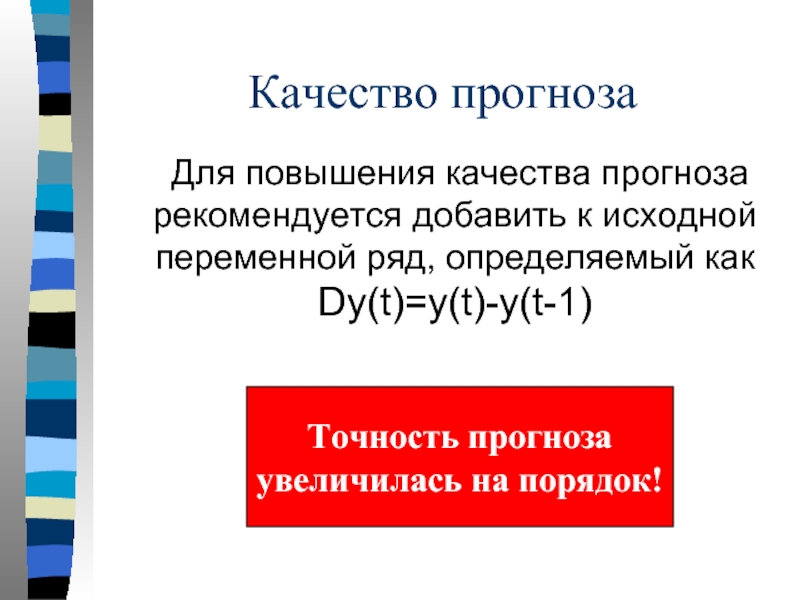

- 58. Качество прогноза Для повышения качества прогноза рекомендуется

- 59. Модель распределенной нейронной памяти Каждый

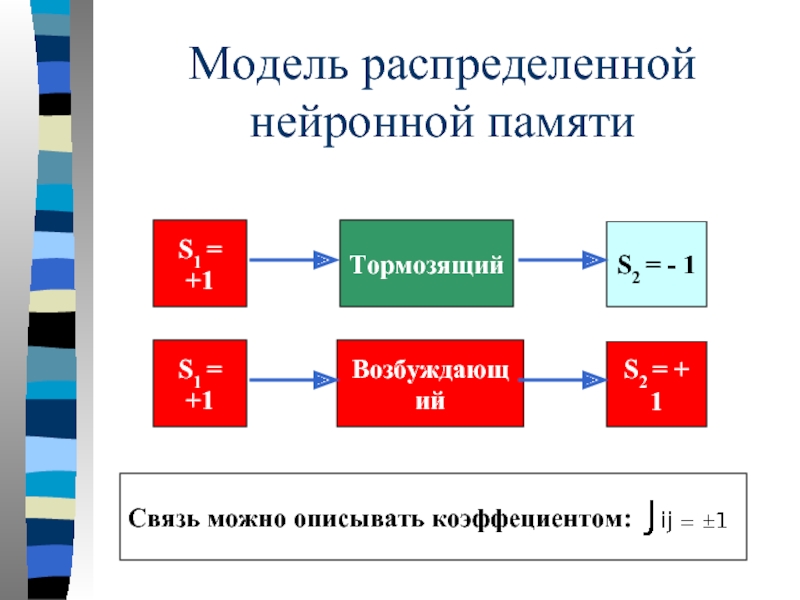

- 60. Модель распределенной нейронной памяти Тормозящий S1 =

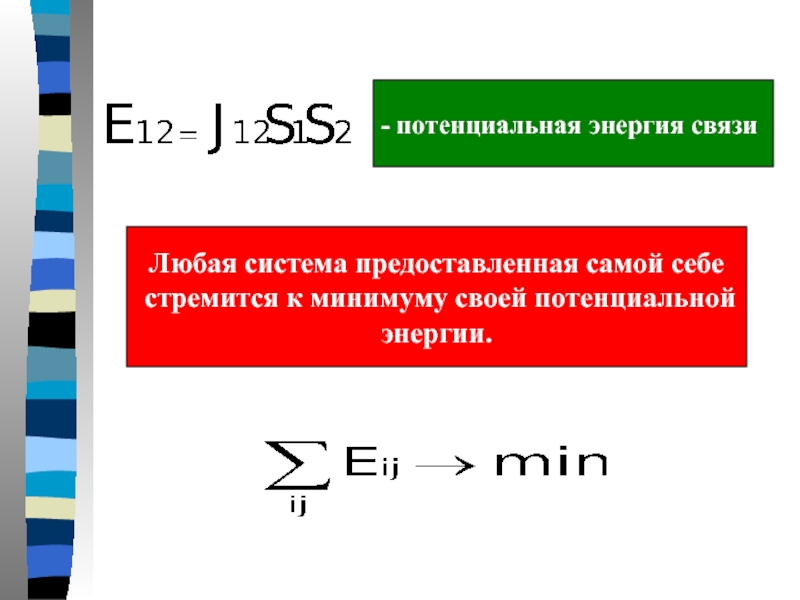

- 61. - потенциальная энергия связи Любая система

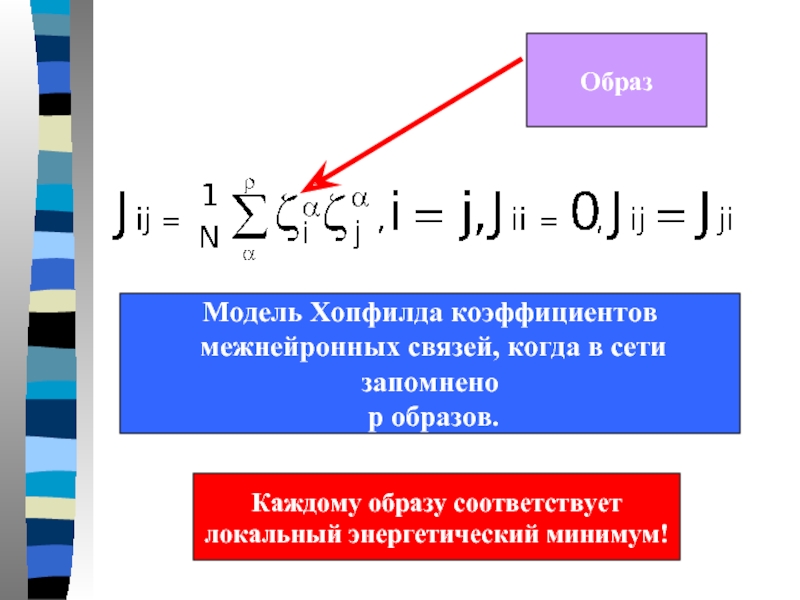

- 62. Модель Хопфилда коэффициентов межнейронных связей, когда

- 63. Бимодальный образ Качественный вид потенциальной функции Хопфилда

- 64. Модель Хакена Образы описываются параметрами порядка: d1

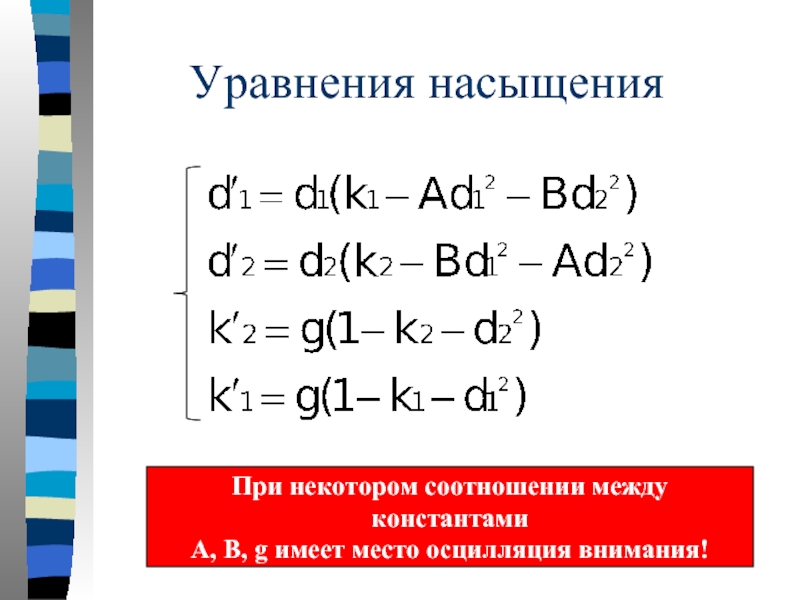

- 65. Уравнения насыщения При некотором соотношении между константами А, B, g имеет место осцилляция внимания!

- 66. Период колебаний При зрительном восприятии: T

- 67. Мы обсудили Проблему неоднозначности в искусстве Биологические

- 68. Мы обсудили Задачу: выявление показателей, влияющих на

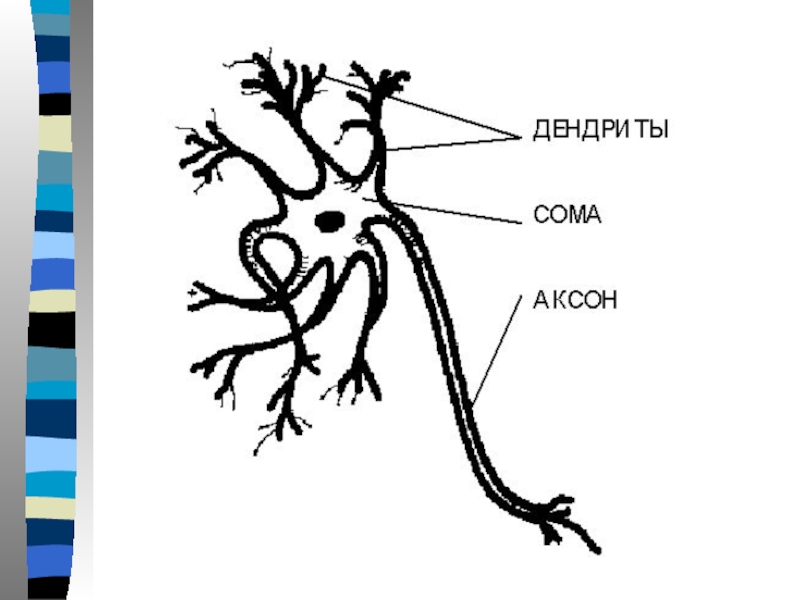

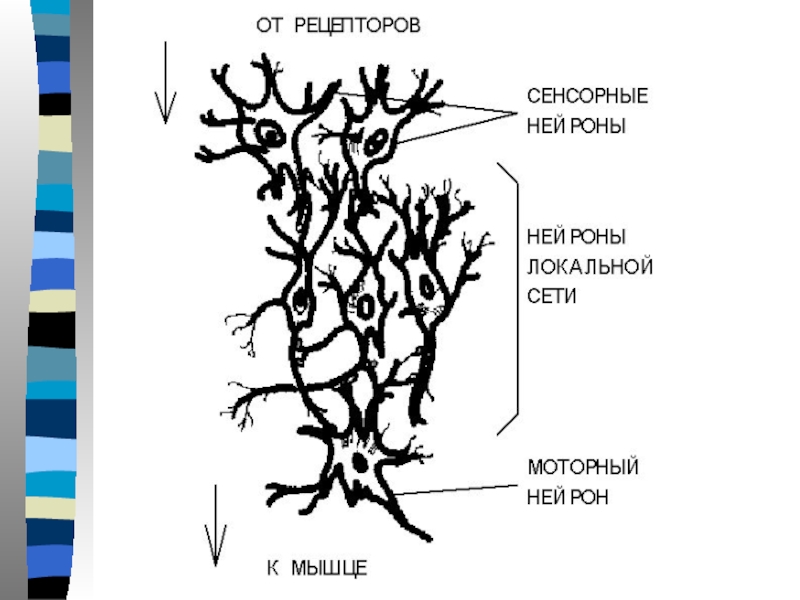

Слайд 6Современная биология:

Клетка - элементарный процессор, способный к простейшей обработке информации

Нейрон -

Нейрон осуществляет прием и передачу информации в виде импульсов нервной активности

Природа импульсов - электрохимическая

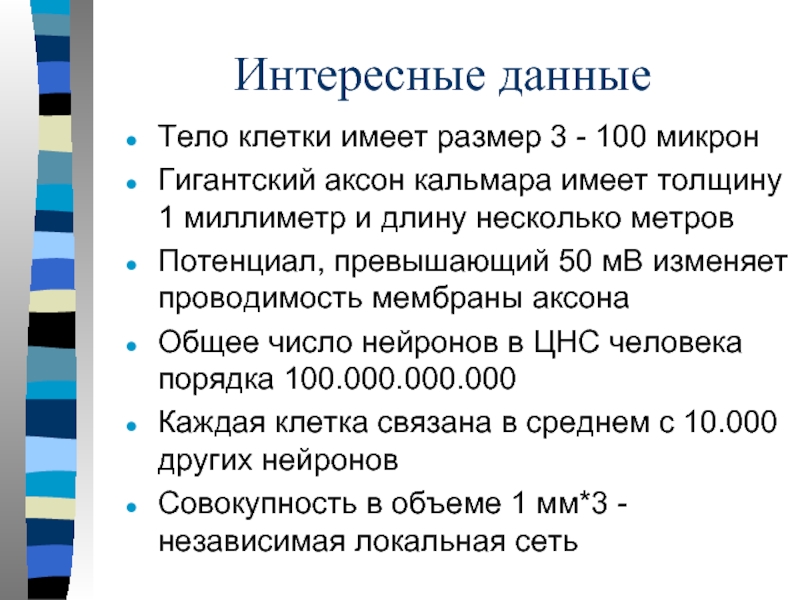

Слайд 8Интересные данные

Тело клетки имеет размер 3 - 100 микрон

Гигантский аксон кальмара

Потенциал, превышающий 50 мВ изменяет проводимость мембраны аксона

Общее число нейронов в ЦНС человека порядка 100.000.000.000

Каждая клетка связана в среднем с 10.000 других нейронов

Совокупность в объеме 1 мм*3 - независимая локальная сеть

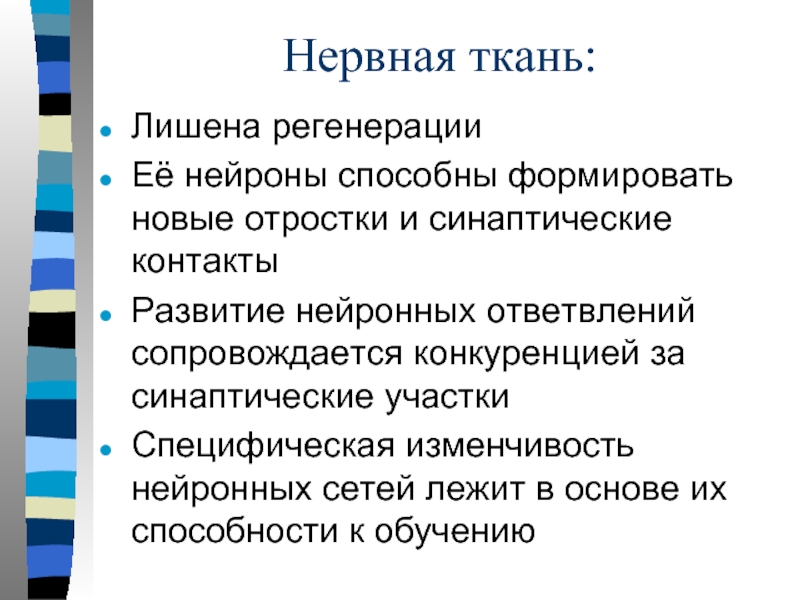

Слайд 10Нервная ткань:

Лишена регенерации

Её нейроны способны формировать новые отростки и синаптические контакты

Развитие

Специфическая изменчивость нейронных сетей лежит в основе их способности к обучению

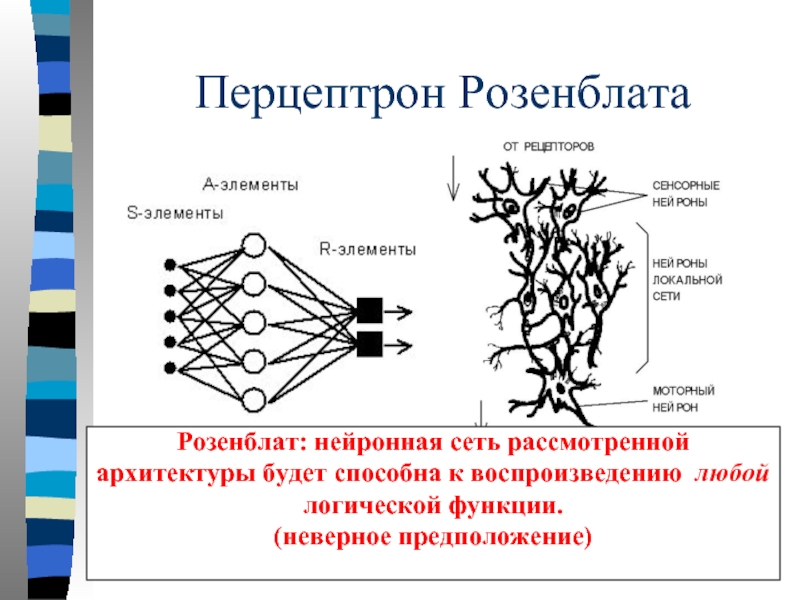

Слайд 13Перцептрон Розенблата

S- сенсорные, А - ассоциативные, R - рефлекторные

Розенблат: нейронная

архитектуры будет способна к воспроизведению любой

логической функции.

(неверное предположение)

Слайд 14Обучение сети

Обучить нейронную сеть это значит, сообщить ей, чего от нее

Показав ребенку изображение буквы и получив неверный ответ, ему сообщается тот, который хотят получить.

Ребенок запоминает этот пример с верным ответом и в его памяти происходят изменения в нужном направлении.

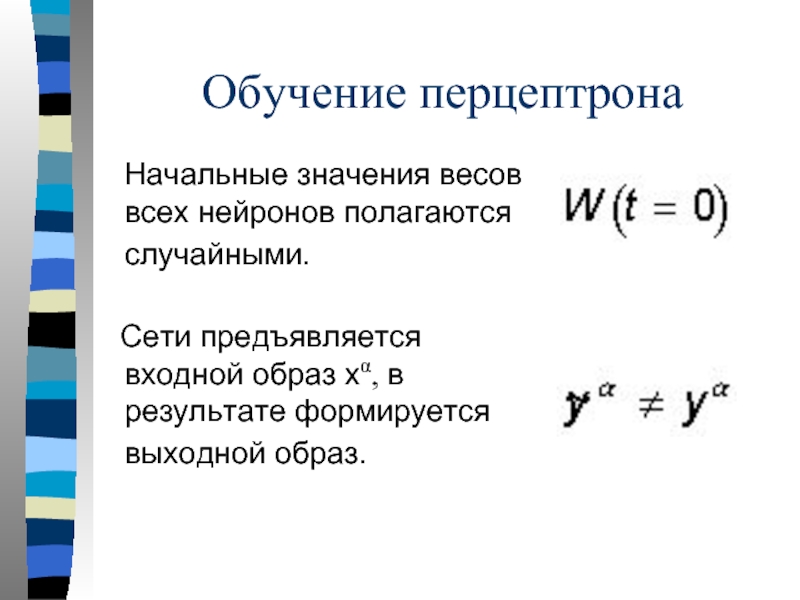

Слайд 15Обучение перцептрона

Начальные значения весов всех нейронов полагаются случайными.

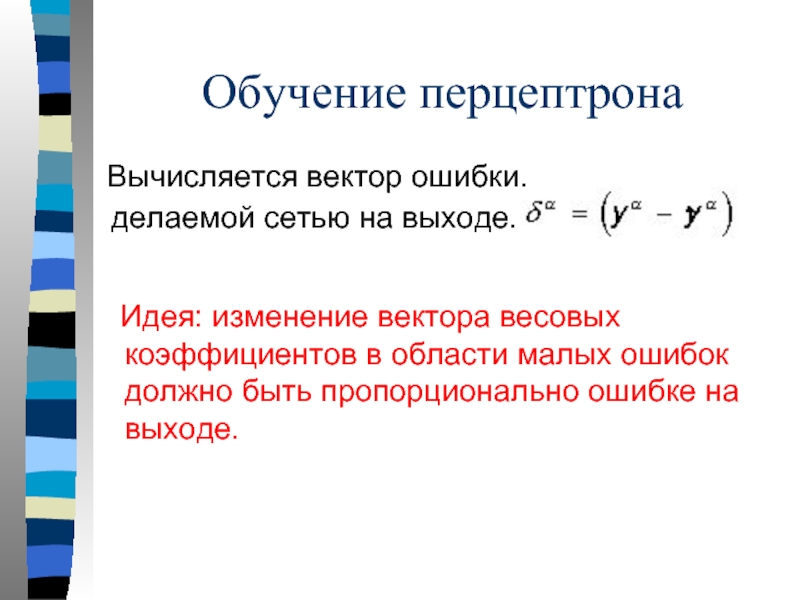

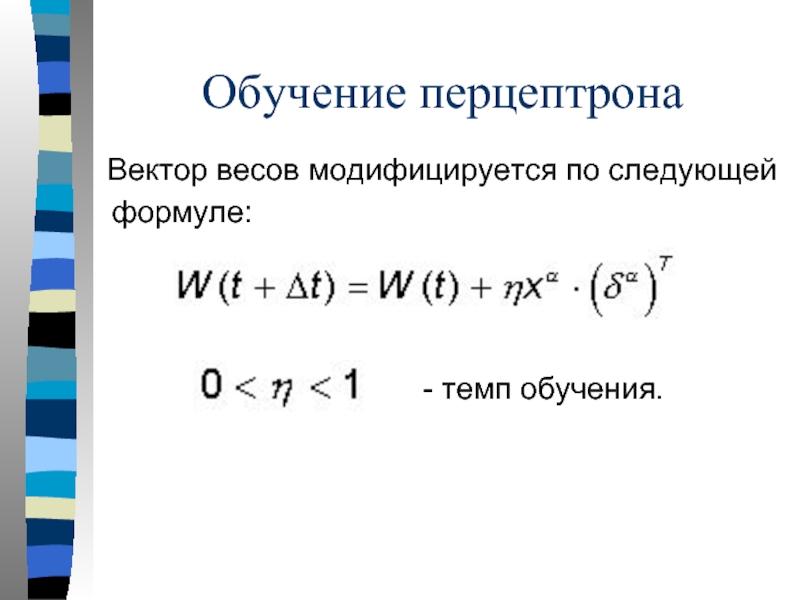

Слайд 16Обучение перцептрона

Вычисляется вектор ошибки, делаемой сетью на выходе.

Слайд 18Параметры

Обучение проводится для всех обучающих векторов.

Один цикл предъявления всей выборки называется

Обучение завершается по истечении нескольких эпох, когда вектор весов перестанет значимо меняться.

Слайд 19Возможности применения

Теорема о полноте:

Любая непрерывная функция может быть приближена

Нейронные сети являются универсальными структурами, позволяющими реализовать любой алгоритм!

Слайд 20Этапы построения сети

Выбор архитектуры сети

Число входов

Функции активации

Как соединить нейроны

Что взять за

Подбор весов (обучение сети)

Построить вручную

Воспользоваться пакетом нейросетевого моделирования

Слайд 21STATISTICA

Neural Networks

Программный пакет для создания и обучения нейронных сетей и

работы с

StatSoft® Russia

Слайд 22Исключительная простота в работе

Советник по конструированию сети

Мастер решения задач

Богатые

STATISTICA Neural Networks

Слайд 23STATISTICA Neural Networks:

работа с данными

Структура таблиц исходных данных:

числовые и номинальные переменные;

входные

подмножества наблюдений.

Импорт файлов различных форматов, использование буфера обмена.

Подготовка данных: встроенные алгоритмы пре- и пост-процессирования.

Слайд 24STATISTICA Neural Networks:

построение сетей

Создание и сохранение наборов сетей.

Выбор типа сети:

многослойные персептроны

радиальные базисные функции (RBF);

вероятностные и обобщенно-регрессионные сети (PNN и GRNN);

сети Кохонена.

Задание функции ошибок, функций активации и PSP-функций различных слоев.

Доступ к весам всех нейронов сети.

Слайд 25STATISTICA Neural Networks:

обучение сетей

Большой выбор алгоритмов обучения:

обратное распространение ошибки;

спуск по сопряженным

квази-ньютоновский и Левенберга-Маркара;

метод псевдообратных матриц.

Использование кросс-проверки.

Задание условий остановки.

Контроль за процессом обучения с помощью графика среднеквадратичной ошибки и гистограммы ошибок наблюдений.

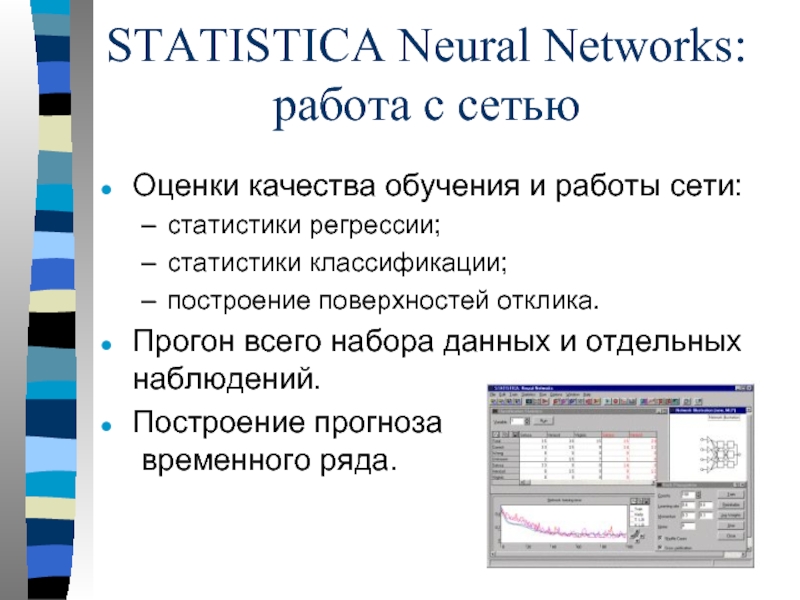

Слайд 26STATISTICA Neural Networks:

работа с сетью

Оценки качества обучения и работы сети:

статистики регрессии;

статистики

построение поверхностей отклика.

Прогон всего набора данных и отдельных наблюдений.

Построение прогноза временного ряда.

Слайд 27STATISTICA Neural Network:

дополнительные функции

Генетический алгоритм отбора

входных данных

Нелинейное понижение размерности

Регуляризация весов по

Анализ чувствительности

Введение матрицы потерь

Операционные характеристики

Слайд 28STATISTICA Neural Networks:

создание приложений

Взаимодействие с системой STATISTICA: передача данных и графиков.

Встроенный

Новая функция - генератор программного кода на языке Си.

Слайд 30Условия моделирования

Предвыборные компании кандидатов отработаны добросовестно

Все участники сделали все возможное

Выбор практически

Прогноз составлялся в 1992 году по данным выборов начиная с 1864

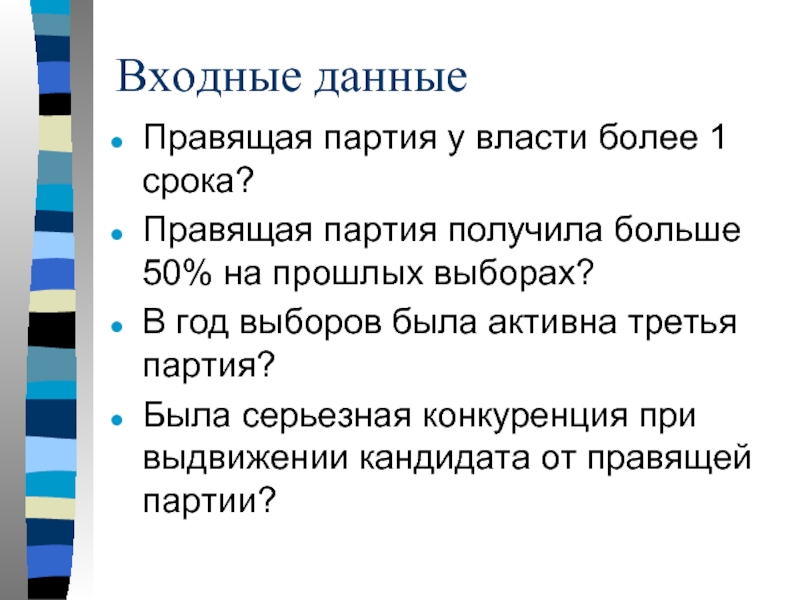

Слайд 31Входные данные

Правящая партия у власти более 1 срока?

Правящая партия получила больше

В год выборов была активна третья партия?

Была серьезная конкуренция при выдвижении кандидата от правящей партии?

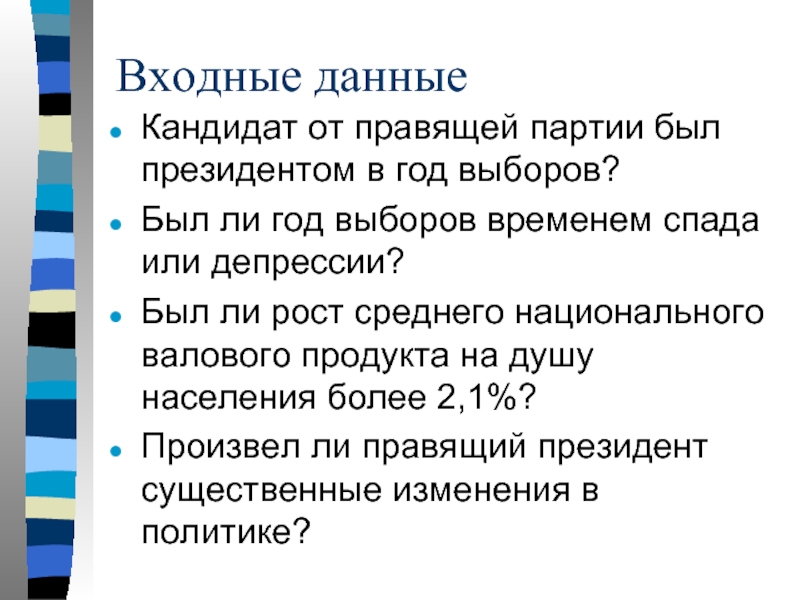

Слайд 32Входные данные

Кандидат от правящей партии был президентом в год выборов?

Был ли

Был ли рост среднего национального валового продукта на душу населения более 2,1%?

Произвел ли правящий президент существенные изменения в политике?

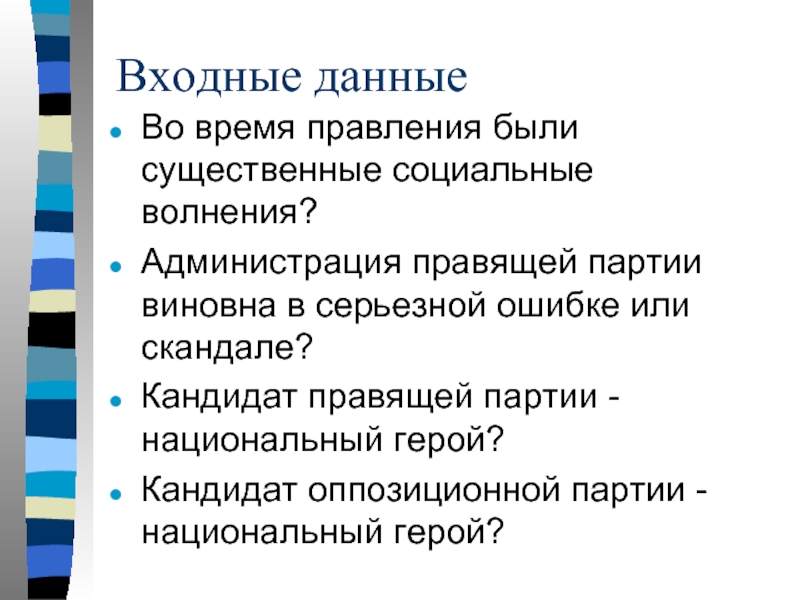

Слайд 33Входные данные

Во время правления были существенные социальные волнения?

Администрация правящей партии виновна

Кандидат правящей партии - национальный герой?

Кандидат оппозиционной партии - национальный герой?

Слайд 39Анализ чувствительности

Нажатие этой кнопки

автоматически исключает

незначимые переменные

из анализа

Слайд 41Представлены факторы

Затраты на материалы

Объем зарплаты

Производительность труда

Курс доллара США

Слайд 44Анализ чувствительности

Объем зарплаты и

производительность

труда сильно влияют

на прибыль предприятия

Слайд 58Качество прогноза

Для повышения качества прогноза рекомендуется добавить к исходной переменной ряд,

Точность прогноза

увеличилась на порядок!

Слайд 59Модель распределенной нейронной памяти

Каждый нейрон может находиться в двух

S1 = +1 - возбужденное

S2 = - 1 - покой

Нейроны связаны между собой синаптическими связями, которые бывают возбуждающие и тормозящие.

Слайд 60Модель распределенной нейронной памяти

Тормозящий

S1 = +1

S2 = - 1

Возбуждающий

S1 = +1

S2

Связь можно описывать коэффециентом:

Слайд 61- потенциальная энергия связи

Любая система предоставленная самой себе

стремится к

энергии.

Слайд 62Модель Хопфилда коэффициентов

межнейронных связей, когда в сети запомнено

p образов.

Образ

Каждому образу соответствует

локальный энергетический минимум!

Слайд 64Модель Хакена

Образы описываются параметрами порядка: d1 и d2

Переменные, описывающие степень насыщения

Слайд 65Уравнения насыщения

При некотором соотношении между константами

А, B, g имеет место осцилляция

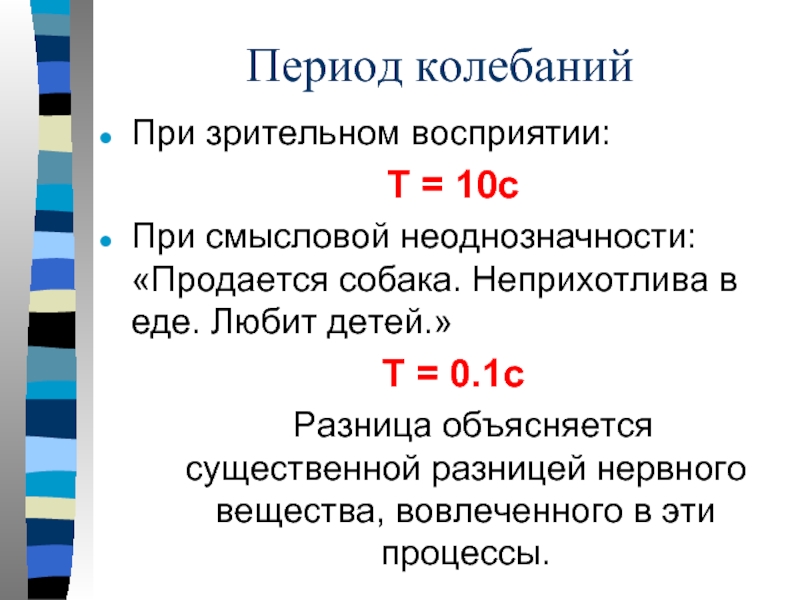

Слайд 66Период колебаний

При зрительном восприятии:

T = 10c

При смысловой неоднозначности: «Продается собака.

T = 0.1c

Разница объясняется существенной разницей нервного вещества, вовлеченного в эти процессы.

Слайд 67Мы обсудили

Проблему неоднозначности в искусстве

Биологические нейронные сети

Математические модели нейронных сетей

Возможности пакета

Задачу: прогноз результатов выборов президента США

Слайд 68Мы обсудили

Задачу: выявление показателей, влияющих на валовую прибыль предприятия (регрессионная модель)

Задачу:

Способ оценки периода колебаний зрительных образов в сознании