- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Разработка параллельных приложений для многоядерных систем презентация

Содержание

- 1. Разработка параллельных приложений для многоядерных систем

- 2. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Используемые

- 3. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Intel

- 4. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО OpenMP

- 5. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Преимущества

- 6. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Принцип

- 7. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Состав

- 8. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Использование

- 9. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Способы

- 10. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Расписание

- 11. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Задача

- 12. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Реализация

- 13. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Организация

- 14. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Intel

- 15. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Возможности

- 16. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Пример

- 17. НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО Ссылки

Слайд 1Разработка параллельных приложений для многоядерных систем

С.В. Ковальчук

НИИ Наукоемких компьютерных технологий, СПбГУ

Слайд 2НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Используемые средства

Intel C++ Compiler

Оптимизирующий компилятор

OpenMP, Intel

Средства распараллеливания для систем с общей памятью

Слайд 3НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Intel C++ Compiler

Архитектуры процессоров

IA-32, x86-64 (Intel

Операционные системы

Microsoft Windows, Linux, Mac OS

Основные возможности

Высокоуровневая оптимизация

Межпроцедурная оптимизация

Автоматическое распараллеливание кода:

Векторизация

Разделение циклов по нескольким нитям

Профилирующая оптимизация

Интеграция с VisualStudio

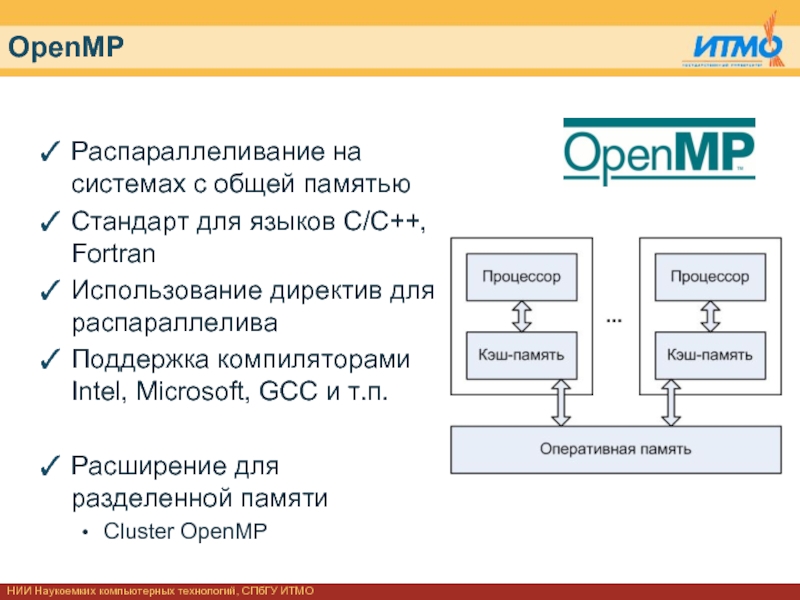

Слайд 4НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

OpenMP

Распараллеливание на системах с общей памятью

Стандарт

Использование директив для распараллелива

Поддержка компиляторами Intel, Microsoft, GCC и т.п.

Расширение для разделенной памяти

Cluster OpenMP

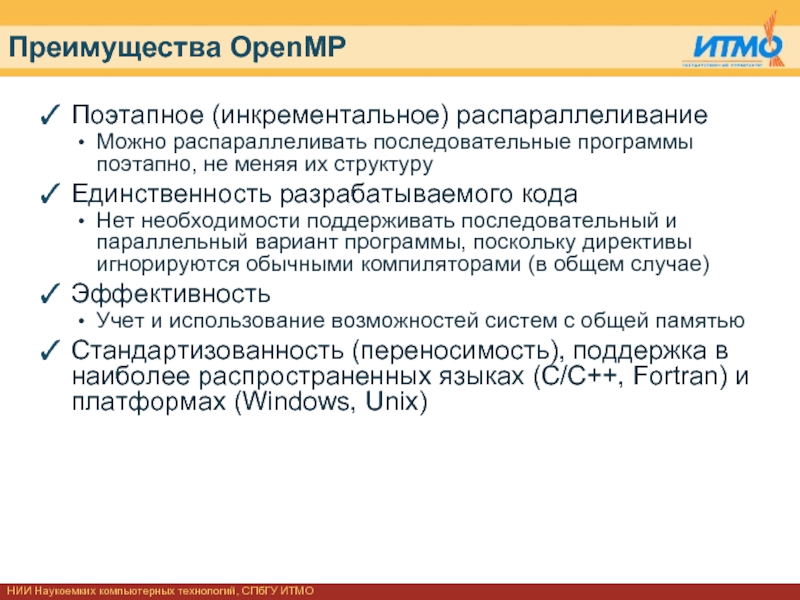

Слайд 5НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Преимущества OpenMP

Поэтапное (инкрементальное) распараллеливание

Можно распараллеливать последовательные

Единственность разрабатываемого кода

Нет необходимости поддерживать последовательный и параллельный вариант программы, поскольку директивы игнорируются обычными компиляторами (в общем случае)

Эффективность

Учет и использование возможностей систем с общей памятью

Стандартизованность (переносимость), поддержка в наиболее распространенных языках (C/C++, Fortran) и платформах (Windows, Unix)

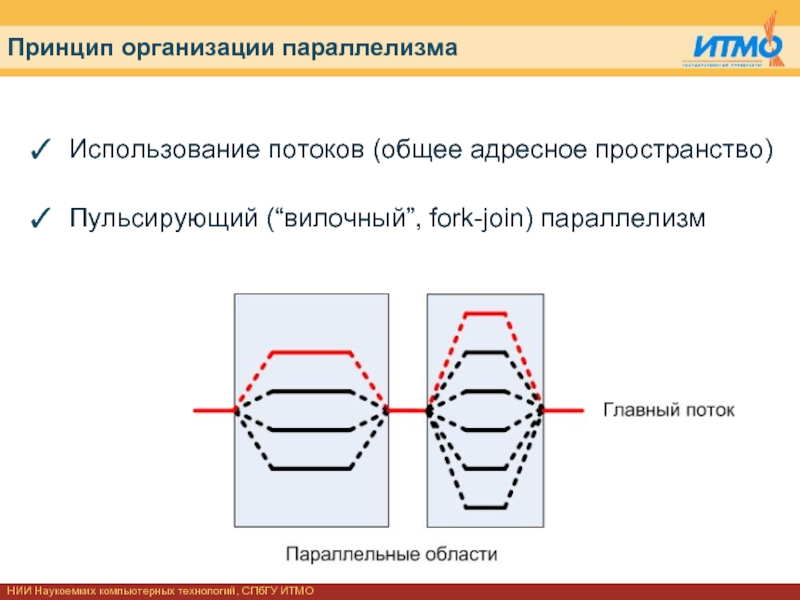

Слайд 6НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Принцип организации параллелизма

Использование потоков (общее адресное

Пульсирующий (“вилочный”, fork-join) параллелизм

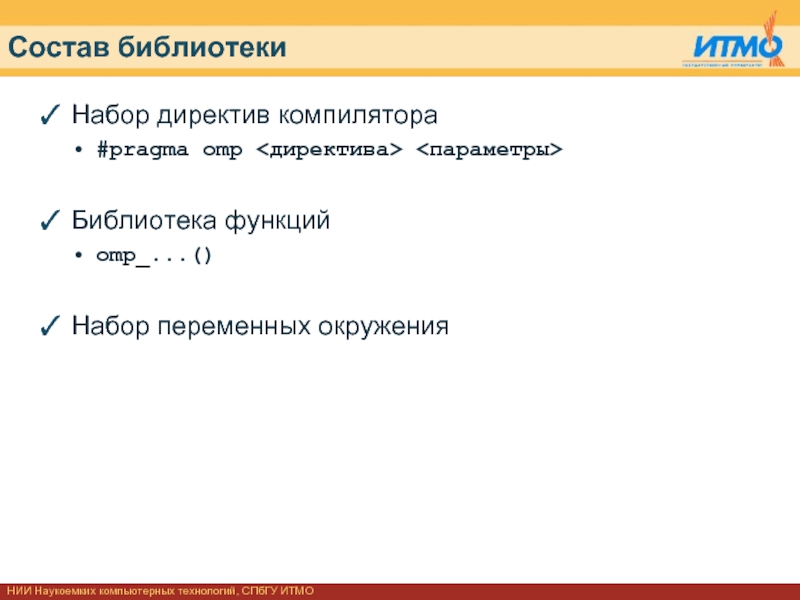

Слайд 7НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Состав библиотеки

Набор директив компилятора

#pragma omp

Библиотека функций

omp_...()

Набор переменных окружения

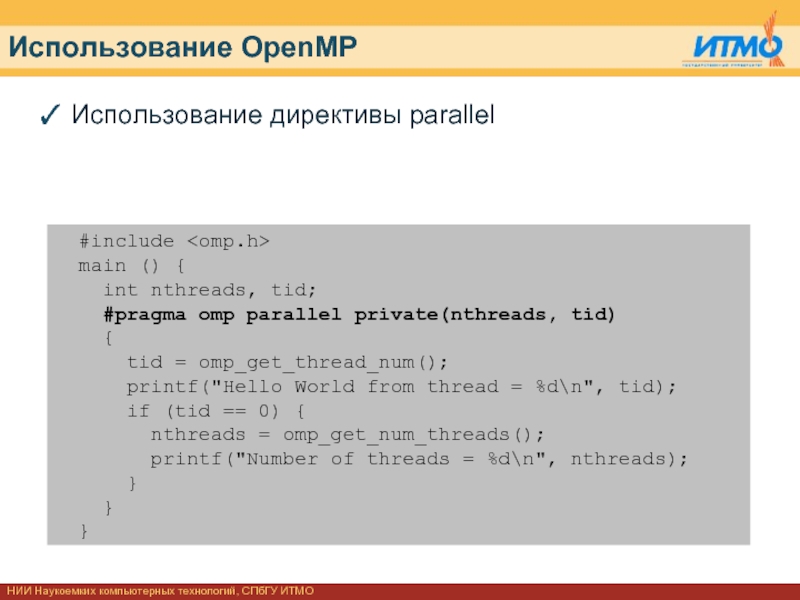

Слайд 8НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Использование OpenMP

Использование директивы parallel

#include

main () {

int nthreads, tid;

#pragma omp parallel private(nthreads, tid)

{

tid = omp_get_thread_num();

printf("Hello World from thread = %d\n", tid);

if (tid == 0) {

nthreads = omp_get_num_threads();

printf("Number of threads = %d\n", nthreads);

}

}

}

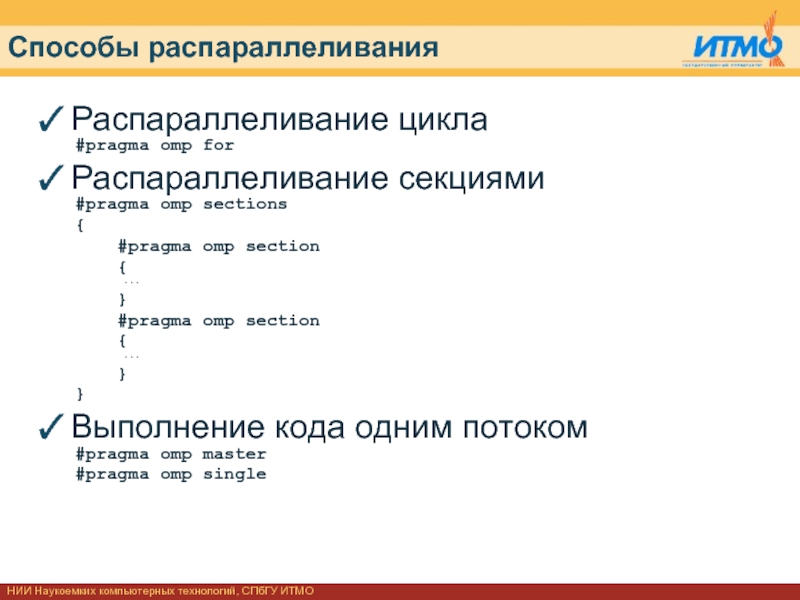

Слайд 9НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Способы распараллеливания

Распараллеливание цикла

#pragma omp for

Распараллеливание секциями

#pragma

{

#pragma omp section

{

...

}

#pragma omp section

{

...

}

}

Выполнение кода одним потоком

#pragma omp master

#pragma omp single

Слайд 10НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

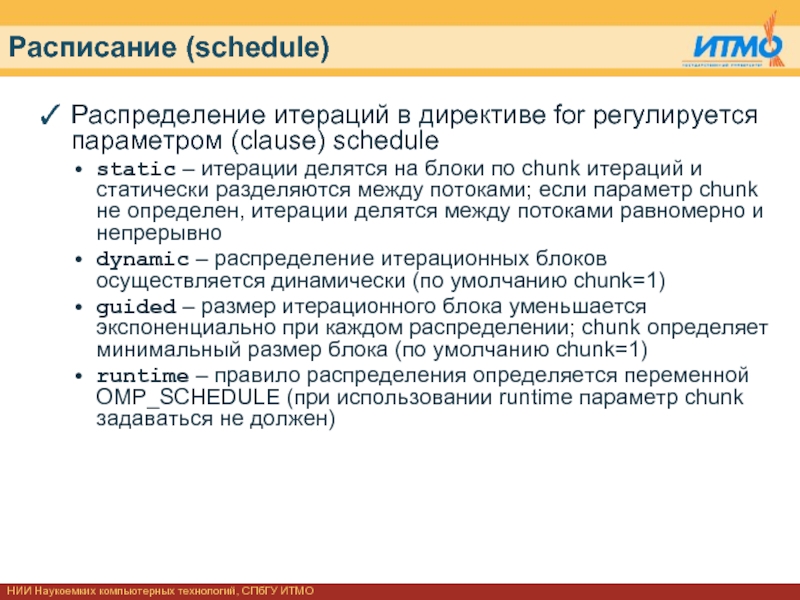

Расписание (schedule)

Распределение итераций в директиве for

static – итерации делятся на блоки по chunk итераций и статически разделяются между потоками; если параметр chunk не определен, итерации делятся между потоками равномерно и непрерывно

dynamic – распределение итерационных блоков осуществляется динамически (по умолчанию chunk=1)

guided – размер итерационного блока уменьшается экспоненциально при каждом распределении; chunk определяет минимальный размер блока (по умолчанию chunk=1)

runtime – правило распределения определяется переменной OMP_SCHEDULE (при использовании runtime параметр chunk задаваться не должен)

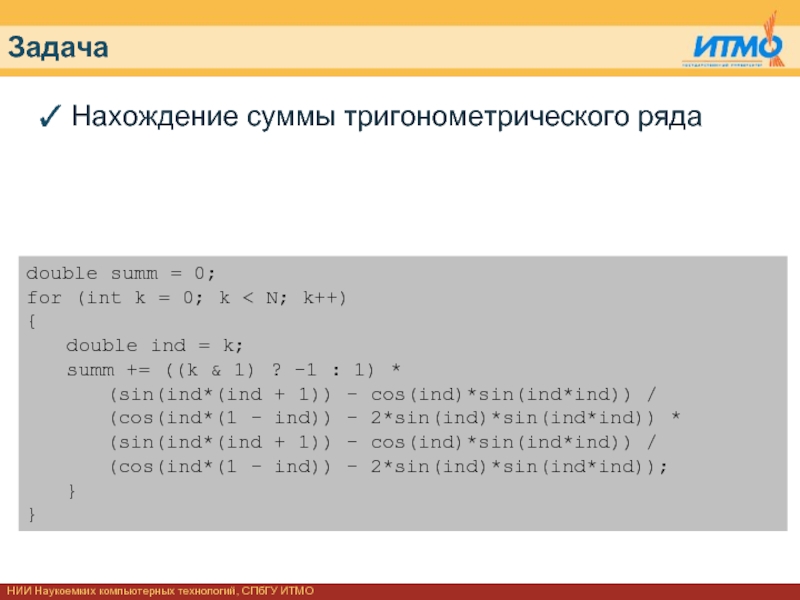

Слайд 11НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Задача

Нахождение суммы тригонометрического ряда

double summ =

for (int k = 0; k < N; k++)

{

double ind = k;

summ += ((k & 1) ? -1 : 1) *

(sin(ind*(ind + 1)) - cos(ind)*sin(ind*ind)) /

(cos(ind*(1 - ind)) - 2*sin(ind)*sin(ind*ind)) *

(sin(ind*(ind + 1)) - cos(ind)*sin(ind*ind)) /

(cos(ind*(1 - ind)) - 2*sin(ind)*sin(ind*ind));

}

}

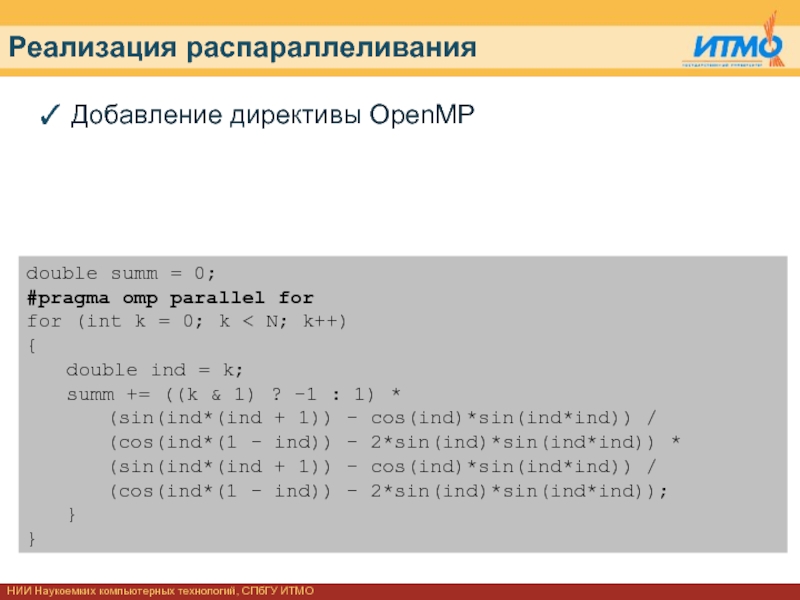

Слайд 12НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Реализация распараллеливания

Добавление директивы OpenMP

double summ =

#pragma omp parallel for

for (int k = 0; k < N; k++)

{

double ind = k;

summ += ((k & 1) ? -1 : 1) *

(sin(ind*(ind + 1)) - cos(ind)*sin(ind*ind)) /

(cos(ind*(1 - ind)) - 2*sin(ind)*sin(ind*ind)) *

(sin(ind*(ind + 1)) - cos(ind)*sin(ind*ind)) /

(cos(ind*(1 - ind)) - 2*sin(ind)*sin(ind*ind));

}

}

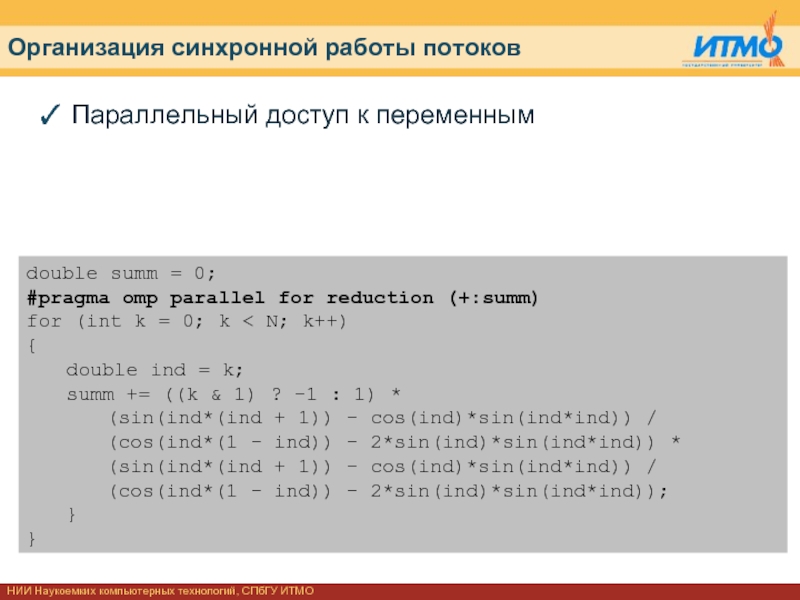

Слайд 13НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Организация синхронной работы потоков

Параллельный доступ к

double summ = 0;

#pragma omp parallel for reduction (+:summ)

for (int k = 0; k < N; k++)

{

double ind = k;

summ += ((k & 1) ? -1 : 1) *

(sin(ind*(ind + 1)) - cos(ind)*sin(ind*ind)) /

(cos(ind*(1 - ind)) - 2*sin(ind)*sin(ind*ind)) *

(sin(ind*(ind + 1)) - cos(ind)*sin(ind*ind)) /

(cos(ind*(1 - ind)) - 2*sin(ind)*sin(ind*ind));

}

}

Слайд 14НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Intel Threading Building Blocks

Высокоуровневая библиотека для

Реализована на языке C++ в форме классов и шаблонов

Поддерживаемые ОС: Microsoft Windows, Linux, Mac OS

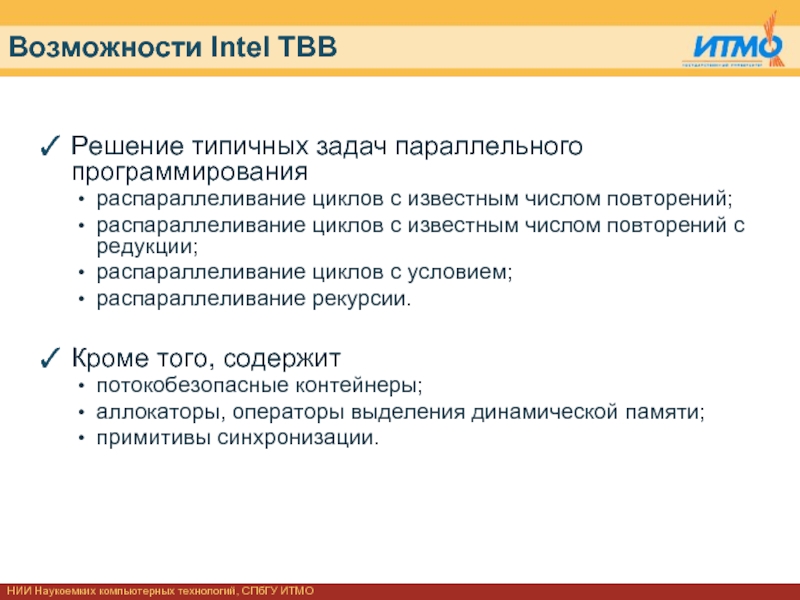

Слайд 15НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Возможности Intel TBB

Решение типичных задач параллельного

распараллеливание циклов с известным числом повторений;

распараллеливание циклов с известным числом повторений с редукции;

распараллеливание циклов с условием;

распараллеливание рекурсии.

Кроме того, содержит

потокобезопасные контейнеры;

аллокаторы, операторы выделения динамической памяти;

примитивы синхронизации.

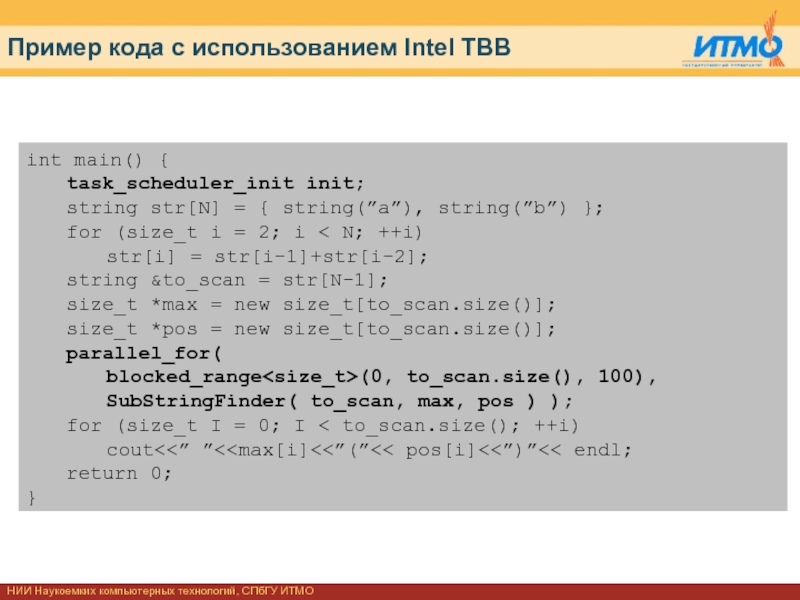

Слайд 16НИИ Наукоемких компьютерных технологий, СПбГУ ИТМО

Пример кода с использованием Intel TBB

int

task_scheduler_init init;

string str[N] = { string(”a”), string(”b”) };

for (size_t i = 2; i < N; ++i)

str[i] = str[i-1]+str[i-2];

string &to_scan = str[N-1];

size_t *max = new size_t[to_scan.size()];

size_t *pos = new size_t[to_scan.size()];

parallel_for(

blocked_range

SubStringFinder( to_scan, max, pos ) );

for (size_t I = 0; I < to_scan.size(); ++i)

cout<<” ”<

}