- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Машинное обучение в электронной коммерции – практика использования и подводные камни презентация

Содержание

- 1. Машинное обучение в электронной коммерции – практика использования и подводные камни

- 2. Карл… Карл, я открыл страшную тайну нейронных сетей Это очень интересно, пап!

- 3. Карл… Карл, я специалист по BigData…. Это

- 4. О чем хочется поговорить Ввести в исторический

- 5. О ЧЕМ ПОГОВОРИМ Для менеджеров, без математики!

- 6. «Золотая» лихорадка Была бигдата Теперь нейронки Завтра

- 7. Только правда, только хардкор Клянусь говорить только правду Верьте! Проверить оооочень трудно…

- 8. Что такое бигдата на самом деле? Данные

- 9. Бигдата и веб-студия Чем занимаются в веб-студии.

- 10. Наука и (веб) разработка Программирование и теория,

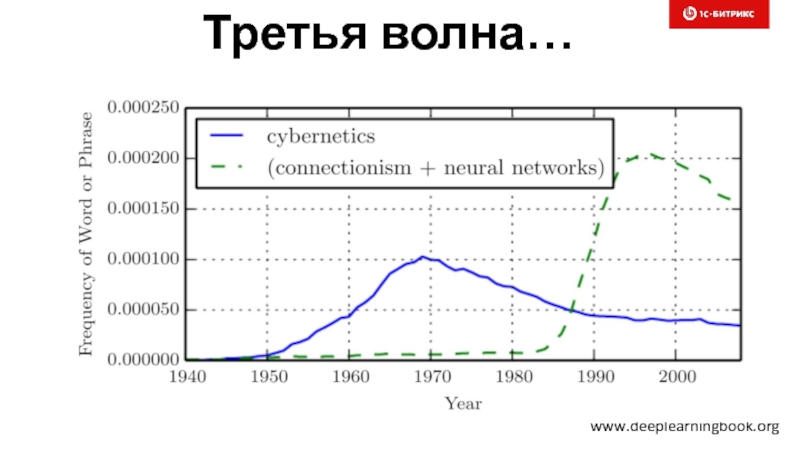

- 11. Третья волна… www.deeplearningbook.org

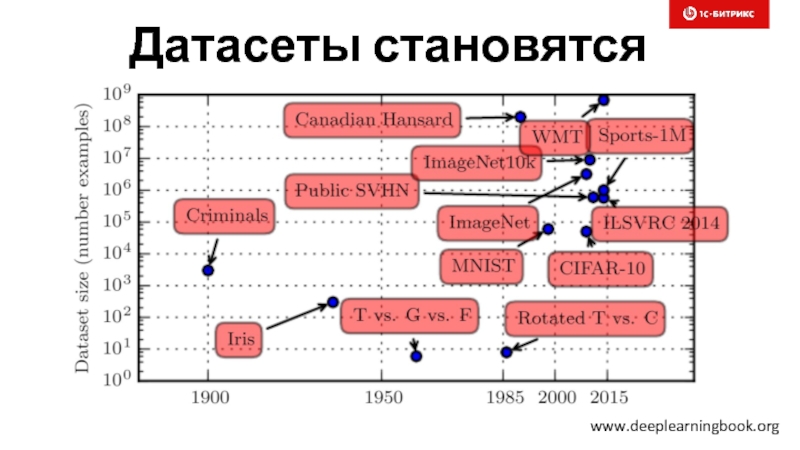

- 12. Датасеты становятся больше… www.deeplearningbook.org

- 13. Нейронки гораздо точнее… www.deeplearningbook.org

- 14. Нейронки становятся больше… www.deeplearningbook.org

- 15. Бигдата и нейронки – созданы друг для друга Машины опорных векторов Факторизация слоев Нелинейность

- 16. А если данных все таки собрано мало?

- 17. В чем же принципиальная разница нейронок и

- 18. Подтянулись GPU и железо Универсальные GPU CUDA

- 19. Парад бесплатных фреймворков TensorFlow (Google) Torch Theano Keras Deeplearning4j CNTK (Microsoft) DSSTNE (Amazon) Caffe

- 20. Вендоры скупают ученых Facebook (Yann LeCun) Baidu

- 21. Как работает нейронка? Все просто – почти

- 22. Потрясающие возможности нейросетей

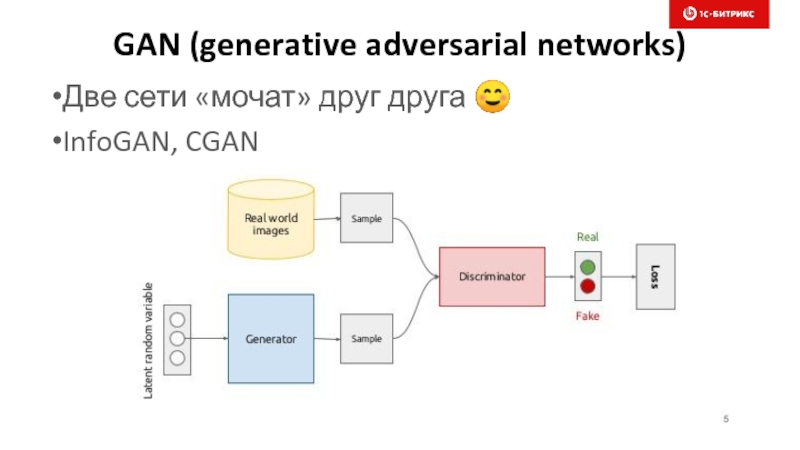

- 23. GAN (generative adversarial networks) Две сети «мочат»

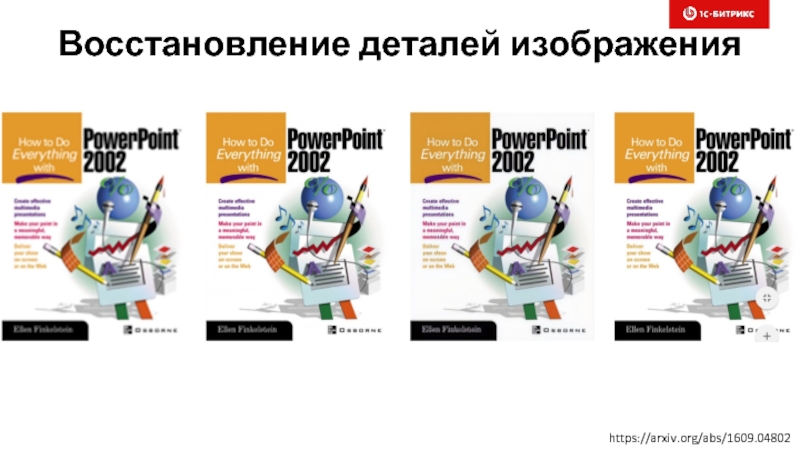

- 24. Восстановление деталей изображения https://arxiv.org/abs/1609.04802

- 25. Восстановление деталей изображения https://arxiv.org/abs/1609.04802

- 26. Восстановление деталей изображения https://arxiv.org/abs/1609.04802

- 27. Фантастические интерьеры https://habrahabr.ru/company/mailru/blog/338248/

- 28. Изменение возраста https://habrahabr.ru/company/mailru/blog/338248/

- 29. Картинка по эскизу Слайд https://habrahabr.ru/company/mailru/blog/338248/

- 30. Восстановление частей изображения Слайд

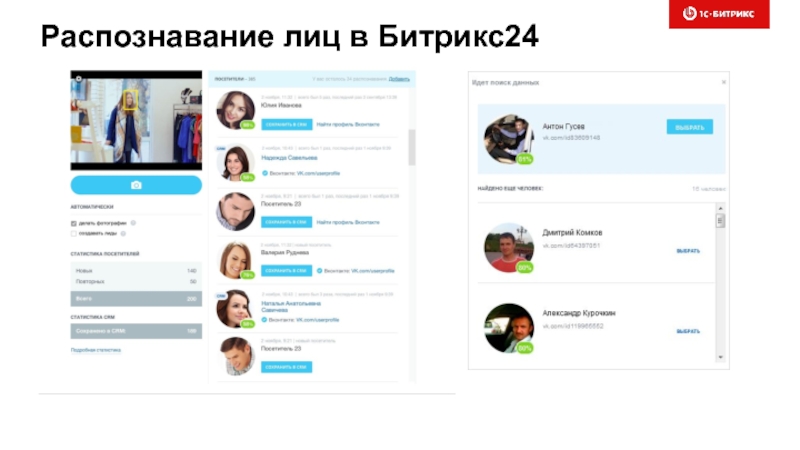

- 31. Распознавание лиц в Битрикс24

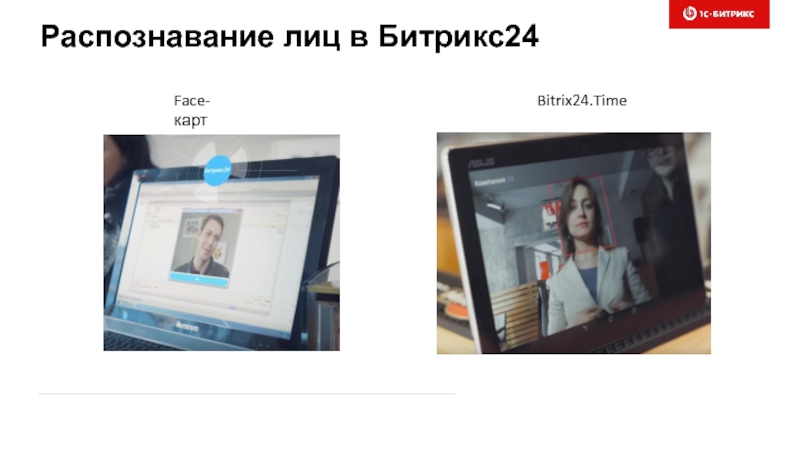

- 32. Распознавание лиц в Битрикс24 Face-карт Bitrix24.Time

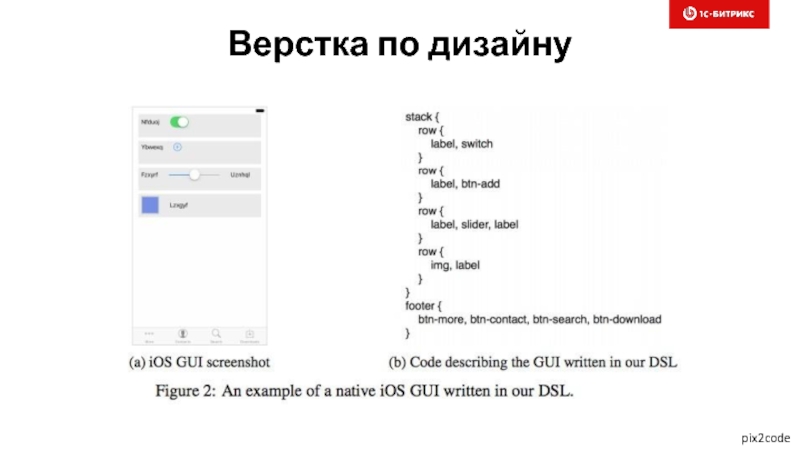

- 33. Верстка по дизайну pix2code

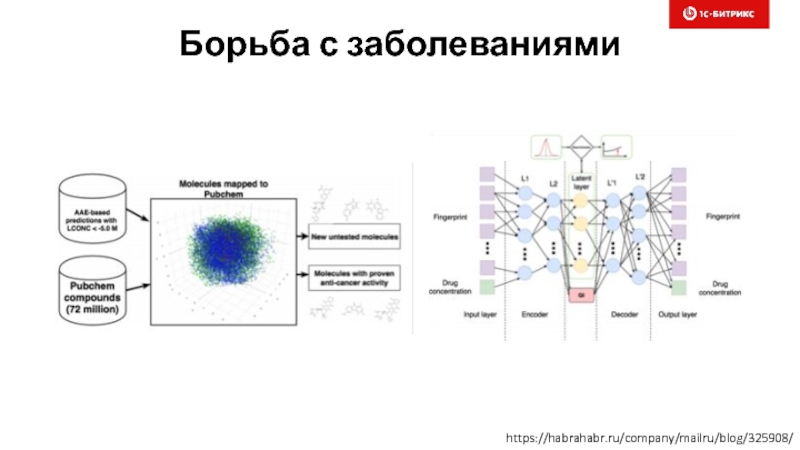

- 34. Борьба с заболеваниями https://habrahabr.ru/company/mailru/blog/325908/

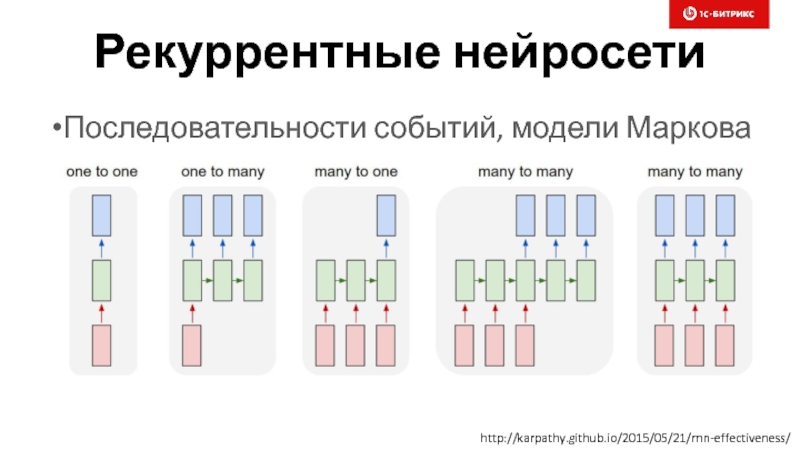

- 35. Рекуррентные нейросети Последовательности событий, модели Маркова http://karpathy.github.io/2015/05/21/rnn-effectiveness/

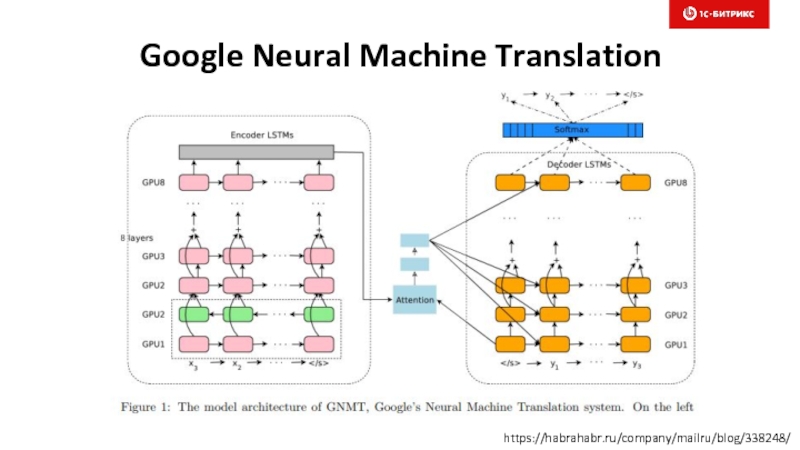

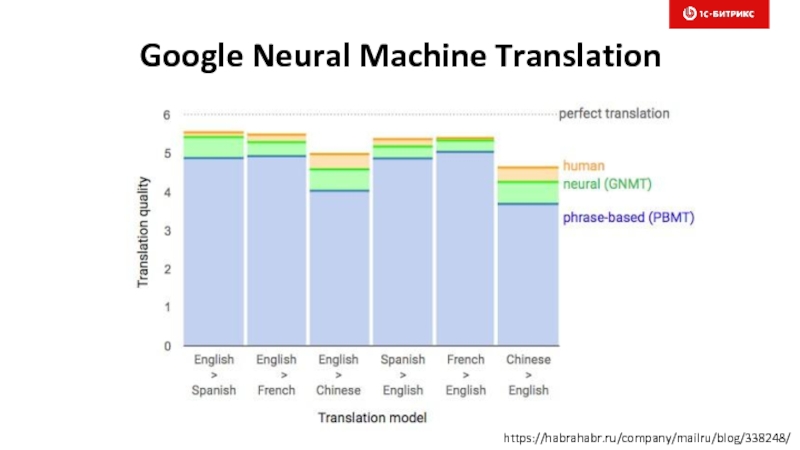

- 36. Google Neural Machine Translation https://habrahabr.ru/company/mailru/blog/338248/

- 37. Google Neural Machine Translation https://habrahabr.ru/company/mailru/blog/338248/

- 38. Чтение по губам Сеть без звука читает

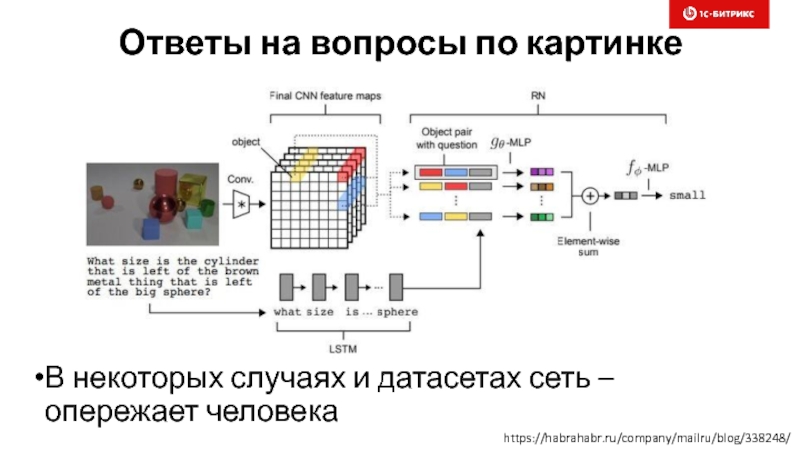

- 39. Ответы на вопросы по картинке В некоторых

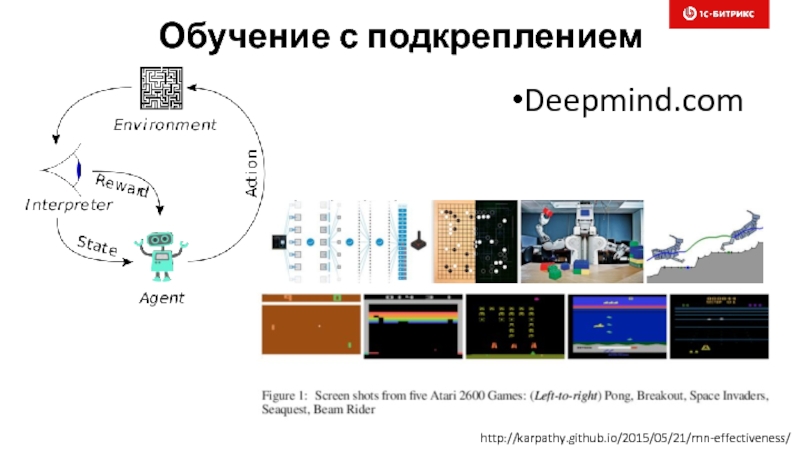

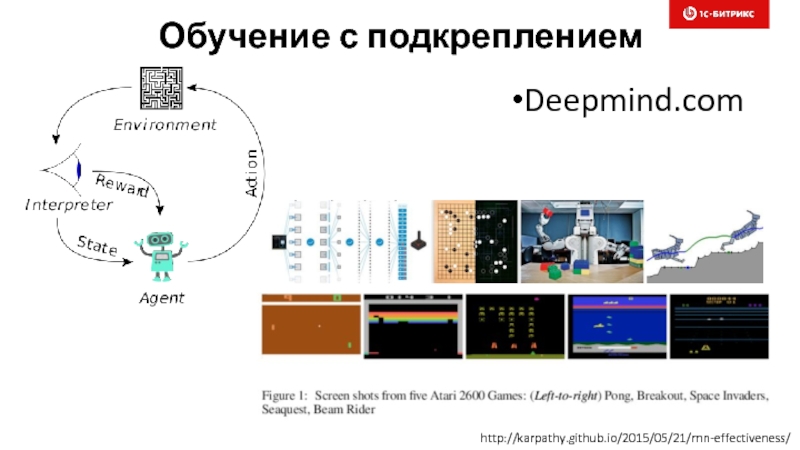

- 40. Обучение с подкреплением Deepmind.com http://karpathy.github.io/2015/05/21/rnn-effectiveness/

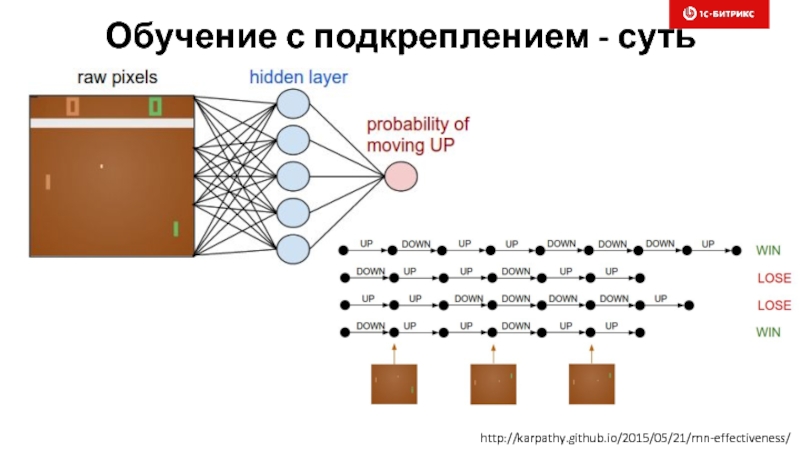

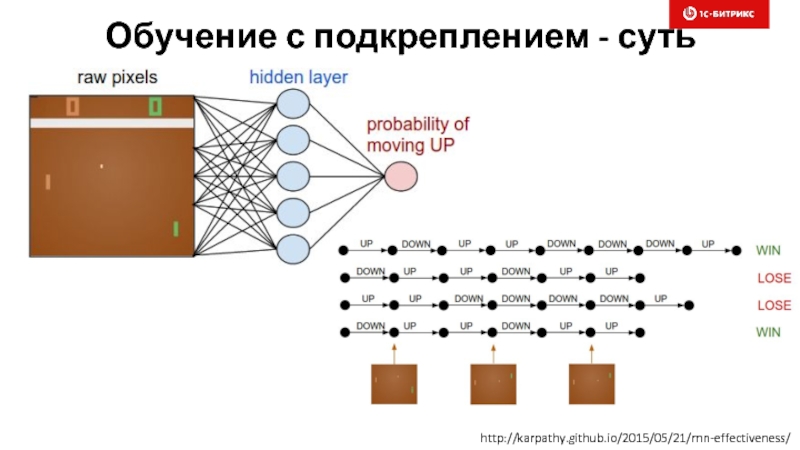

- 41. Обучение с подкреплением - суть http://karpathy.github.io/2015/05/21/rnn-effectiveness/

- 42. Другие кейсы применения нейронок Предсказание следующего действия

- 43. Где же подвох? ☺

- 44. А они то есть!!! И не один. ☺

- 45. Подвох 1 Нужна бигдата Только конкретная, ваша, а не общедоступная Сможете собрать/купить?

- 46. Трус не играет в хоккей

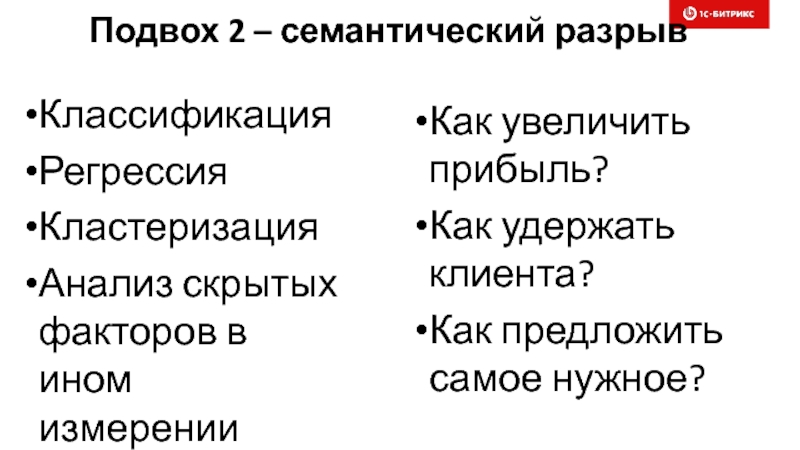

- 47. Подвох 2 – семантический разрыв Классификация Регрессия

- 48. Машина Тьюринга и … GTA Нужно создавать новые абстракции, нужны «нейронные» программисты, менеджеры и прОдукты

- 49. Подвох 3 – всем тут все понятно? ☺

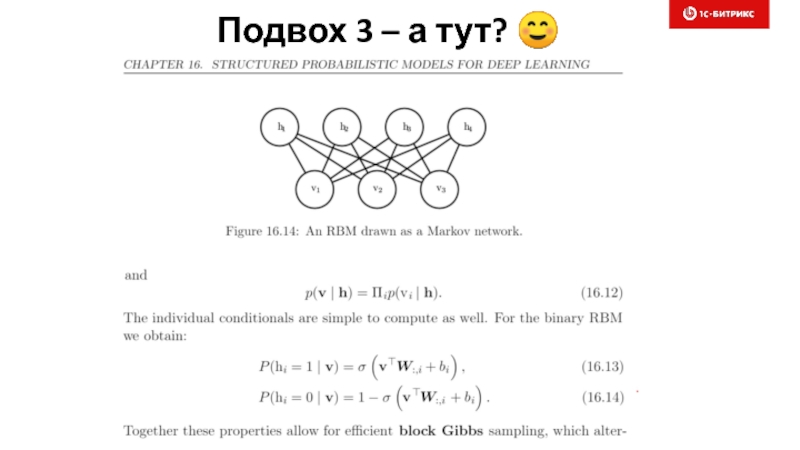

- 50. Подвох 3 – а тут? ☺

- 51. Подвох 3 – нужно долго учиться Хорошая

- 52. Подвох 4 – никаких гарантий В интернете

- 53. Подвох 5: полная цепочка - сложна Сбор

- 54. Делаем глубокий вдох…. и улыбаемся!

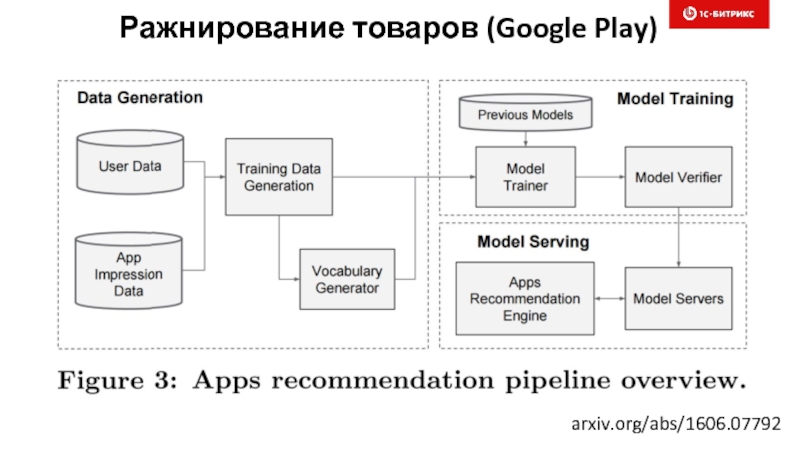

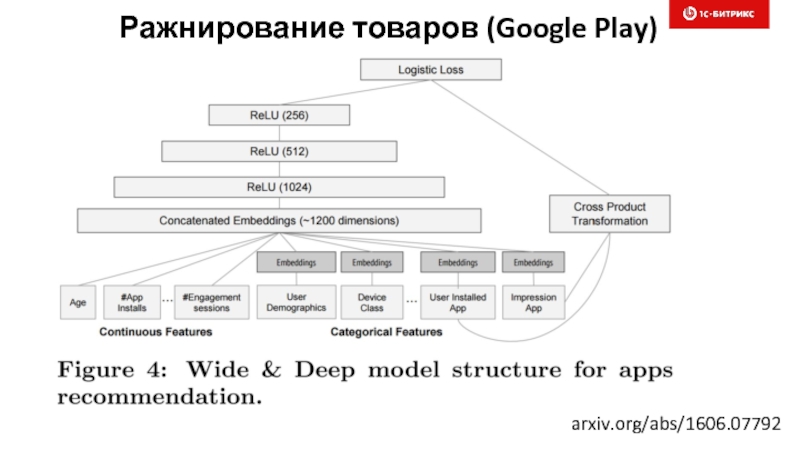

- 55. Ражнирование товаров (Google Play) arxiv.org/abs/1606.07792

- 56. arxiv.org/abs/1606.07792 Ражнирование товаров (Google Play)

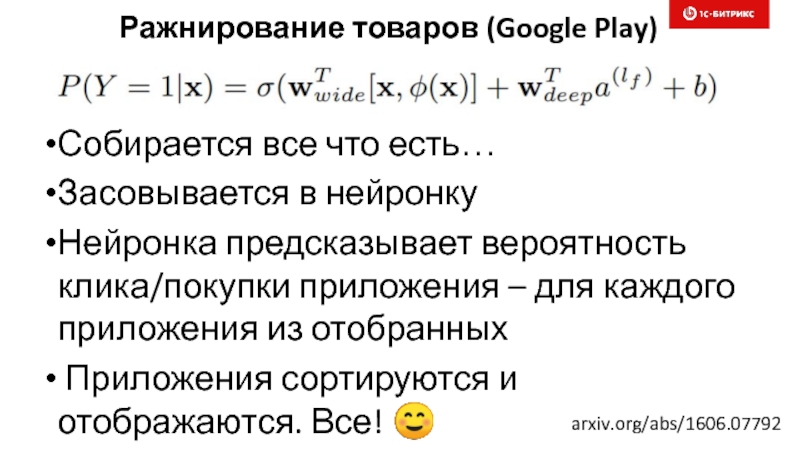

- 57. arxiv.org/abs/1606.07792 Собирается все что есть… Засовывается в

- 58. Где брать людей в команду? Бигдата: хорошие

- 59. Ну что, нырнем поглубже? Может заболеть голова ☺

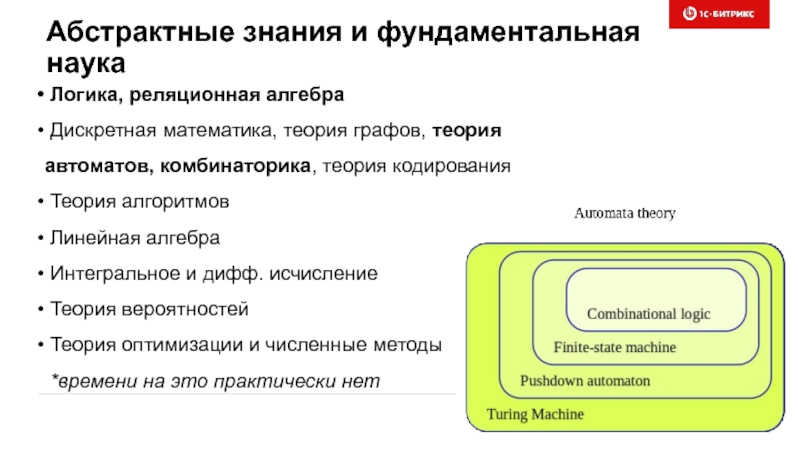

- 60. Абстрактные знания и фундаментальная наука

- 61. Восьмая проблема Гильберта и другие штучки

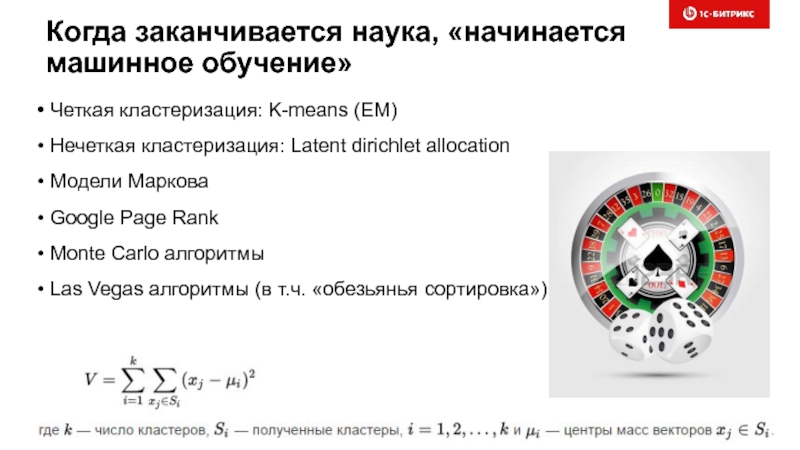

- 62. Когда заканчивается наука, «начинается машинное обучение»

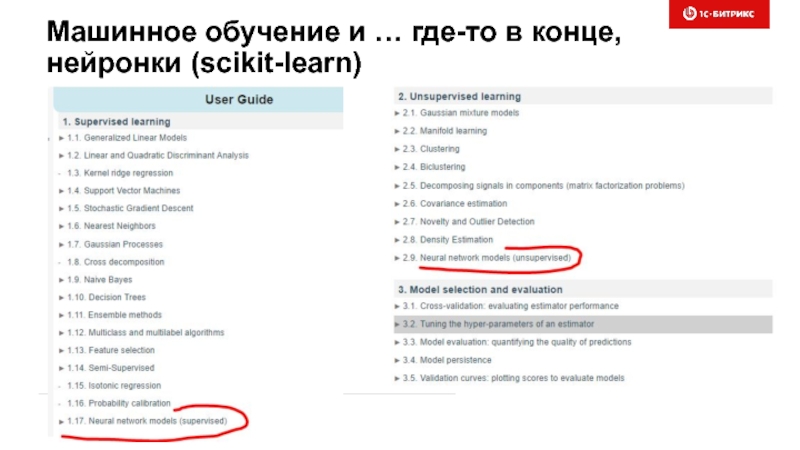

- 63. Машинное обучение и … где-то в конце, нейронки (scikit-learn)

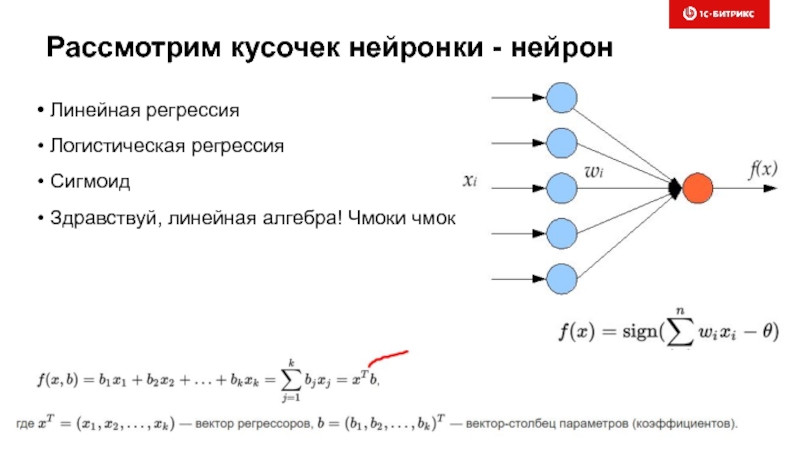

- 64. Рассмотрим кусочек нейронки - нейрон

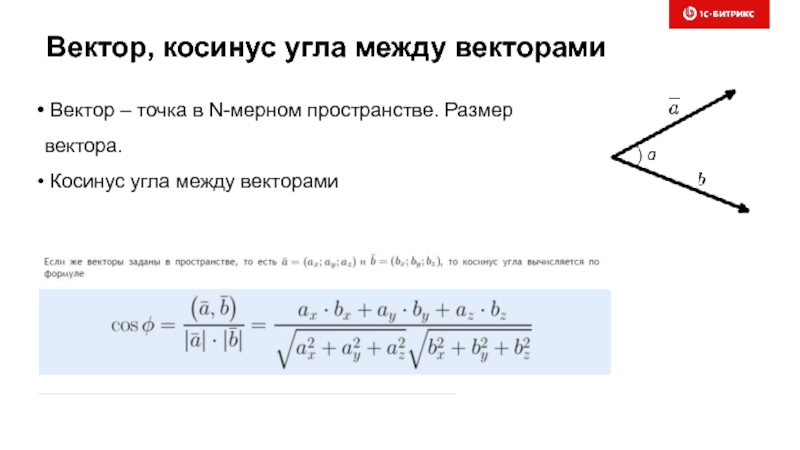

- 65. Вектор, косинус угла между векторами

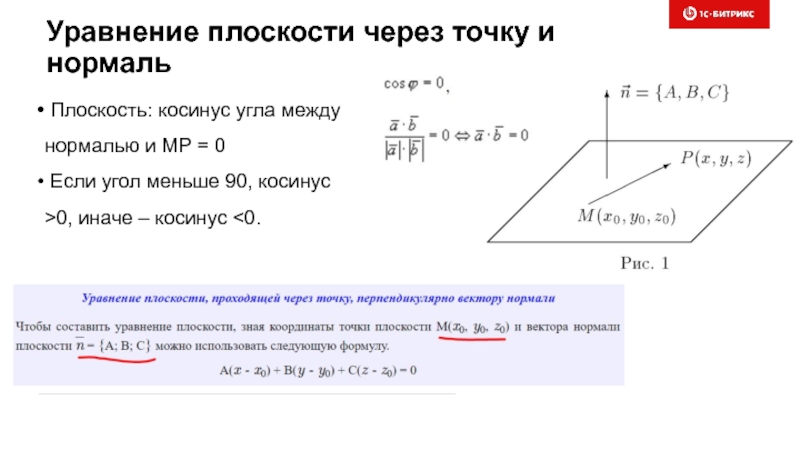

- 66. Уравнение плоскости через точку и нормаль

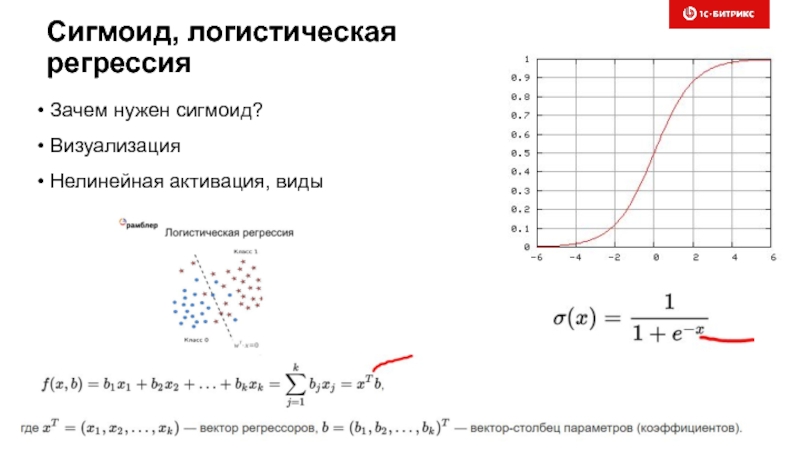

- 67. Сигмоид, логистическая регрессия

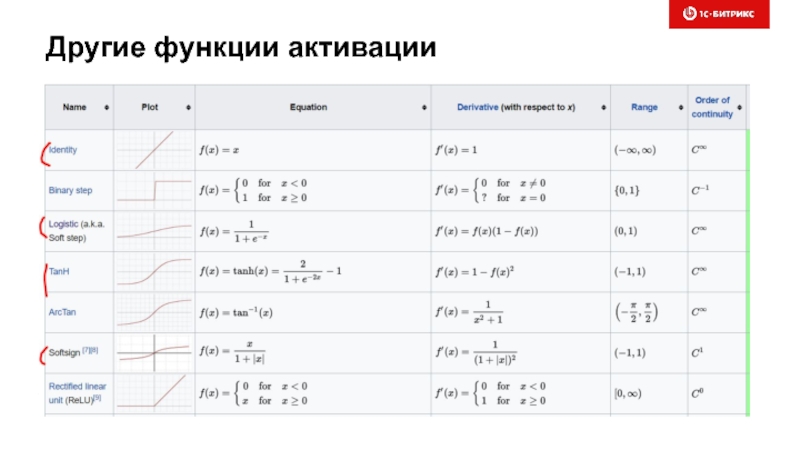

- 68. Другие функции активации

- 69. 25 кадр Твою ж мать, сколько еще это будет продолжаться? ☺

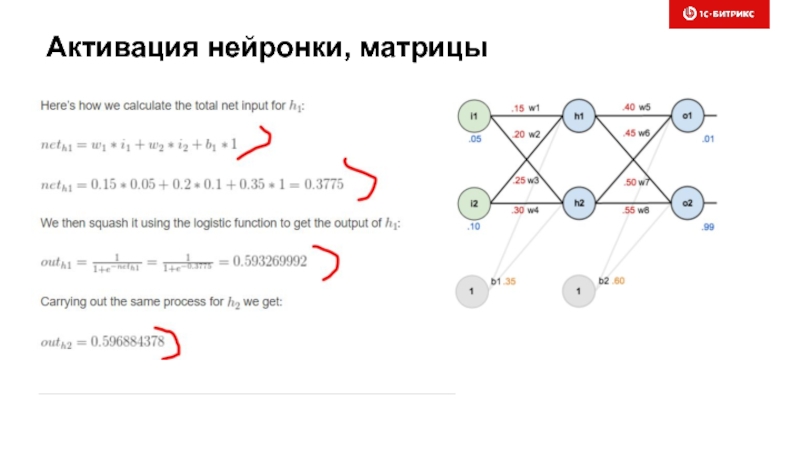

- 70. Активация нейронки, матрицы

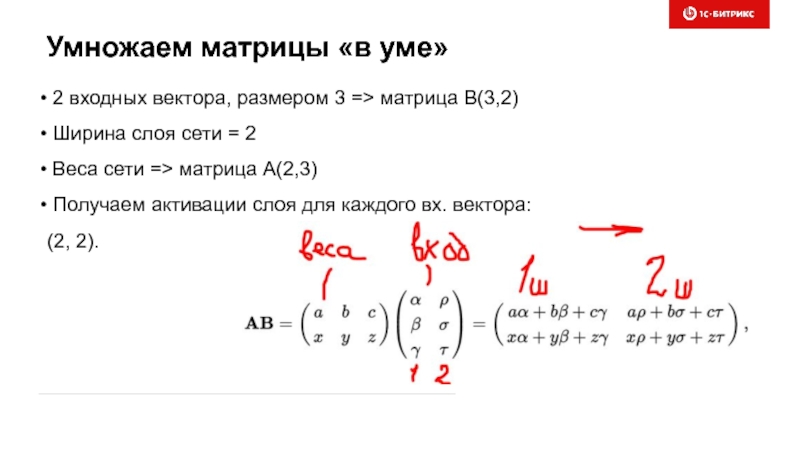

- 71. Умножаем матрицы «в уме»

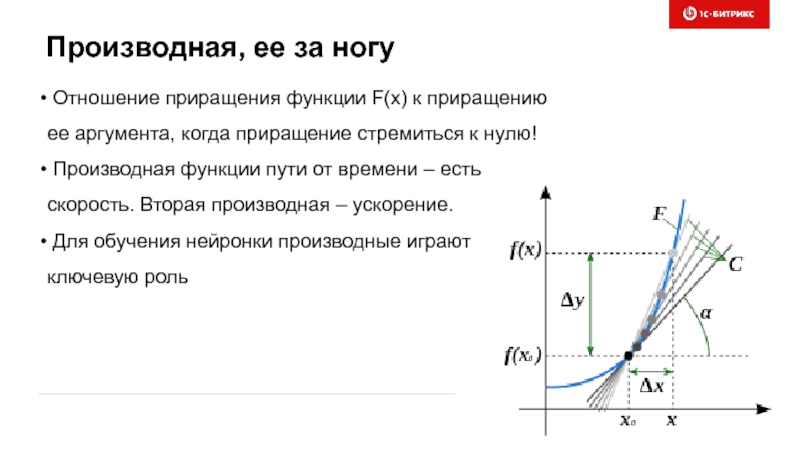

- 72. Производная, ее за ногу

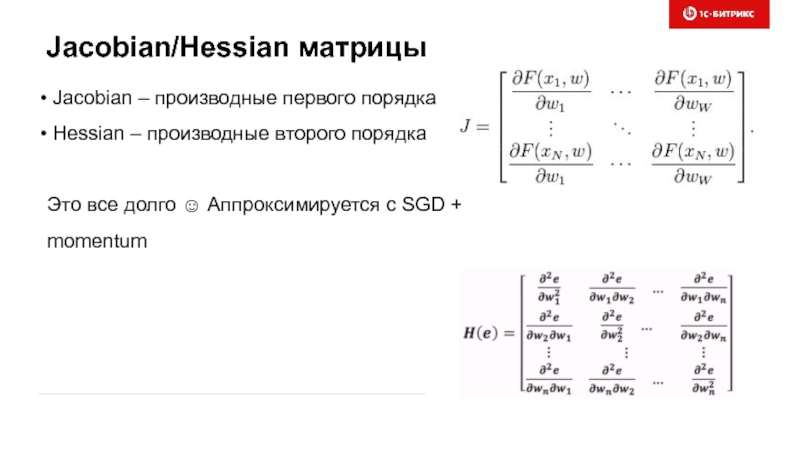

- 73. Jacobian/Hessian матрицы

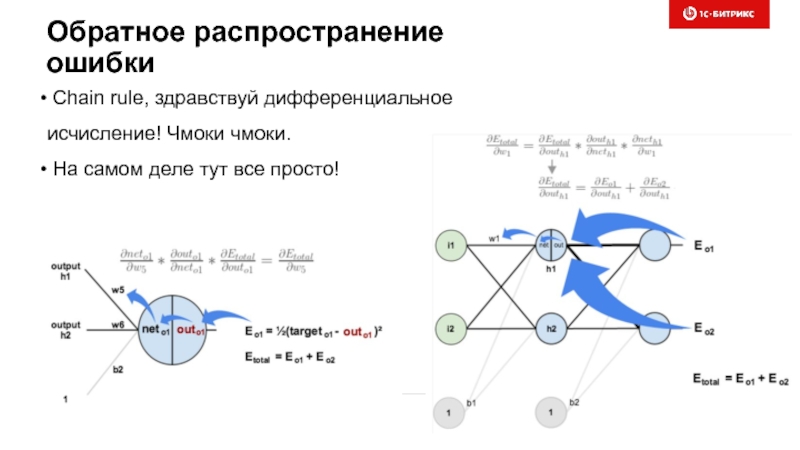

- 74. Обратное распространение ошибки

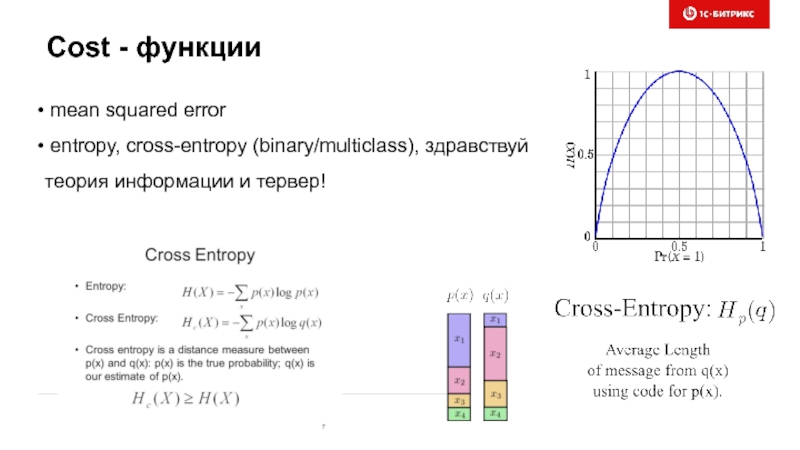

- 75. Cost - функции

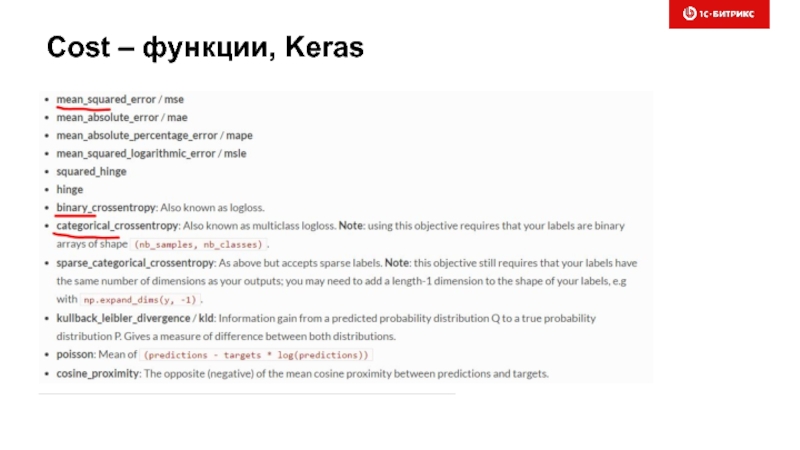

- 76. Cost – функции, Keras

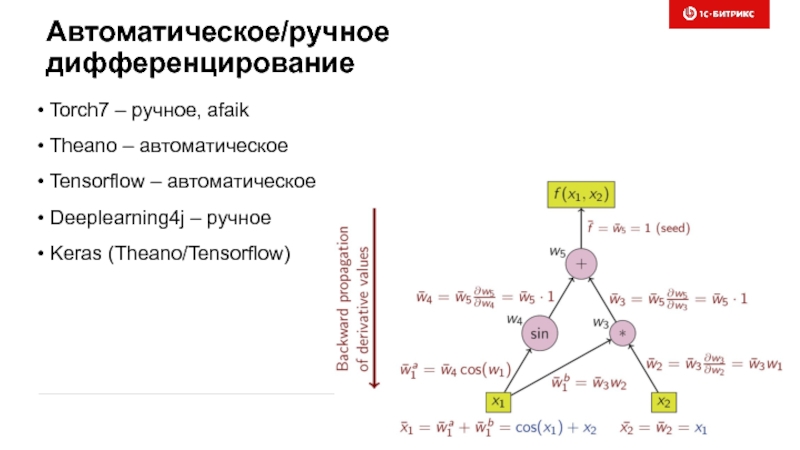

- 77. Автоматическое/ручное дифференцирование

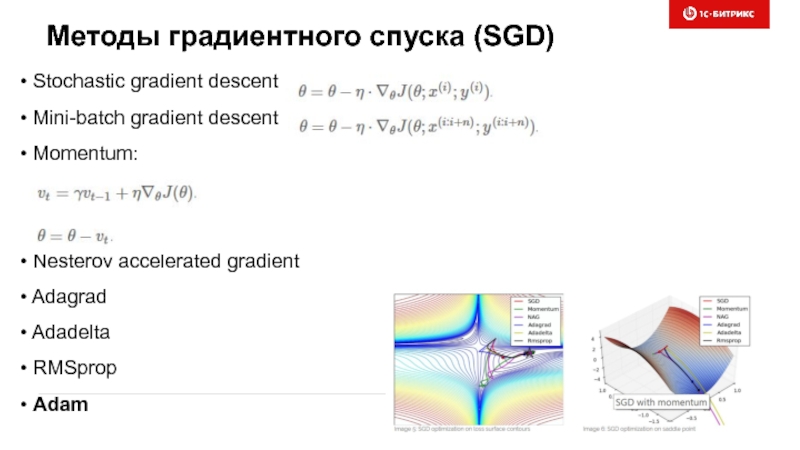

- 78. Методы градиентного спуска (SGD)

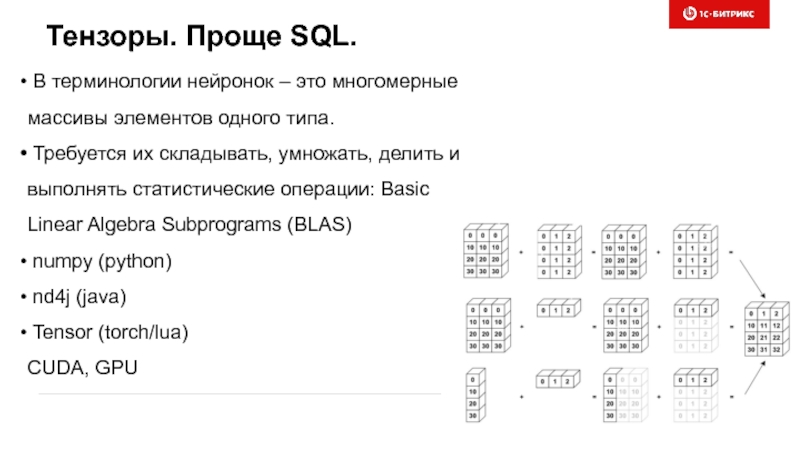

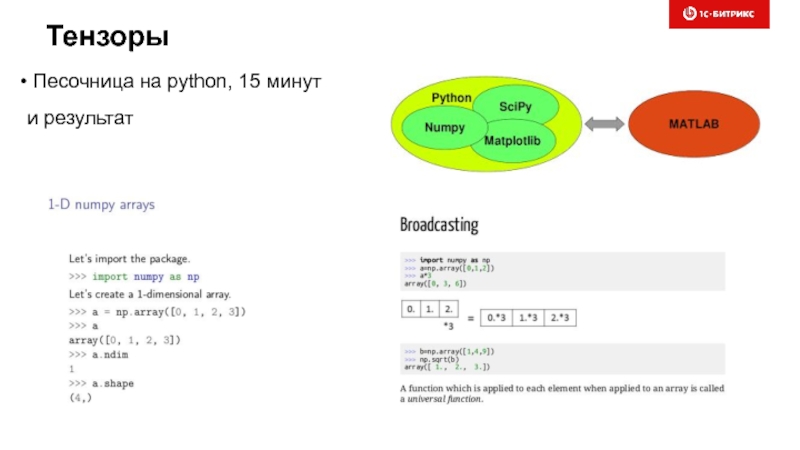

- 79. Тензоры. Проще SQL.

- 80. Тензоры Песочница на python, 15 минут и результат

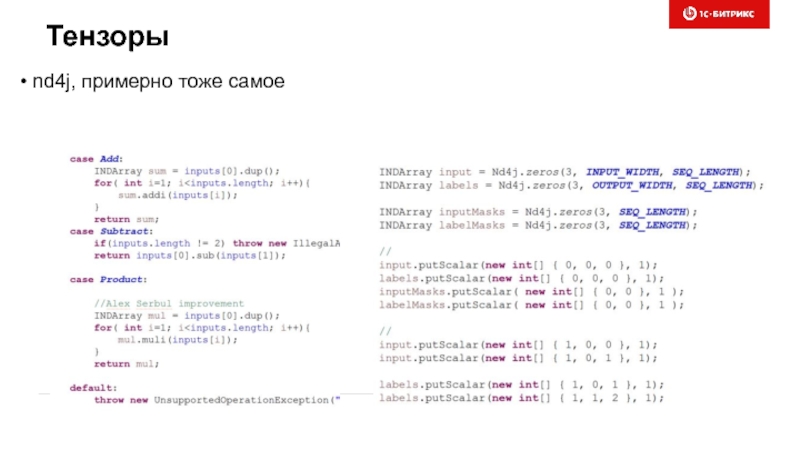

- 81. Тензоры nd4j, примерно тоже самое

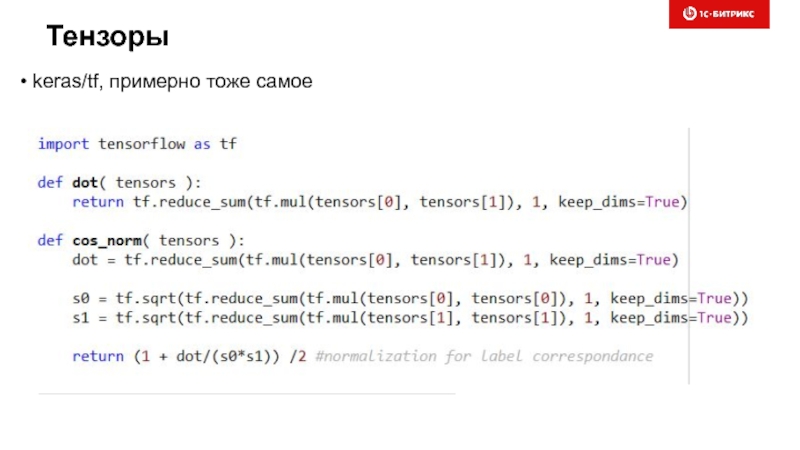

- 82. Тензоры keras/tf, примерно тоже самое

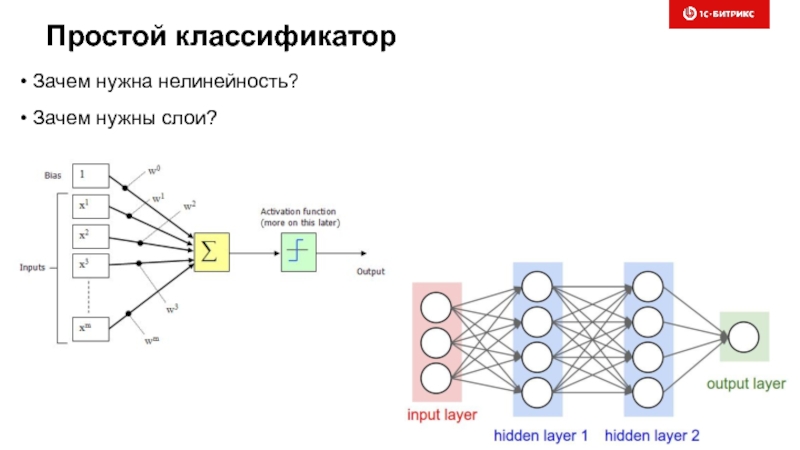

- 83. Простой классификатор Зачем нужна нелинейность? Зачем нужны слои?

- 84. Врач никому не нужен? ☺ Ныряем в прикладные кейсы

- 85. Полезные (готовые) инструменты Rapidminer SAS SPSS … Готовые блоки, серверные редакции (hadoop), графики

- 86. Полезные библиотеки (бесплатные) Spark MLlib (scala/java/python) –

- 87. Рабочее место аналитика

- 88. Аналитик Организовать сбор данных Минимум программирования Работа

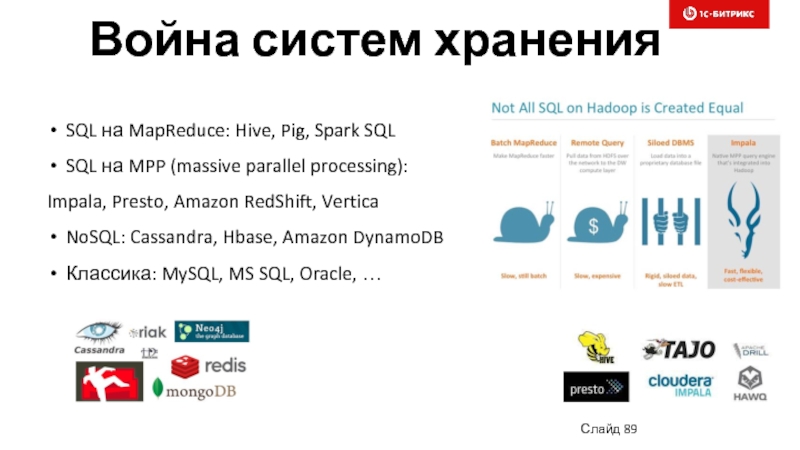

- 89. Война систем хранения Слайд SQL на

- 90. Визуализация

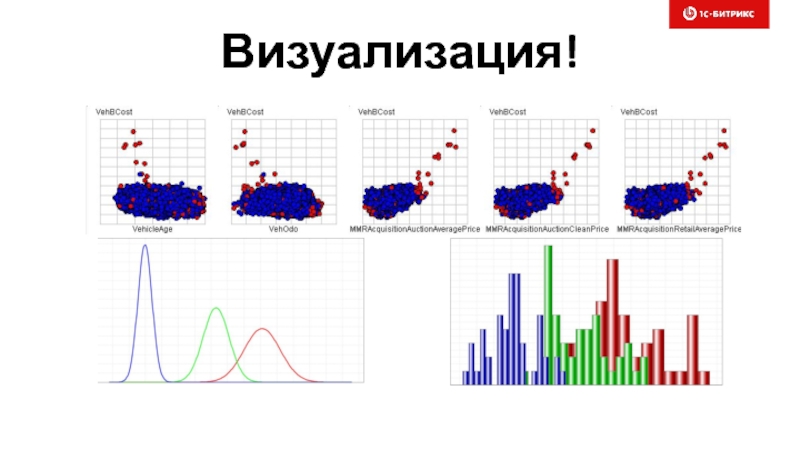

- 91. Визуализация!

- 92. Визуализация! Кто мои клиенты (возраст, средний чек,

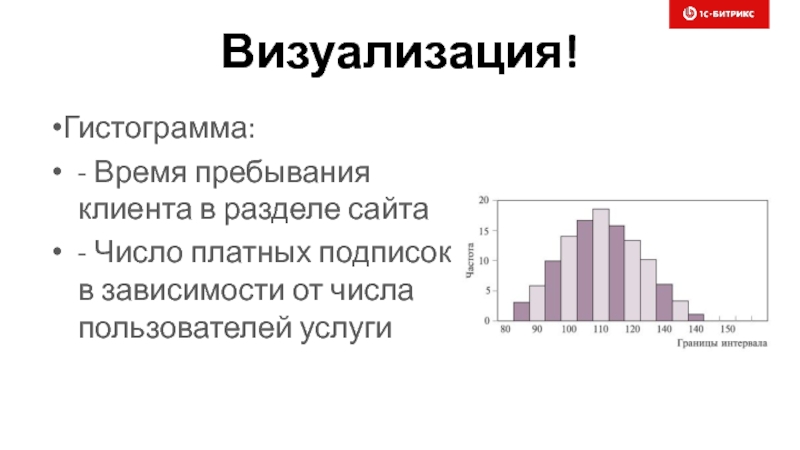

- 93. Визуализация! Гистограмма: - Время пребывания клиента в

- 94. Кластерный анализ

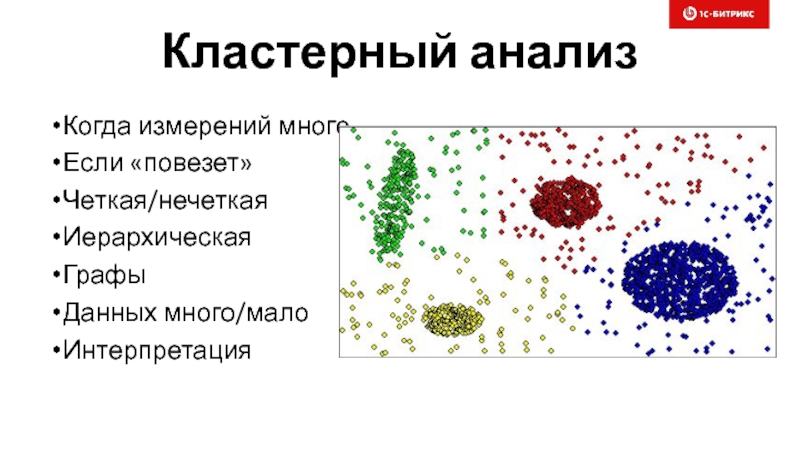

- 95. Кластерный анализ Когда измерений много Если «повезет»

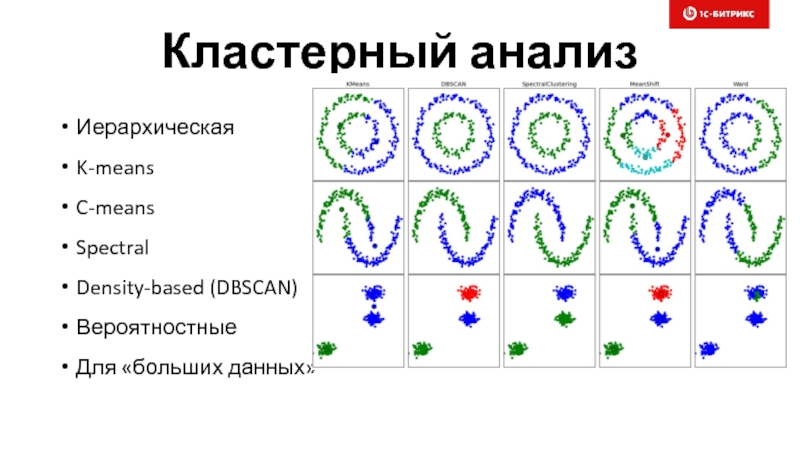

- 96. Кластерный анализ Иерархическая K-means C-means Spectral Density-based (DBSCAN) Вероятностные Для «больших данных»

- 97. Кластерный анализ – бизнес-кейсы Сегментация клиентов, типов

- 98. Кластерный анализ – оценки на программирование Данные

- 99. Кластерный анализ – риски Много данных –

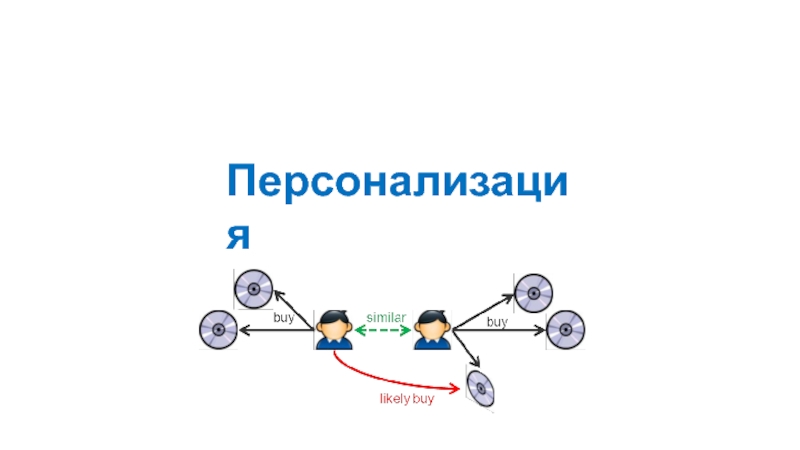

- 100. Персонализация

- 101. Персонализация Релевантный контент – «угадываем мысли» Релевантный

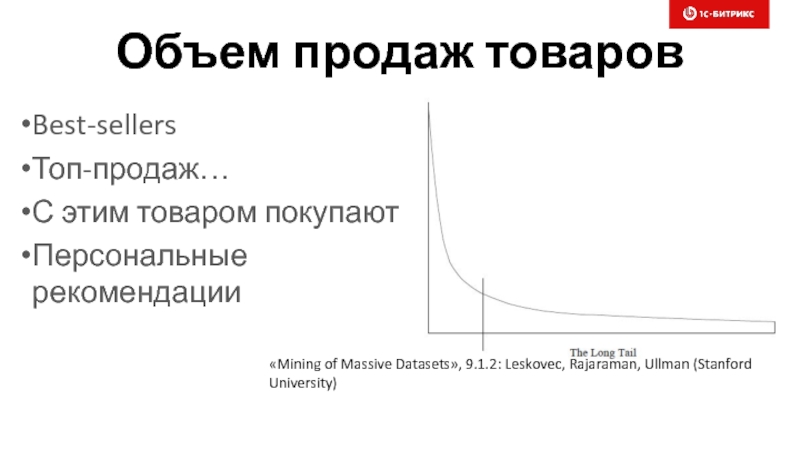

- 102. Объем продаж товаров Best-sellers Топ-продаж… С этим

- 103. Коллаборативная фильтрация Предложи Товары/Услуги, которые есть у

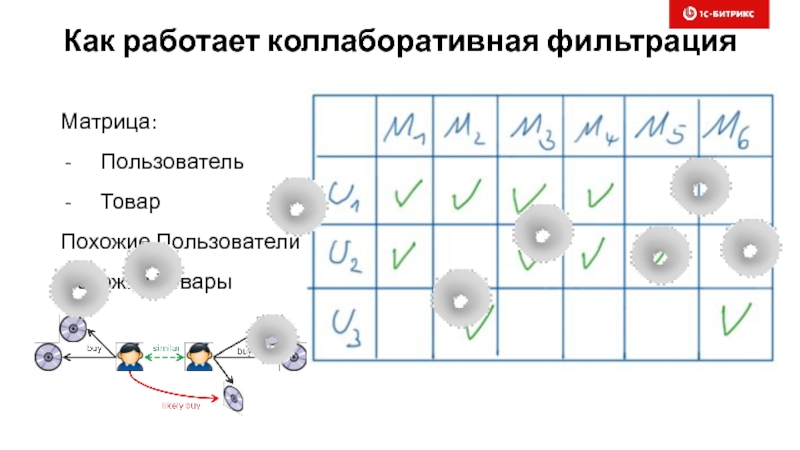

- 104. Как работает коллаборативная фильтрация Матрица: Пользователь Товар Похожие Пользователи Похожие Товары

- 105. Возможности коллаборативной фильтрации (Item-Item) Персональная рекомендация (рекомендуем

- 106. Коллаборативная фильтрация (Item-Item) – сроки, риски Apache

- 107. Content-based рекомендации Купил пластиковые окна – теперь

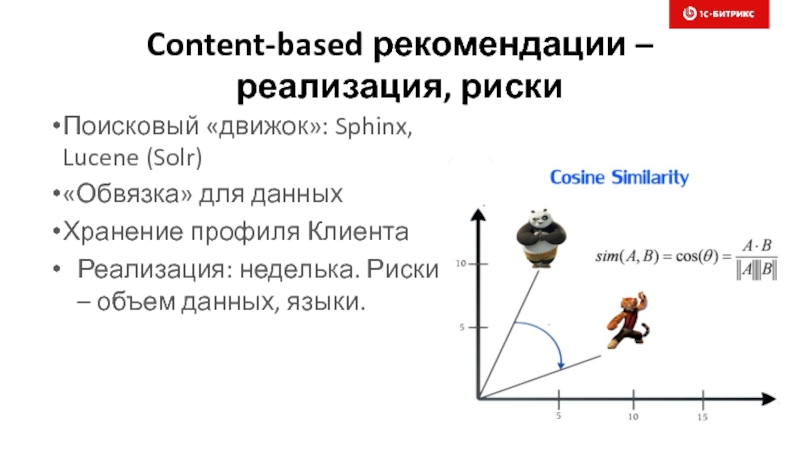

- 108. Content-based рекомендации – реализация, риски Поисковый «движок»:

- 109. Content-based, collaborative рекомендации - разумно Рекомендовать постоянно

- 110. Классификация

- 111. Классификация – это не кластеризация! Не путать!

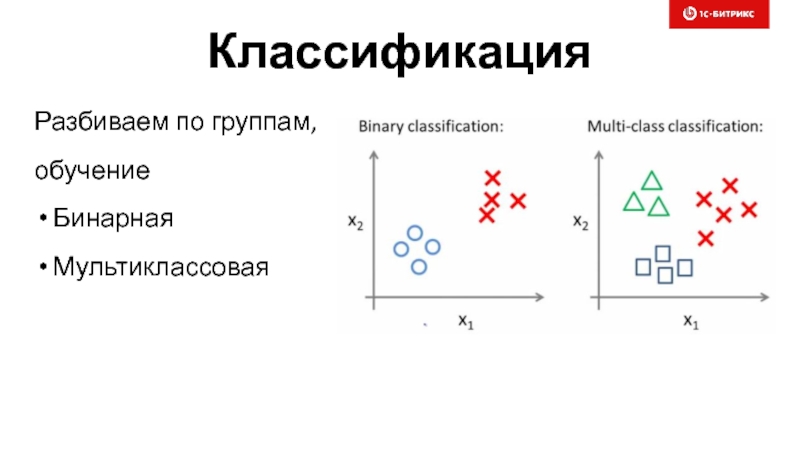

- 112. Классификация Разбиваем по группам, обучение Бинарная Мультиклассовая

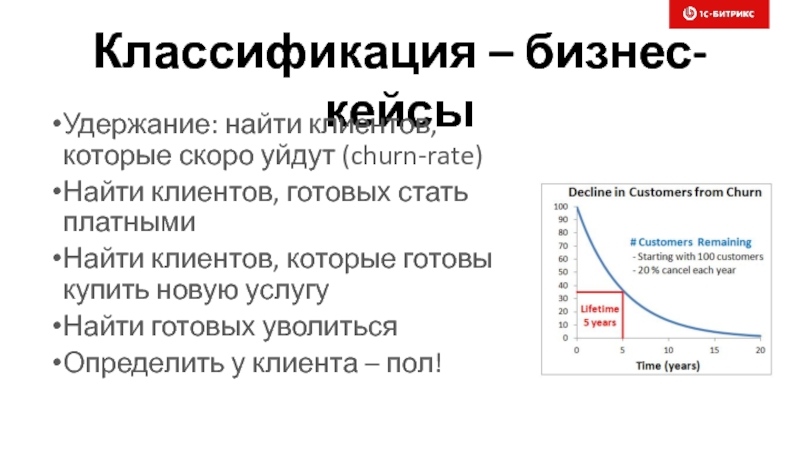

- 113. Классификация – бизнес-кейсы Удержание: найти клиентов, которые

- 114. Классификация – тонкости А как/чем удержать клиентов?

- 115. Классификация – реализация, риски Определение, нормализация атрибутов

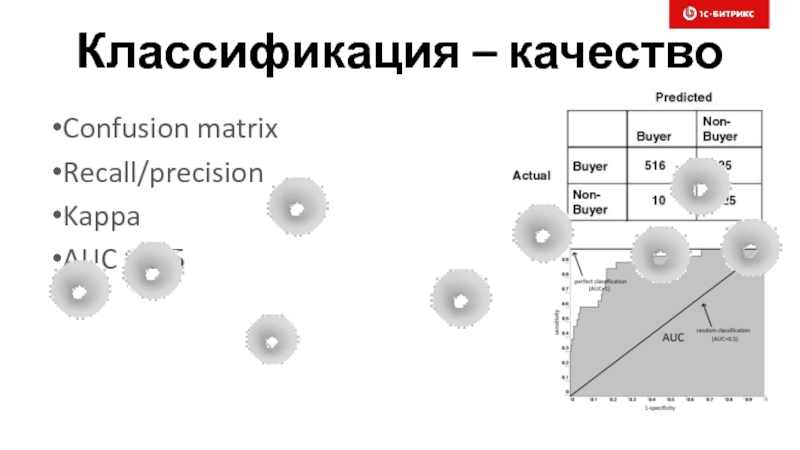

- 116. Классификация – качество Confusion matrix Recall/precision Kappa AUC > 0.5

- 117. Регрессия

- 118. Регрессия Предсказать «циферку» Стоимость квартиры, автомобиля на

- 119. Регрессия – customer lifetime value (CLV) Пришел

- 120. Регрессия – реализация, риски Выявление атрибутов Выбор

- 121. Reinforcement learning

- 122. Автоматическое A/B-тестирование Создаем наборы: главной, баннеров, корзины,

- 123. Reinforcement learning

- 124. Обучение с подкреплением Deepmind.com http://karpathy.github.io/2015/05/21/rnn-effectiveness/

- 125. Обучение с подкреплением - суть http://karpathy.github.io/2015/05/21/rnn-effectiveness/

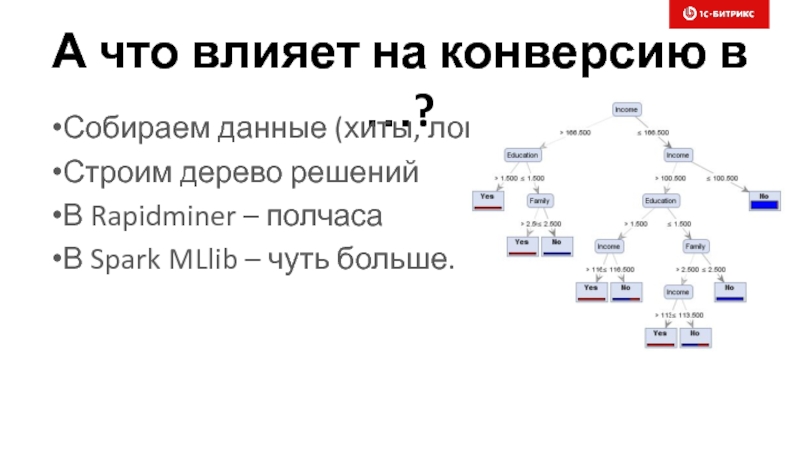

- 126. А что влияет на конверсию в …?

- 127. Стратегии увеличения прибыли

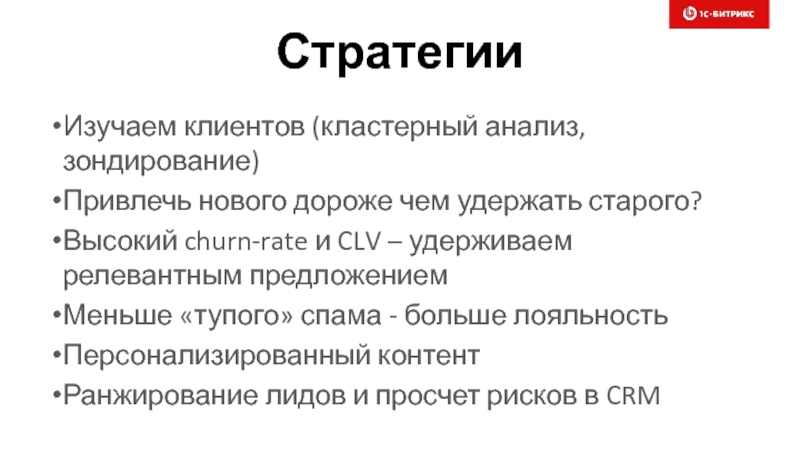

- 128. Стратегии Изучаем клиентов (кластерный анализ, зондирование) Привлечь

- 129. Типы нейросетей в 1С-Битрикс

- 130. Классификатор обращений техподдержки Глубокий

- 131. 1D свертка для классификации текстов Глубокий аналог

- 132. Классификатор обращений техподдержки Битрикс24

- 133. «Нейробот»

- 134. Наши эксперименты Наши эксперименты: Ф.М. Достоевский,

- 135. Наши эксперименты: Л.Н. Толстой, "Война и

- 136. Наши эксперименты: Код ядра Битрикс

- 137. Интересные тренды и техники Semi-supervised learning. Когда

- 138. Выводы Можно брать готовые модели в фреймворках

- 139. Спасибо за внимание! Вопросы?

Слайд 1

Машинное обучение в электронной коммерции – практика использования и подводные камни

Александр

Руководитель направления

Слайд 3Карл…

Карл, я специалист по BigData….

Это очень круто, пап!

Большая часть населения земли

Слайд 4О чем хочется поговорить

Ввести в исторический контекст проблемы. Разобраться в причинах.

Кратко

Перечислить актуальные, интересные бизнес-задачи в электронной коммерции и не только

Рассмотреть популярные архитектуры нейронок для решения бизнес-задач

Слайд 5О ЧЕМ ПОГОВОРИМ

Для менеджеров, без математики!

Понятные алгоритмы и техники

Полезные для электронной

В рамках Bigdata

Слайд

Слайд 6«Золотая» лихорадка

Была бигдата

Теперь нейронки

Завтра будет вторжение инопланетян ☺

Что происходит, успеть или

Слайд 8Что такое бигдата на самом деле?

Данные хранят ценную информацию. На данных

Как собрать данные правильно? MySQL или Hadoop?

Сколько нужно данных? Алгоритмы и объем данных

Инженерная культура в компании

Что нужно знать, чтобы извлечь пользу из данных (аналитика, матстатистика, машинное обучение)

Слайд 9Бигдата и веб-студия

Чем занимаются в веб-студии. Партнеры Битрикс, фреймворки. Близость к

Разработка «на бою». Минусы и плюсы.

Чатбот-платформа Битрикс. Возможности.

Маркетплейсы Битрикс и Битрикс24. Возможности.

Техники сбора бигдаты. Много ли нужно бигдаты.

Бигдата как актив. Системы аналитики и мониторинга.

Слайд 10Наука и (веб) разработка

Программирование и теория, computer science

Нужно ли писать тесты

На каком языке/фреймворке делать сайт?

Парадокс верстальщиков, python и javascript

Парадокс php и mysql

Почему до сих пор жив unix и во веки веков, аминь

Как правильно относиться к новым алгоритмам и применять их в боевых проектах?

Слайд 15Бигдата и нейронки – созданы друг для друга

Машины опорных векторов

Факторизация слоев

Нелинейность

Слайд 16А если данных все таки собрано мало?

Сколько нужно данных?

Простые классические алгоритимы:

Слайд 17В чем же принципиальная разница нейронок и традиционных алгоритмов?

Иерархия концепций/слоев в

Прорывные результаты в последние годы

Способность «впитать» в себя информацию из большого объема данных, нелинейность и факторизация

Сложные связи между атрибутами данных

Плоские модели

Слайд 18Подтянулись GPU и железо

Универсальные GPU

CUDA

Работа с тензорами

Диски, кластера: Spark, Hadoop/HDFS, Amazon

Языки: Scala

Слайд 19Парад бесплатных фреймворков

TensorFlow (Google)

Torch

Theano

Keras

Deeplearning4j

CNTK (Microsoft)

DSSTNE (Amazon)

Caffe

Слайд 20Вендоры скупают ученых

Facebook (Yann LeCun)

Baidu (Andrew Ng, уже правда уходит, достали

Google (Ian Goodfellow)

SalesForce (Richard Socher)

openai.com …

Слайд 21Как работает нейронка?

Все просто – почти как наш мозг ☺

Вспомните школьные

www.deeplearningbook.org

Слайд 35Рекуррентные нейросети

Последовательности событий, модели Маркова

http://karpathy.github.io/2015/05/21/rnn-effectiveness/

Слайд 38Чтение по губам

Сеть без звука читает по губам – уже 2

https://habrahabr.ru/company/mailru/blog/338248/

Слайд 39Ответы на вопросы по картинке

В некоторых случаях и датасетах сеть –

https://habrahabr.ru/company/mailru/blog/338248/

Слайд 42Другие кейсы применения нейронок

Предсказание следующего действия (RNN, …)

Кластеризация (autoencoders)

Кто из клиентов

Сколько стоит квартирка (regression)

Анализ причин (InfoGANs)

Персонализация

Слайд 47Подвох 2 – семантический разрыв

Классификация

Регрессия

Кластеризация

Анализ скрытых факторов в ином измерении

Как увеличить

Как удержать клиента?

Как предложить самое нужное?

Слайд 48Машина Тьюринга и … GTA

Нужно создавать новые абстракции, нужны «нейронные» программисты,

Слайд 51Подвох 3 – нужно долго учиться

Хорошая матподготовка выше среднего

Уметь писать код

Исследовательский

Опыт и интуиция

Слайд 52Подвох 4 – никаких гарантий

В интернете -работает

На ваших данных – нет

Где

Слайд 53Подвох 5: полная цепочка - сложна

Сбор данных

Фильтрация, валидация

Обучение модели

Раздача предсказаний

Контроль качества

Слайд 57arxiv.org/abs/1606.07792

Собирается все что есть…

Засовывается в нейронку

Нейронка предсказывает вероятность клика/покупки приложения –

Приложения сортируются и отображаются. Все! ☺

Ражнирование товаров (Google Play)

Слайд 58Где брать людей в команду?

Бигдата: хорошие программисты и опытные сисадмины –

Создание/тюнинг моделей: физматы – 1 штука на отдел

Product owner с обновленным мозгом – 1 штука на проект(ы)

Менеджеры – 1024 килограмм ☺

python, java, unix, spark, scala

Слайд 60Абстрактные знания и фундаментальная наука

Логика, реляционная алгебра

Дискретная математика,

Теория алгоритмов

Линейная алгебра

Интегральное и дифф. исчисление

Теория вероятностей

Теория оптимизации и численные методы

*времени на это практически нет

Слайд 61Восьмая проблема Гильберта и другие штучки

До сих пор неясно распределение

Эффективные алгоритмы нередко находят методом «тыка», многие мало изучены

Нейронные сети не должны … сходиться, но сходятся. И плохо-плохо изучены.

Наука только открывает ящик Пандоры!

Слайд 62Когда заканчивается наука, «начинается машинное обучение»

Четкая кластеризация: K-means (EM)

Нечеткая

Модели Маркова

Google Page Rank

Monte Carlo алгоритмы

Las Vegas алгоритмы (в т.ч. «обезьянья сортировка»)

Слайд 64Рассмотрим кусочек нейронки - нейрон

Линейная регрессия

Логистическая регрессия

Сигмоид

Здравствуй,

Слайд 65Вектор, косинус угла между векторами

Вектор – точка в N-мерном пространстве.

Косинус угла между векторами

Слайд 66Уравнение плоскости через точку и нормаль

Плоскость: косинус угла между нормалью

Если угол меньше 90, косинус >0, иначе – косинус <0.

Слайд 67Сигмоид, логистическая регрессия

Зачем нужен сигмоид?

Визуализация

Нелинейная активация, виды

Слайд 71Умножаем матрицы «в уме»

2 входных вектора, размером 3 => матрица

Ширина слоя сети = 2

Веса сети => матрица A(2,3)

Получаем активации слоя для каждого вх. вектора: (2, 2).

Слайд 72Производная, ее за ногу

Отношение приращения функции F(x) к приращению ее

Производная функции пути от времени – есть скорость. Вторая производная – ускорение.

Для обучения нейронки производные играют ключевую роль

Слайд 73Jacobian/Hessian матрицы

Jacobian – производные первого порядка

Hessian – производные второго

Это все долго ☺ Аппроксимируется с SGD + momentum

Слайд 74Обратное распространение ошибки

Chain rule, здравствуй дифференциальное исчисление! Чмоки чмоки.

На

Слайд 75Cost - функции

mean squared error

entropy, cross-entropy (binary/multiclass), здравствуй теория

Слайд 77Автоматическое/ручное

дифференцирование

Torch7 – ручное, afaik

Theano – автоматическое

Tensorflow – автоматическое

Keras (Theano/Tensorflow)

Слайд 78Методы градиентного спуска (SGD)

Stochastic gradient descent

Mini-batch gradient descent

Momentum:

Adagrad

Adadelta

RMSprop

Adam

Слайд 79Тензоры. Проще SQL.

В терминологии нейронок – это многомерные массивы элементов

Требуется их складывать, умножать, делить и выполнять статистические операции: Basic Linear Algebra Subprograms (BLAS)

numpy (python)

nd4j (java)

Tensor (torch/lua)

CUDA, GPU

Слайд 85Полезные (готовые) инструменты

Rapidminer

SAS

SPSS

…

Готовые блоки, серверные редакции (hadoop), графики

Слайд 86Полезные библиотеки (бесплатные)

Spark MLlib (scala/java/python) – много данных

scikit-learn.org (python) – мало

R

Слайд 88Аналитик

Организовать сбор данных

Минимум программирования

Работа в инструментах (Rapidminer, R, SAS, SPSS)

Bigdata –

Слайд 89Война систем хранения

Слайд

SQL на MapReduce: Hive, Pig, Spark SQL

SQL на

Impala, Presto, Amazon RedShift, Vertica

NoSQL: Cassandra, Hbase, Amazon DynamoDB

Классика: MySQL, MS SQL, Oracle, …

Слайд 92Визуализация!

Кто мои клиенты (возраст, средний чек, интересы)?

Тренды, графы

Корреляция значений

2-3, иногда больше

«Дешевле/проще» кластеризации

Слайд 93Визуализация!

Гистограмма:

- Время пребывания клиента в разделе сайта

- Число платных подписок в

Слайд 95Кластерный анализ

Когда измерений много

Если «повезет»

Четкая/нечеткая

Иерархическая

Графы

Данных много/мало

Интерпретация

Слайд 96Кластерный анализ

Иерархическая

K-means

C-means

Spectral

Density-based (DBSCAN)

Вероятностные

Для «больших данных»

Слайд 97Кластерный анализ – бизнес-кейсы

Сегментация клиентов, типов использования сервиса, …

Кластеризация «общего» товарного

Кластеризация графа связей сайтов (пересечение аудитории)

Маркетинг работает с целевыми группами, информация разбита на «смысловые облака».

Слайд 98Кластерный анализ – оценки на программирование

Данные должны быть уже собраны

Анализ в

Анализ в Spark Mllib (1-2 дня, много данных)

Анализ в scikit-learn – аналогично (мало данных)

На выходе: список кластерных групп, иногда визуализация.

Метрики качества кластеризации.

Слайд 99Кластерный анализ – риски

Много данных – медленно!

Тексты, каталоги товаров …

Как интерпретировать?

Рецепты:

Spark

Слайд 101Персонализация

Релевантный контент – «угадываем мысли»

Релевантный поиск

Предлагаем то, что клиенту нужно как

Увеличение лояльности, конверсии

Слайд 102Объем продаж товаров

Best-sellers

Топ-продаж…

С этим товаром покупают

Персональные рекомендации

«Mining of Massive Datasets», 9.1.2:

Слайд 103Коллаборативная фильтрация

Предложи Товары/Услуги, которые есть у твоих друзей (User-User)

Предложи к твоим

Слайд 104Как работает коллаборативная фильтрация

Матрица:

Пользователь

Товар

Похожие Пользователи

Похожие Товары

Слайд 105Возможности коллаборативной фильтрации (Item-Item)

Персональная рекомендация (рекомендуем посмотреть эти Товары)

С этим Товаром

Топ Товаров на сайте

Слайд 106Коллаборативная фильтрация (Item-Item) – сроки, риски

Apache Spark MLlib (als), Apache Mahout

Объем данных

Объем модели, требования к «железу»

Слайд

Слайд 107Content-based рекомендации

Купил пластиковые окна – теперь их предлагают на всех сайтах

Купил Toyota, ищу шины, предлагают шины к Toyota

Слайд 108Content-based рекомендации – реализация, риски

Поисковый «движок»: Sphinx, Lucene (Solr)

«Обвязка» для данных

Хранение

Реализация: неделька. Риски – объем данных, языки.

Слайд 109Content-based, collaborative рекомендации - разумно

Рекомендовать постоянно «возобновляемые» Товары (молоко, носки, …)

Рекомендовать

Учет пола, возраста, размера, …

Слайд 111Классификация – это не кластеризация!

Не путать!

Кластеризация – автоматическая и если повезет

Классификация

Пример: фильтрация спама, которую доучиваем

Слайд 113Классификация – бизнес-кейсы

Удержание: найти клиентов, которые скоро уйдут (churn-rate)

Найти клиентов, готовых

Найти клиентов, которые готовы купить новую услугу

Найти готовых уволиться

Определить у клиента – пол!

Слайд 114Классификация – тонкости

А как/чем удержать клиентов?

Определение релевантных групп – зондирование (рассылки,

Оценка качества моделей

Слайд 115Классификация – реализация, риски

Определение, нормализация атрибутов

Feature engineering

Выбор алгоритма, kernel

Spark MLlib, scikit-learn

Rapidminer – полчаса

Слайд 118Регрессия

Предсказать «циферку»

Стоимость квартиры, автомобиля на рынке

Ценность клиента для магазина

Зарплата на данную

и т.д.

Слайд 119Регрессия – customer lifetime value (CLV)

Пришел клиент, а он потенциально прибыльный!

Система

Подарки, скидки, …

Слайд 120Регрессия – реализация, риски

Выявление атрибутов

Выбор алгоритма

Spark MLlib – не работает, scikit-learn

Слайд 122Автоматическое A/B-тестирование

Создаем наборы: главной, баннеров, корзины, мастера заказа

Ставим цель – оформление

Клиенты обучают систему - автоматически

Система отображает самые эффективные элементы интерфейса

Слайд 124Обучение с подкреплением

Deepmind.com

http://karpathy.github.io/2015/05/21/rnn-effectiveness/

Слайд 126А что влияет на конверсию в …?

Собираем данные (хиты, логи, анкетирование)

Строим

В Rapidminer – полчаса

В Spark MLlib – чуть больше.

Слайд 128Стратегии

Изучаем клиентов (кластерный анализ, зондирование)

Привлечь нового дороже чем удержать старого?

Высокий churn-rate

Меньше «тупого» спама - больше лояльность

Персонализированный контент

Ранжирование лидов и просчет рисков в CRM

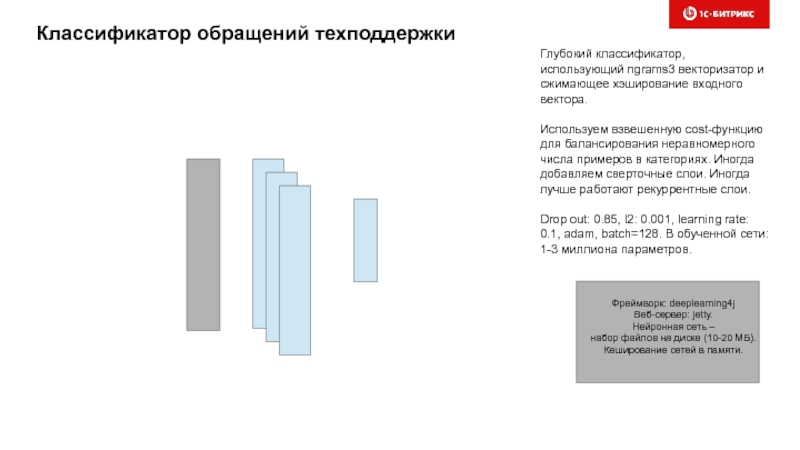

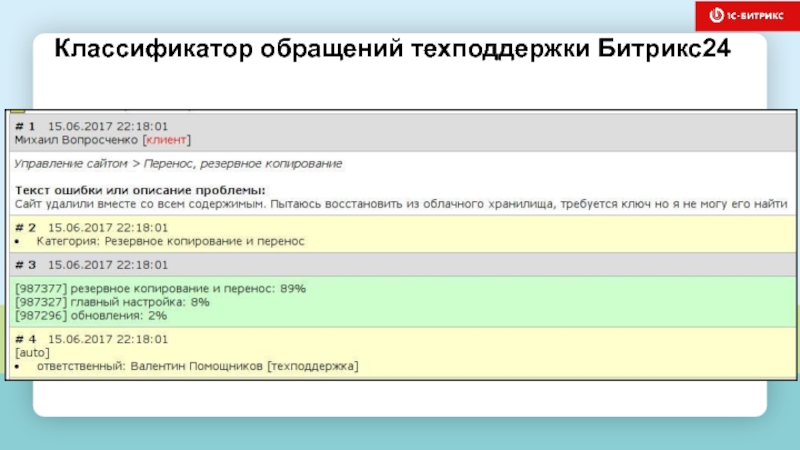

Слайд 130Классификатор обращений техподдержки

Глубокий классификатор, использующий ngrams3 векторизатор и сжимающее хэширование входного

Используем взвешенную cost-функцию для балансирования неравномерного числа примеров в категориях. Иногда добавляем сверточные слои. Иногда лучше работают рекуррентные слои.

Drop out: 0.85, l2: 0.001, learning rate: 0.1, adam, batch=128. В обученной сети: 1-3 миллиона параметров.

Фреймворк: deeplearning4j

Веб-сервер: jetty.

Нейронная сеть –

набор файлов на диске (10-20 МБ).

Кеширование сетей в памяти.

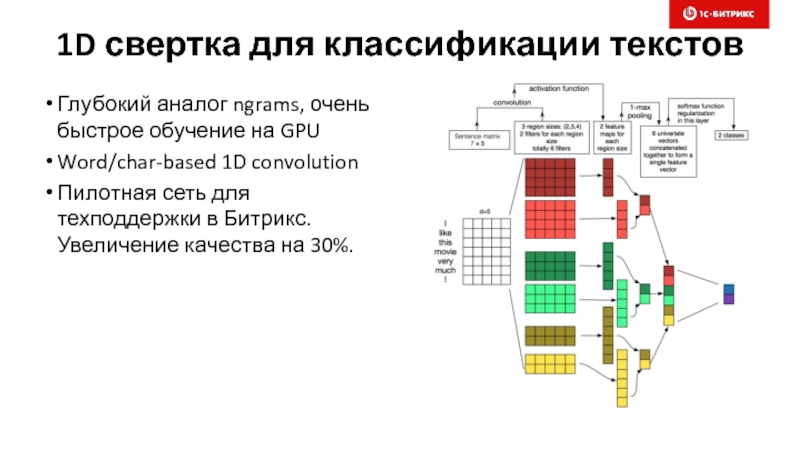

Слайд 1311D свертка для классификации текстов

Глубокий аналог ngrams, очень быстрое обучение на

Word/char-based 1D convolution

Пилотная сеть для техподдержки в Битрикс. Увеличение качества на 30%.

Слайд 133«Нейробот»

Кластер веб-серверов,

Кэширование, REST-API

GPUs (TitanX)

Глубокая нейронная сеть

с двумя входами и одним выходом

Внутри сети происходит совмещение

семантических пространств вопросов и ответов.

В 2017 году – сделали совместный пилот с мэрией Москвы

Слайд 134Наши эксперименты

Наши эксперименты:

Ф.М. Достоевский, "Преступление и наказание“

Число слоев сети: 2

Число нейронов в каждом слое: 400

Коэффициент встряхивания "мозгов" (dropout): чуть больше единицы

Память сети: 50 символов назад

Число параметров, которые мы учим - меньше миллиона.

Слайд 135Наши эксперименты:

Л.Н. Толстой, "Война и мир"

Число слоев сети: 3

Число

Коэффициент встряхивания "мозгов" (dropout): чуть больше единицы

Память сети: 150 символов назад

Число параметров, которые мы учим - несколько миллионов

Наши эксперименты

Слайд 136Наши эксперименты:

Код ядра Битрикс

3-х слойная сеть, размер слоя: 400 нейронов,

Наши эксперименты

Слайд 137Интересные тренды и техники

Semi-supervised learning. Когда данных мало…

One-shot learning

Переобучение

Neural turing machine/memory

Attention

Слайд 138Выводы

Можно брать готовые модели в фреймворках и применять в различных бизнес-задачах

Собирать данные не сложно – главное аккуратно ☺

Все быстро меняется, нужно учиться

Инженерные практики в компании – очень важны

Слайд 139

Спасибо за внимание!

Вопросы?

Александр Сербул

@AlexSerbul

Alexandr

serbul@1c-bitrix.ru