- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

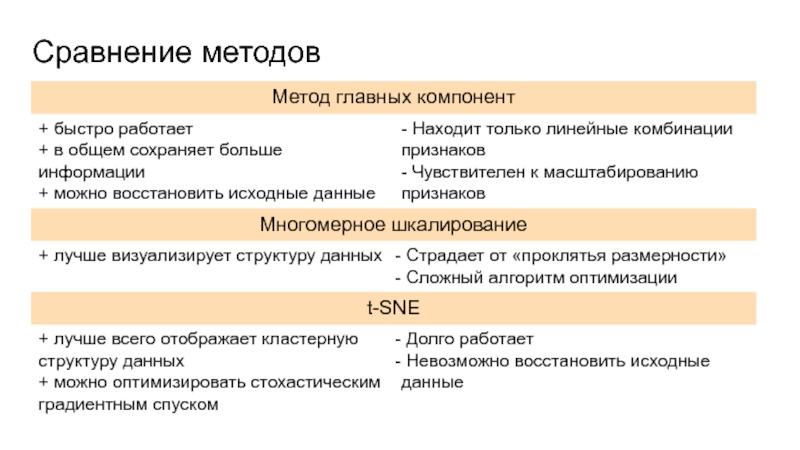

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Визуализация многомерных пространств презентация

Содержание

- 1. Визуализация многомерных пространств

- 2. Где мы встречаем многомерные пространства? Одна из самых распространенных областей - анализ данных:

- 3. Цель визуализации Цель – получить

- 4. "To deal with hyper-planes in a 14

- 5. Методы Рассмотрим методы, сопоставляющие точке в n-мерном пространстве точку в пространстве меньшей размерности:

- 6. Метод главных компонент (PCA) Основной линейный метод

- 7. Максимизировать вариацию по вектору Минимизировать

- 8. Записать x1 … xn как вектор-строки

- 9. Шаг 2: Оцентрировать данные Найти среднее по

- 10. Шаг 3: Вычислить матрицу ковариации Найти матрицу

- 11. Шаг 4: Найти собственные вектора и собственные

- 12. Шаг 5: Проекция и реконструкция В матрицу

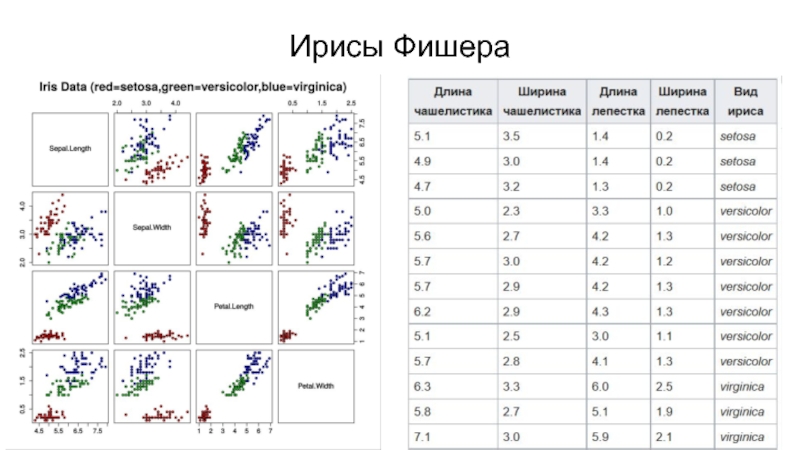

- 13. Ирисы Фишера

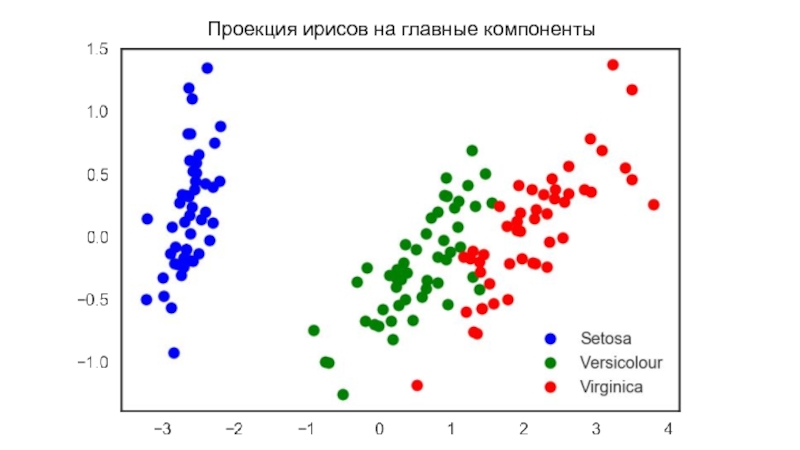

- 14. Проекция ирисов на главные компоненты

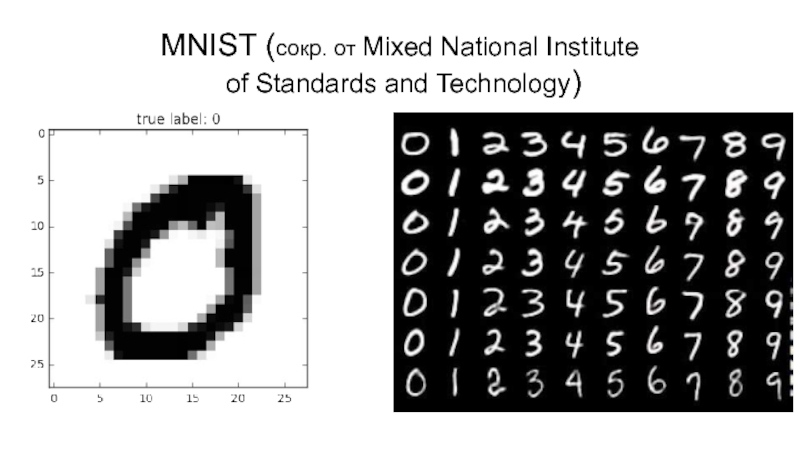

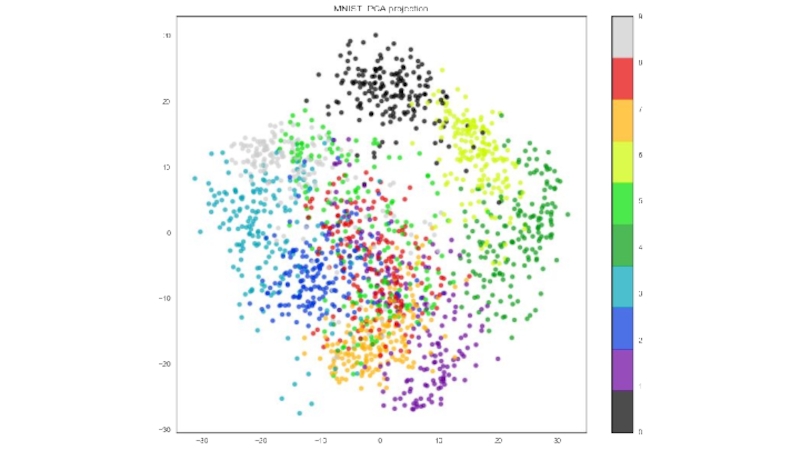

- 15. MNIST (сокр. от Mixed National Institute of Standards and Technology)

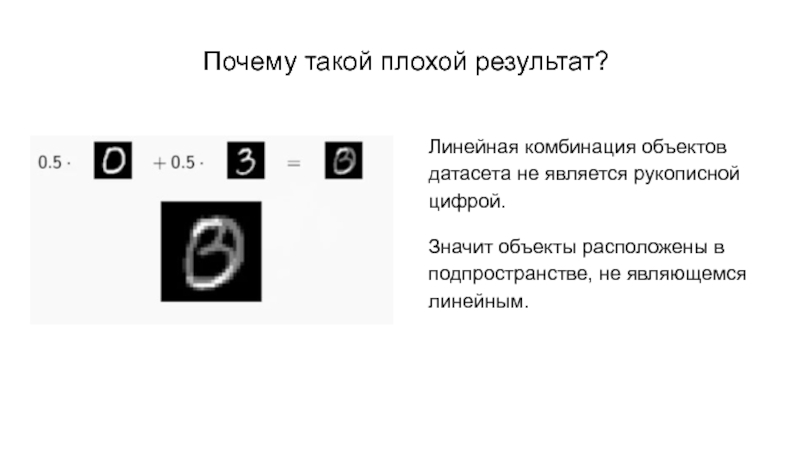

- 17. Почему такой плохой результат? Линейная комбинация объектов

- 18. Нелинейные методы Рассмотрим более простую модель и

- 19. Гипотеза: малоразмерное представление сохраняет попарные расстояния между

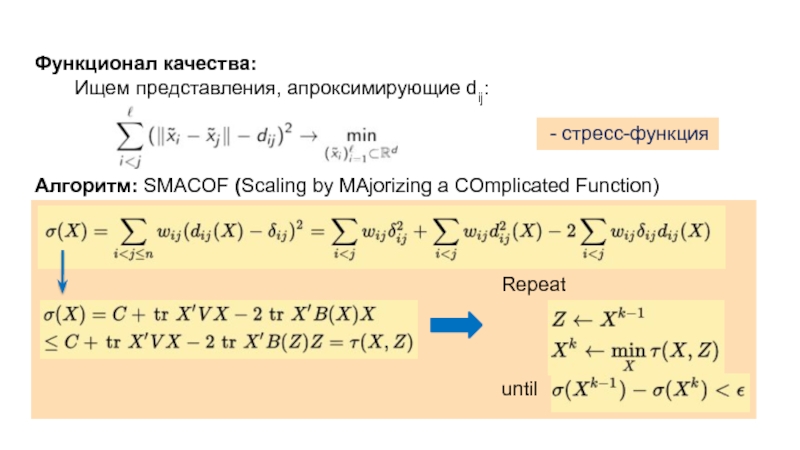

- 20. Функционал качества: Ищем представления, апроксимирующие dij:

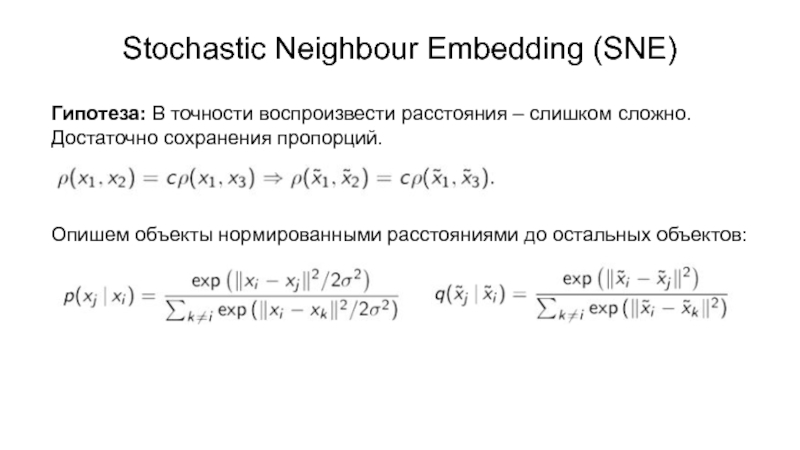

- 21. Stochastic Neighbour Embedding (SNE) Гипотеза: В точности

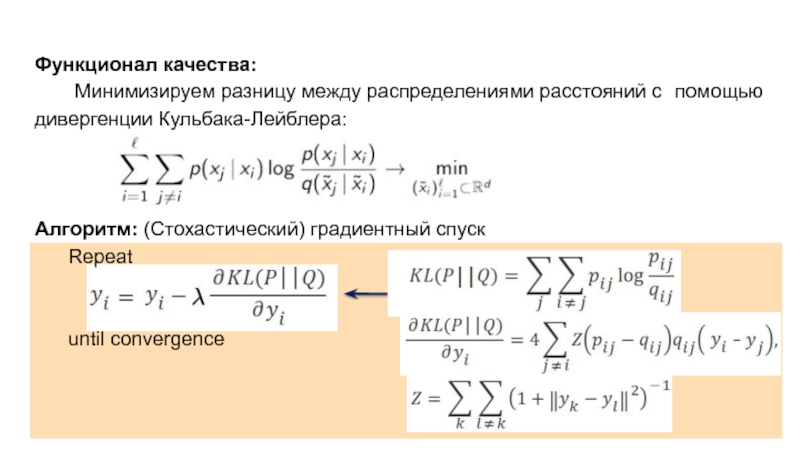

- 22. Функционал качества: Минимизируем разницу между распределениями

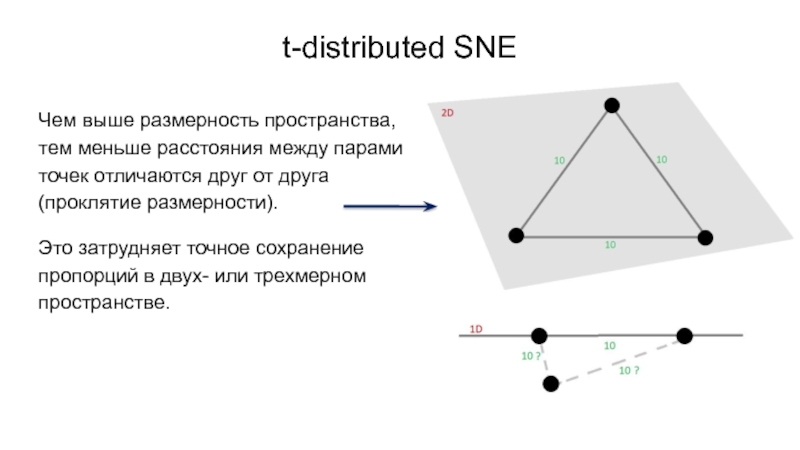

- 23. t-distributed SNE Чем выше размерность пространства, тем

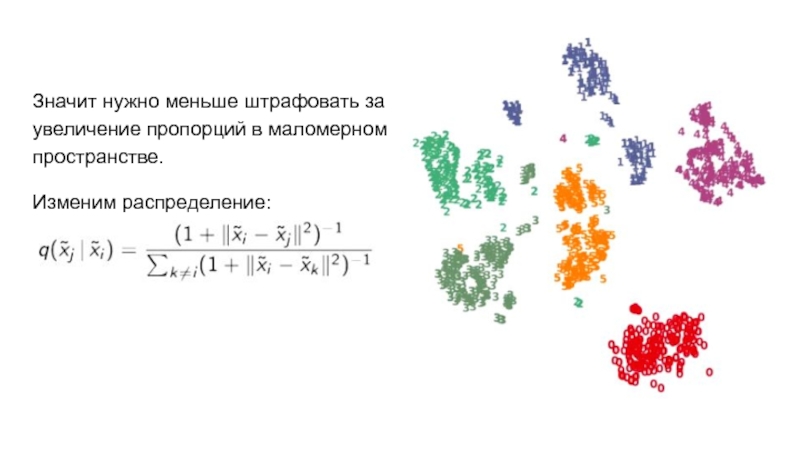

- 24. Значит нужно меньше штрафовать за увеличение пропорций в маломерном пространстве. Изменим распределение:

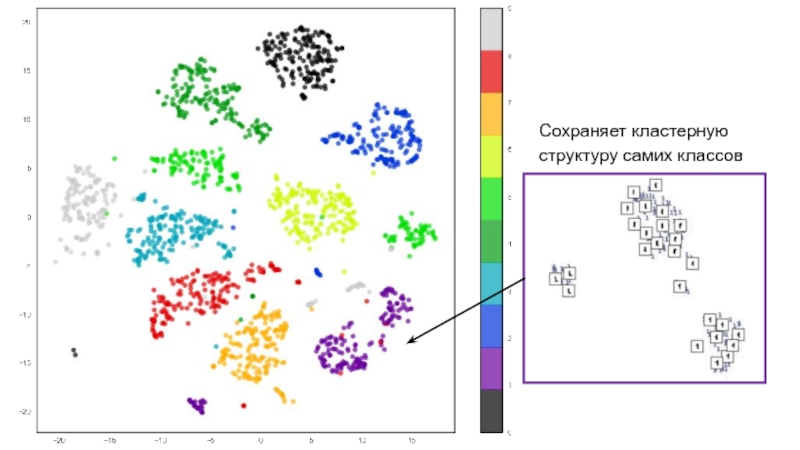

- 25. Сохраняет кластерную структуру самих классов

- 26. Сравнение методов

- 27. Выводы Существует множество методов визуализации многомерных

- 28. Спасибо за внимание

Слайд 2Где мы встречаем многомерные пространства?

Одна из самых распространенных областей -

Слайд 3 Цель визуализации

Цель – получить отображение данных в 2 или

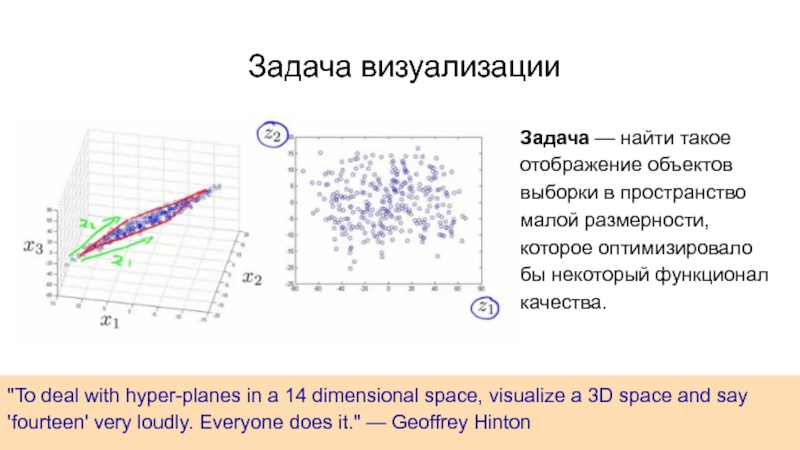

Слайд 4"To deal with hyper-planes in a 14 dimensional space, visualize a

Задача — найти такое отображение объектов выборки в пространство малой размерности, которое оптимизировало бы некоторый функционал качества.

Задача визуализации

Слайд 5Методы

Рассмотрим методы, сопоставляющие точке в n-мерном пространстве точку в пространстве меньшей

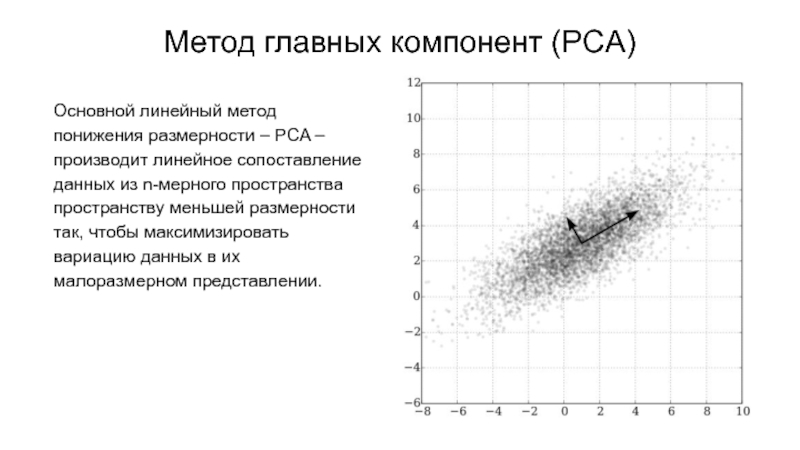

Слайд 6Метод главных компонент (PCA)

Основной линейный метод понижения размерности – PCA –

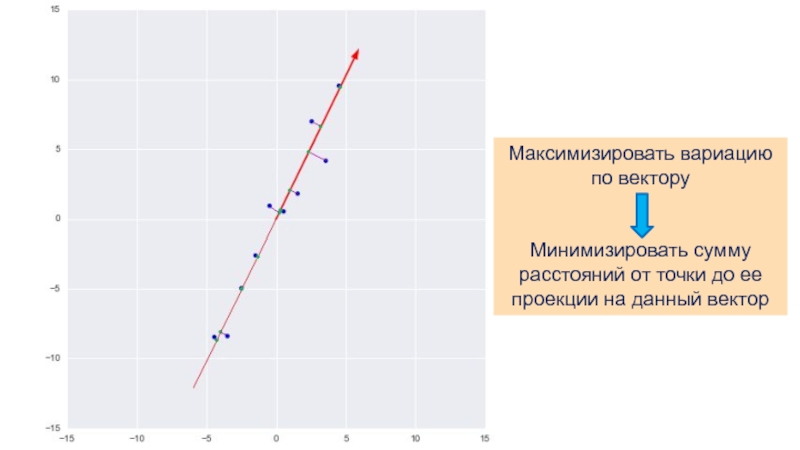

Слайд 7Максимизировать вариацию по вектору

Минимизировать сумму расстояний от точки до ее проекции

Слайд 8

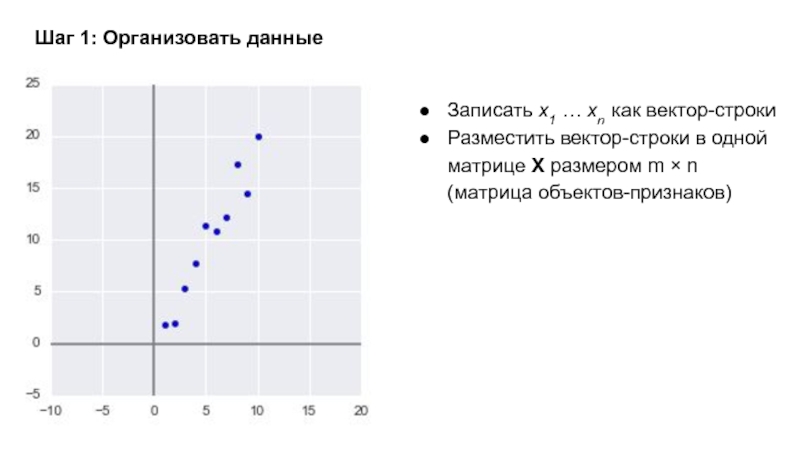

Записать x1 … xn как вектор-строки

Разместить вектор-строки в одной матрице X

Шаг 1: Организовать данные

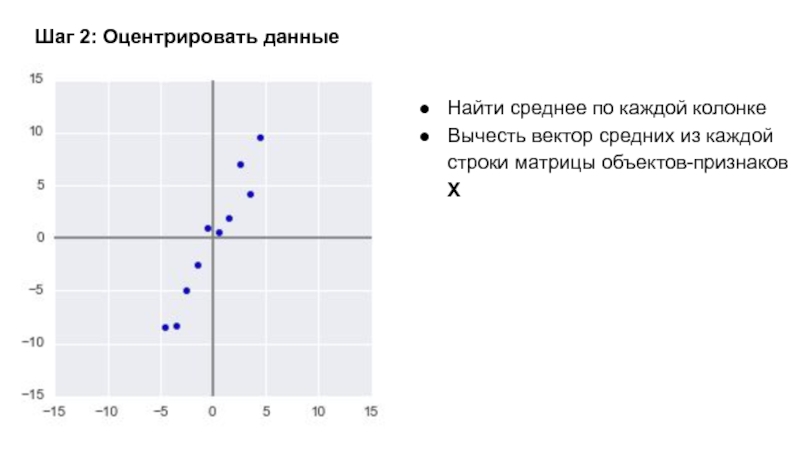

Слайд 9Шаг 2: Оцентрировать данные

Найти среднее по каждой колонке

Вычесть вектор средних из

Слайд 10Шаг 3: Вычислить матрицу ковариации

Найти матрицу ковариации С размера n ×

C = 1⁄(n − 1) XT X

Использование N − 1 вместо N обусловлено поправкой Бесселя

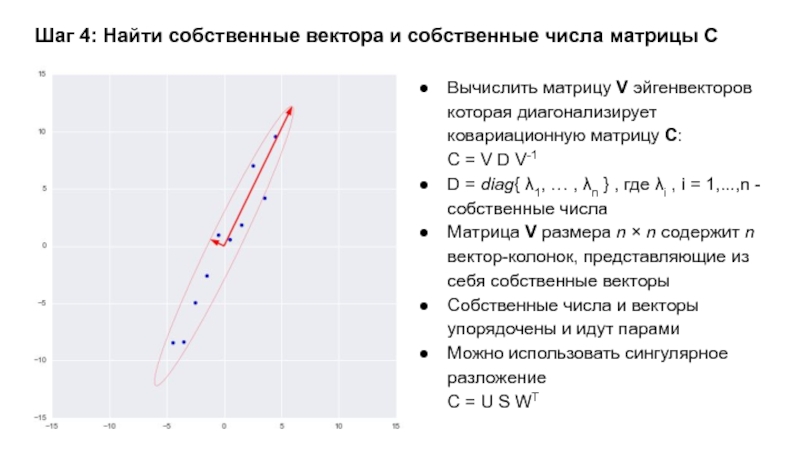

Слайд 11Шаг 4: Найти собственные вектора и собственные числа матрицы С

Вычислить матрицу

C = V D V-1

D = diag{ λ1, … , λn } , где λi , i = 1,...,n - собственные числа

Матрица V размера n × n содержит n вектор-колонок, представляющие из себя собственные векторы

Собственные числа и векторы упорядочены и идут парами

Можно использовать сингулярное разложение

C = U S WT

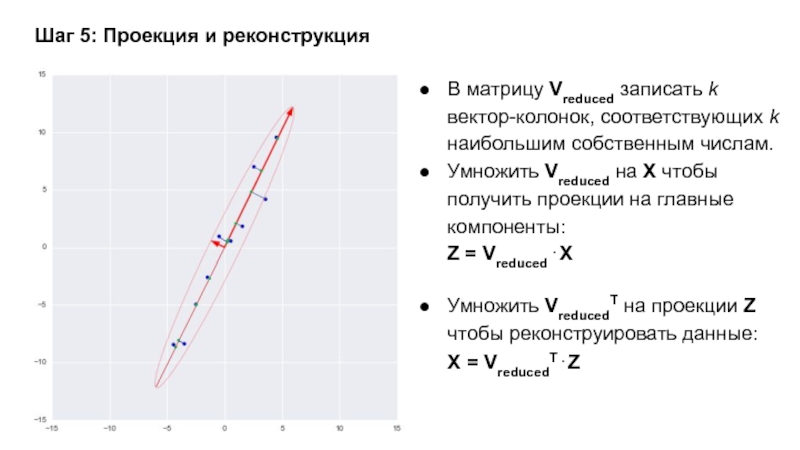

Слайд 12Шаг 5: Проекция и реконструкция

В матрицу Vreduced записать k вектор-колонок, соответствующих

Умножить Vreduced на X чтобы получить проекции на главные компоненты:

Z = Vreduced . X

Умножить VreducedT на проекции Z чтобы реконструировать данные:

X = VreducedT . Z

Слайд 17Почему такой плохой результат?

Линейная комбинация объектов датасета не является рукописной цифрой.

Значит

Слайд 18Нелинейные методы

Рассмотрим более простую модель и поставим задачу нелинейного понижения размерности:

Задача

При этом мы не ограничены линейными отображениями.

Слайд 19Гипотеза: малоразмерное представление сохраняет попарные расстояния между объектами.

-

- евклидово расстояние между малоразмерными представлениями

Многомерное шкалирование

Слайд 20

Функционал качества:

Ищем представления, апроксимирующие dij:

Алгоритм: SMACOF (Scaling by MAjorizing a COmplicated

- стресс-функция

Repeat

until

Слайд 21Stochastic Neighbour Embedding (SNE)

Гипотеза: В точности воспроизвести расстояния – слишком сложно.

Опишем объекты нормированными расстояниями до остальных объектов:

Слайд 22

Функционал качества:

Минимизируем разницу между распределениями расстояний с помощью дивергенции Кульбака-Лейблера:

Алгоритм: (Стохастический)

Repeat

until convergence

Слайд 23t-distributed SNE

Чем выше размерность пространства, тем меньше расстояния между парами точек

Это затрудняет точное сохранение пропорций в двух- или трехмерном пространстве.

Слайд 24Значит нужно меньше штрафовать за увеличение пропорций в маломерном пространстве.

Изменим распределение:

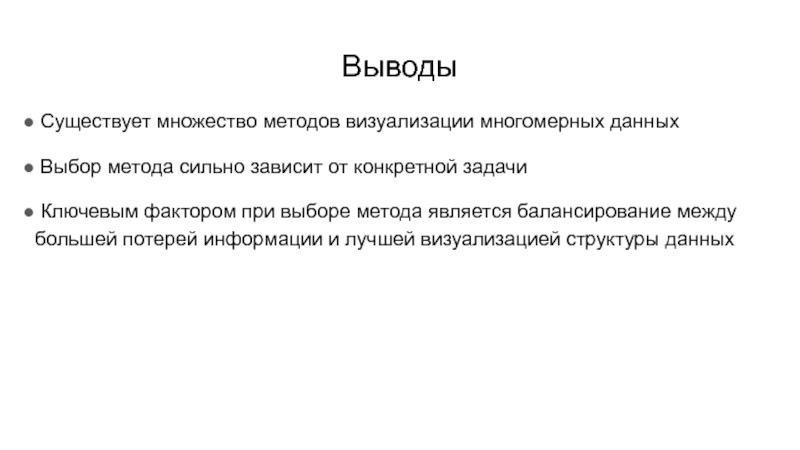

Слайд 27Выводы

Существует множество методов визуализации многомерных данных

Выбор метода сильно зависит

Ключевым фактором при выборе метода является балансирование между большей потерей информации и лучшей визуализацией структуры данных