- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

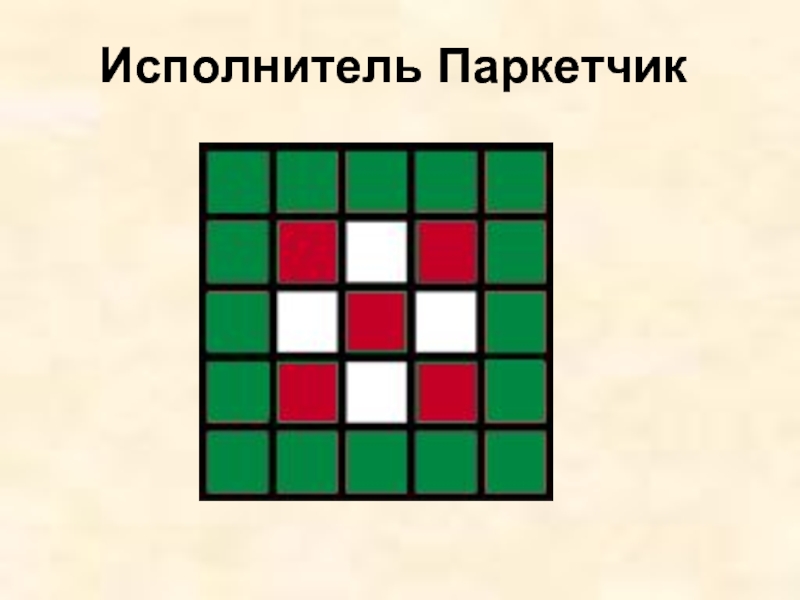

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Обобщенная модель множественной регрессии презентация

Содержание

- 1. Обобщенная модель множественной регрессии

- 2. 1. Мультиколлинеарность Под мультиколлинеарностью понимают высокую

- 3. В первом случае, по крайней мере, одна

- 4. В этом случае матрица

- 5. Чаще связь между объясняющими

- 6. Матрица

- 7. В итоге отметим

- 9. Точных количественных критериев для

- 10. Считается, что если в ней содержатся коэф-фициенты

- 11. Для оценки значимости мультиколлинеар-ности факторов можно использовать

- 12. Отсюда выдвигается гипотеза

- 13. Если мультиколлинеарность установлена, то каким

- 14. Самый простой из них

- 15. Другой метод заключается в

- 16. В следующем

- 17. Рис. 1

- 18. Например, при

- 19. Определитель матрицы увеличивается по

- 21. 2. Гетероскедастичность

- 24. Для обнаружения гетероскедастичности наиболее

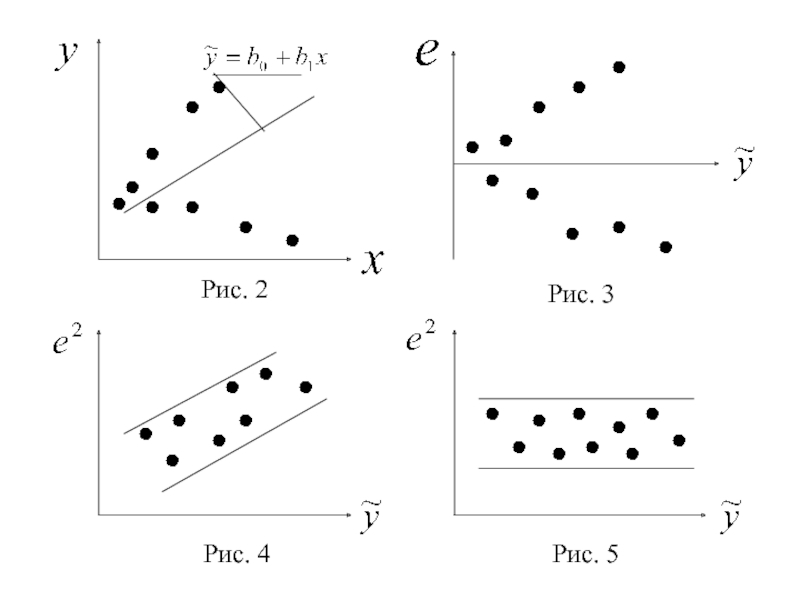

- 25. Рис. 4 Рис. 5

- 26. В некоторых случаях гетероскедастичность визуально не столь

- 27. Никаких дополнительных предположений относительно

- 28. Рассмотрим применение теста на

- 29. В итоге коэффициент

- 30. Поэтому, если

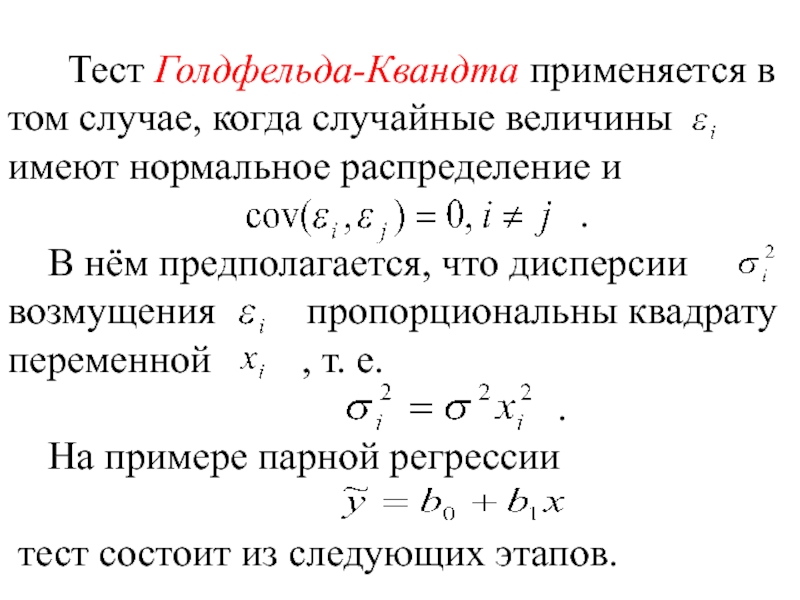

- 31. Тест Голдфельда-Квандта применяется в

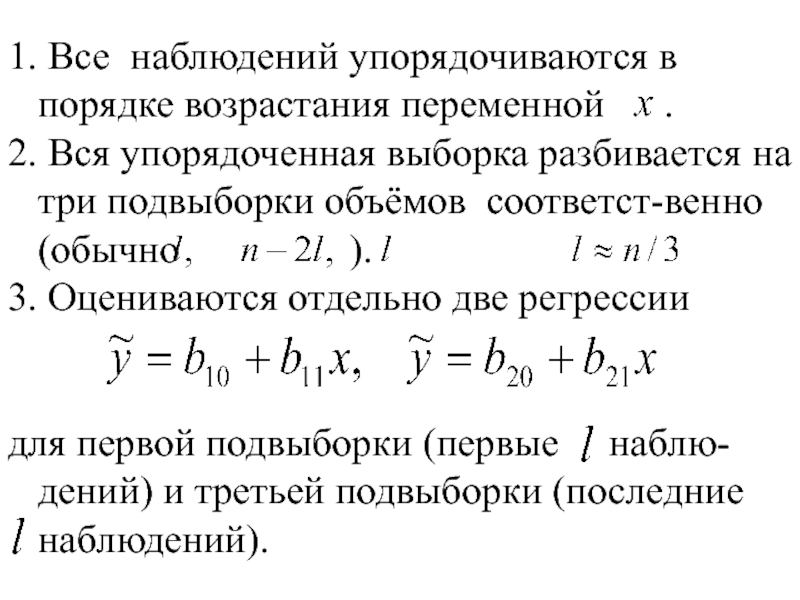

- 32. 1. Все наблюдений упорядочиваются в порядке возрастания

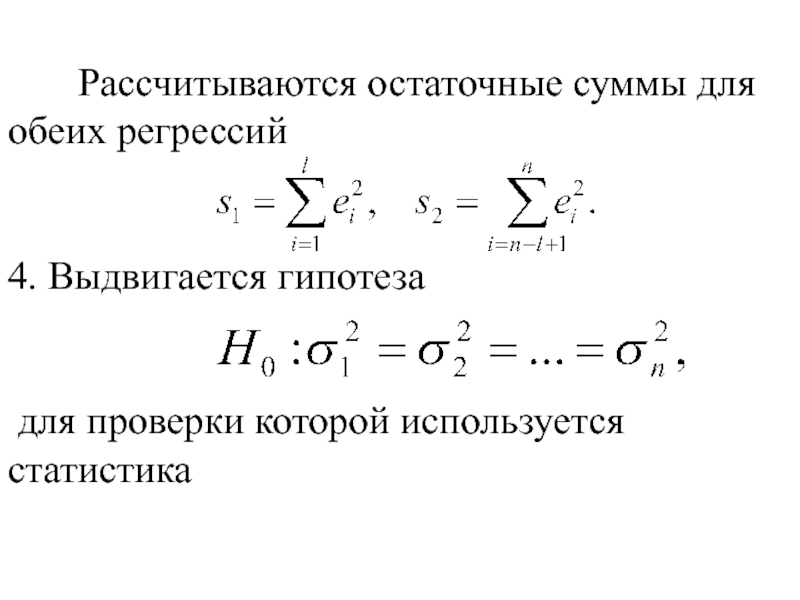

- 33. Рассчитываются остаточные суммы

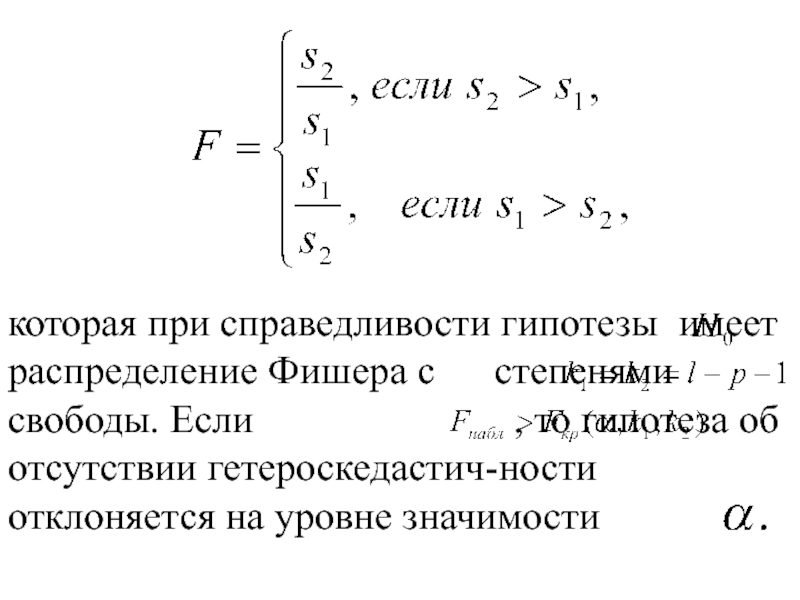

- 34. которая при справедливости гипотезы имеет

- 35. Если в модели более

- 36. Если дисперсии

- 37. Тогда

- 38. Очевидно, что для любого наблюдения

- 39. Уравнение (4) представляет собой взвешен-ную регрессию с

- 40. Здесь

- 41. На практике значения

- 42. тогда уравнение (3) преобразуется в гомоскедастичную модель

- 43. Если же предположить, что дисперсии

Слайд 1Лекция 4

Обобщенная модель множественной регрессии

1. Мультиколлинеарность

2. Гетероскедастичность

Слайд 21. Мультиколлинеарность

Под мультиколлинеарностью понимают высокую взаимную коррелированность объясняющих переменных.

Мультиколлинеарность может

Слайд 3В первом случае, по крайней мере, одна пара из объясняющих переменных

Слайд 4 В этом случае матрица

На практике строгая мультиколлинеар-ность встречается достаточно редко, т. к. её несложно избежать на стадии предва-рительного отбора факторов модели.

Слайд 5 Чаще связь между объясняющими переменными выражается в стохастичес-кой

В этом случае говорят о нестрогой мультиколлинеарности.

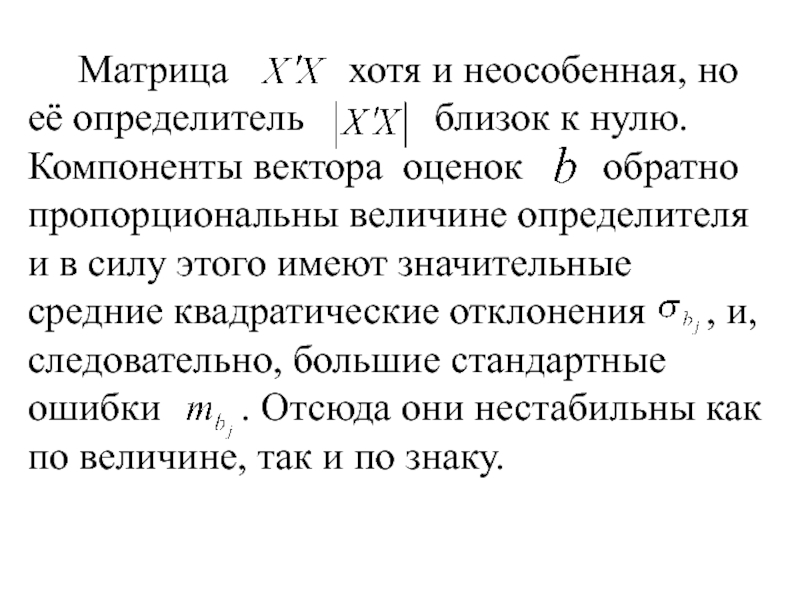

Слайд 6 Матрица хотя и

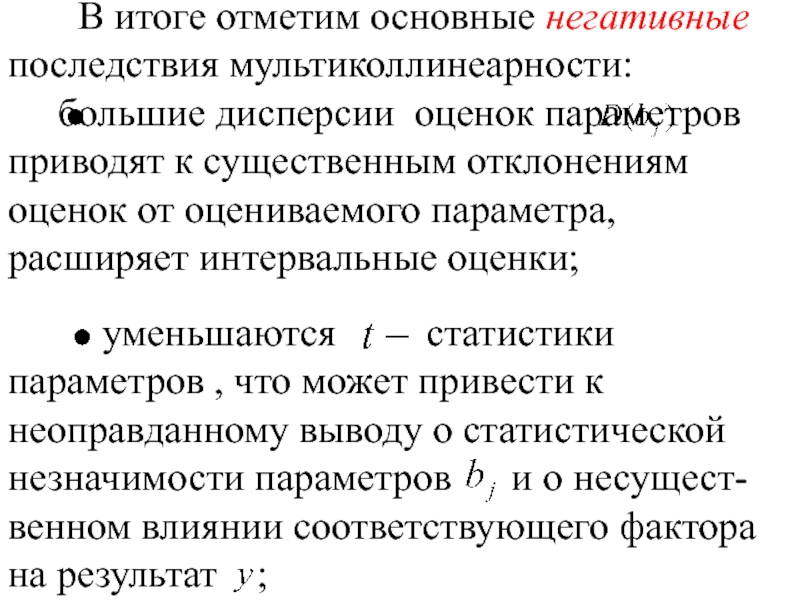

Слайд 7 В итоге отметим основные негативные последствия мультиколлинеарности:

уменьшаются статистики параметров , что может привести к неоправданному выводу о статистической незначимости параметров и о несущест-венном влиянии соответствующего фактора на результат ;

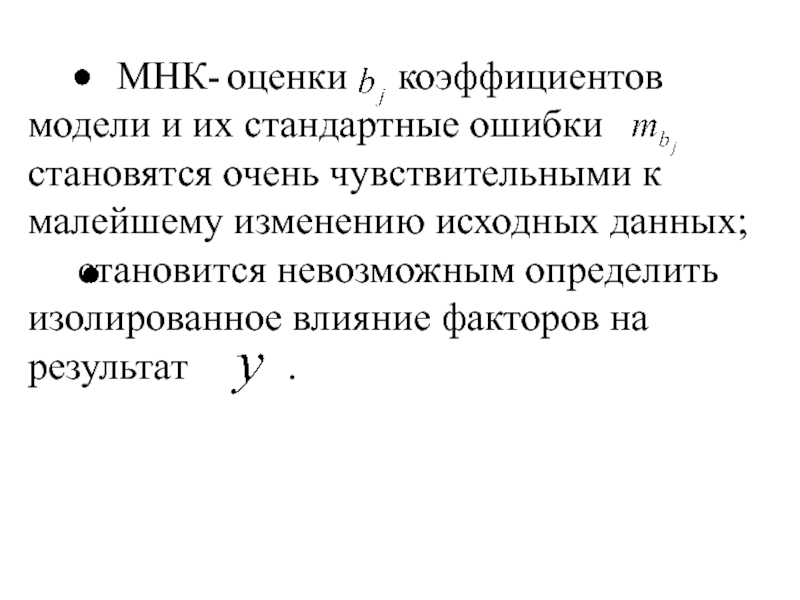

Слайд 8 МНК- оценки

становится невозможным определить изолированное влияние факторов на результат .

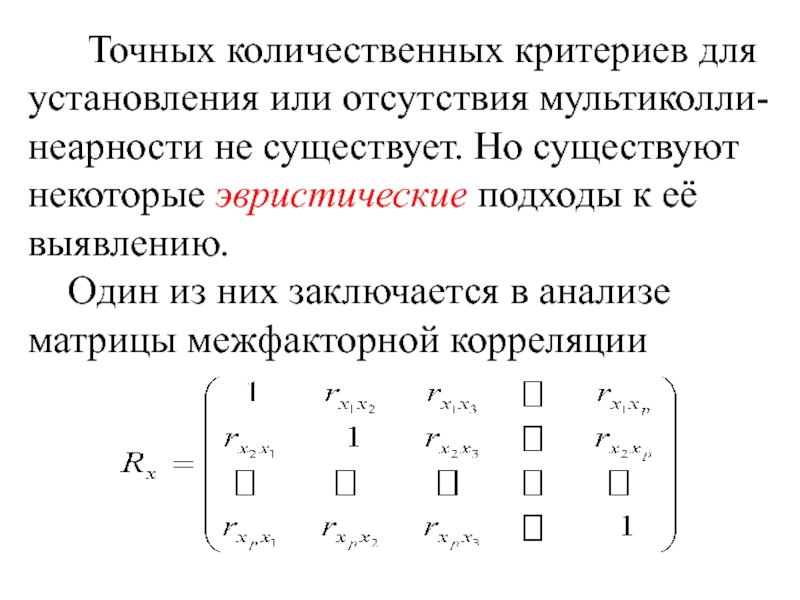

Слайд 9 Точных количественных критериев для установления или отсутствия мультиколли-неарности

Один из них заключается в анализе матрицы межфакторной корреляции

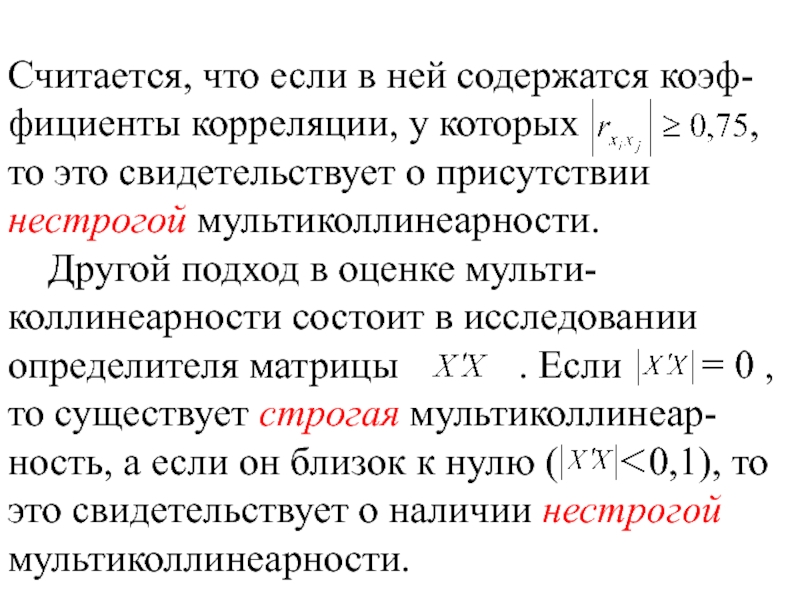

Слайд 10Считается, что если в ней содержатся коэф-фициенты корреляции, у которых

Другой подход в оценке мульти-коллинеарности состоит в исследовании определителя матрицы . Если = 0 , то существует строгая мультиколлинеар-ность, а если он близок к нулю ( 0,1), то это свидетельствует о наличии нестрогой мультиколлинеарности.

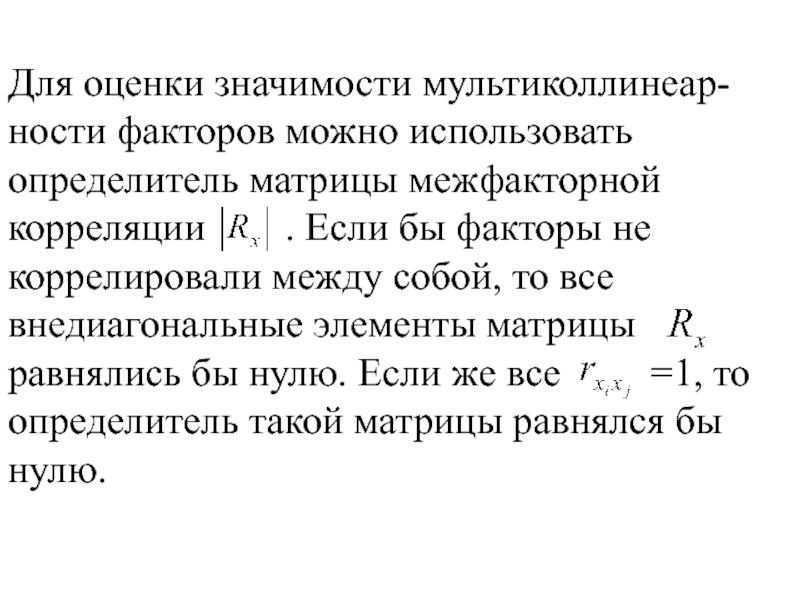

Слайд 11Для оценки значимости мультиколлинеар-ности факторов можно использовать определитель матрицы межфакторной корреляции

Слайд 12 Отсюда выдвигается гипотеза (отсутствие

имеет приближенное распределение «хи-квадрат» с степенями свободы.

Если , то гипотеза отклоняется и мультиколлинеарность факторов считается доказанной.

Слайд 13 Если мультиколлинеарность установлена, то каким образом её можно устранить?

Единого подхода к её устранению не существует, но используются ряд методов, которые применимы в конкретных ситуациях.

Слайд 14 Самый простой из них заключается в том, что

Но здесь нужна осторожность, чтобы не исключить переменную, которая необходима в уравнении по своей экономической сущ-ности, но зачастую коррелирует с другими факторами.

Слайд 15 Другой метод заключается в увеличении объёма выборки, если

Например, при использовании ежегодных данных можно перейти к поквартальным данным и объем выборки увеличится в 4 раза.

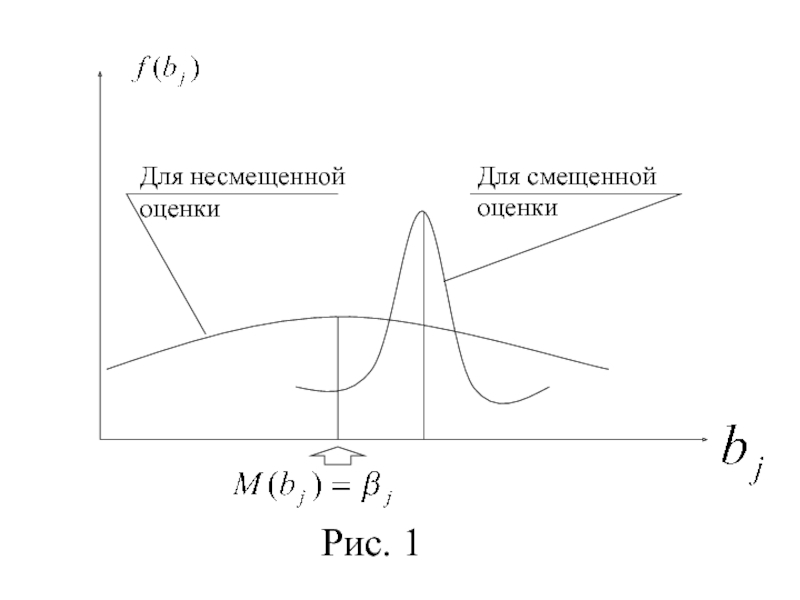

Слайд 16 В следующем методе переходят от несмещенных

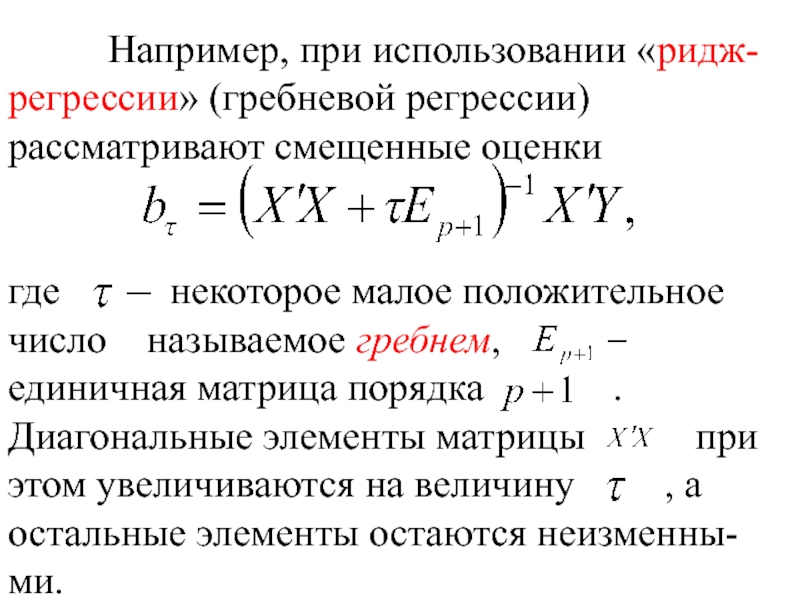

Слайд 18 Например, при использовании «ридж-

регрессии» (гребневой регрессии)

рассматривают

где некоторое малое положительное число называемое гребнем,

единичная матрица порядка . Диагональные элементы матрицы при этом увеличиваются на величину , а остальные элементы остаются неизменны-ми.

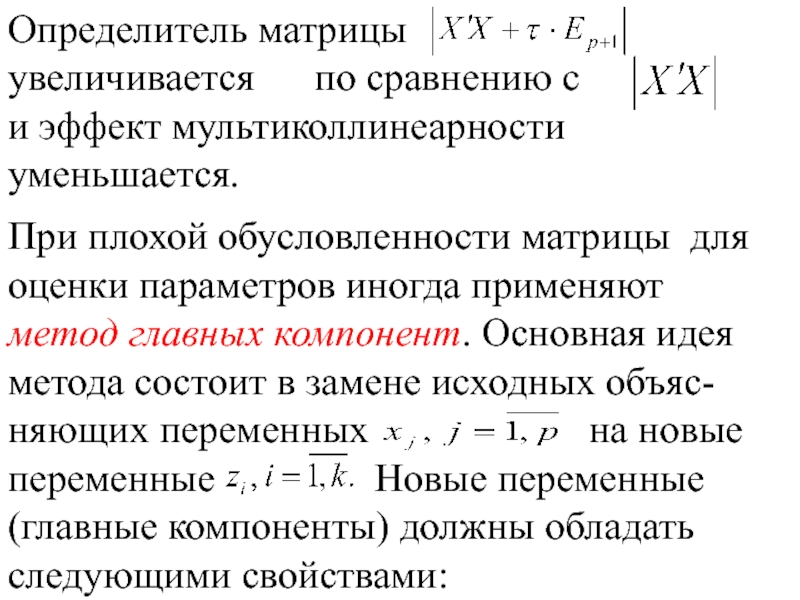

Слайд 19Определитель матрицы

увеличивается по сравнению с

и эффект мультиколлинеарности

При плохой обусловленности матрицы для оценки параметров иногда применяют метод главных компонент. Основная идея метода состоит в замене исходных объяс-няющих переменных на новые переменные Новые переменные (главные компоненты) должны обладать следующими свойствами:

Слайд 20 полная совокупность главных

главные компоненты должны быть ортогональны между собой, т. е. быть линейно-независимыми.

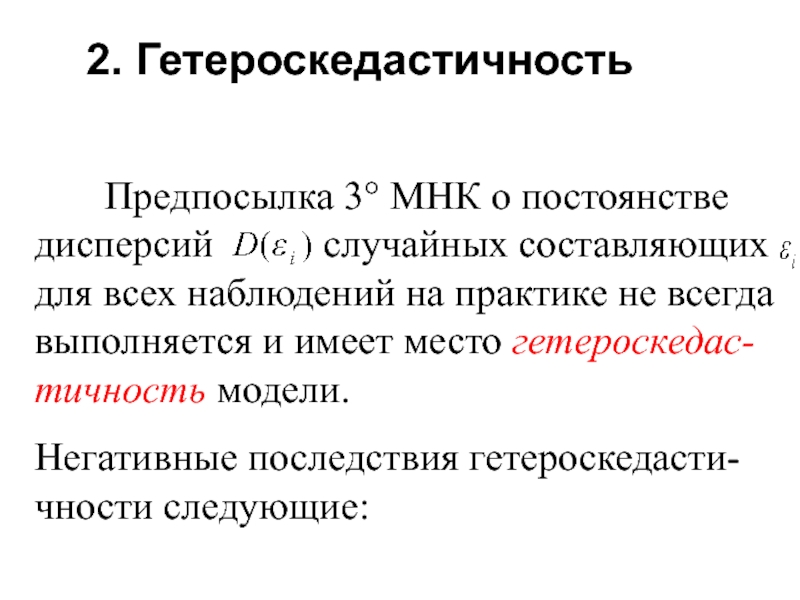

Слайд 212. Гетероскедастичность

Предпосылка 3° МНК о постоянстве

Негативные последствия гетероскедасти-чности следующие:

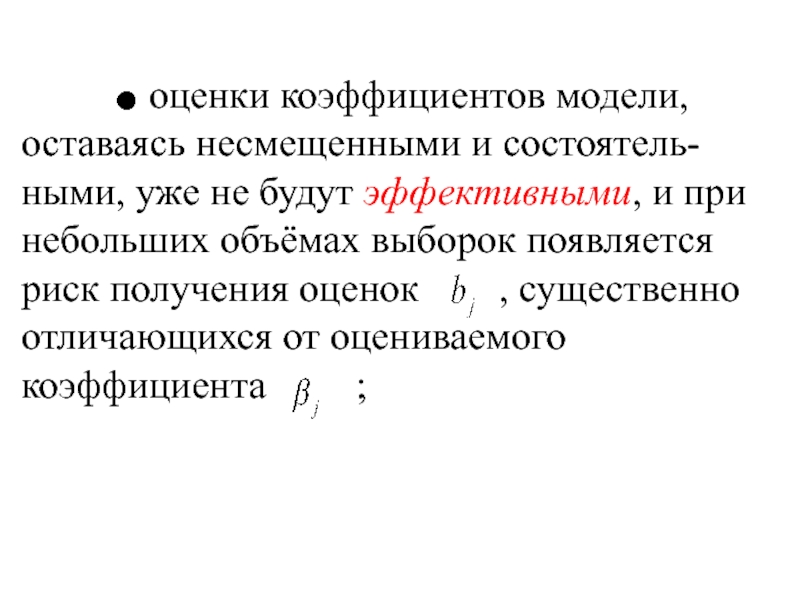

Слайд 22

Слайд 23 стандартные ошибки параметров ,

дисперсии оценок будут рассчитываться со смещением, что существенно влияет на интервальные оценки коэффициентов модели.

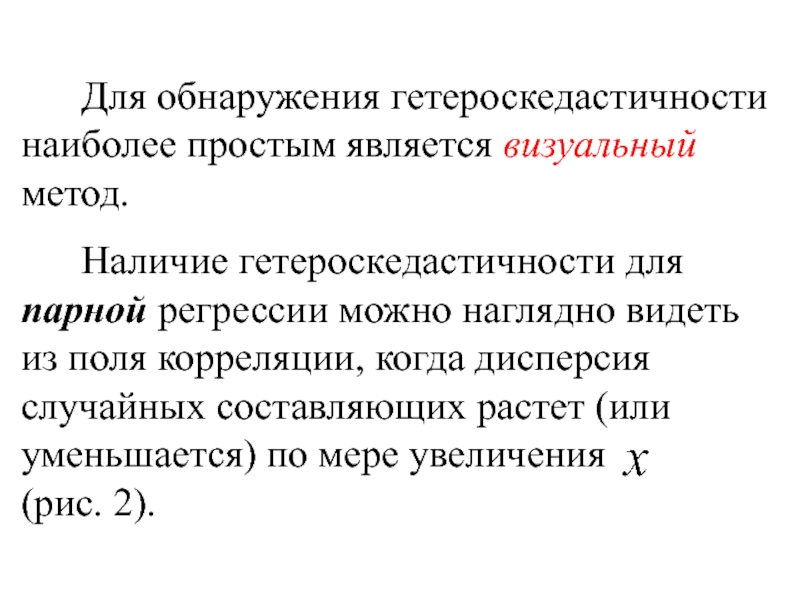

Слайд 24 Для обнаружения гетероскедастичности наиболее простым является визуальный метод.

Наличие гетероскедастичности для парной регрессии можно наглядно видеть из поля корреляции, когда дисперсия случайных составляющих растет (или уменьшается) по мере увеличения (рис. 2).

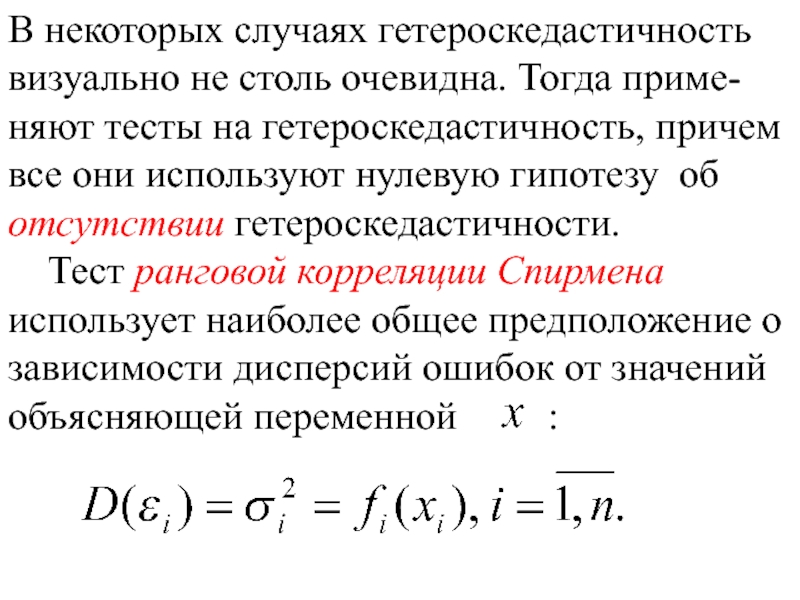

Слайд 26В некоторых случаях гетероскедастичность визуально не столь очевидна. Тогда приме-няют тесты

Тест ранговой корреляции Спирмена использует наиболее общее предположение о зависимости дисперсий ошибок от значений объясняющей переменной :

Слайд 27 Никаких дополнительных предположений относительно вида функций

Идея теста заключается в том, что является некоторой оценкой , и поэтому в случае гетероскедастичности значения и будут коррелировать.

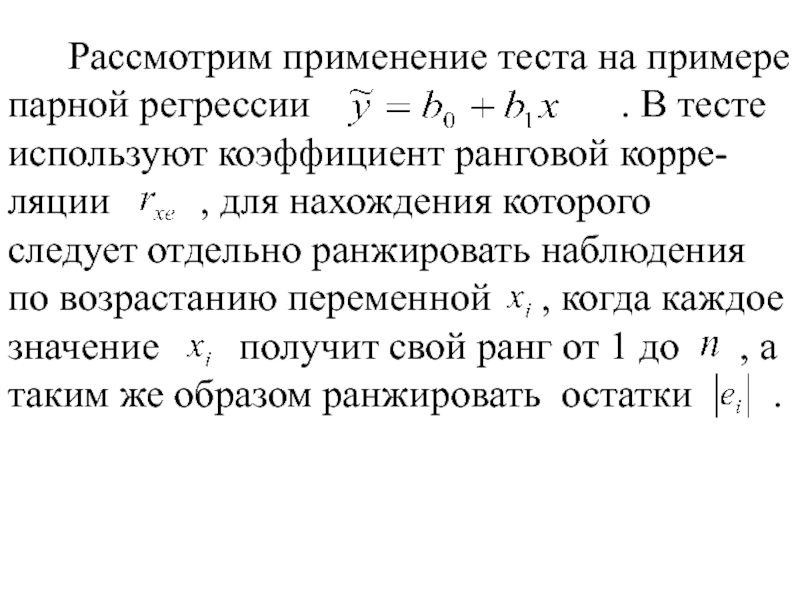

Слайд 28 Рассмотрим применение теста на примере парной регрессии

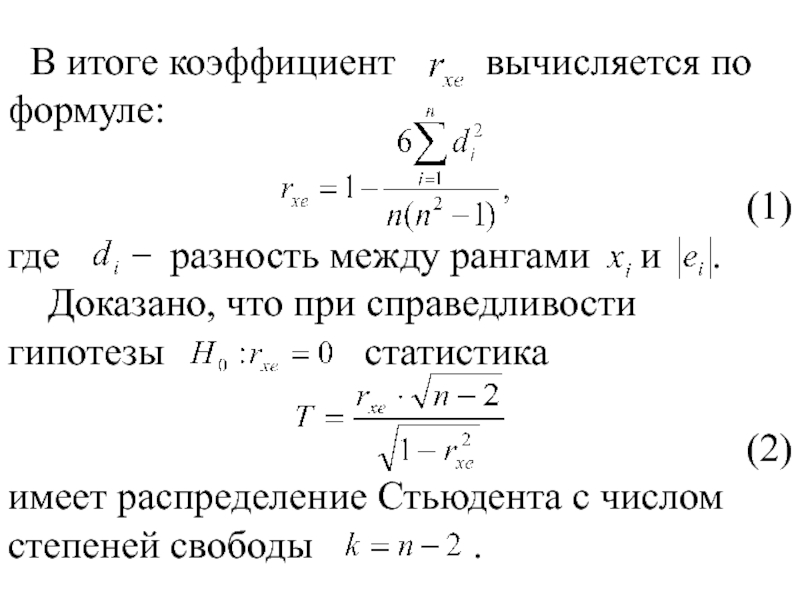

Слайд 29 В итоге коэффициент вычисляется по

(1)

где разность между рангами и .

Доказано, что при справедливости гипотезы статистика

(2)

имеет распределение Стьюдента с числом степеней свободы .

Слайд 30Поэтому, если превышает

Для множественной регрессии проверка гипотезы с помощью статис-тики (2) может выполняться по каждому фактору отдельно.

Слайд 31 Тест Голдфельда-Квандта применяется в том случае, когда случайные

.

В нём предполагается, что дисперсии возмущения пропорциональны квадрату переменной , т. е.

.

На примере парной регрессии

тест состоит из следующих этапов.

Слайд 321. Все наблюдений упорядочиваются в порядке возрастания переменной .

2.

3. Оцениваются отдельно две регрессии

для первой подвыборки (первые наблю-дений) и третьей подвыборки (последние наблюдений).

Слайд 33 Рассчитываются остаточные суммы для обеих регрессий

4. Выдвигается

для проверки которой используется статистика

Слайд 34

которая при справедливости гипотезы имеет распределение Фишера с степенями

Слайд 35 Если в модели более одного фактора, то выборка

При установлении гетероскедастичности возникает необходимость преобразования модели с целью устранения данного недостатка.

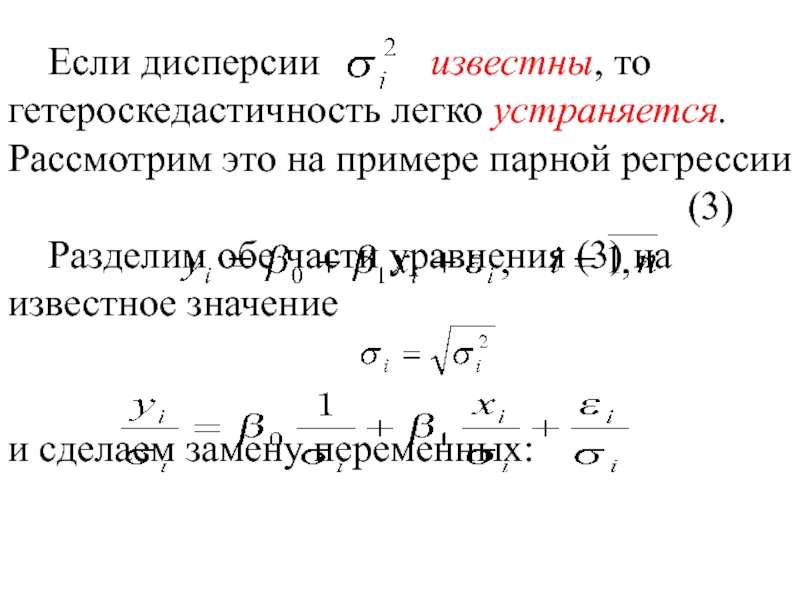

Слайд 36 Если дисперсии известны, то

(3)

Разделим обе части уравнения (3) на известное значение

и сделаем замену переменных:

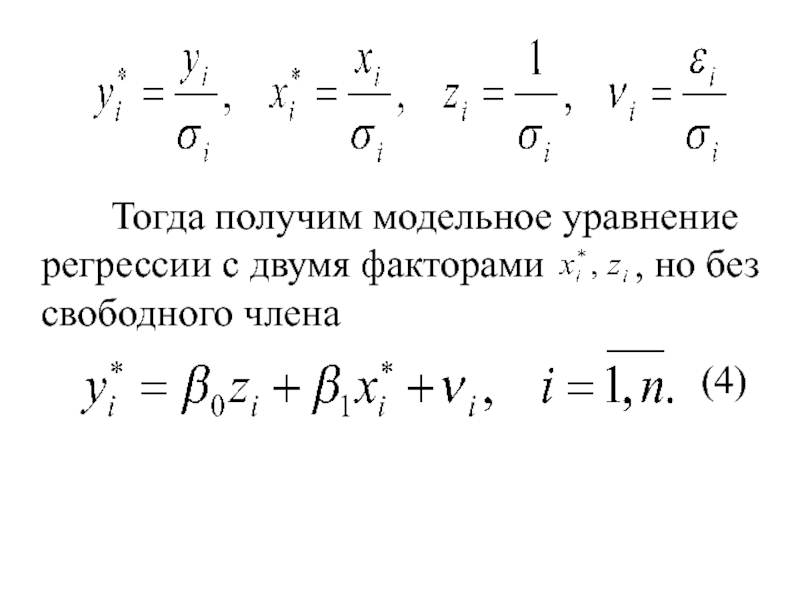

Слайд 37

Тогда получим модельное уравнение регрессии с двумя

(4)

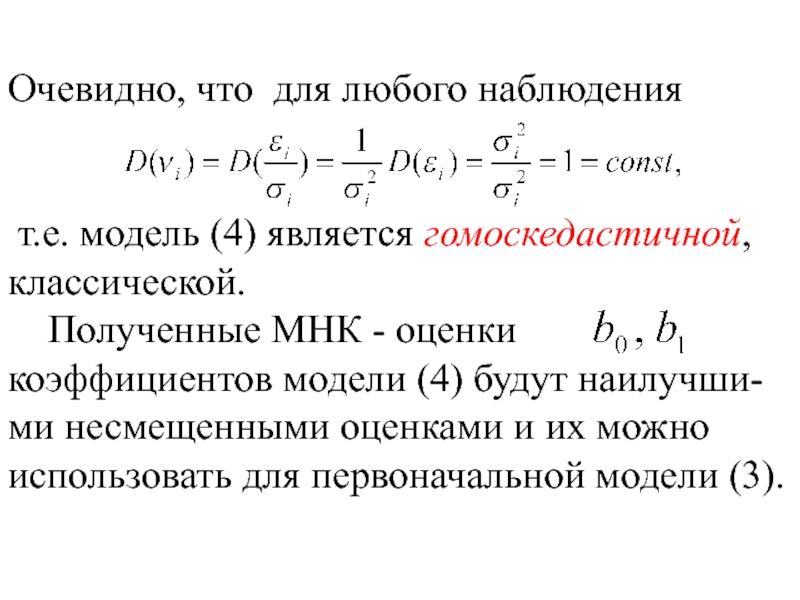

Слайд 38Очевидно, что для любого наблюдения

т.е. модель (4) является гомоскедастичной, классической.

Полученные МНК - оценки коэффициентов модели (4) будут наилучши-ми несмещенными оценками и их можно использовать для первоначальной модели (3).

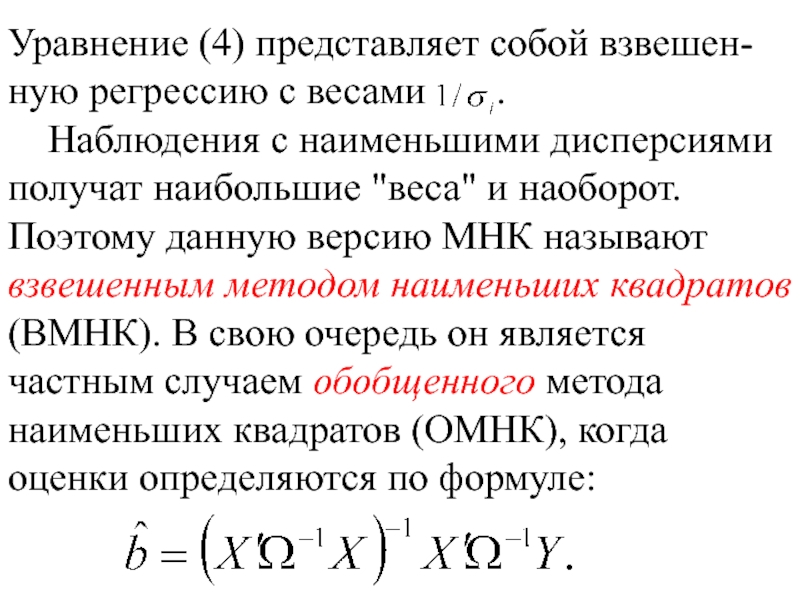

Слайд 39Уравнение (4) представляет собой взвешен-ную регрессию с весами

Наблюдения с наименьшими дисперсиями получат наибольшие "веса" и наоборот. Поэтому данную версию МНК называют взвешенным методом наименьших квадратов (ВМНК). В свою очередь он является частным случаем обобщенного метода наименьших квадратов (ОМНК), когда оценки определяются по формуле:

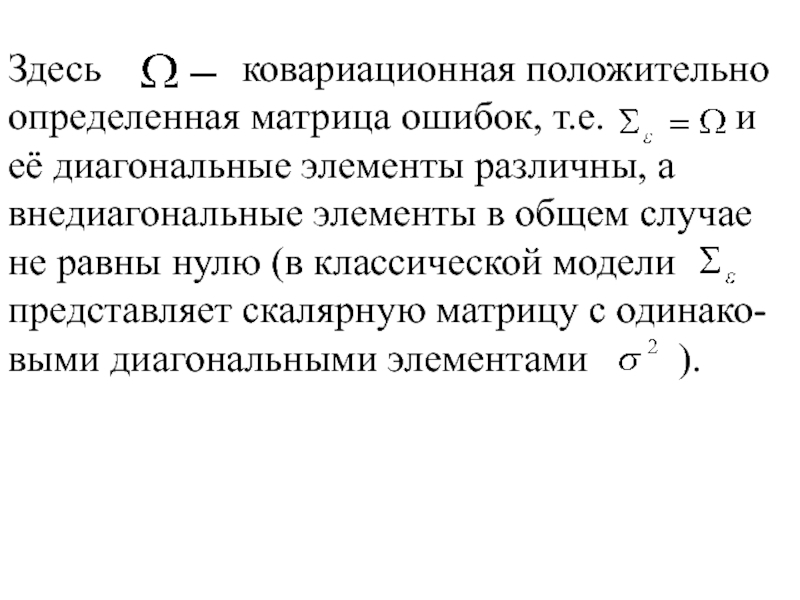

Слайд 40Здесь ковариационная положительно определенная матрица

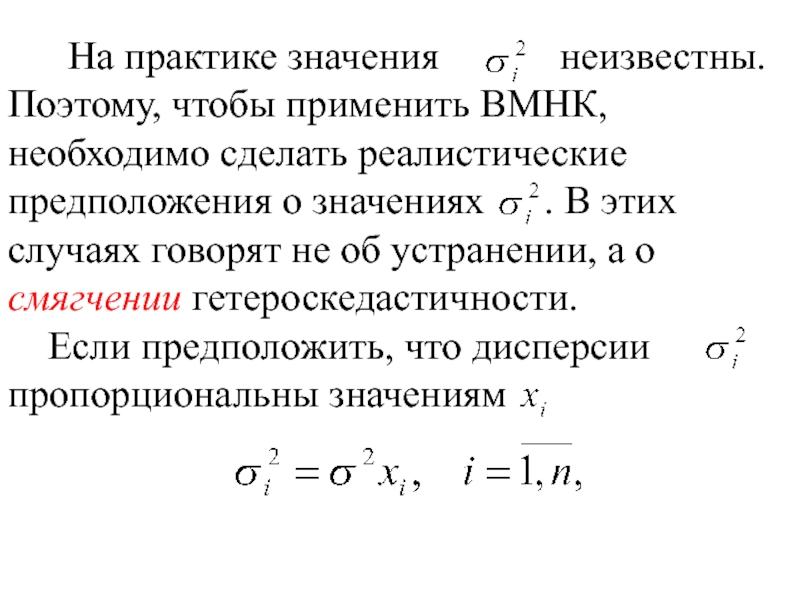

Слайд 41 На практике значения

Если предположить, что дисперсии пропорциональны значениям

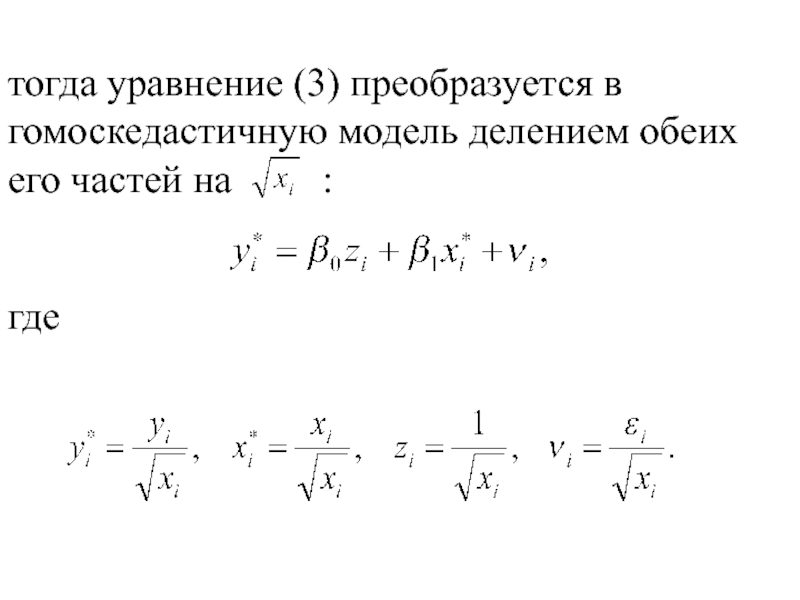

Слайд 42тогда уравнение (3) преобразуется в гомоскедастичную модель делением обеих его частей

где

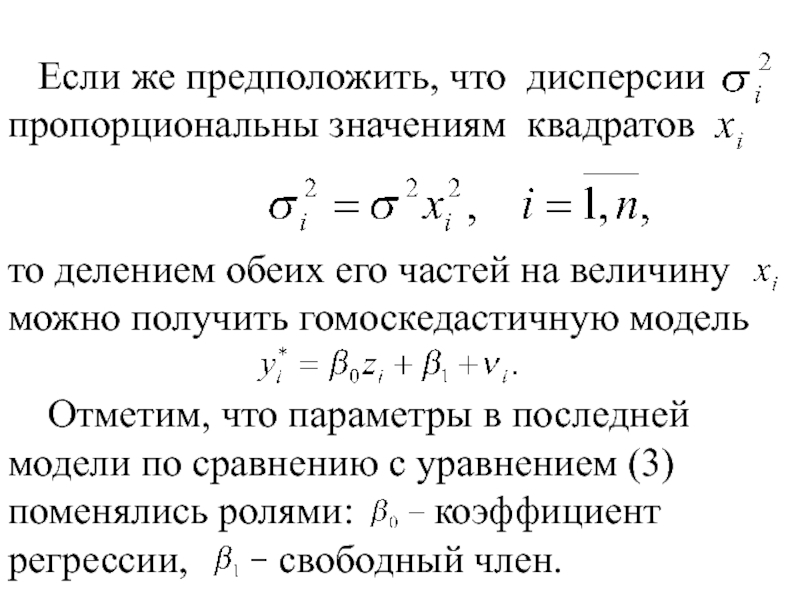

Слайд 43 Если же предположить, что дисперсии пропорциональны значениям квадратов

то делением обеих его частей на величину можно получить гомоскедастичную модель

Отметим, что параметры в последней модели по сравнению с уравнением (3) поменялись ролями: коэффициент регрессии, свободный член.