- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Мультиколлинеарность. Строгая и нестрогая мультиколлинеарность презентация

Содержание

- 1. Мультиколлинеарность. Строгая и нестрогая мультиколлинеарность

- 2. Мультиколлинеарность - тесная корреляционная взаимосвязь между отбираемыми

- 3. Виды мультиколлинеарности. Строгая и нестрогая мультиколлинеарность Строгая

- 4. Полная мультиколлинеарность соответствует случаю, когда

- 5. Корреляционные связи есть всегда. Проблема мультиколлинеарности -

- 6. Мультиколлинеарность проявляется в совместном действии факторов: 1.

- 7. В экономических исследованиях мультиколлинеарность чаще проявляется в

- 8. ВНИМАНИЕ! Рассматриваемые в презентации примеры можно

- 9. Рекомендуемая литература по теме

- 10. Обнаружение мультиколлинеарности Один из подходов заключается в

- 11. ПРИМЕР. Задача состоит в построении модели для

- 12. Обнаружение мультиколлинеарности Высокие коэффициенты детерминации и F-статистика,

- 13. Обнаружение мультиколлинеарности. Анализ матрицы коэффициентов парной корреляции

- 14. Обнаружение мультиколлинеарности Тест Фаррара–Глоубера

- 15. Обнаружение мультиколлинеарности Тест Фаррара–Глоубера (1) Проверка

- 16. Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (1) Проверка наличия

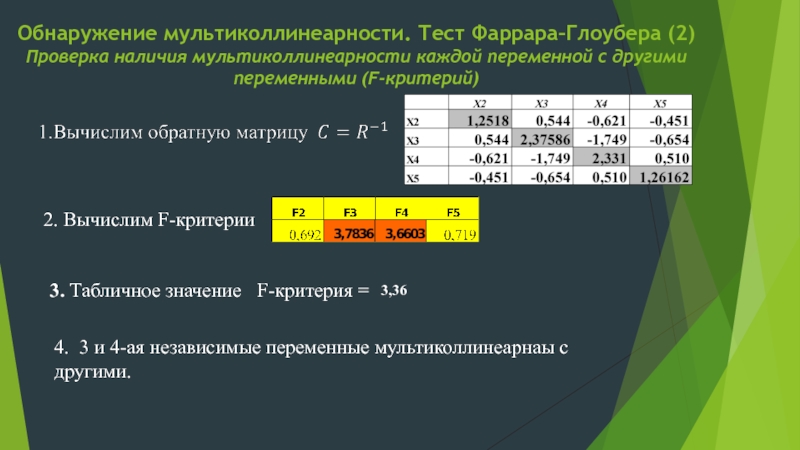

- 17. Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (2) Проверка наличия

- 18. Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (2) Проверка наличия

- 19. Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (3) Проверка наличия мультиколлинеарности каждой пары переменных (t-тест).

- 20. Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (3) Проверка наличия

- 21. Фактор инфляции вариации как оценка эффекта мультиколлинеарности

- 22. Обнаружение мультиколлинеарности. Метод инфляционных факторов Алгоритм метода

- 23. Минимальное возможное значение = 1.0

- 24. Обнаружение мультиколлинеарности. Метод Белсли. Для определения мультиколлинеарности

- 25. Методы устранения мультиколлинеарности Изменить или увеличить выборку.

Слайд 2Мультиколлинеарность - тесная корреляционная взаимосвязь между отбираемыми для анализа факторами, совместно

Слайд 3Виды мультиколлинеарности. Строгая и нестрогая мультиколлинеарность

Строгая (полная, функциональная) мультиколлинеарность - наличие

2. Нестрогая мультиколлинеарность - наличие сильной линейной корреляционной связи между объясняющими переменными .

3. Чем ближе мультиколлинеарность к строгой

(совершенной), тем серьезнее ее последствия

Слайд 4 Полная мультиколлинеарность соответствует случаю, когда предположение, что матрица

Это приводит к невозможности решения соответствующей системы нормальных уравнений и получения оценок параметров регрессионной модели.

Слайд 5Корреляционные связи есть всегда. Проблема мультиколлинеарности - сила проявления корреляционных связей.

2.

3. Строгая мультиколлинеарность делает построение регрессии невозможным. (Согласно теоремы Кронекера-Капелли система уравнений имеет бесчисленное множество решений).

Слайд 6Мультиколлинеарность проявляется в совместном действии факторов:

1. Построить модель - значит определить

2. Если два или более фактора изменяются только совместно, их вклад по отдельности становится невозможно различить.

3. Чем более сильно коррелированны переменные, тем труднее различить их вклад.

Слайд 7В экономических исследованиях мультиколлинеарность чаще проявляется в нестрогой (стохастической) форме, когда

Слайд 8ВНИМАНИЕ!

Рассматриваемые в презентации примеры можно найти в

«Экономико-математические методы и

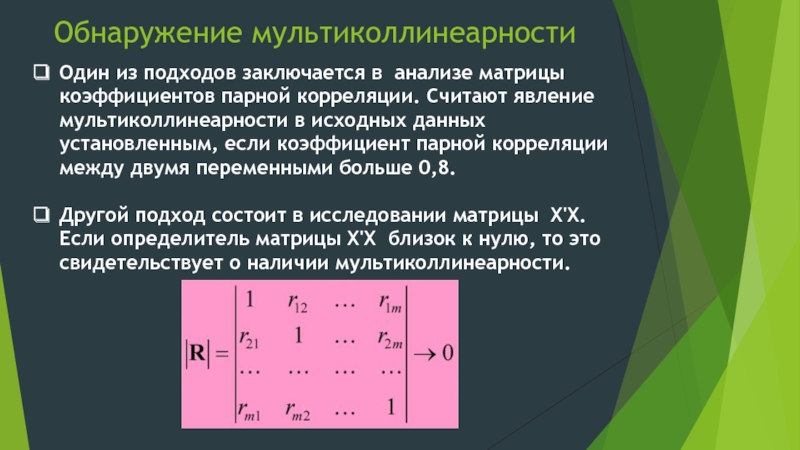

Слайд 10Обнаружение мультиколлинеарности

Один из подходов заключается в анализе матрицы коэффициентов парной корреляции.

Другой подход состоит в исследовании матрицы Х'Х. Если определитель матрицы Х'Х близок к нулю, то это свидетельствует о наличии мультиколлинеарности.

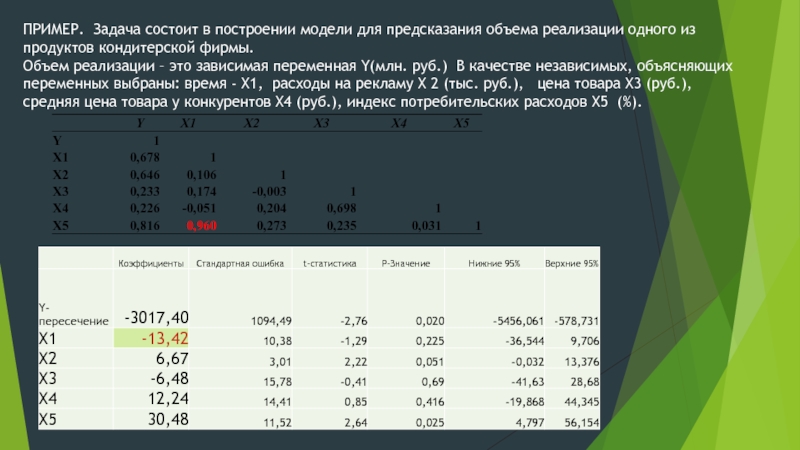

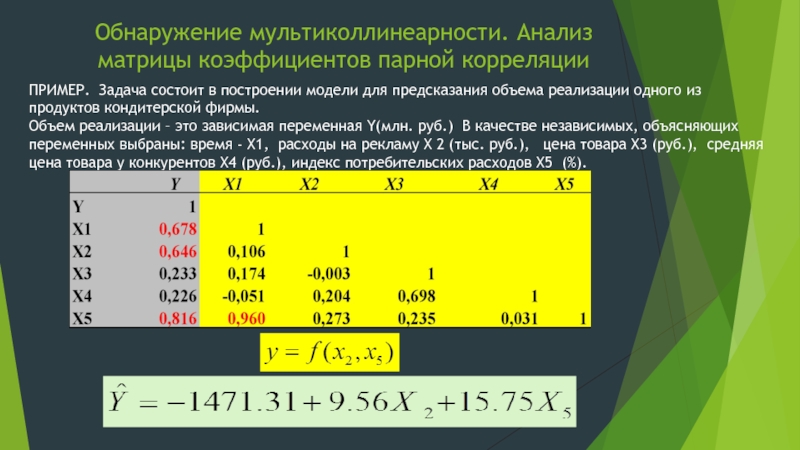

Слайд 11ПРИМЕР. Задача состоит в построении модели для предсказания объема реализации одного

Объем реализации – это зависимая переменная Y(млн. руб.) В качестве независимых, объясняющих переменных выбраны: время - X1, расходы на рекламу X 2 (тыс. руб.), цена товара X3 (руб.), средняя цена товара у конкурентов X4 (руб.), индекс потребительских расходов X5 (%).

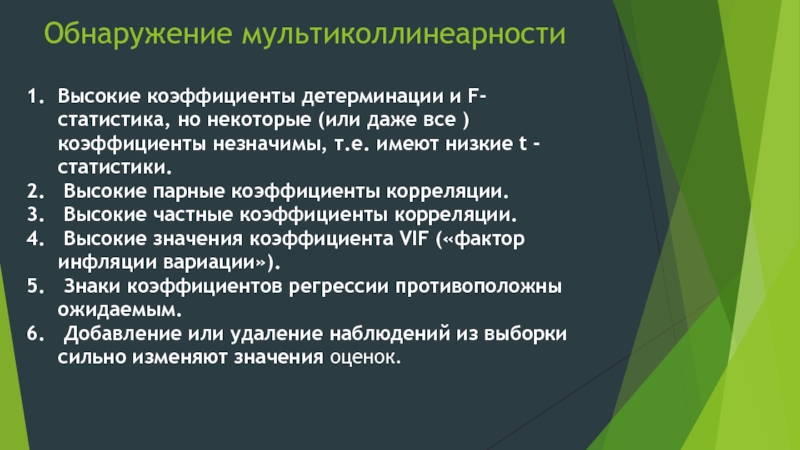

Слайд 12Обнаружение мультиколлинеарности

Высокие коэффициенты детерминации и F-статистика, но некоторые (или даже все

Высокие парные коэффициенты корреляции.

Высокие частные коэффициенты корреляции.

Высокие значения коэффициента VIF («фактор инфляции вариации»).

Знаки коэффициентов регрессии противоположны ожидаемым.

Добавление или удаление наблюдений из выборки сильно изменяют значения оценок.

Слайд 13Обнаружение мультиколлинеарности. Анализ матрицы коэффициентов парной корреляции

ПРИМЕР. Задача состоит в построении

Объем реализации – это зависимая переменная Y(млн. руб.) В качестве независимых, объясняющих переменных выбраны: время - X1, расходы на рекламу X 2 (тыс. руб.), цена товара X3 (руб.), средняя цена товара у конкурентов X4 (руб.), индекс потребительских расходов X5 (%).

Слайд 14Обнаружение мультиколлинеарности

Тест Фаррара–Глоубера

Этот алгоритм содержит три вида статистических

1) всего массива переменных (критерий «хи-квадрат»);

2) каждой переменной с другими переменными (F-критерий);

3) каждой пары переменных (t-тест).

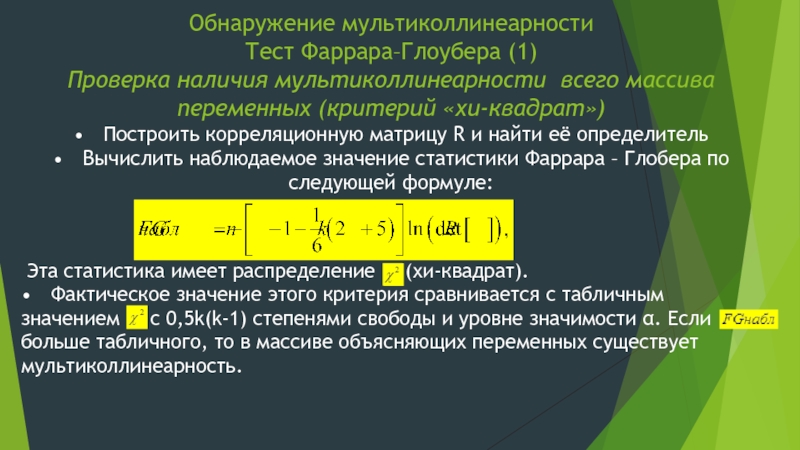

Слайд 15Обнаружение мультиколлинеарности Тест Фаррара–Глоубера (1) Проверка наличия мультиколлинеарности всего массива переменных (критерий

Эта статистика имеет распределение (хи-квадрат).

• Фактическое значение этого критерия сравнивается с табличным значением с 0,5k(k-1) степенями свободы и уровне значимости α. Если больше табличного, то в массиве объясняющих переменных существует мультиколлинеарность.

Слайд 16Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (1)

Проверка наличия мультиколлинеарности всего массива переменных

Вычислим определитель

FGнабл > FGкрит=12,59 Hо отклоняется, факторы признаются коллинеарными

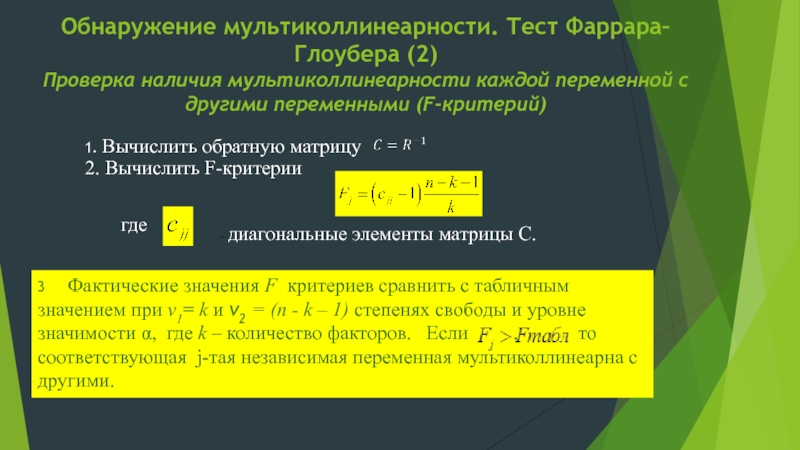

Слайд 17Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (2) Проверка наличия мультиколлинеарности каждой переменной с другими

1. Вычислить обратную матрицу

2. Вычислить F-критерии

где

– диагональные элементы матрицы C.

3 Фактические значения F критериев сравнить с табличным значением при ν1= k и ν2 = (n - k – 1) степенях свободы и уровне значимости α, где k – количество факторов. Если , то соответствующая j-тая независимая переменная мультиколлинеарна с другими.

Слайд 18Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (2) Проверка наличия мультиколлинеарности каждой переменной с другими

2. Вычислим F-критерии

3. Табличное значение

F-критерия =

3,36

4. 3 и 4-ая независимые переменные мультиколлинеарнаы с другими.

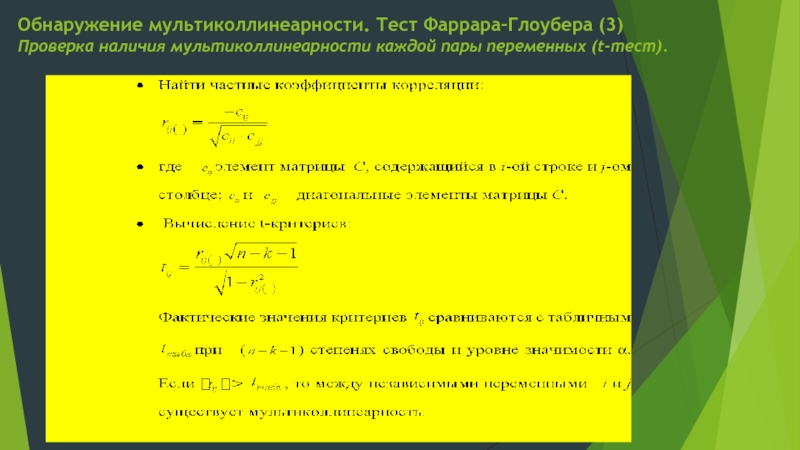

Слайд 19Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (3)

Проверка наличия мультиколлинеарности каждой пары переменных (t-тест).

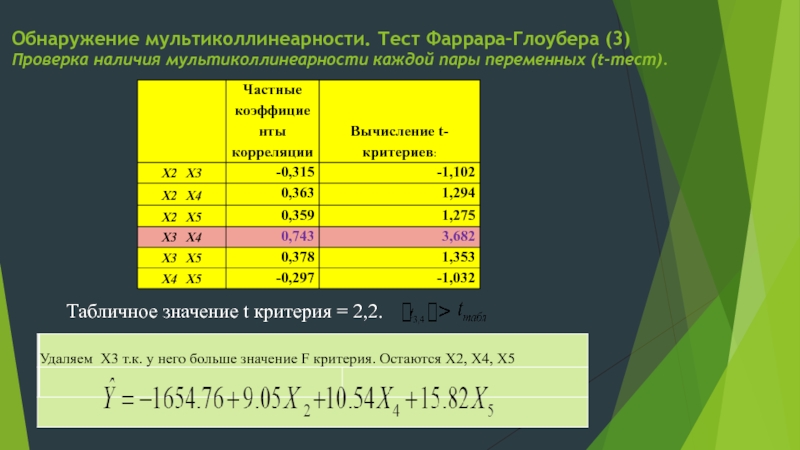

Слайд 20Обнаружение мультиколлинеарности. Тест Фаррара–Глоубера (3)

Проверка наличия мультиколлинеарности каждой пары переменных (t-тест).

Табличное

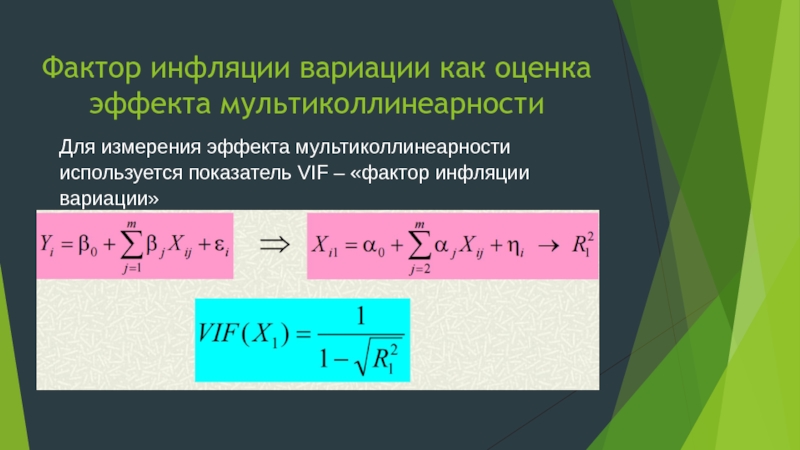

Слайд 21Фактор инфляции вариации как оценка эффекта мультиколлинеарности

Для измерения эффекта мультиколлинеарности используется

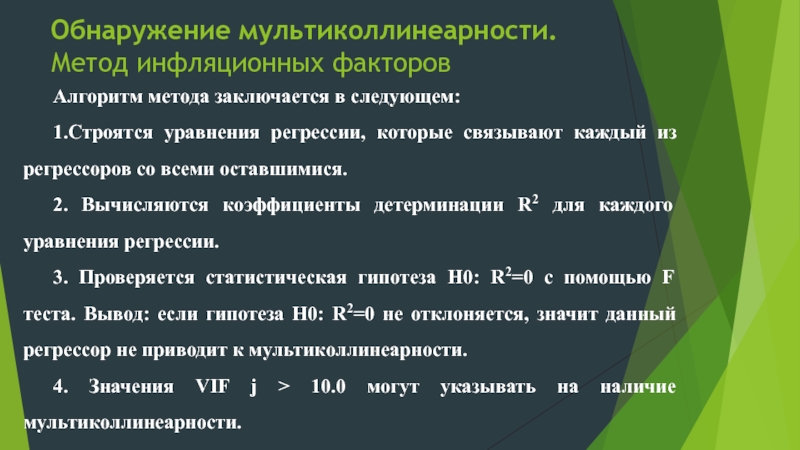

Слайд 22Обнаружение мультиколлинеарности. Метод инфляционных факторов

Алгоритм метода заключается в следующем:

1.Строятся уравнения

2. Вычисляются коэффициенты детерминации R2 для каждого уравнения регрессии.

3. Проверяется статистическая гипотеза H0: R2=0 с помощью F теста. Вывод: если гипотеза H0: R2=0 не отклоняется, значит данный регрессор не приводит к мультиколлинеарности.

4. Значения VIF j > 10.0 могут указывать на наличие мультиколлинеарности.

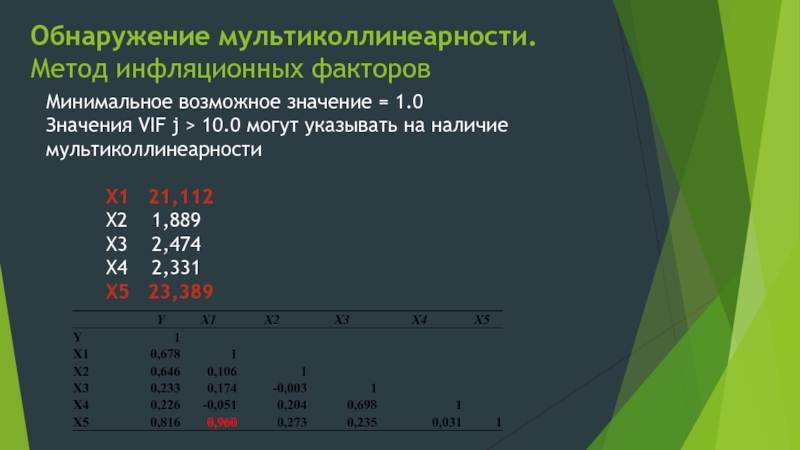

Слайд 23

Минимальное возможное значение = 1.0

Значения VIF j > 10.0 могут указывать

X1 21,112

X2 1,889

X3 2,474

X4 2,331

X5 23,389

Обнаружение мультиколлинеарности. Метод инфляционных факторов

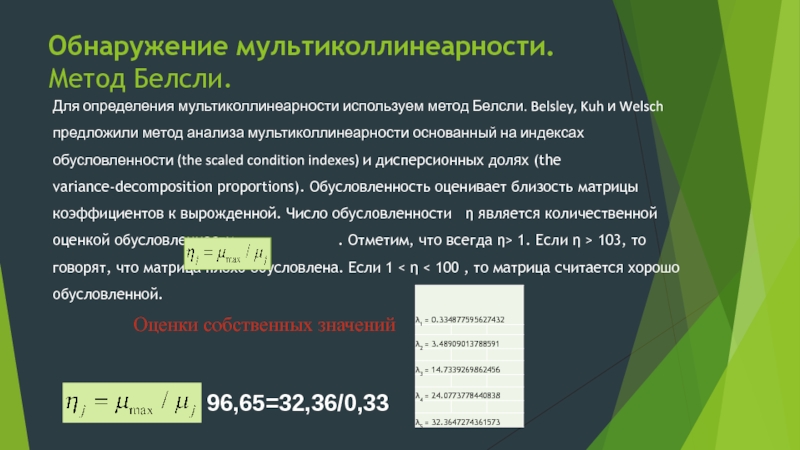

Слайд 24Обнаружение мультиколлинеарности. Метод Белсли.

Для определения мультиколлинеарности используем метод Белсли. Belsley, Kuh

Оценки собственных значений

96,65=32,36/0,33

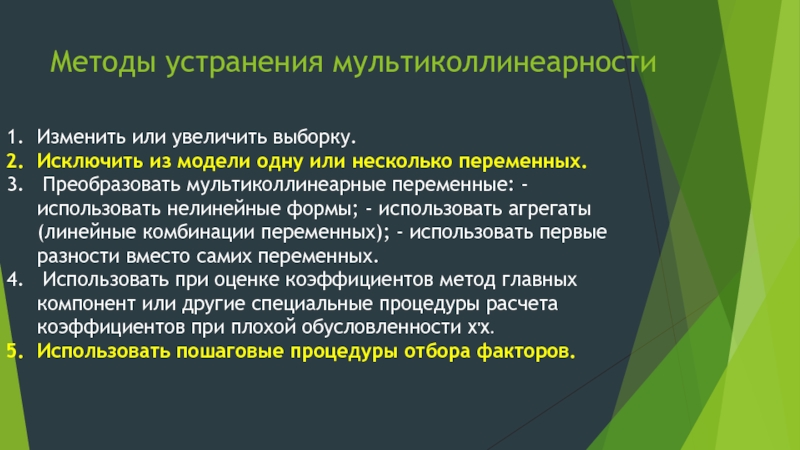

Слайд 25Методы устранения мультиколлинеарности

Изменить или увеличить выборку.

Исключить из модели одну или несколько

Преобразовать мультиколлинеарные переменные: - использовать нелинейные формы; - использовать агрегаты (линейные комбинации переменных); - использовать первые разности вместо самих переменных.

Использовать при оценке коэффициентов метод главных компонент или другие специальные процедуры расчета коэффициентов при плохой обусловленности Х'Х.

Использовать пошаговые процедуры отбора факторов.