- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Измерение информации. Информационная характеристика источника двоичных сообщений презентация

Содержание

- 1. Измерение информации. Информационная характеристика источника двоичных сообщений

- 2. Введение Измерение – нахождение значения физической величины

- 3. Введение Рис. 1.1 Меры информации

- 4. Введение В синтаксическом подходе выделяют: Структурная теория

- 5. 1.1. Синтаксические меры информации. Структурная теория. При

- 6. 1.1.1. Геометрическая мера Определение количества информации геометрическим

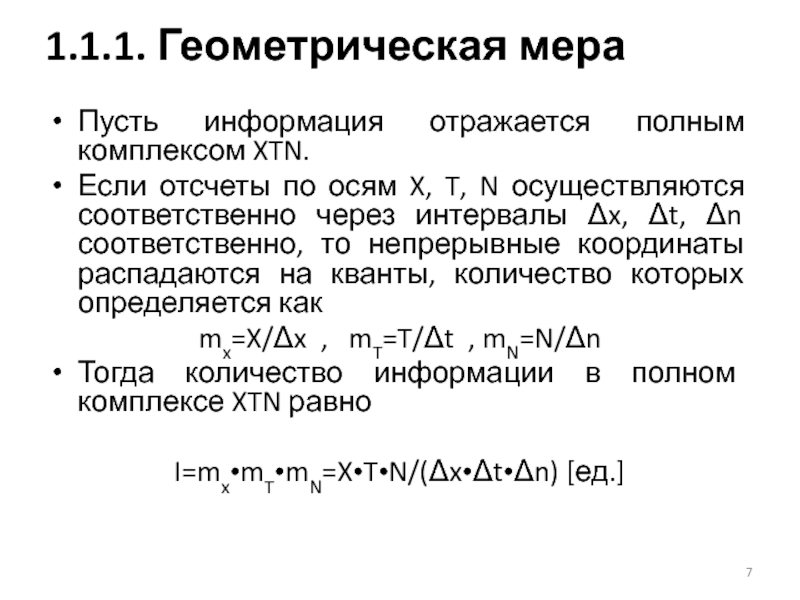

- 7. Пусть информация отражается полным комплексом XTN. Если

- 8. К этой мере целесообразно прибегать тогда, когда

- 9. В комбинаторике рассматривают различные виды соединения из

- 10. Количество информации в комбинаторной мере вычисляется как

- 11. Например, при сочетаниях из n=10 по m=0,

- 12. Не всегда все возможные комбинации составляют действительные

- 13. Из теории вероятностей: Проводится некий опыт, исход

- 14. Из теории вероятностей: Меру случайности называют вероятностью

- 15. Из теории вероятностей: Событие A называется независимым

- 16. Из теории вероятностей: События A и B

- 17. Из теории вероятностей: Суммой событий A и

- 18. Из теории вероятностей: Совокупность событий составляют полную

- 19. Рассмотрим 2 независимых опыта с числом равновероятных

- 20. Искомая функция f(*) должна удовлетворять условию:

- 21. В зависимости от выбора основания логарифма получаем

- 22. Иной подход к выводу формулы Хартли: Пусть

- 23. В случае, когда все N состояний равновероятны,

- 24. При статистическом (вероятностном) подходе информация рассматривается как

- 25. Последовательность знаков с таким свойством называется шенноновским

- 26. Упорядоченным называется состояние системы, осуществляемое относительно малым

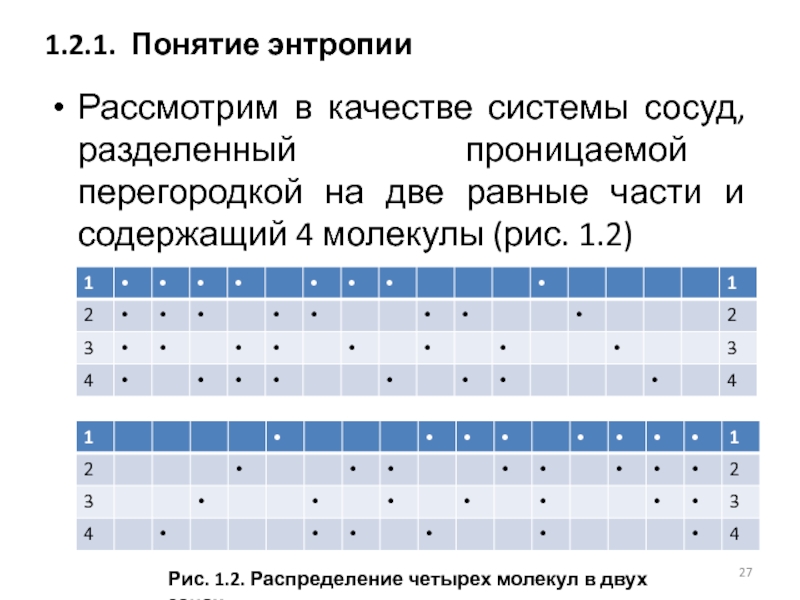

- 27. Рассмотрим в качестве системы сосуд, разделенный проницаемой

- 28. 1.2.1. Понятие энтропии Таблица 1.1 Распределение четырех молекул в двух зонах

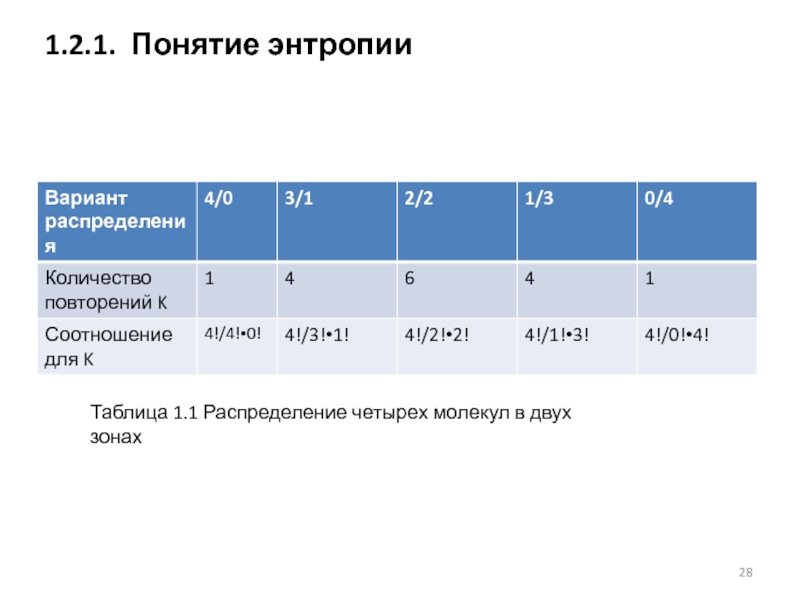

- 29. Формула: K=N!/(N1!•N2!)=N!/[N1!•(N-N1)!] С увеличением числа молекул различия

- 30. 1.2.1. Понятие энтропии Таблица 1.2. Распределение N молекул в двух зонах

- 31. Вероятность скопления N молекул газа в одной

- 32. Второй закон термодинамики: Природа стремится от состояний

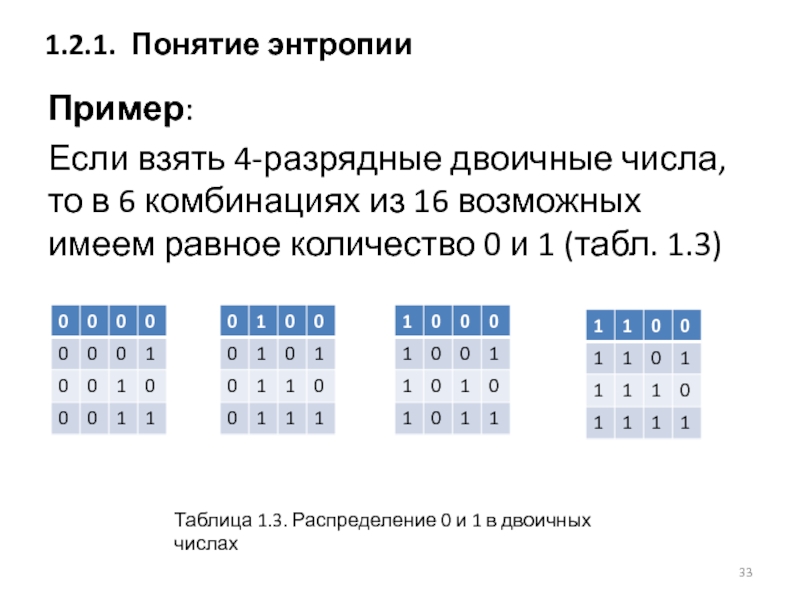

- 33. Пример: Если взять 4-разрядные двоичные числа, то

- 34. Энтропия в термодинамике – количественная мера неупорядоченности,

- 35. Статистический смысл второго закона (начала) термодинамики: Макроскопическое

- 36. В соответствии со вторым законом для замкнутого

- 37. Иная трактовка - энтропия как мера вероятности

- 38. Третий смысл энтропии получается из понятия упорядоченности:

- 39. Энтропия в теории информации – количественная мера

- 40. Главным свойством рассмотренных опытов является неопределенность, т.к.

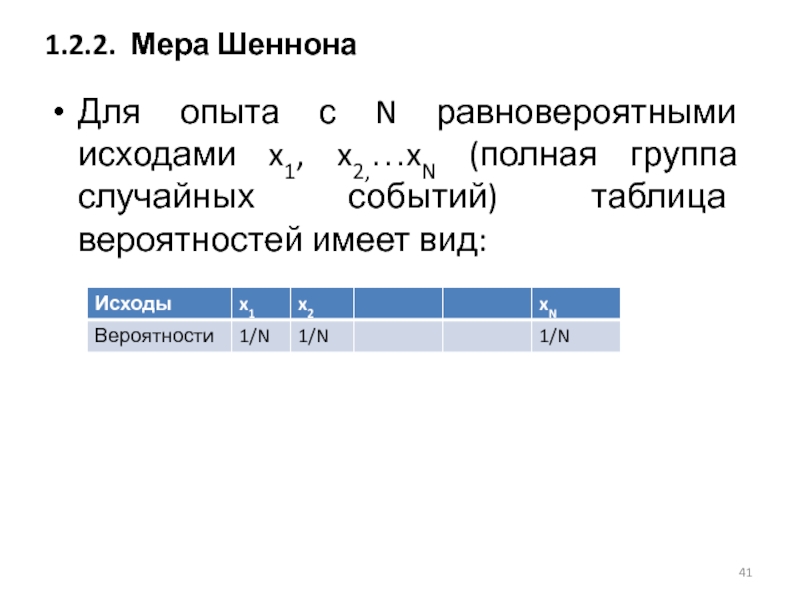

- 41. Для опыта с N равновероятными исходами x1,

- 42. Рассматривая количество информации как меру неопределенности такого

- 43. В общем случае для опыта с N

- 44. H(X) – энтропия случайного опыта или просто

- 45. Единице измерения энтропии 1 бит соответствует опыт,

- 46. Сопоставление термодинамической формулы (Больцмана) и информационной (Хартли

- 47. H(X) – величина вещественная и неотрицательная H(X)min=0 когда pk=1, pi=1 H(X)max=ld N когда pi=1/N H(X)min

- 48. 1.2.3. Свойства энтропии Рис.1.3 Энтропия опыта с двумя исходами

- 49. Условная энтропия HY(X) является мерой остаточной неопределенности.

- 50. Пусть источник сообщений (испытатель), наблюдая за случайными

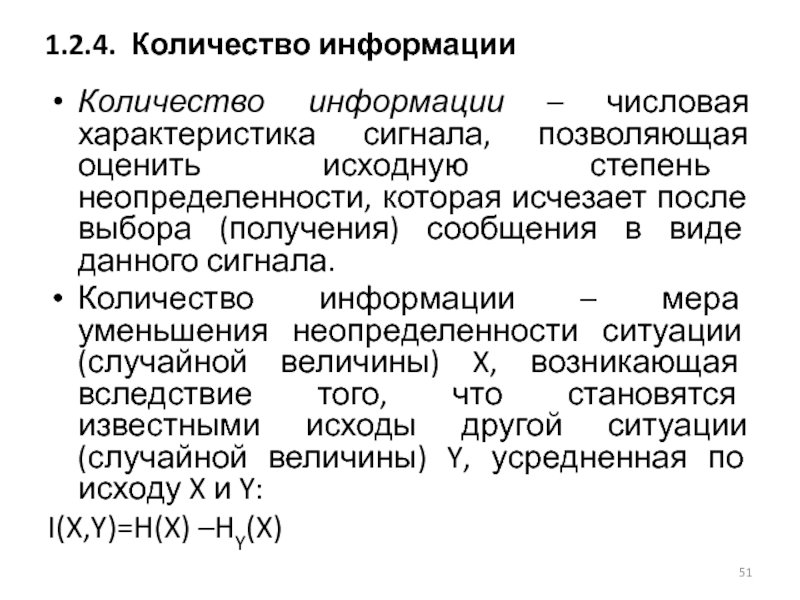

- 51. Количество информации – числовая характеристика сигнала, позволяющая

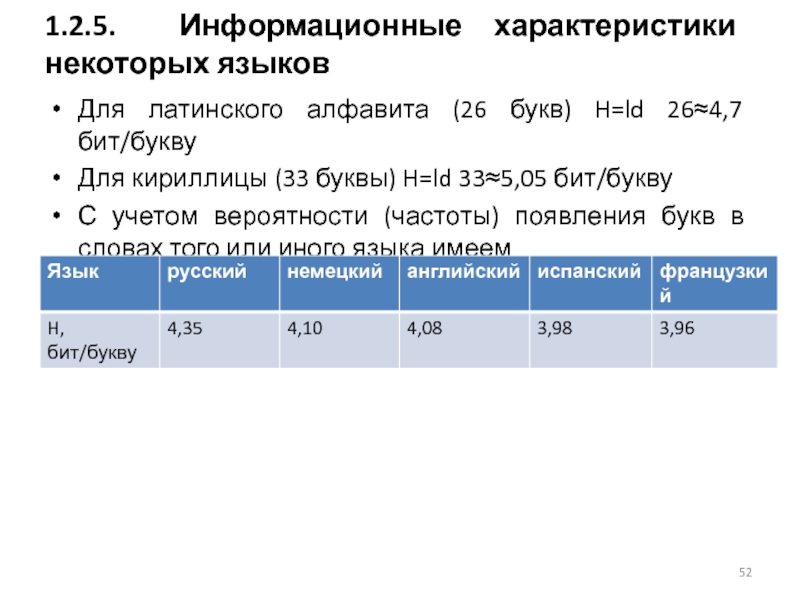

- 52. Для латинского алфавита (26 букв) H=ld 26≈4,7

- 53. Рассмотрим оценки, отвечающие как семантическому, так и

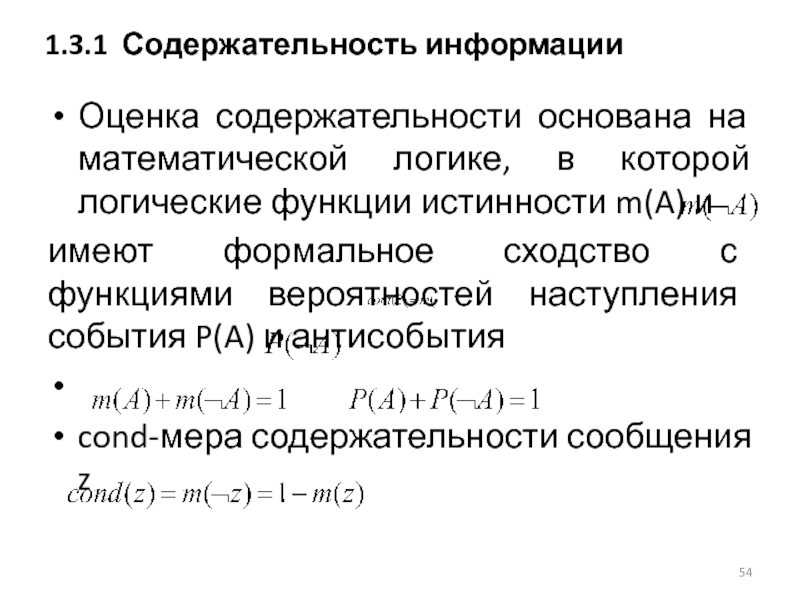

- 54. Оценка содержательности основана на математической логике, в

- 55. Логическая оценка информации: Отличие статистической

- 56. А.А.Харткевичем предложена мера целесообразности информации, которая определяется

- 57. Мера целесообразности в общем виде может выть

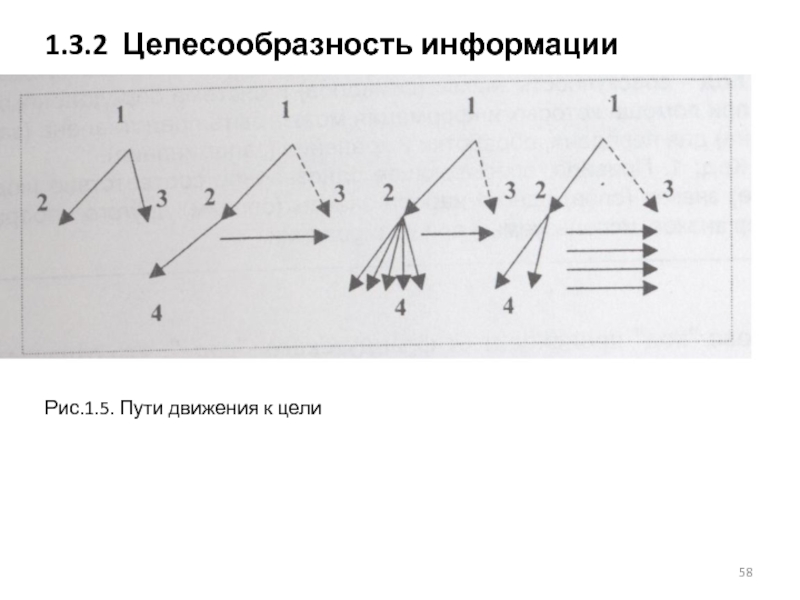

- 58. 1.3.2 Целесообразность информации Рис.1.5. Пути движения к цели

- 59. Пусть имеется некоторое исходное состояние (точка 1),

- 60. Предположим, что достигнута точка 2, и при

Слайд 2Введение

Измерение – нахождение значения физической величины опытным путем с помощью специальных

Мера – средство измерения, предназначенное для воспроизведения заданного значения физической величины (например, гиря).

Слайд 4Введение

В синтаксическом подходе выделяют:

Структурная теория рассматривает дискретное строение массивов информации и

Статистическая теория оперирует понятием энтропии как меры неопределенности, учитывающей вероятность появления и, следовательно информативность тех или иных сообщений.

Слайд 51.1. Синтаксические меры информации. Структурная теория.

При использовании структурной теории (структурных мер)

Слайд 61.1.1. Геометрическая мера

Определение количества информации геометрическим методом сводится к измерению длины

Геометрическим методом определяется потенциальное (максимально возможное) количество информации или информационная ёмкость исследуемого комплекса.

Слайд 7Пусть информация отражается полным комплексом XTN.

Если отсчеты по осям X, T,

mx=X/Δx , mT=T/Δt , mN=N/Δn

Тогда количество информации в полном комплексе XTN равно

I=mx•mT•mN=X•T•N/(Δx•Δt•Δn) [ед.]

1.1.1. Геометрическая мера

Слайд 8 К этой мере целесообразно прибегать тогда, когда требуется оценить возможность передачи

1.1.2. Комбинаторная мера

Слайд 9В комбинаторике рассматривают различные виды соединения из n элементов по m

сочетания Cnm=n!/[m!•(n-m)!]

перестановки Pm=m!

размещения Anm=n!/(n-m)!=Cnm•Pm

1.1.2. Комбинаторная мера

Слайд 10Количество информации в комбинаторной мере вычисляется как количество комбинаций информационных элементов.

Т.е.

Количество информации при том же количестве элементов теперь многократно увеличивается.

1.1.2. Комбинаторная мера

Слайд 11Например, при сочетаниях из n=10 по m=0, 1, 2, 3 …9,

C=10!/0!(10-0)!+10!/1!(10-1)!+…+10!/10!(10-10)!=1+10+45+120+210+252+210+120+45+10+1=1024 комбинации

Перестановка тех же элементов дает:

P=10!=3 682 800 комбинаций.

1.1.2. Комбинаторная мера

Слайд 12Не всегда все возможные комбинации составляют действительные степени свободы данной системы.

Тогда

1.1.2. Комбинаторная мера

Слайд 13Из теории вероятностей:

Проводится некий опыт, исход которого называется событием.

Например, при бросании

Разные события обладают разной степенью возможности, т.о., исход любого опыта – случайное событие.

1.1.3. Аддитивная мера Хартли

Слайд 14Из теории вероятностей:

Меру случайности называют вероятностью и обозначают P(A).

Если P(A)=1, то

1.1.3. Аддитивная мера Хартли

Слайд 15Из теории вероятностей:

Событие A называется независимым от события B, если P(A)

В противном случае рассматривают условную вероятность P(A/B) – вероятность наступления события A при условии, что событие B уже произошло.

Например, вероятность попадания снаряда в одну и ту же воронку.

1.1.3. Аддитивная мера Хартли

Слайд 16Из теории вероятностей:

События A и B называют несовместными, если в результате

Например, появление «орла» и «решки» одновременно при бросании монеты.

1.1.3. Аддитивная мера Хартли

Слайд 17Из теории вероятностей:

Суммой событий A и B называется событие, состоящее в

Произведение событий A и B - событие, состоящее в появлении обоих.

1.1.3. Аддитивная мера Хартли

Слайд 18Из теории вероятностей:

Совокупность событий составляют полную группу, если в результате опыта

Например, появление любой цифры от 1 до 6 при бросании игральной кости.

Суммарная вероятность всех входящих в полную группу событий равна 1.

1.1.3. Аддитивная мера Хартли

Слайд 19Рассмотрим 2 независимых опыта с числом равновероятных исходов N1 и N2

Предположим,

Пусть оба опыта проводятся одновременно, тогда общее число исходов равно N=N1•N2

При этом получаемое количество информации I=I1+I2=f(N1•N2)

1.1.3. Аддитивная мера Хартли

Слайд 20

Искомая функция f(*) должна удовлетворять условию: f(N1)+f(N2)=f(N1•N2)

Единственной функцией удовлетворяющей этому условию

Формула Р.Хартли (1928 г.) I=logaN

1.1.3. Аддитивная мера Хартли

Слайд 21В зависимости от выбора основания логарифма получаем следующие меры количества информации:

a=e I=ln N [нит] – натуральные единицы

a=10 I=lg N [дит] – десятичные единицы

a=2 I=ld N [бит] –двоичные единицы

(1 бит информации от английских слов binary digit)

1.1.3. Аддитивная мера Хартли

Слайд 22Иной подход к выводу формулы Хартли:

Пусть передаваемое сообщение имеет вид числа,

Одно и то же количество разрядов в разных системах счисления может передавать разное число состояний отображаемого объекта: N=mn ,

где N – число возможных отображаемых состояний;

m – основание системы счисления;

n – число разрядов в сообщении (длина разрядной сетки).

Например, при m=100 и n=2 имеем 100 чисел от 00 до 99, а при m=2 и n=2 всего 4 числа: 00, 01, 10 и 11

1.1.3. Аддитивная мера Хартли

Слайд 23В случае, когда все N состояний равновероятны, получаем следующую формулу для

I=logaN=n•logam

Если a=m, то I=n, т.е. количество информации равно объему данных.

Эту меру можно назвать компьютерной, т.к. при a=m=2 (двоичная система счисления) и n=1 (один разряд) имеем единицу измерения 1 бит, от которой производными являются байт, килобайт, мегабайт и т.д.

1.1.3. Аддитивная мера Хартли

Слайд 24При статистическом (вероятностном) подходе информация рассматривается как сообщения о случайных событиях

При бросании кубика: вероятность встретить один знак (одну из цифр от 1 до 6) в произвольный момент времени совпадает с относительной частотой этого знака во всей последовательно знаков.

1.2. Синтаксическая мера. Статистическая теория

Слайд 25Последовательность знаков с таким свойством называется шенноновским сообщением.

Поскольку сами знаки и

1.2. Синтаксическая мера. Статистическая теория

Слайд 26Упорядоченным называется состояние системы, осуществляемое относительно малым числом способов, а беспорядочным

1.2.1. Понятие энтропии

Слайд 27Рассмотрим в качестве системы сосуд, разделенный проницаемой перегородкой на две равные

1.2.1. Понятие энтропии

Рис. 1.2. Распределение четырех молекул в двух зонах

Слайд 29Формула:

K=N!/(N1!•N2!)=N!/[N1!•(N-N1)!]

С увеличением числа молекул различия в вероятностях будут резко возрастать (таблица

1.2.1. Понятие энтропии

Слайд 31Вероятность скопления N молекул газа в одной половине сосуда объемом 1

для одной молекулы P1=0,5 (да/нет)

при нормальных условиях в 1 см3 содержится L=2,7•1019 молекул газа (число Лошмидта)

Тогда для N молекул имеем PN=P1N=0,51=2-1

1.2.1. Понятие энтропии

Слайд 32Второй закон термодинамики:

Природа стремится от состояний менее вероятных к состояниям более

1.2.1. Понятие энтропии

Слайд 33Пример:

Если взять 4-разрядные двоичные числа, то в 6 комбинациях из 16

1.2.1. Понятие энтропии

Таблица 1.3. Распределение 0 и 1 в двоичных числах

Слайд 34Энтропия в термодинамике – количественная мера неупорядоченности, мера вероятности осуществления какого-либо

В физику понятие энтропии ввел Рудольф Клаузиус (19 в.).

Л. Больцман использовал это понятие для определения меры необратимого рассеяния энергии, что позволило строго математически сформулировать второй закон термодинамики.

1.2.1. Понятие энтропии

Слайд 35Статистический смысл второго закона (начала) термодинамики:

Макроскопическое состояние газа с некоторыми значениями

1.2.1. Понятие энтропии

Слайд 36В соответствии со вторым законом для замкнутого пространства (изолированной системы) энтропия

S=-1/N•Σni ln(ni/N)=-Σpi ln pi

где N-общее число молекул в системе;

pi – вероятность того, что ni молекул имеют скорости vi+Δvi

1.2.1. Понятие энтропии

Слайд 37Иная трактовка - энтропия как мера вероятности осуществления какого-либо состояния системы:

S=-Σpi

где pi – вероятность нахождения молекул в i-й ячейке фазового пространства; W – термодинамическая вероятность данного макроскопического состояния системы или число соответствующих состояний; k=1,38•10-23 Дж/К – постоянная Больцмана.

1.2.1. Понятие энтропии

Слайд 38Третий смысл энтропии получается из понятия упорядоченности: коль скоро неупорядоченные состояния

1.2.1. Понятие энтропии

Слайд 39Энтропия в теории информации – количественная мера неопределенности.

Трактовку ввел в 1948

1.2.2. Мера Шеннона

Слайд 40Главным свойством рассмотренных опытов является неопределенность, т.к. каждый исход – случайное

Важно уметь численно оценить степень неопределенности, чтобы иметь возможность объективного сравнения различных опытов.

Степень неопределенности опыта, имеющего N исходов, зависит от N: если при N=1 исход опыта вообще не является случайным, то по мере возрастания N предсказание того или иного исхода становится все более проблематичным.

1.2.2. Мера Шеннона

Слайд 41Для опыта с N равновероятными исходами x1, x2,…xN (полная группа случайных

1.2.2. Мера Шеннона

Слайд 42Рассматривая количество информации как меру неопределенности такого опыта в соответствии с

I= ld N [бит]

При этом каждый исход имеет неопределенность

Ik=(1/N) ld N=-(1/N) ld (1/N) [бит]

1.2.2. Мера Шеннона

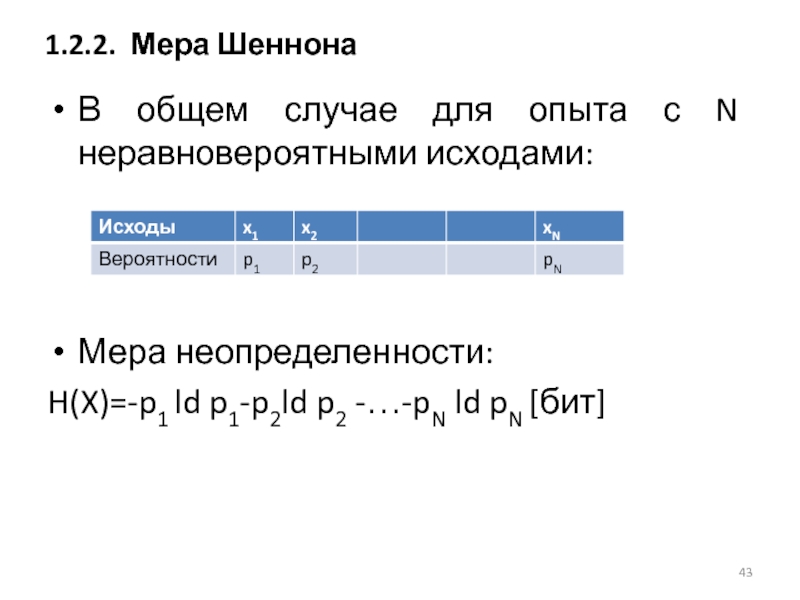

Слайд 43В общем случае для опыта с N неравновероятными исходами:

Мера неопределенности:

H(X)=-p1 ld

1.2.2. Мера Шеннона

Слайд 44H(X) – энтропия случайного опыта или просто энтропия.

H(X)=-Σpi ld pi при

Это основное определение теории информации Шеннона.

Количественно выражается как средняя функция каждого из возможных исходов опыта.

Формула Хартли является предельным случаем формулы Шеннона.

1.2.2. Мера Шеннона

Слайд 45Единице измерения энтропии 1 бит соответствует опыт, имеющий N=2 равновероятных исходов

H(X)=-1/2 ld ½-1/2 ld ½=1/2+1/2=1 [бит]

1.2.2. Мера Шеннона

Слайд 46Сопоставление термодинамической формулы (Больцмана) и информационной (Хартли и Шеннона) трактовок понятия

E0=k T ln2 [Дж/бит]

Где E0 – количество энергии, требуемое для обработки 1 бита информации при заданном значении термодинамической температуры, k – постоянная Больцмана

1.2.2. Мера Шеннона

Слайд 47H(X) – величина вещественная и неотрицательная

H(X)min=0 когда pk=1, pi=1

H(X)max=ld N когда

H(X)min

Для двух независимых опытов X и Y, осуществляемых одновременно H(X,Y)=H(X)+H(Y)

Для двух зависимых опытов X и Y, осуществляемых одновременно H(X,Y)=H(X)+HX(Y)=H(Y)+HY(X), где HX(Y) – условная энтропия Y

1.2.3. Свойства энтропии

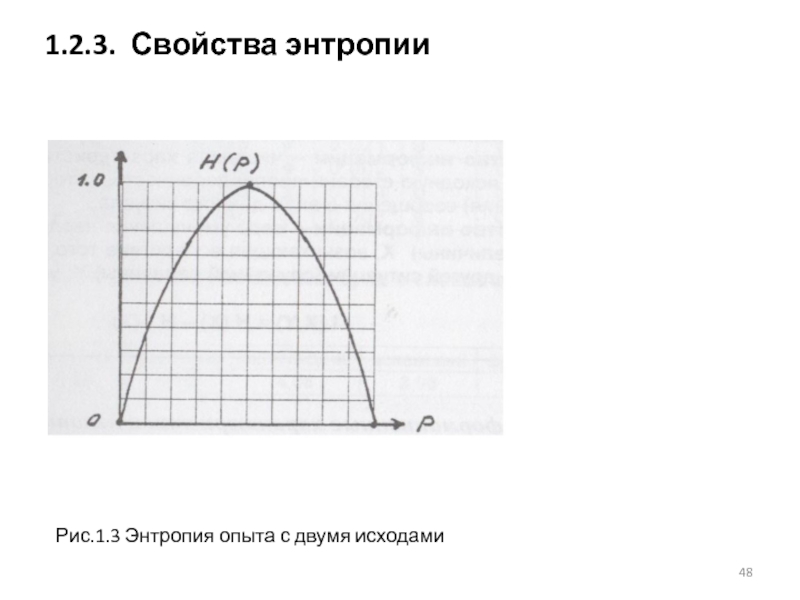

Слайд 49Условная энтропия HY(X) является мерой остаточной неопределенности.

1.2.4. Количество информации

Рис.1.4. Упрощенная схема

Слайд 50Пусть источник сообщений (испытатель), наблюдая за случайными исходами, генерирует и передает

После прохождения через канал связи это сообщение преобразуется в принятое (конечное) сообщение Y, характеризуемое энтропией H(Y), которое и воспринимает получатель.

Т.к. получатель не имеет прямого доступа к опыту, он оценивает его исходы только по сообщению Y.

В результате для получателя неопределенность ситуации уменьшилась на величину HY(X) – энтропия сообщения X при условии, что получено сообщение Y.

Разность H(X)-HY(X) называется неэнтропией (отрицательная энтропия), т.к. Определяет уменьшение энтропии за счет передачи сообщения, служит мерой количества информации при передаче сообщения.

1.2.4. Количество информации

Слайд 51Количество информации – числовая характеристика сигнала, позволяющая оценить исходную степень неопределенности,

Количество информации – мера уменьшения неопределенности ситуации (случайной величины) X, возникающая вследствие того, что становятся известными исходы другой ситуации (случайной величины) Y, усредненная по исходу X и Y:

I(X,Y)=H(X) –HY(X)

1.2.4. Количество информации

Слайд 52Для латинского алфавита (26 букв) H=ld 26≈4,7 бит/букву

Для кириллицы (33 буквы)

С учетом вероятности (частоты) появления букв в словах того или иного языка имеем

1.2.5. Информационные характеристики некоторых языков

Слайд 53Рассмотрим оценки, отвечающие как семантическому, так и прагматическому подходам.

Это обусловлено тем,

1.3. Семантическая и прагматическая меры информации

Слайд 54Оценка содержательности основана на математической логике, в которой логические функции истинности

имеют формальное сходство с функциями вероятностей наступления события P(A) и антисобытия

cond-мера содержательности сообщения z

1.3.1 Содержательность информации

Слайд 55Логическая оценка информации:

Отличие статистической оценки от логической состоит в том, что

1.3.1 Содержательность информации

Слайд 56А.А.Харткевичем предложена мера целесообразности информации, которая определяется как изменение вероятности достижения

Полученная информация может не изменять вероятности достижения цели (ситуация не изменилась), тогда ее мера равна 0.

Информация может уменьшать вероятность достижения цели (дезинформативность, ситуация ухудшилась), тогда ее мера отрицательна.

Информация может увеличивать вероятность достижения цели (добротная информация, ситуация улучшилась), тогда ее мера положительна.

1.3.2 Целесообразность информации

Слайд 57Мера целесообразности в общем виде может выть выражена соотношением

I=Ld p1-ld p0=ld(p1/p0)

где

1.3.2 Целесообразность информации

Слайд 59Пусть имеется некоторое исходное состояние (точка 1), цель (точка 3), и

Из точки 1 возможны 2 пути: 1-2 и 1-3.

Если пути к цели априорно неизвестны, то можно предположить, что вероятности ее достижения по обоим путям равны, т.е. P(1-2)=P(1-3)=1/2

1.3.2 Целесообразность информации

Слайд 60Предположим, что достигнута точка 2, и при этом получена нейтральная информация:

Тогда I=ld[P(2-3)/P(1-2)]=ld(1/2)-ld(1/2)=0

Предположим, что достигнута точка 2, и при этом получена ложная информация: пять направлений из шести ведут по пути 2-4 и только одно – по пути 2-3.

Тогда I=ld[P(2-3)/P(1-2)]=ld(1/6)-ld(1/2)=-ld 6+ld 2=-1,58

Предположим, что достигнута точка 2, и при этом получена благоприятная информация: два направления из шести ведут по ложному пути 2-4 и четыре направления – по пути 2-3

Тогда I=ld[P(2-3)/P(1-2)]=ld(4/6)-ld(1/2)=ld 4- ld 6 +ld 2=0,42

1.3.2 Целесообразность информации

![В комбинаторике рассматривают различные виды соединения из n элементов по m элементов, например:сочетания Cnm=n!/[m!•(n-m)!]перестановки Pm=m!размещения](/img/tmb/3/280776/1d2cf6c7ecc3541faf0b8cf93021e5a8-800x.jpg)

![Формула:K=N!/(N1!•N2!)=N!/[N1!•(N-N1)!]С увеличением числа молекул различия в вероятностях будут резко возрастать (таблица 1.2)1.2.1. Понятие энтропии](/img/tmb/3/280776/5c1aa90fddf590330237c84e77f460e9-800x.jpg)