- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Информационные технологии. Информатика (для заочников) презентация

Содержание

- 1. Информационные технологии. Информатика (для заочников)

- 2. Информатика Термин "информатика" (франц. informatique) происходит от

- 3. В 1978 году международный научный конгресс официально

- 4. Приоритетные направления информатики: Разpаботка вычислительных

- 5. Информация (informatio, лат.) – разъяснение, изложение

- 6. в теории связи – сообщения в форме

- 7. Измерение информации 4 подхода к

- 8. 1. Объемный подход. Это измерение информации с

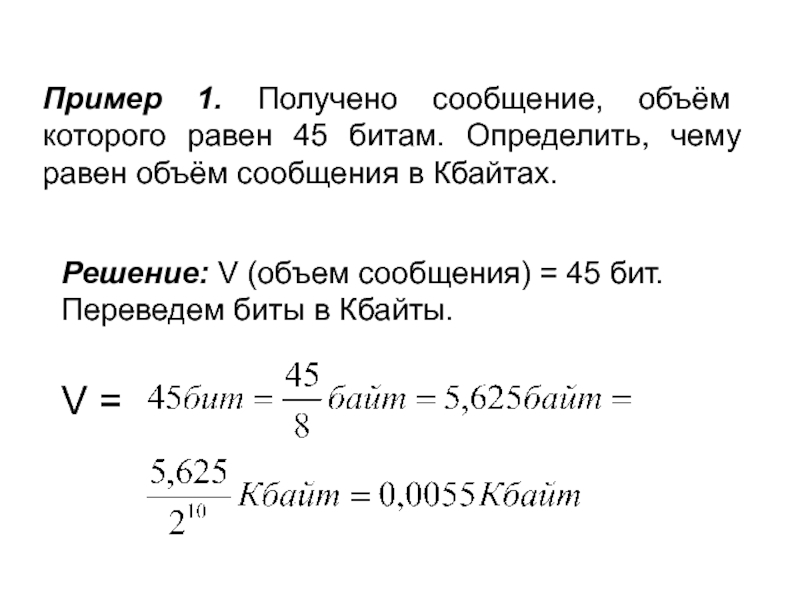

- 9. Пример 1. Получено сообщение, объём которого равен

- 10. Пример 2. Какую часть диска емкостью 210

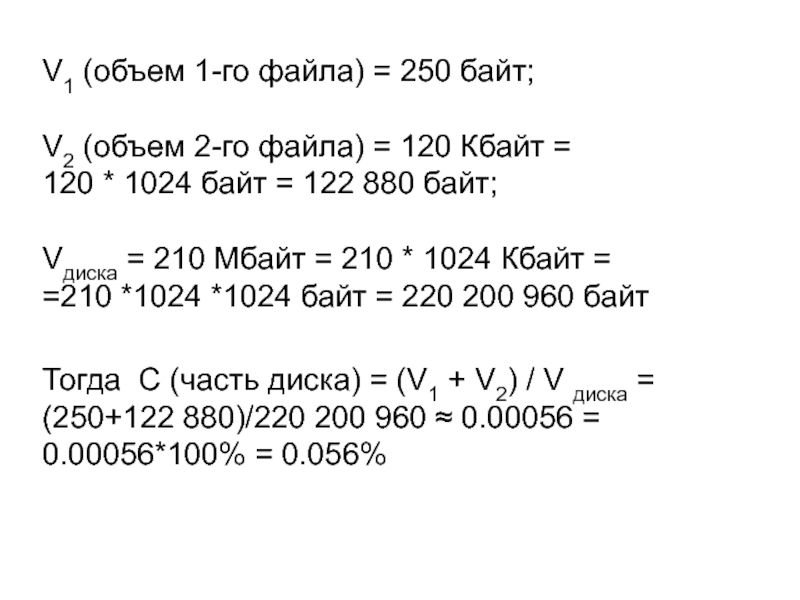

- 11. V1 (объем 1-го файла) = 250 байт;

- 12. 2. Алфавитный подход к измерению информации

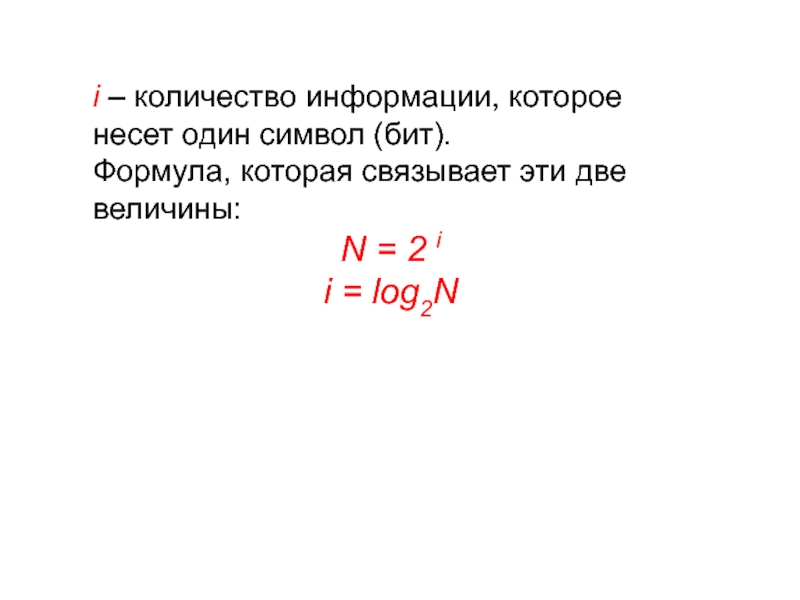

- 13. i – количество информации, которое несет один

- 14. K – количество символов в сообщении. V

- 15. Пример 1. Сообщение записано 32-х символьным

- 16. Пример 2. Книга, набранная с помощью компьютера,

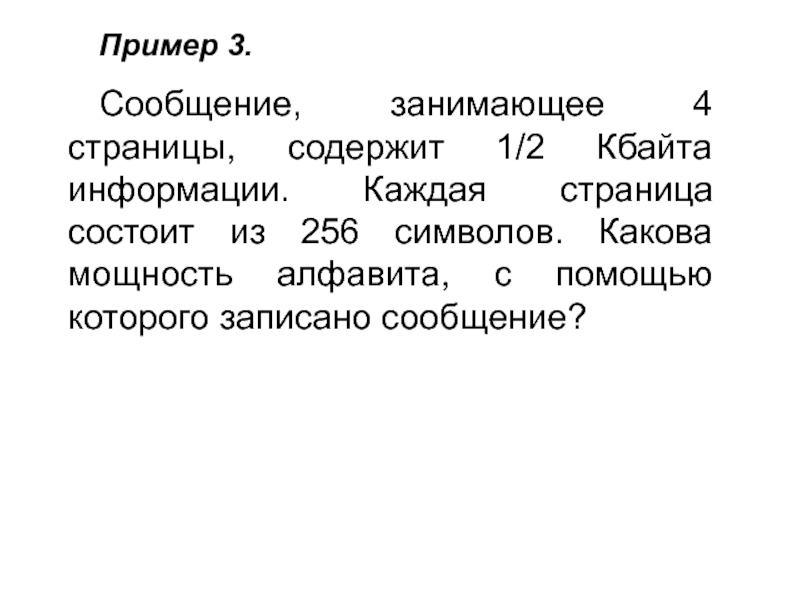

- 17. Пример 3. Сообщение, занимающее 4 страницы,

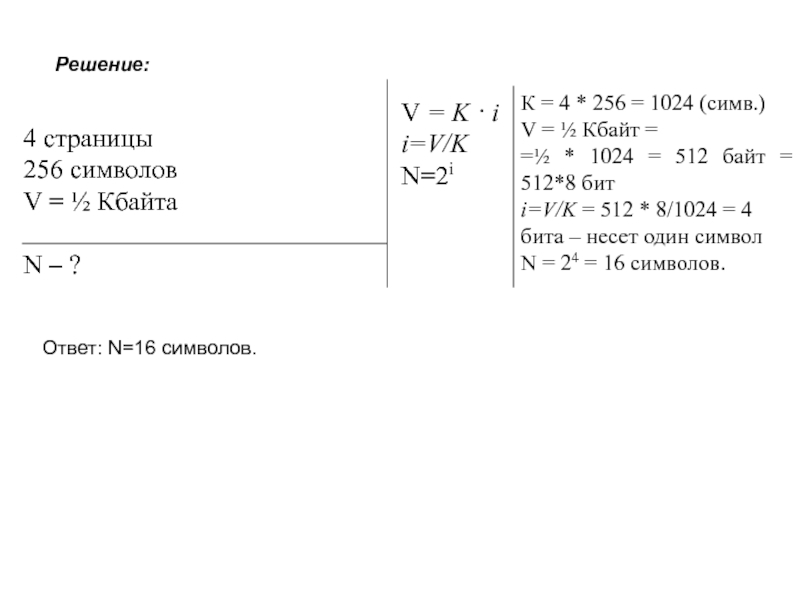

- 18. 4 страницы 256 символов V =

- 19. 3. Содержательный подход к измерению информации

- 20. Введем обозначения: N – количество равновероятных событий

- 21. Пример 1. В коробке 16 CD-дисков. Сколько

- 22. Пример 2. При угадывании целого числа

- 23. Допустим, мы загадали число 6 1 Вопрос:

- 24. 4 Вопрос: Аналогично предыдущему случаю: в первой

- 25. Пример 3. Сколько информации содержится в сообщении

- 26. 4. Вероятностный подход к измерению информации

- 27. Пример 1. Бросается игральный кубик. Какова вероятность

- 28. Пример 2. В гараже 15 автомобилей КАМАЗ,

- 29. Вероятностный подход Введем обозначения: pi –

- 30. Пример 3. В группе 24

- 31. Пример 4. Студенты в группе за экзамен

- 32. Энтропия Основоположник теории информации Клод Шеннон определил

- 33. Формула Шеннона В общем случае, энтропия

- 34. Пример 5. Пусть в некотором учреждении состав

Слайд 2Информатика

Термин "информатика" (франц. informatique) происходит от французских слов information (информация) и

Широко распространён также англоязычный вариант этого термина — "Сomputer science", что означает буквально "компьютерная наука".

Инфоpматика — это основанная на использовании компьютерной техники дисциплина, изучающая структуру и общие свойства информации, а также закономерности и методы её создания, хранения, поиска, преобразования, передачи и применения в различных сферах человеческой деятельности.

Слайд 3В 1978 году международный научный конгресс официально закрепил за понятием "информатика"

Слайд 4Приоритетные направления информатики:

Разpаботка вычислительных систем и пpогpаммного обеспечения;

Теоpия инфоpмации,

Математическое моделирование, методы вычислительной и прикладной математики и их применение к фундаментальным и прикладным исследованиям в различных областях знаний;

Методы искусственного интеллекта, моделирующие методы логического и аналитического мышления в интеллектуальной деятельности человека (логический вывод, обучение, понимание речи, визуальное восприятие, игры и др.);

Системный анализ, изучающий методологические средства, используемые для подготовки и обоснования решений по сложным проблемам различного характера;

Биоинформатика, изучающая информационные процессы в биологических системах;

Социальная информатика, изучающая процессы информатизации общества;

Методы машинной графики, анимации, средства мультимедиа;

Телекоммуникационные системы и сети

Разнообразные пpиложения, охватывающие все виды хозяйственной и общественной деятельности.

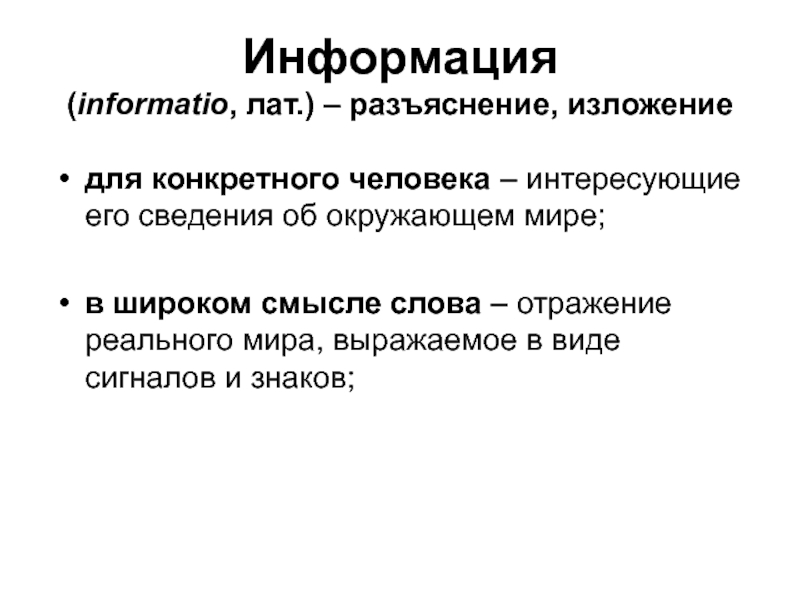

Слайд 5Информация

(informatio, лат.) – разъяснение, изложение

для конкретного человека – интересующие его

в широком смысле слова – отражение реального мира, выражаемое в виде сигналов и знаков;

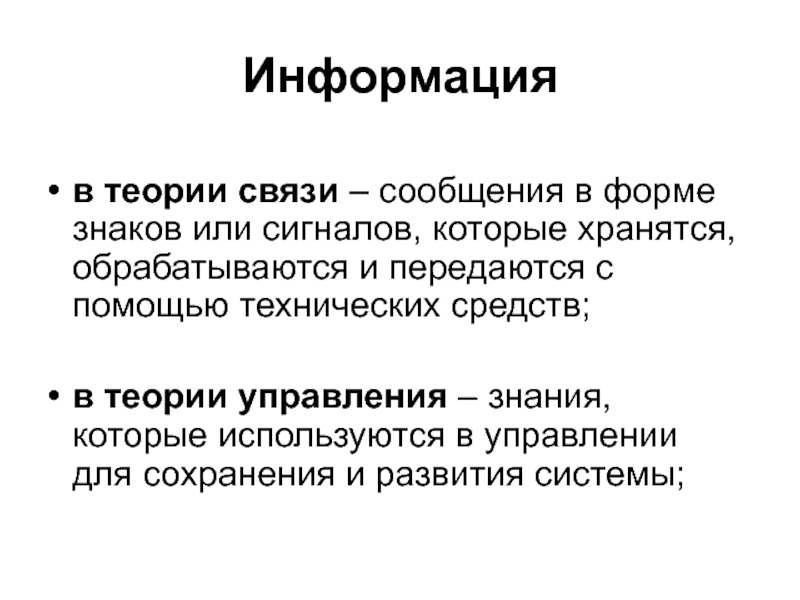

Слайд 6в теории связи – сообщения в форме знаков или сигналов, которые

в теории управления – знания, которые используются в управлении для сохранения и развития системы;

Информация

Слайд 7

Измерение информации

4 подхода к измерению информации:

1. Объемный подход

2. Алфавитный подход

3. Содержательный

4. Вероятностный подход

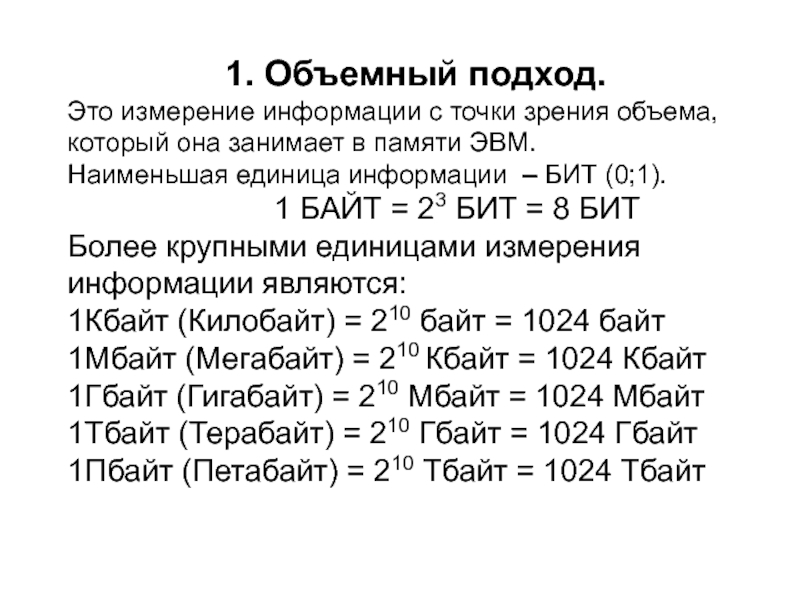

Слайд 81. Объемный подход.

Это измерение информации с точки зрения объема, который она

Наименьшая единица информации – БИТ (0;1).

1 БАЙТ = 23 БИТ = 8 БИТ

Более крупными единицами измерения информации являются:

1Кбайт (Килобайт) = 210 байт = 1024 байт

1Мбайт (Мегабайт) = 210 Кбайт = 1024 Кбайт

1Гбайт (Гигабайт) = 210 Мбайт = 1024 Мбайт

1Тбайт (Терабайт) = 210 Гбайт = 1024 Гбайт

1Пбайт (Петабайт) = 210 Тбайт = 1024 Тбайт

Слайд 9Пример 1. Получено сообщение, объём которого равен 45 битам. Определить, чему

Решение: V (объем сообщения) = 45 бит. Переведем биты в Кбайты.

V =

Слайд 10Пример 2. Какую часть диска емкостью 210 Мб занимают два файла

Решение: Для решения задачи необходимо все величины привести к одинаковым единицам измерения.

Будем вести расчет в байтах.

Слайд 11V1 (объем 1-го файла) = 250 байт;

V2 (объем 2-го файла) =

120 * 1024 байт = 122 880 байт;

Vдиска = 210 Мбайт = 210 * 1024 Кбайт =

=210 *1024 *1024 байт = 220 200 960 байт

Тогда С (часть диска) = (V1 + V2) / V диска = (250+122 880)/220 200 960 ≈ 0.00056 = 0.00056*100% = 0.056%

Слайд 122. Алфавитный подход к измерению информации

Это измерение информации с точки зрения

Введем обозначения:

N – мощность алфавита

(количество символов в алфавите).

Пример:

Мощность русского алфавита – 33 буквы; мощность английского алфавита – 26 букв; мощность компьютерного алфавита – 256 символов.

Слайд 13i – количество информации, которое несет один символ (бит).

Формула, которая связывает

N = 2 i

i = log2N

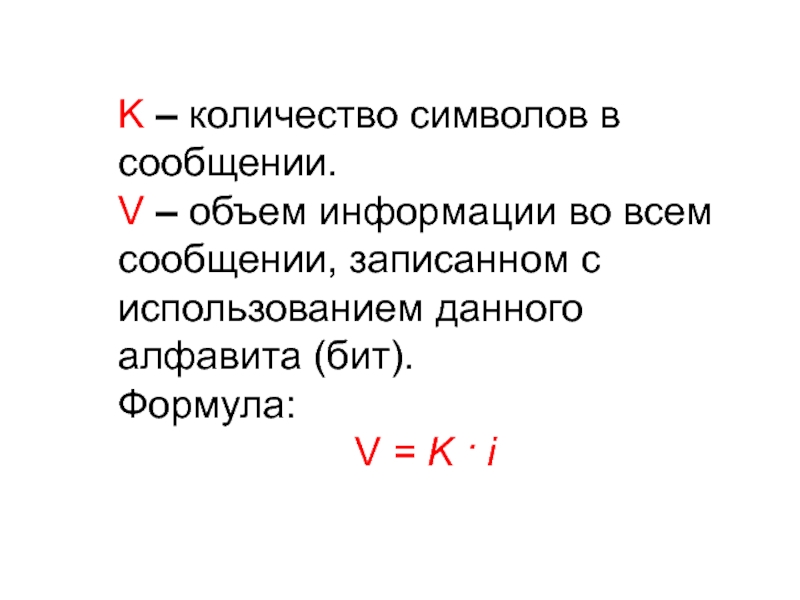

Слайд 14K – количество символов в сообщении.

V – объем информации во всем

Формула:

V = K · i

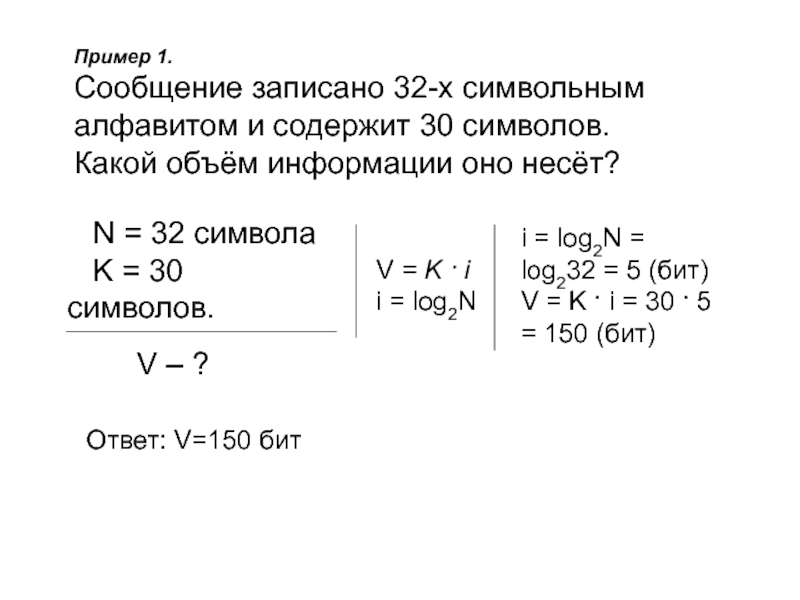

Слайд 15Пример 1.

Сообщение записано 32-х символьным

алфавитом и содержит 30 символов.

Какой объём информации оно несёт?

V = K · i

i = log2N

i = log2N = log232 = 5 (бит)

V = K · i = 30 · 5 = 150 (бит)

N = 32 символа

K = 30 символов.

V – ?

Ответ: V=150 бит

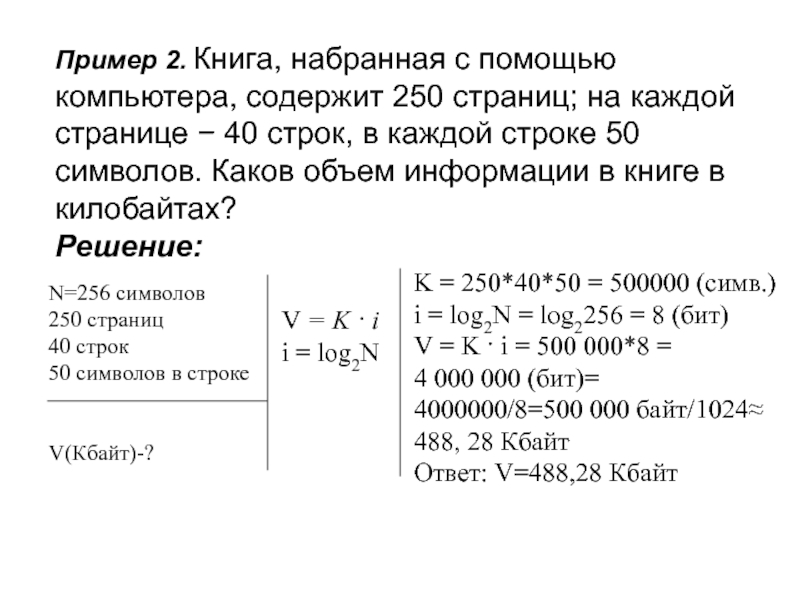

Слайд 16Пример 2. Книга, набранная с помощью компьютера, содержит 250 страниц; на

Решение:

N=256 символов

250 страниц

40 строк

50 символов в строке

V(Кбайт)-?

V = K · i

i = log2N

K = 250*40*50 = 500000 (симв.)

i = log2N = log2256 = 8 (бит)

V = K · i = 500 000*8 =

4 000 000 (бит)=

4000000/8=500 000 байт/1024≈ 488, 28 Кбайт

Ответ: V=488,28 Кбайт

Слайд 17Пример 3.

Сообщение, занимающее 4 страницы, содержит 1/2 Кбайта информации. Каждая

Слайд 18

4 страницы

256 символов

V = ½ Кбайта

N – ?

Решение:

V =

N=2i

К = 4 * 256 = 1024 (симв.)

V = ½ Кбайт =

=½ * 1024 = 512 байт = 512*8 бит

i=V/K = 512 * 8/1024 = 4 бита – несет один символ

N = 24 = 16 символов.

Ответ: N=16 символов.

Слайд 193. Содержательный подход к измерению информации

Это измерение информации с точки зрения

Все люди имеющуюся информацию могут оценивать по-разному.

Кому-то она важна, кому-то бесполезна;

кому-то интересна, кому-то – нет.

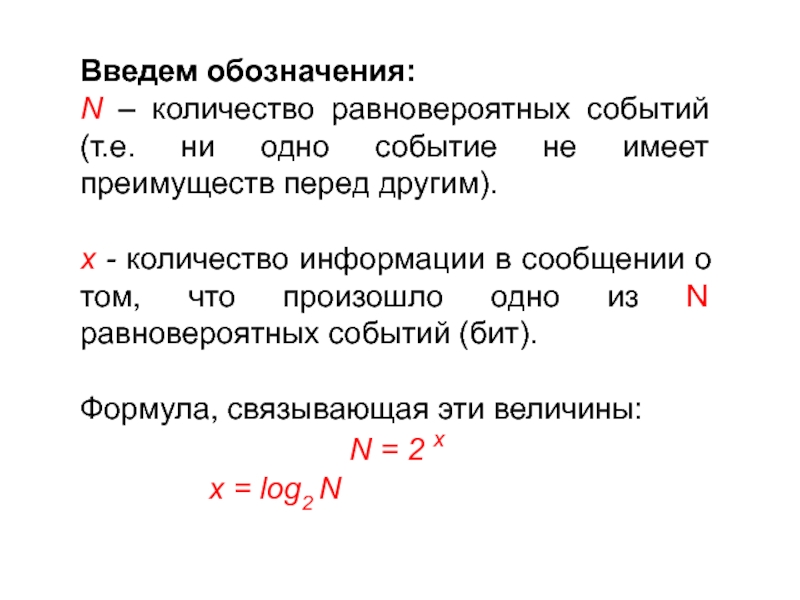

Слайд 20Введем обозначения:

N – количество равновероятных событий (т.е. ни одно событие не

х - количество информации в сообщении о том, что произошло одно из N равновероятных событий (бит).

Формула, связывающая эти величины:

N = 2 х

х = log2 N

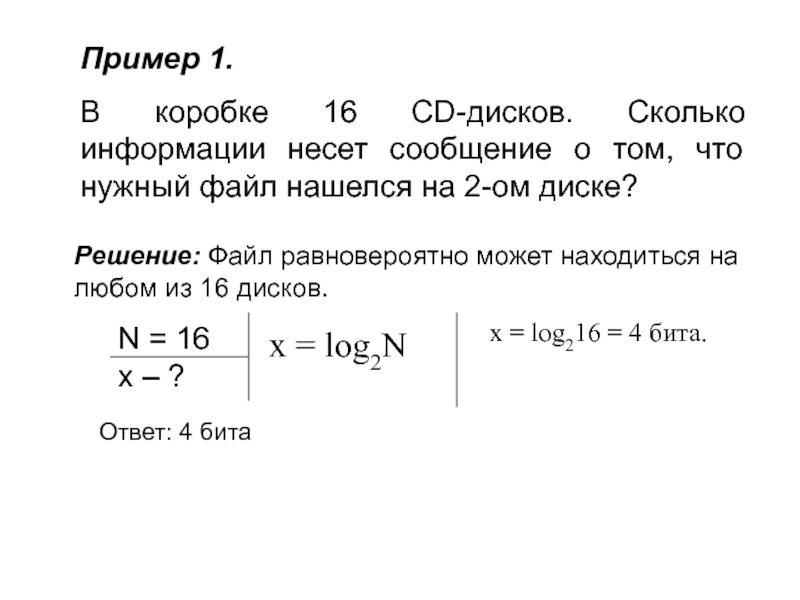

Слайд 21Пример 1.

В коробке 16 CD-дисков. Сколько информации несет сообщение о том,

Решение: Файл равновероятно может находиться на любом из 16 дисков.

N = 16

х – ?

х = log2N

х = log216 = 4 бита.

Ответ: 4 бита

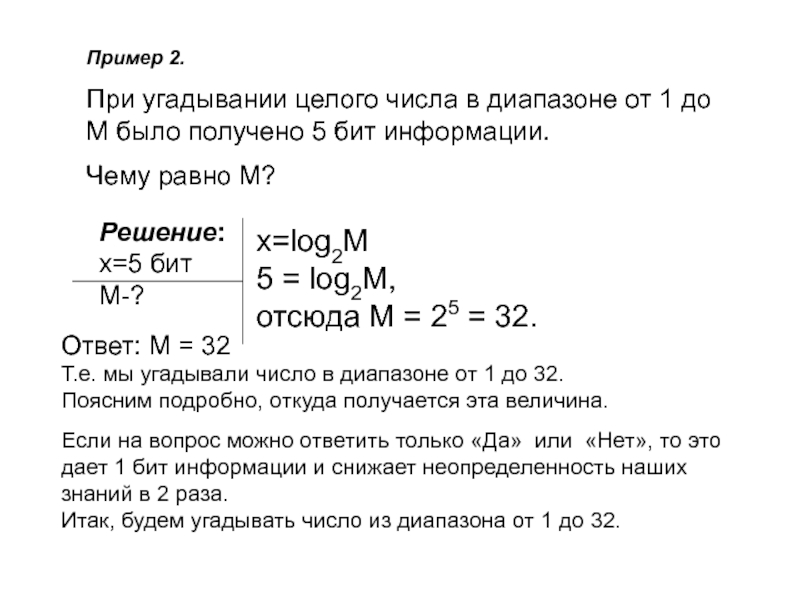

Слайд 22Пример 2.

При угадывании целого числа в диапазоне от 1 до

Чему равно М?

х=log2M

5 = log2М,

отсюда М = 25 = 32.

Решение:

х=5 бит

М-?

Ответ: М = 32

Т.е. мы угадывали число в диапазоне от 1 до 32.

Поясним подробно, откуда получается эта величина.

Если на вопрос можно ответить только «Да» или «Нет», то это дает 1 бит информации и снижает неопределенность наших знаний в 2 раза.

Итак, будем угадывать число из диапазона от 1 до 32.

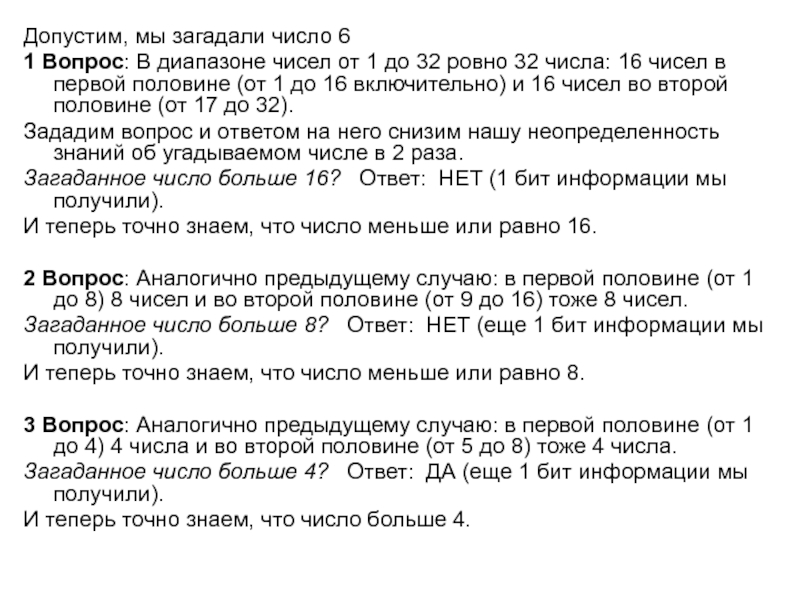

Слайд 23Допустим, мы загадали число 6

1 Вопрос: В диапазоне чисел от 1

Зададим вопрос и ответом на него снизим нашу неопределенность знаний об угадываемом числе в 2 раза.

Загаданное число больше 16? Ответ: НЕТ (1 бит информации мы получили).

И теперь точно знаем, что число меньше или равно 16.

2 Вопрос: Аналогично предыдущему случаю: в первой половине (от 1 до 8) 8 чисел и во второй половине (от 9 до 16) тоже 8 чисел.

Загаданное число больше 8? Ответ: НЕТ (еще 1 бит информации мы получили).

И теперь точно знаем, что число меньше или равно 8.

3 Вопрос: Аналогично предыдущему случаю: в первой половине (от 1 до 4) 4 числа и во второй половине (от 5 до 8) тоже 4 числа.

Загаданное число больше 4? Ответ: ДА (еще 1 бит информации мы получили).

И теперь точно знаем, что число больше 4.

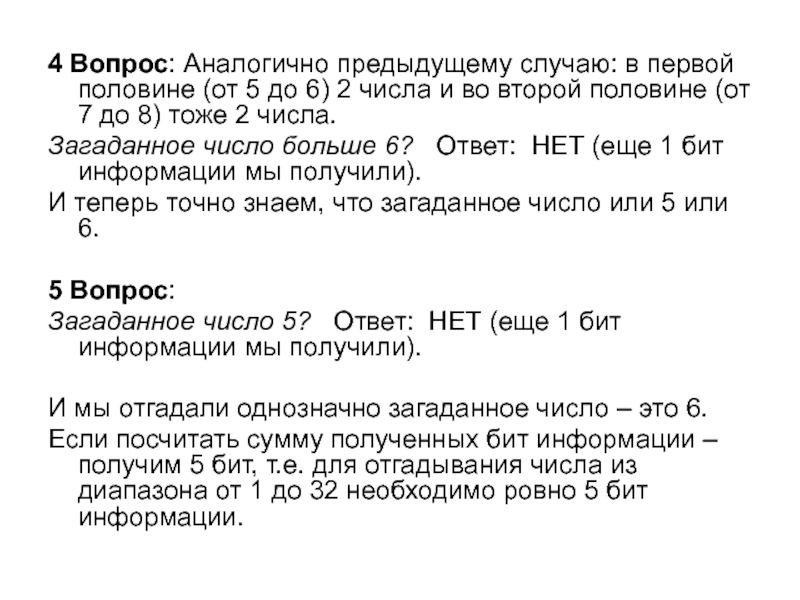

Слайд 244 Вопрос: Аналогично предыдущему случаю: в первой половине (от 5 до

Загаданное число больше 6? Ответ: НЕТ (еще 1 бит информации мы получили).

И теперь точно знаем, что загаданное число или 5 или 6.

5 Вопрос:

Загаданное число 5? Ответ: НЕТ (еще 1 бит информации мы получили).

И мы отгадали однозначно загаданное число – это 6.

Если посчитать сумму полученных бит информации – получим 5 бит, т.е. для отгадывания числа из диапазона от 1 до 32 необходимо ровно 5 бит информации.

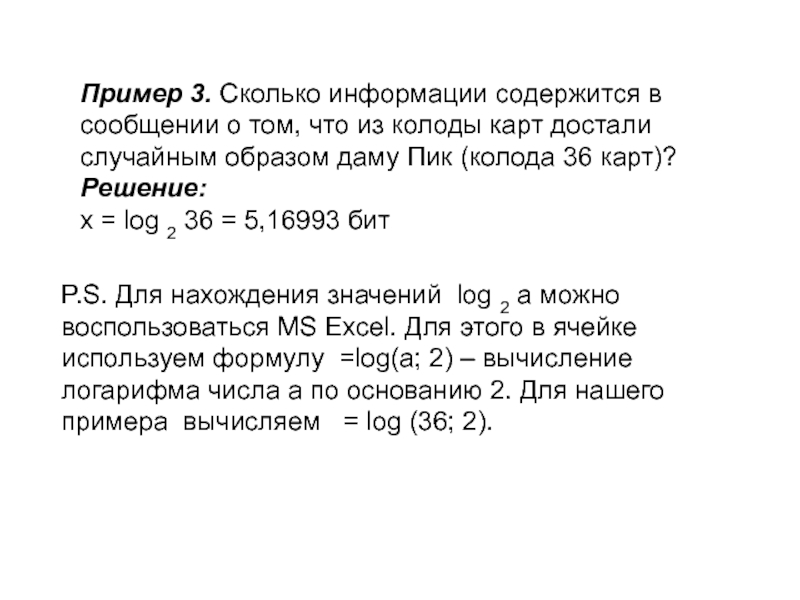

Слайд 25Пример 3. Сколько информации содержится в сообщении о том, что из

Решение:

х = log 2 36 = 5,16993 бит

P.S. Для нахождения значений log 2 a можно воспользоваться MS Excel. Для этого в ячейке используем формулу =log(a; 2) – вычисление логарифма числа a по основанию 2. Для нашего примера вычисляем = log (36; 2).

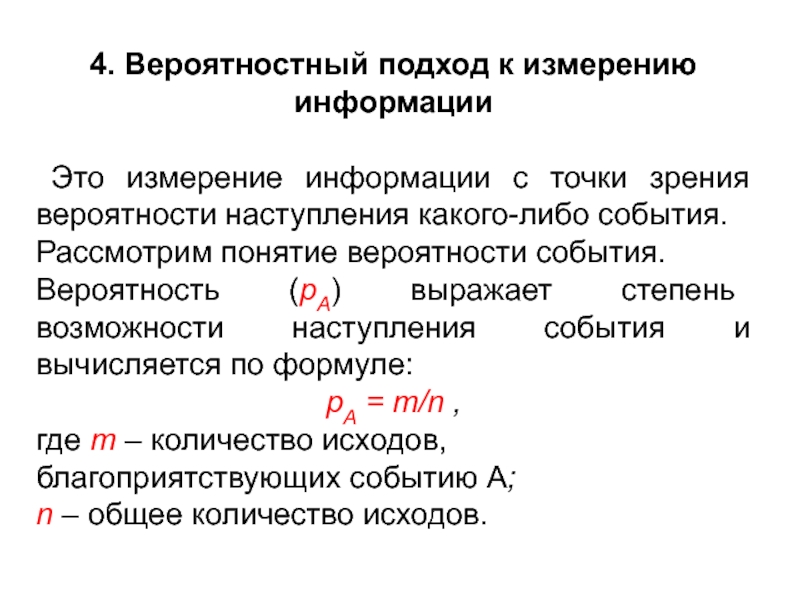

Слайд 264. Вероятностный подход к измерению информации

Это измерение информации с точки

Рассмотрим понятие вероятности события.

Вероятность (pА) выражает степень возможности наступления события и вычисляется по формуле:

pА = m/n ,

где m – количество исходов, благоприятствующих событию А;

n – общее количество исходов.

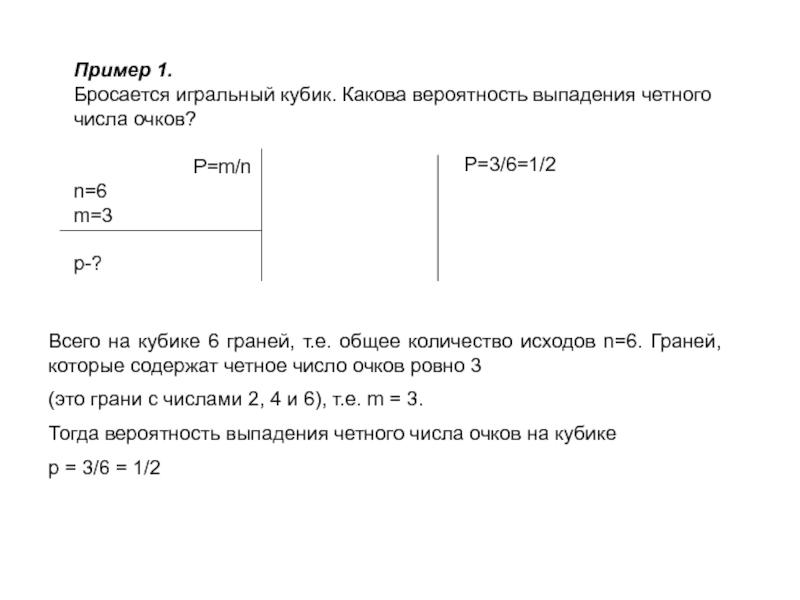

Слайд 27Пример 1.

Бросается игральный кубик. Какова вероятность выпадения четного числа очков?

P=m/n

n=6

m=3

p-?

P=3/6=1/2

Всего на

(это грани с числами 2, 4 и 6), т.е. m = 3.

Тогда вероятность выпадения четного числа очков на кубике

p = 3/6 = 1/2

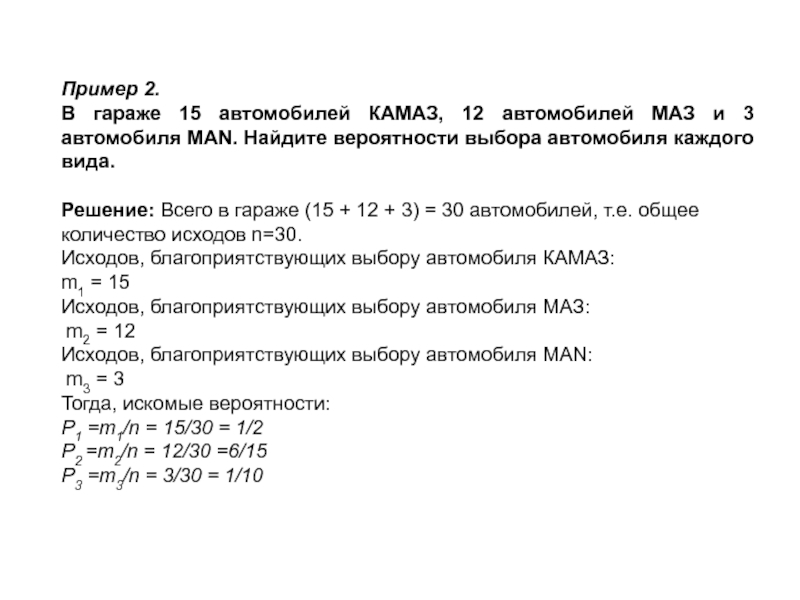

Слайд 28Пример 2.

В гараже 15 автомобилей КАМАЗ, 12 автомобилей МАЗ и 3

Решение: Всего в гараже (15 + 12 + 3) = 30 автомобилей, т.е. общее количество исходов n=30.

Исходов, благоприятствующих выбору автомобиля КАМАЗ:

m1 = 15

Исходов, благоприятствующих выбору автомобиля МАЗ:

m2 = 12

Исходов, благоприятствующих выбору автомобиля MAN:

m3 = 3

Тогда, искомые вероятности:

P1 =m1/n = 15/30 = 1/2

P2 =m2/n = 12/30 =6/15

P3 =m3/n = 3/30 = 1/10

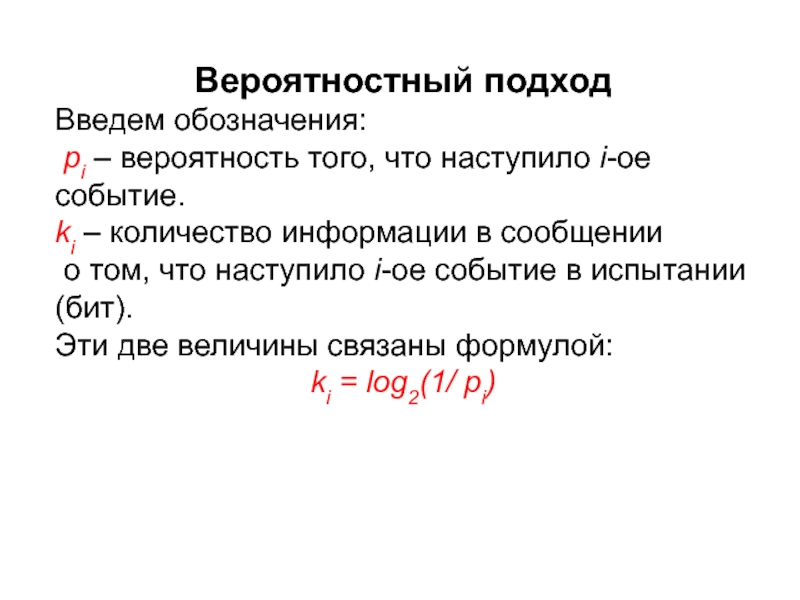

Слайд 29Вероятностный подход

Введем обозначения:

pi – вероятность того, что наступило i-ое событие.

ki

о том, что наступило i-ое событие в испытании (бит).

Эти две величины связаны формулой:

ki = log2(1/ pi)

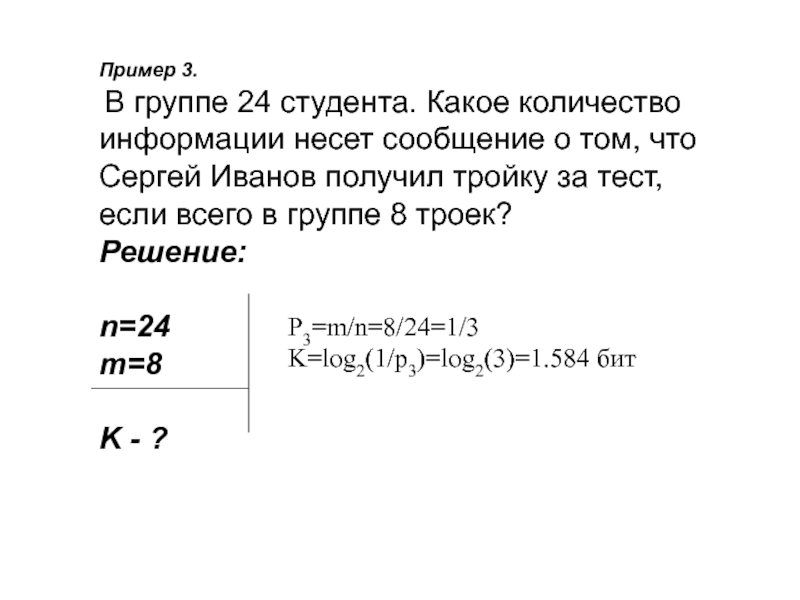

Слайд 30Пример 3.

В группе 24 студента. Какое количество информации несет

Решение:

n=24

m=8

K - ?

P3=m/n=8/24=1/3

K=log2(1/p3)=log2(3)=1.584 бит

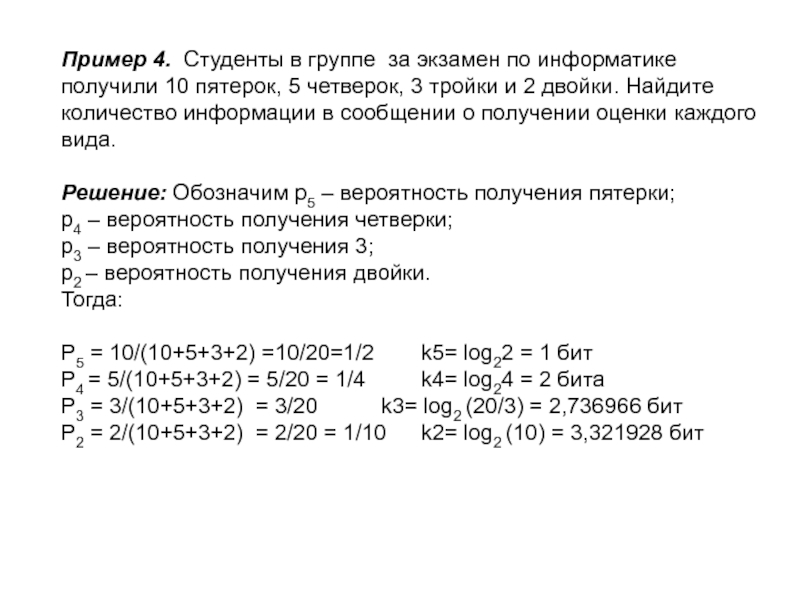

Слайд 31Пример 4. Студенты в группе за экзамен по информатике получили 10

Решение: Обозначим р5 – вероятность получения пятерки;

р4 – вероятность получения четверки;

р3 – вероятность получения 3;

р2 – вероятность получения двойки.

Тогда:

Р5 = 10/(10+5+3+2) =10/20=1/2 k5= log22 = 1 бит

P4 = 5/(10+5+3+2) = 5/20 = 1/4 k4= log24 = 2 бита

P3 = 3/(10+5+3+2) = 3/20 k3= log2 (20/3) = 2,736966 бит

P2 = 2/(10+5+3+2) = 2/20 = 1/10 k2= log2 (10) = 3,321928 бит

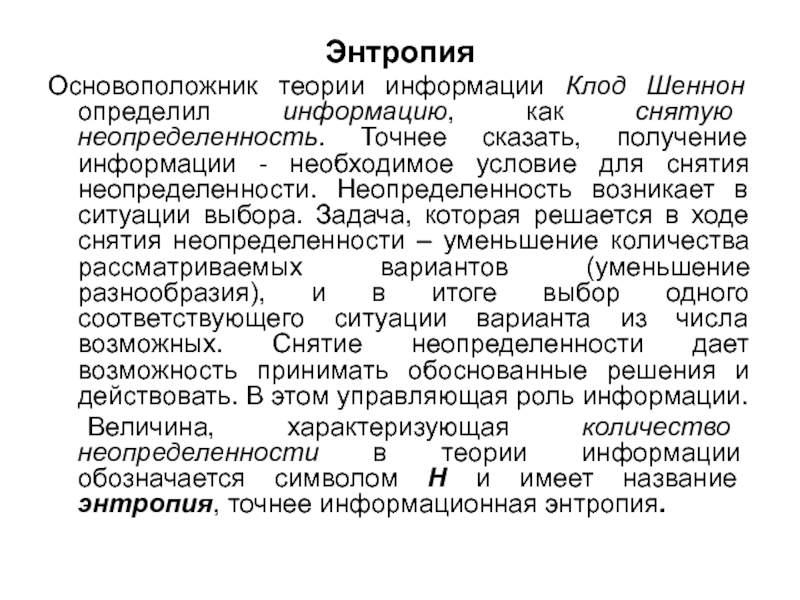

Слайд 32Энтропия

Основоположник теории информации Клод Шеннон определил информацию, как снятую неопределенность. Точнее

Величина, характеризующая количество неопределенности в теории информации обозначается символом H и имеет название энтропия, точнее информационная энтропия.

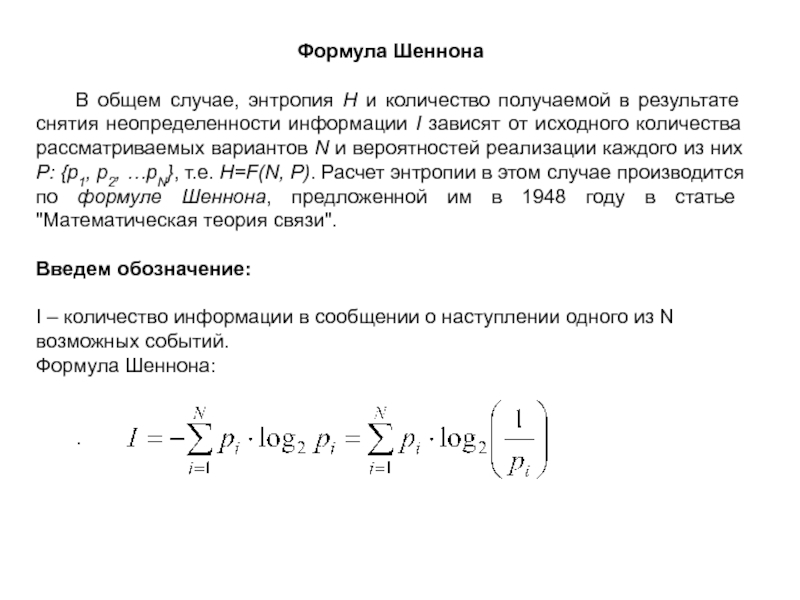

Слайд 33Формула Шеннона

В общем случае, энтропия H и количество получаемой в результате

Введем обозначение:

I – количество информации в сообщении о наступлении одного из N возможных событий.

Формула Шеннона:

.

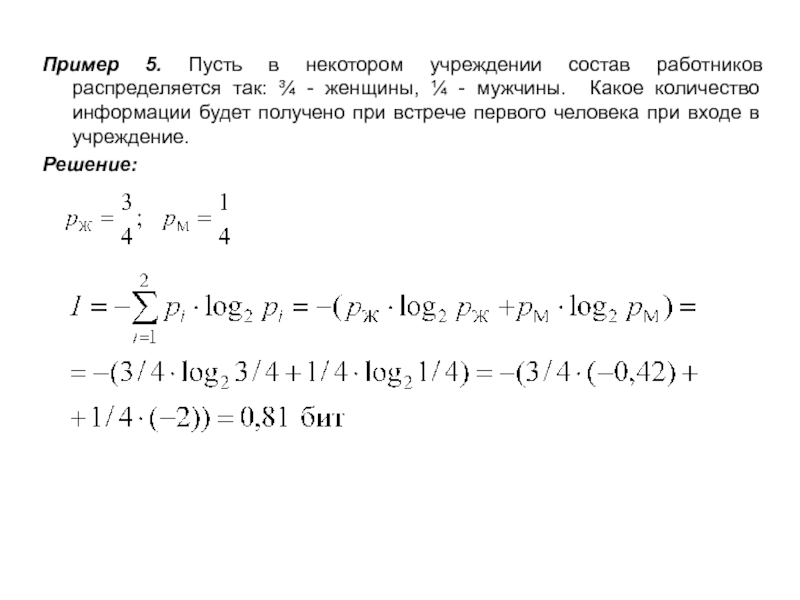

Слайд 34Пример 5. Пусть в некотором учреждении состав работников распределяется так: ¾

Решение: