- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Гибкий web-crawler презентация

Содержание

- 1. Гибкий web-crawler

- 2. Схема доклада Введение. Объект и цель исследования.

- 3. Web-crawler это.. Инструмент для разных целей Основная

- 4. Кому и для чего это надо? Web-мастерам

- 5. Сбор данных Индексация вручную (copy-paste). Рутинная работа.

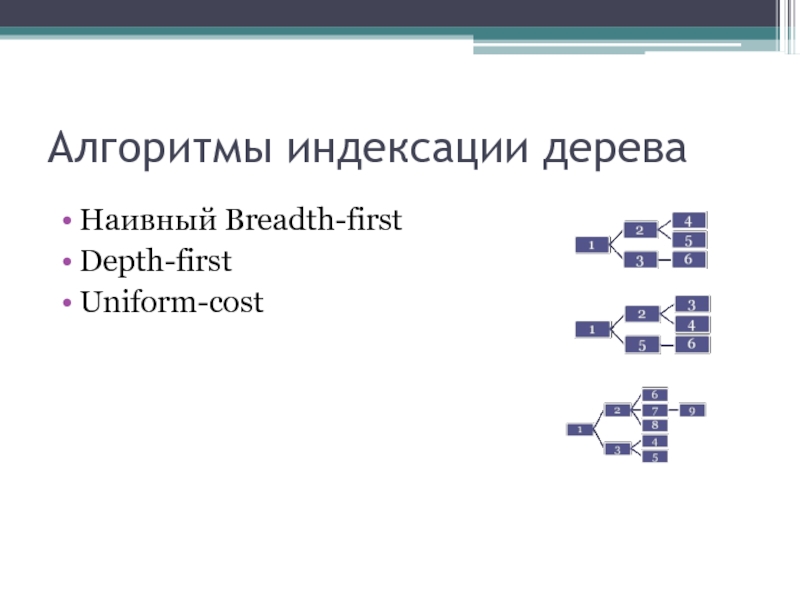

- 6. Алгоритмы индексации дерева Наивный Breadth-first Depth-first Uniform-cost

- 7. Ограничения индексации Необходимы из-за физических ограничений сервера

- 8. Web-crawler как часть большего Selection, revisit policy

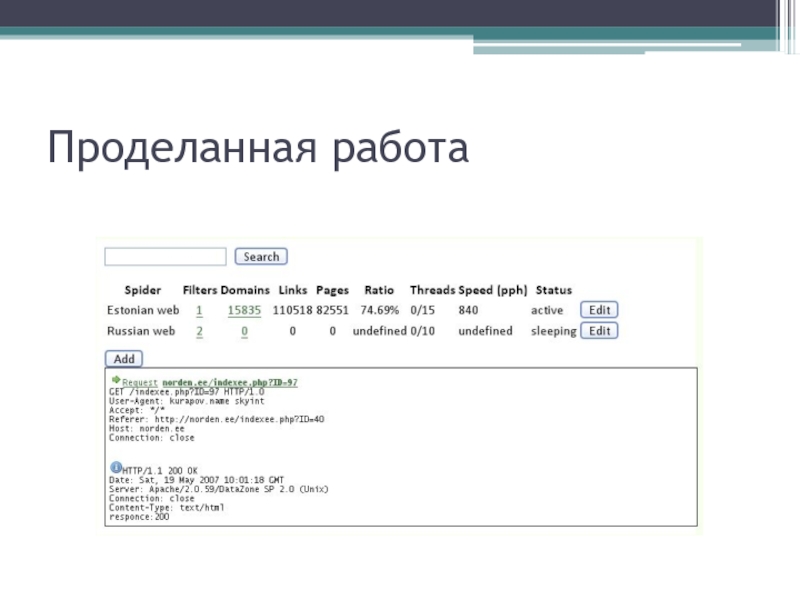

- 9. Проделанная работа

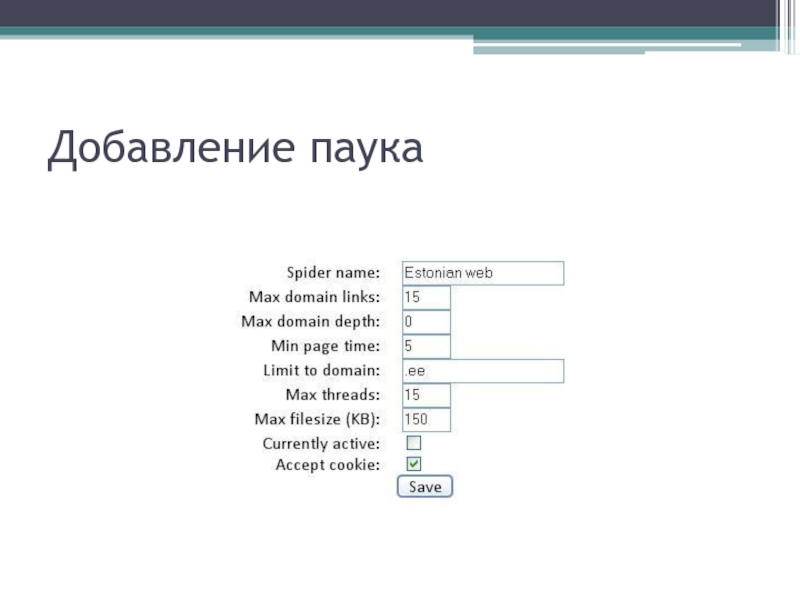

- 10. Добавление паука

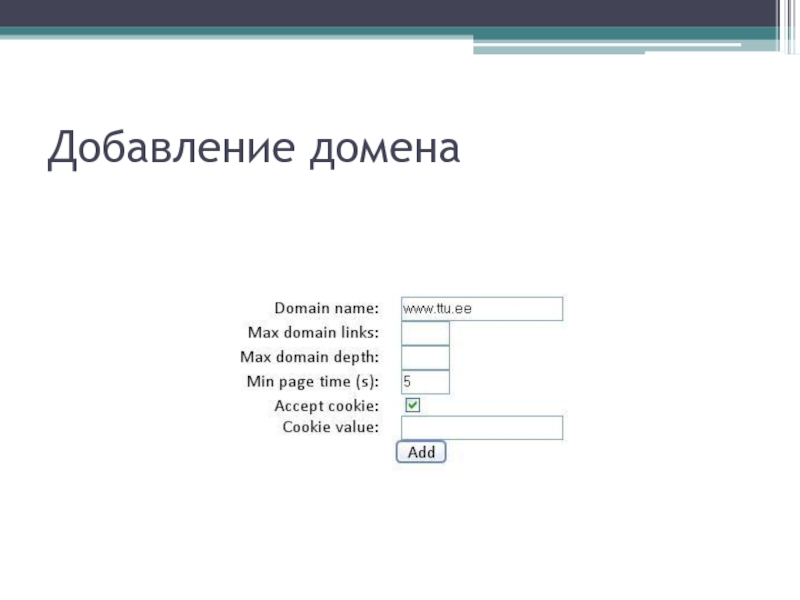

- 11. Добавление домена

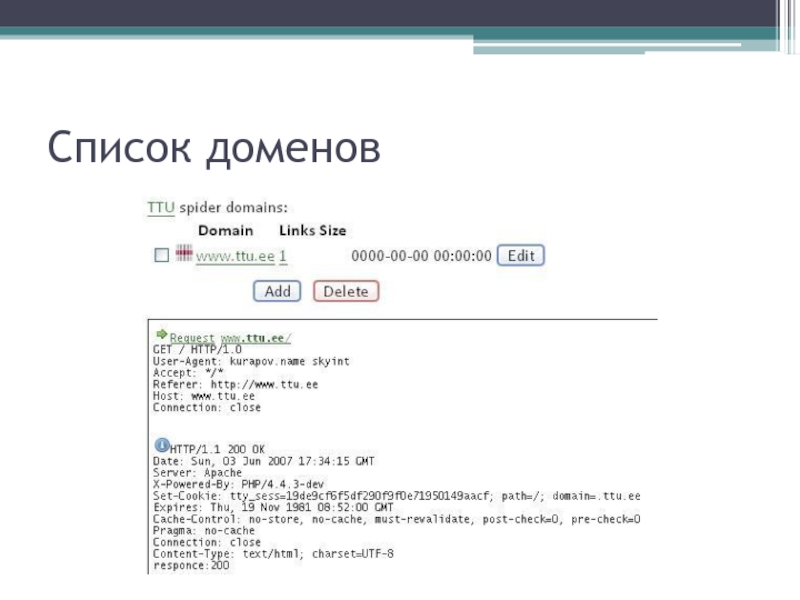

- 12. Список доменов

- 13. Взгляд изнутри MySQL 5 PHP5

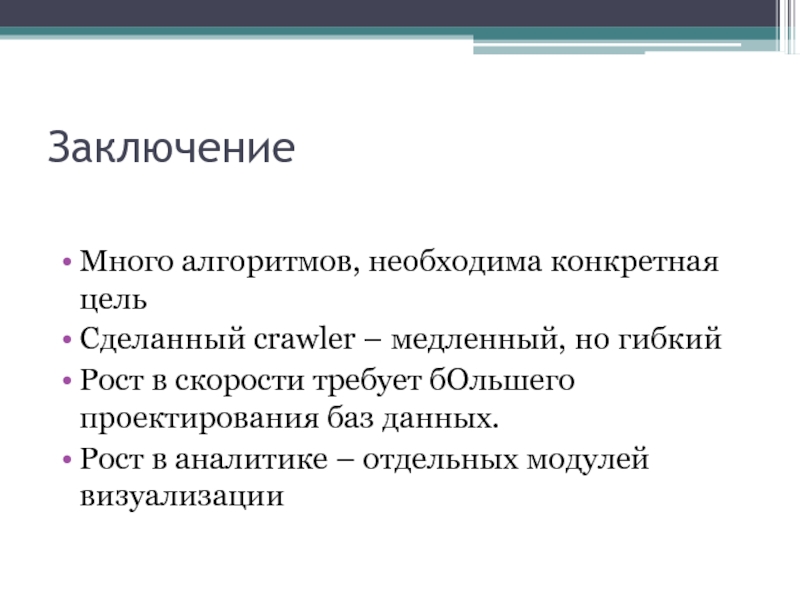

- 14. Заключение Много алгоритмов, необходима конкретная цель

- 15. The end

- 16. Замена PHP ASP JSP CGI Perl

- 17. PHP популярность

Слайд 2Схема доклада

Введение. Объект и цель исследования.

Способы решения проблемы. Алгоритмы индексации и

упрядочивания данных. Взгляды на выборку, перепросмотр и распределение нагрузки.

Проделанная работа. Особенности и жертвы разработки.

Заключение и выводы.

Проделанная работа. Особенности и жертвы разработки.

Заключение и выводы.

Слайд 3Web-crawler это..

Инструмент для разных целей

Основная цель – сбор данных для поиска

по ним

Косвенные цели – анализ документов в целом

Косвенные цели – анализ документов в целом

Слайд 4Кому и для чего это надо?

Web-мастерам среднего уровня со знаниями основ

LAMP (для образования)

Аналитикам, администраторам, архитекторам (для планирования)

Создателям информации (для сбора фактов)

Аналитикам, администраторам, архитекторам (для планирования)

Создателям информации (для сбора фактов)

Слайд 5Сбор данных

Индексация вручную (copy-paste). Рутинная работа.

Автоматическая индексация.

Основная проблема – алгоритм индексации.

Оценка

полученных данных для дальнейшего отображения

Слайд 7Ограничения индексации

Необходимы из-за физических ограничений сервера в случае неизвестного числа документов

Естественное

ограничение – новые технологии flash, video, java applet, javascript, необходимость авторизации, captcha

Настраивыемые ограничения (глубина,число документов, тип ресурсов)

Настраивыемые ограничения (глубина,число документов, тип ресурсов)

Слайд 8Web-crawler как часть большего

Selection, revisit policy

Лёгкость интеграции

Возможность расширения (параллелизация) за счёт

многопоточности (crontab) : скорость и нагрузка

Внешние системы обработки данных – video, image, audio, xml, rdf..

Внешние системы обработки данных – video, image, audio, xml, rdf..

Слайд 13Взгляд изнутри

MySQL 5

PHP5

Apache 2

nnCron

проиндексировано 80 тыс

страниц

1-2 страницы в секунду

Open Source

1-2 страницы в секунду

Open Source

Слайд 14Заключение

Много алгоритмов, необходима конкретная цель

Сделанный crawler – медленный, но гибкий

Рост в

скорости требует бОльшего проектирования баз данных.

Рост в аналитике – отдельных модулей визуализации

Рост в аналитике – отдельных модулей визуализации