- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

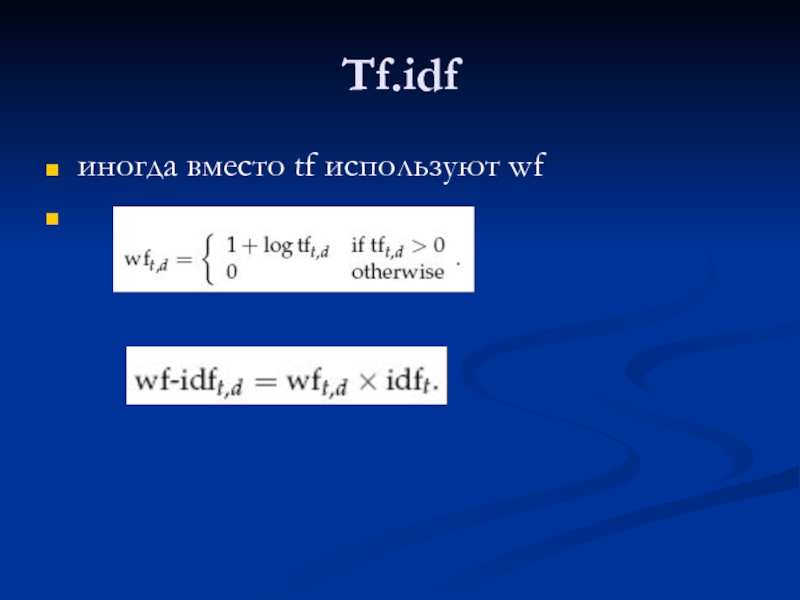

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Статистические оценки семантических и других лингвистических свойств слов презентация

Содержание

- 1. Статистические оценки семантических и других лингвистических свойств слов

- 2. Частотные словари Информацию о каких словах следует

- 3. Частотное поведение слова Позиция в частотном спектре:

- 4. Частотные словари В Частотный словарь приводится либо

- 5. Частотные словари Для русского языка было разработано

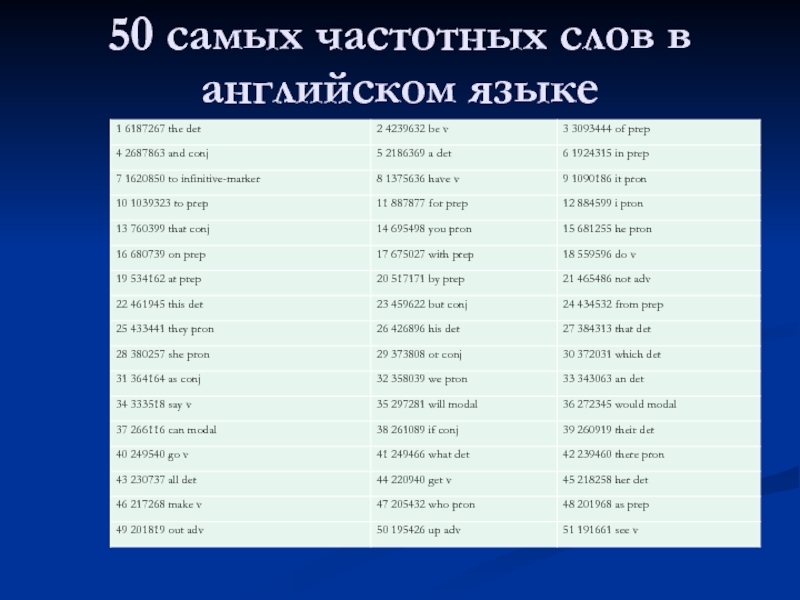

- 6. 50 самых частотных слов в английском языке

- 7. Частоты слов, полученные по выборке, должны

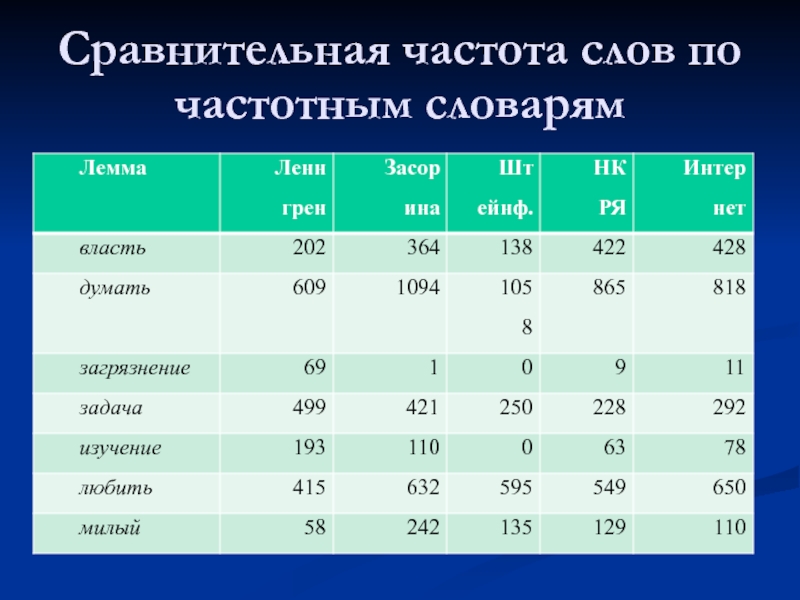

- 8. Сравнительная частота слов по частотным словарям

- 9. Частотные словари Если слово встретилось в тексте

- 10. Частотные словари Корпус большего размера, отражающий большее

- 11. Частотные словари Поскольку задачей частотного словаря является

- 12. Чешский национальный корпус: средняя уменьшенная частота

- 13. Частотные словари слова жуткий, специфический и сырье

- 14. Частотные словари: «значимая» лексика Частотные словари функциональных

- 15. Информационный поиск (индексирование документа, поиск документа,

- 16. Весовые функции частота (вероятность) документная частота tf.idf

- 17. Используемые модели Задачи выявления лексических (грамматических) свойств

- 18. Модель «мешок слов» - векторная модель документа

- 19. Информационный поиск (ИП) Модель поиска: Задача:

- 20. Признаки: координаты в пространстве Близость

- 21. Для построения пространства терминов обычно используются основы

- 22. Ключевые вопросы: Как выбирать размерность пространства

- 23. попытаемся определить список значимых слов: Законы Зипфа

- 25. Смысл абзаца очень точно выражают слова: зипфа,

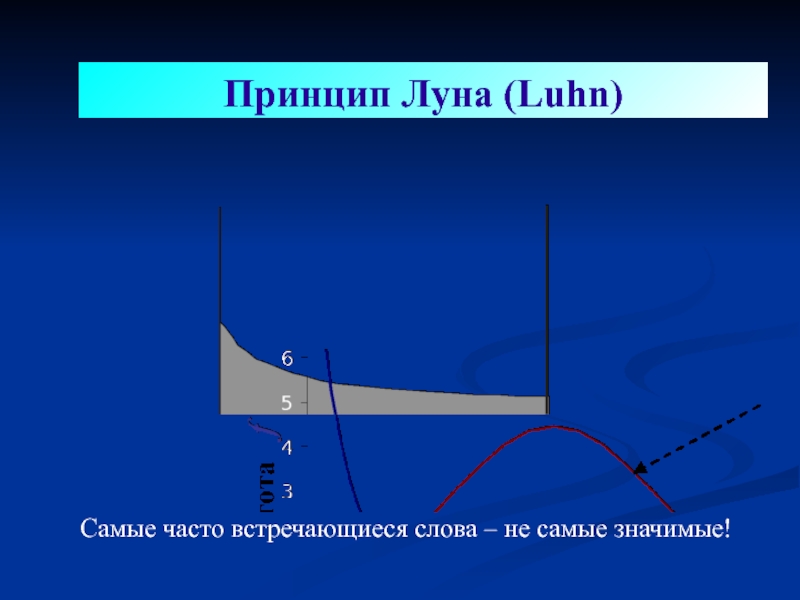

- 26. Принцип Луна (Luhn) Самые часто встречающиеся слова – не самые значимые!

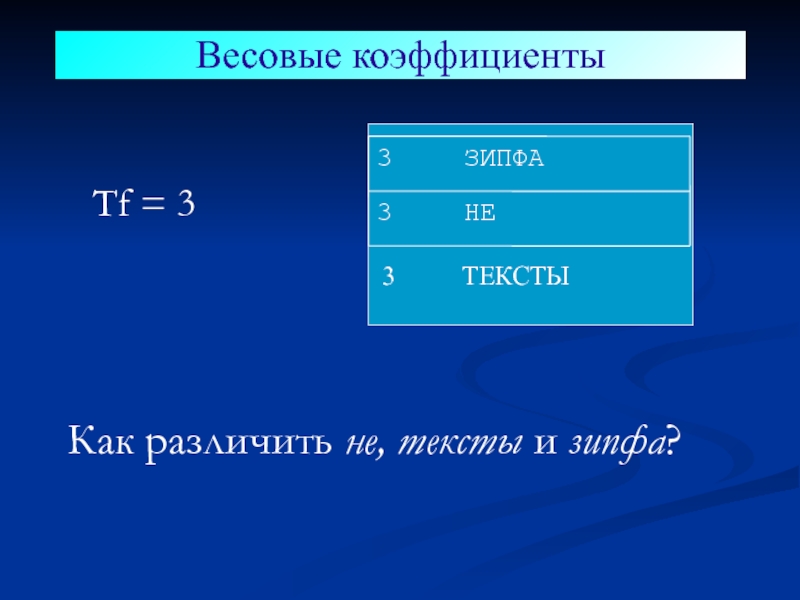

- 27. Как различить не, тексты и зипфа?

- 28. idf: Инверсная частота термина i = log

- 29. Поисковая машина может строить весовые коэффициенты с

- 30. Расчет tf x idf

- 31. Все документы базы данных размещаются в воображаемом

- 32. Документы и запросы представляются в виде векторов

- 33. Составим запрос: корабли в бутылках.

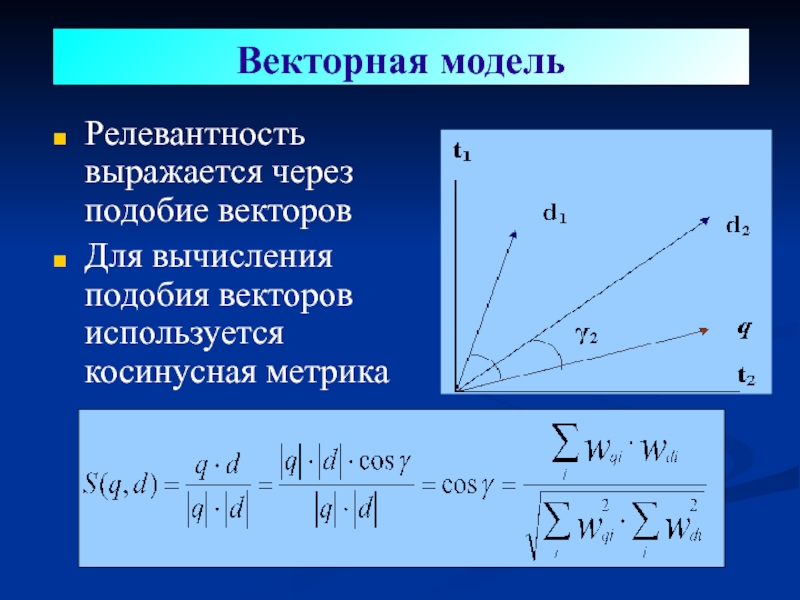

- 34. Релевантность выражается через подобие векторов Для

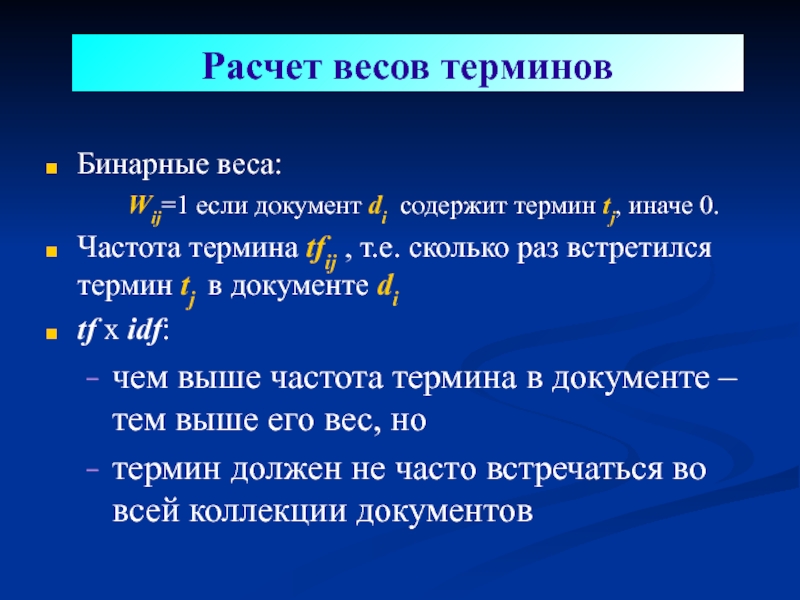

- 35. Бинарные веса: Wij=1 если документ di

- 36. Tf.idf иногда вместо tf используют wf

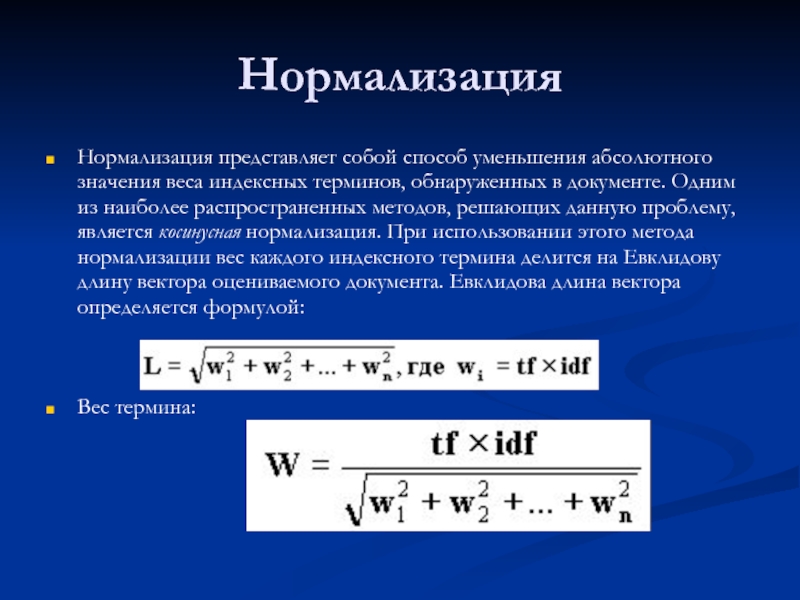

- 37. Нормализация Нормализация представляет собой способ уменьшения

- 38. Нормализация Один из способов нормализации оценки по

- 39. Нормализация по длине документа K1 и b

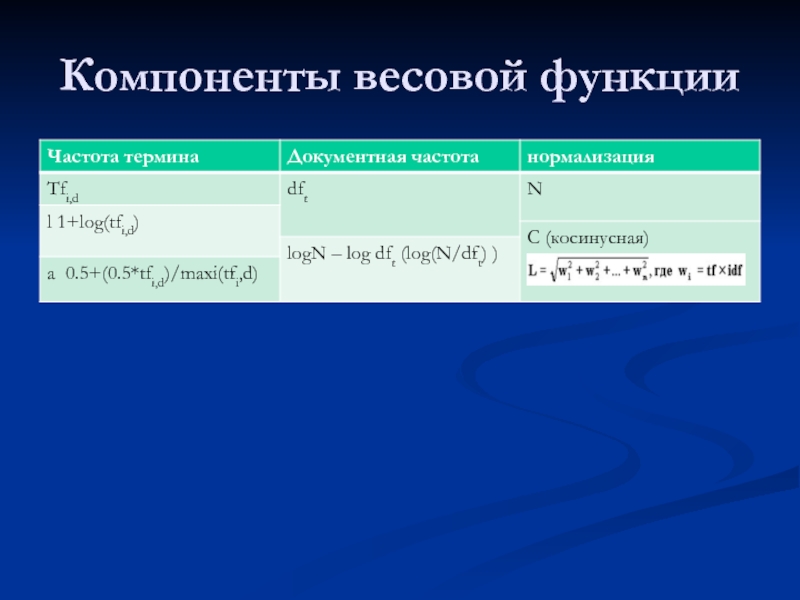

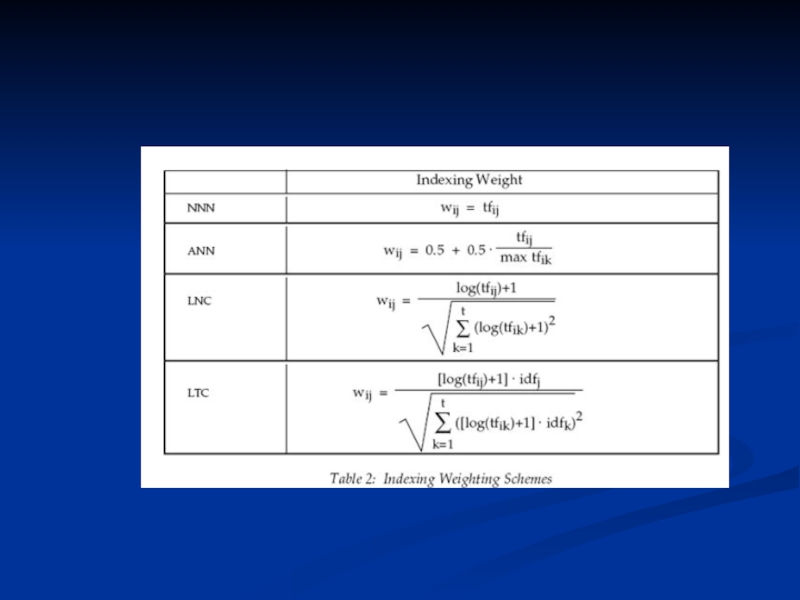

- 40. Компоненты весовой функции

- 42. Расчет тематического веса на основе вероятностной модели

- 43. Вероятностная модель в 1977 году Robertson и

- 44. Вероятностная модель В работах Букштейна, Свенсона и

- 45. Вероятностная модель Допущения: Вероятность термина в (коротком)

- 46. Вероятностная модель Оценки для 6 слов из

- 47. Оценка на основе обратной документной частоты Оценка

- 48. Residual inverse document frequency Разница между логарифмом

- 49. Вероятностная модель Пусть запрос – это множество

- 50. Вероятностная модель Но: нам

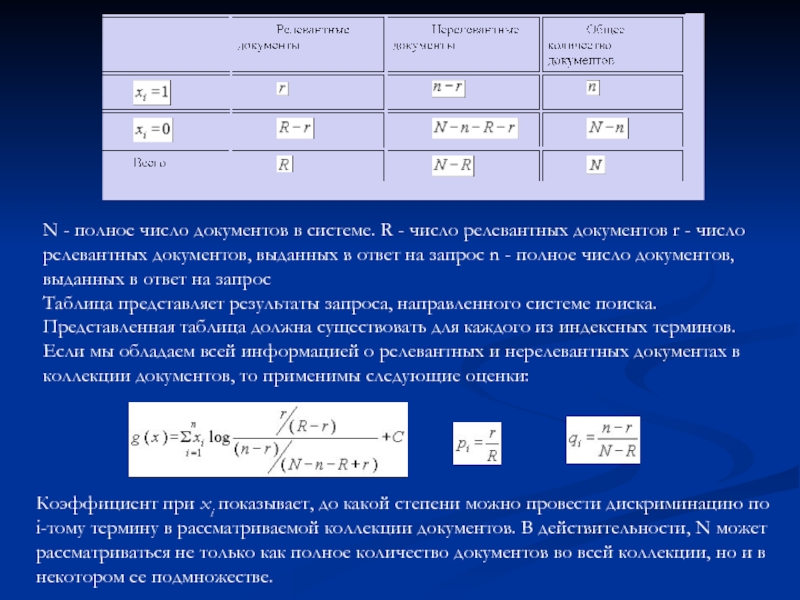

- 51. N - полное число документов в системе.

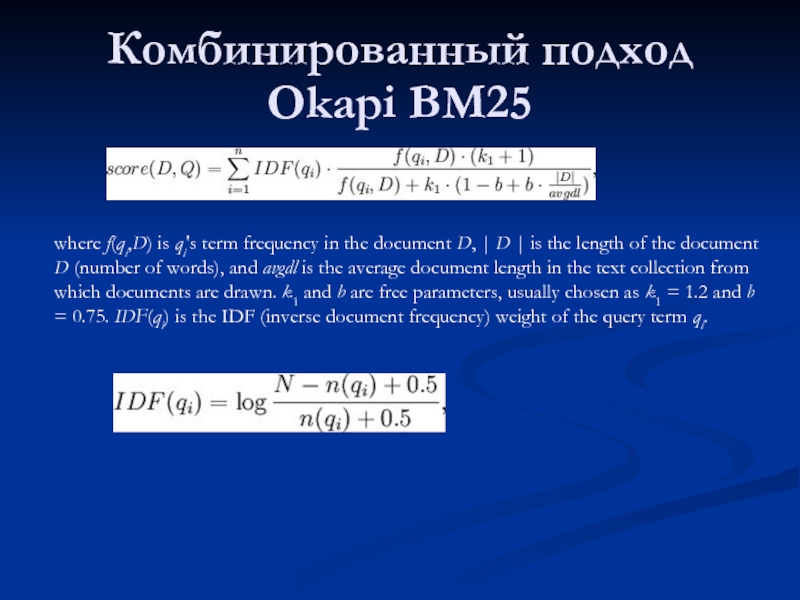

- 52. Комбинированный подход Okapi BM25 where f(qi,D)

- 53. Векторная модель: «Для построения пространства терминов

- 54. Вероятностные модели Заключаются в оценке вероятности

- 55. “Информационная” модель Она базируется на теория информации

- 56. The Term Discrimination Value Оценка строится

- 57. The Term Discrimination Value В соответствии

Слайд 2Частотные словари

Информацию о каких словах следует включать?

Как оценивать информацию о частотности

Как выделять значимые слова?

Слайд 3Частотное поведение слова

Позиция в частотном спектре: низкоранговое (высокочастотное) vs. низкочастотное

ipm, wpm

Слайд 4Частотные словари

В Частотный словарь приводится либо f (x), либо нормированная частота

где N — число исследованных слов текста. Относительной характеристикой употребительности лексической единицы является либо её ранг (число лексических единиц, которые в данном Частотный словарь имеют абсолютную характеристику употребительности, более высокую или равную абсолютной характеристике данной лексической единицы), либо какой-либо признак, по которому ранг может быть вычислен с большей или меньшей точностью. В большинстве Частотный словарь приводятся и абсолютные, и относительные характеристики. Частотный словарь используются для создания эффективных методик обучения языку, для выделения ключевых слов (в информатике), для создания рациональных кодов (в теории связи).

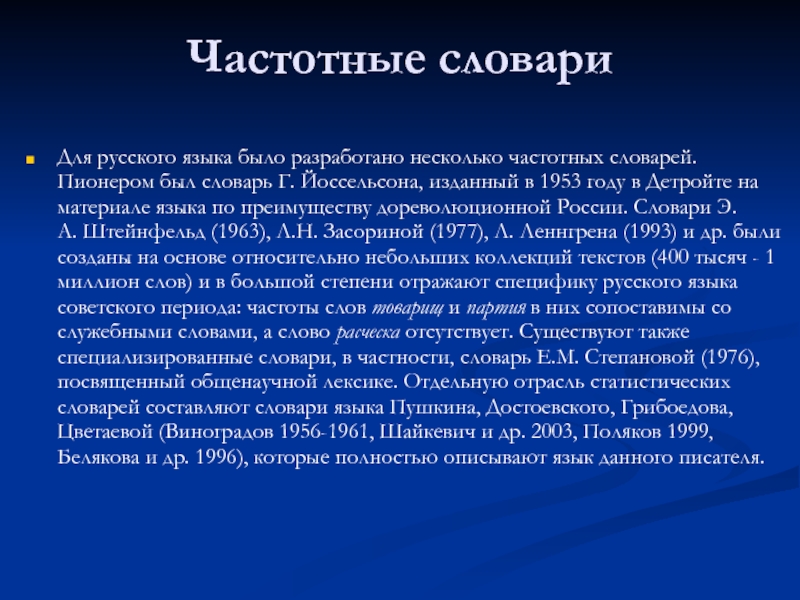

Слайд 5Частотные словари

Для русского языка было разработано несколько частотных словарей. Пионером был

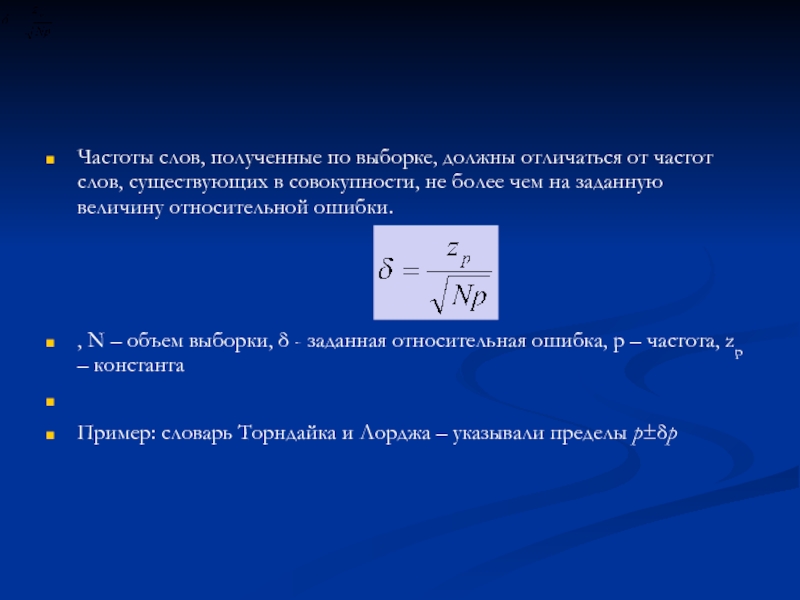

Слайд 7

Частоты слов, полученные по выборке, должны отличаться от частот слов, существующих

, N – объем выборки, δ - заданная относительная ошибка, p – частота, zp – константа

Пример: словарь Торндайка и Лорджа – указывали пределы p±δp

Слайд 9Частотные словари

Если слово встретилось в тексте один раз, то при нормальном

Слайд 10Частотные словари

Корпус большего размера, отражающий большее количество тем и функциональных стилей

Слайд 11Частотные словари

Поскольку задачей частотного словаря является не просто ранжировать слова по

Слайд 12

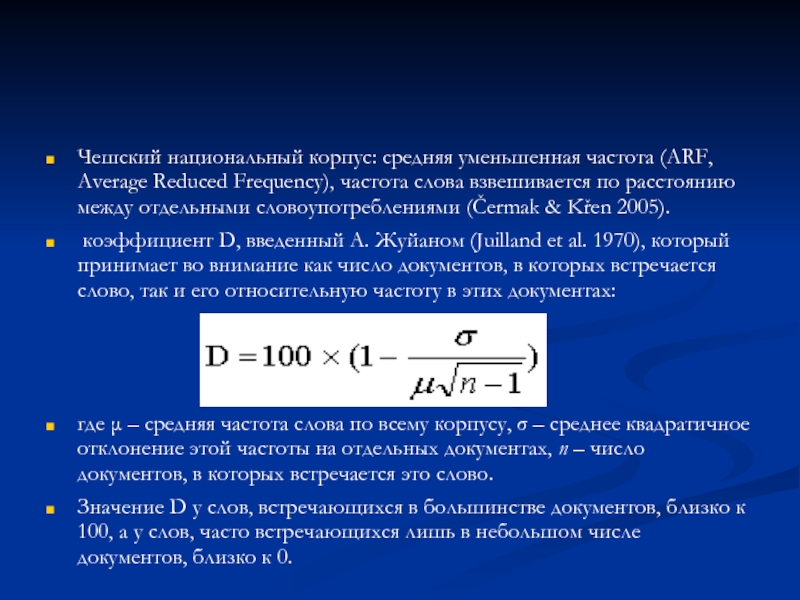

Чешский национальный корпус: средняя уменьшенная частота (ARF, Average Reduced Frequency), частота

коэффициент D, введенный А. Жуйаном (Juilland et al. 1970), который принимает во внимание как число документов, в которых встречается слово, так и его относительную частоту в этих документах:

где μ – средняя частота слова по всему корпусу, σ – среднее квадратичное отклонение этой частоты на отдельных документах, n – число документов, в которых встречается это слово.

Значение D у слов, встречающихся в большинстве документов, близко к 100, а у слов, часто встречающихся лишь в небольшом числе документов, близко к 0.

Слайд 13Частотные словари

слова жуткий, специфический и сырье имеют примерно равную частоту (21

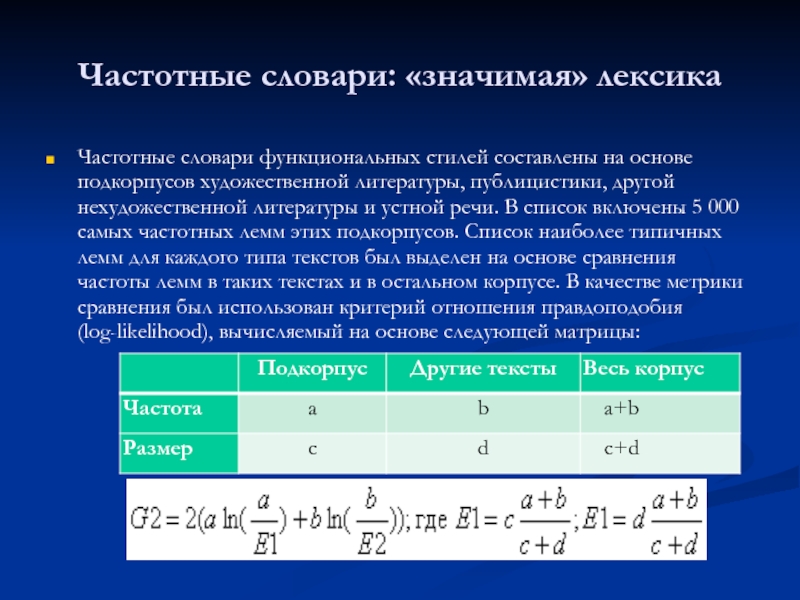

Слайд 14Частотные словари: «значимая» лексика

Частотные словари функциональных стилей составлены на основе подкорпусов

Слайд 15

Информационный поиск (индексирование документа, поиск документа, близкого (наиболее релевантного) запросу);

Компьютерная лексикография

грамматическая разметка (снятие грамматической омонимии)

Слайд 16Весовые функции

частота (вероятность)

документная частота

tf.idf

меры «близости» / различия (дифференцирующая функция):

Коэффициенты

T-score

MI-score

LogLikelihood Ratio

Хи-квадрат

Косинусная

Коэффициенты корреляции

Слайд 17Используемые модели

Задачи выявления лексических (грамматических) свойств языковых элементов (/ текстов) сводятся

кластеризации и классификации

Векторное пространство

Вероятностные модели

«Языковые» модели (марковские модели)

Энтропийные модели

Слайд 18Модель «мешок слов» - векторная модель документа

Вероятностная модель

Информационная модель

И др.

Тематическая значимость

Слайд 19Информационный поиск (ИП)

Модель поиска:

Задача: найти Х

Задача 1: создать поисковый образ

выделить множество диагностических парметров

Задача 2: сравнить объекты и найти образы объектов «максимально близкие» к искомому образу

Слайд 20Признаки:

координаты в пространстве

Близость (подобие):

близость в пространстве

Поисковый образ:

вектор в пространстве

Векторная модель

Слайд 21Для построения пространства терминов обычно используются основы слов, отдельные слова, а

Документы и запросы представляются в виде векторов, компоненты которых соответствуют весам терминов wt.

Чем больше используется терминов, тем сложнее понять какие подмножества слов являются общими для подобных документов.

Векторная модель

Слайд 22Ключевые вопросы:

Как выбирать размерность пространства терминов N ?

Как вычислять весовые коэффициенты

Векторная модель

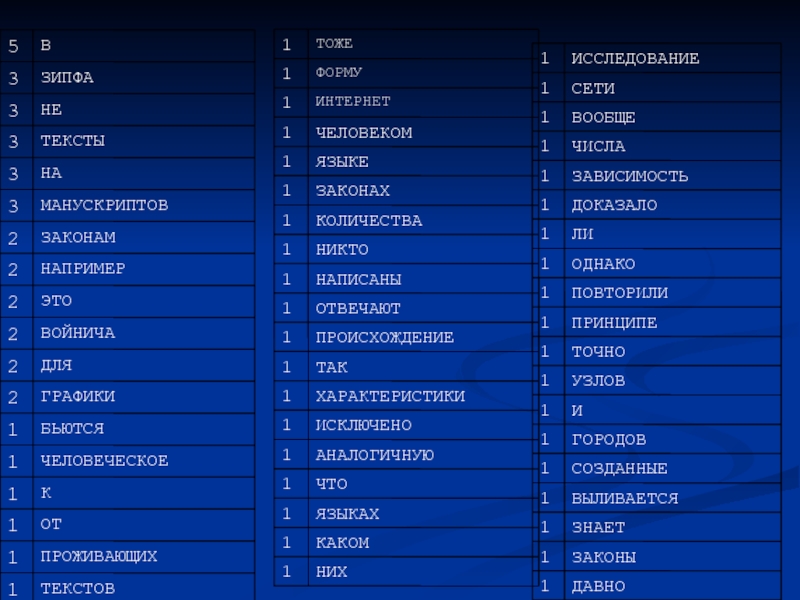

Слайд 23попытаемся определить список значимых слов:

Законы Зипфа универсальны. В принципе, они применимы

Векторная модель: весовые коэффициенты

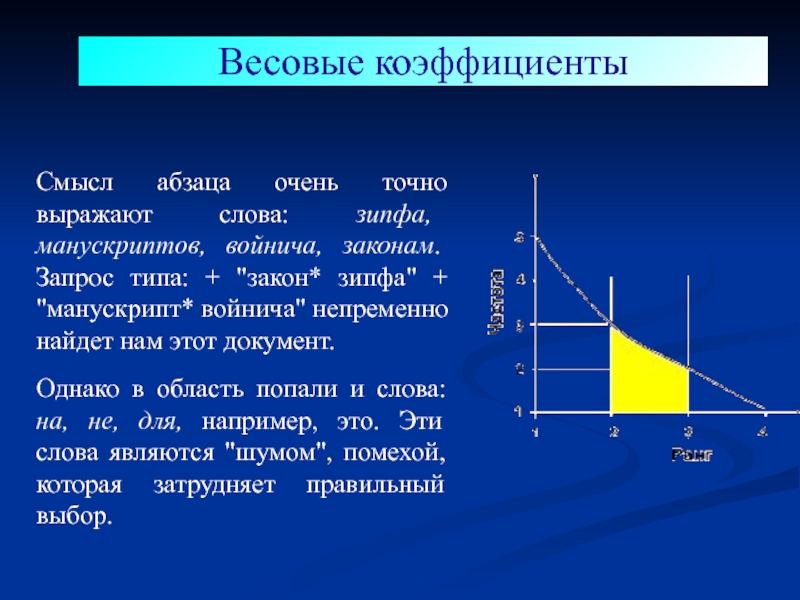

Слайд 25Смысл абзаца очень точно выражают слова: зипфа, манускриптов, войнича, законам. Запрос

Однако в область попали и слова: на, не, для, например, это. Эти слова являются "шумом", помехой, которая затрудняет правильный выбор.

Весовые коэффициенты

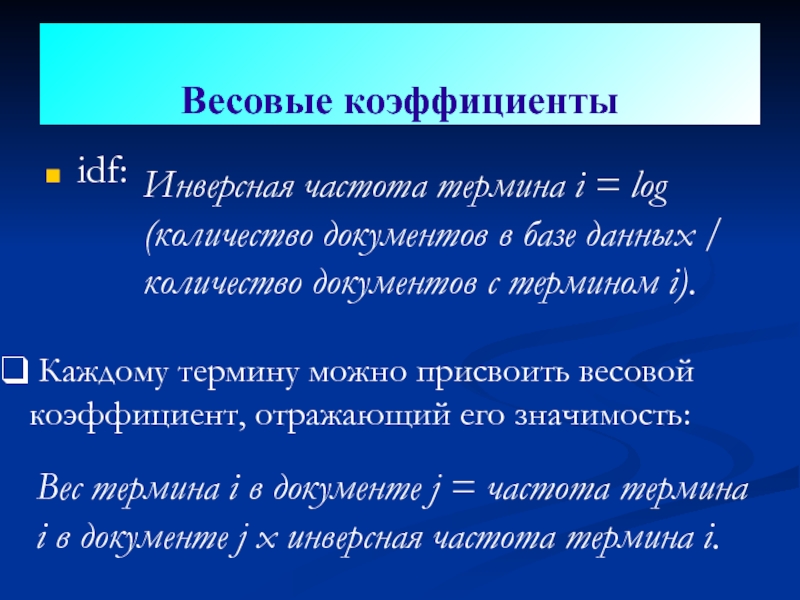

Слайд 28idf:

Инверсная частота термина i = log (количество документов в базе данных

Весовые коэффициенты

Каждому термину можно присвоить весовой коэффициент, отражающий его значимость:

Вес термина i в документе j = частота термина i в документе j х инверсная частота термина i.

Слайд 29Поисковая машина может строить весовые коэффициенты с учетом местоположения термина внутри

Весовые коэффициенты

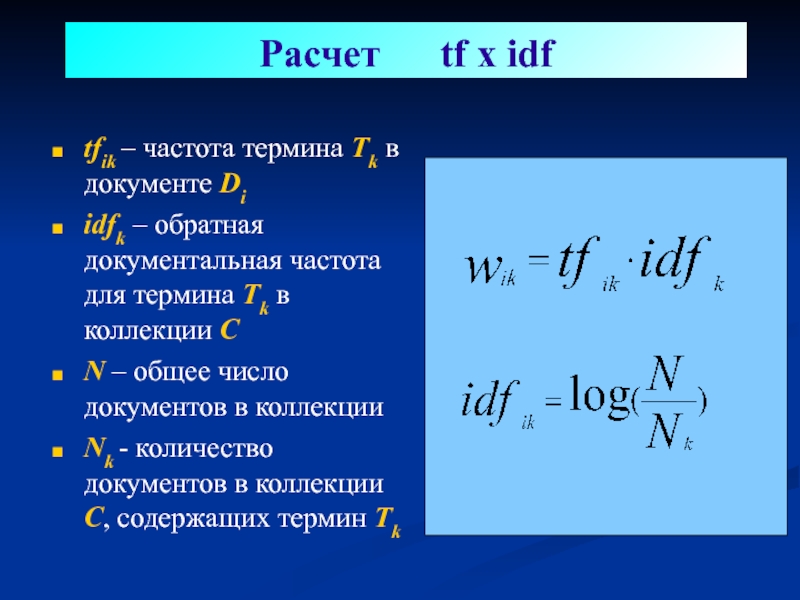

Слайд 30

Расчет tf x idf

tfik – частота термина Tk в

idfk – обратная документальная частота для термина Tk в коллекции С

N – общее число документов в коллекции

Nk - количество документов в коллекции C, содержащих термин Tk

Слайд 31Все документы базы данных размещаются в воображаемом пространстве.

Координаты каждого документа

В результате окажется, что документы с похожим набором терминов разместятся в пространстве ближе друг к другу

Векторная модель

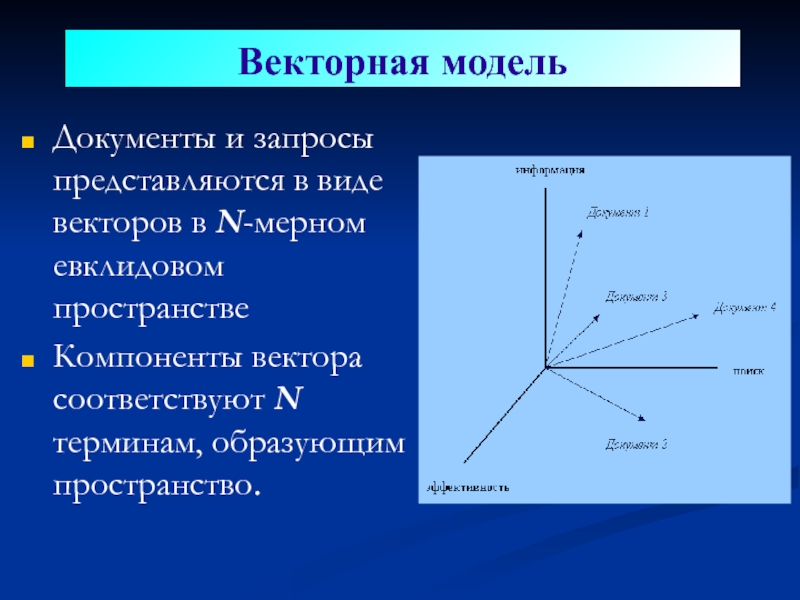

Слайд 32Документы и запросы представляются в виде векторов в N-мерном евклидовом пространстве

Компоненты

Векторная модель

Слайд 33Составим запрос:

корабли в бутылках.

Получив его, поисковая система удалит лишние

Векторная модель

Слайд 34

Релевантность выражается через подобие векторов

Для вычисления подобия векторов используется косинусная метрика

Векторная

Слайд 35Бинарные веса:

Wij=1 если документ di содержит термин tj, иначе 0.

Частота

tf x idf:

чем выше частота термина в документе – тем выше его вес, но

термин должен не часто встречаться во всей коллекции документов

Расчет весов терминов

Слайд 37Нормализация

Нормализация представляет собой способ уменьшения абсолютного значения веса индексных терминов,

Вес термина:

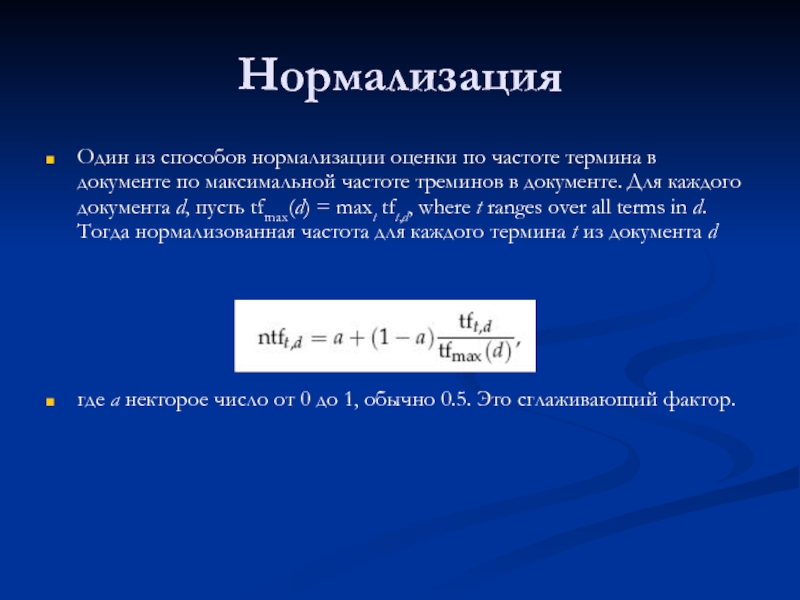

Слайд 38Нормализация

Один из способов нормализации оценки по частоте термина в документе по

где a некторое число от 0 до 1, обычно 0.5. Это сглаживающий фактор.

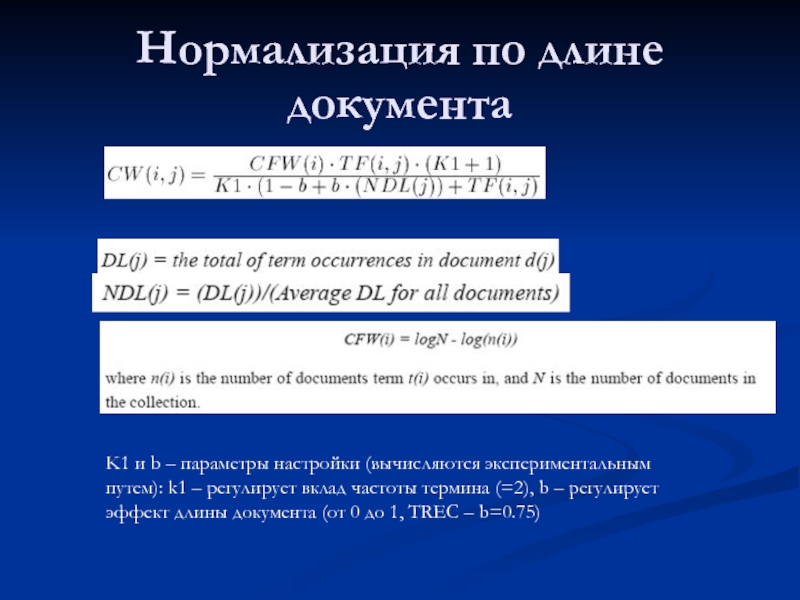

Слайд 39Нормализация по длине документа

K1 и b – параметры настройки (вычисляются экспериментальным

Слайд 42Расчет тематического веса на основе вероятностной модели информационного поиска

Идея в том,

(см., например, Manning, Christopher D., and Hinrich Schütze. 1999. Foundations of Statistical Natural) и др.)

Слайд 43Вероятностная модель

в 1977 году Robertson и Sparck-Jones (Робертсон и Спарк-Джоунз) обосновали

Слайд 44Вероятностная модель

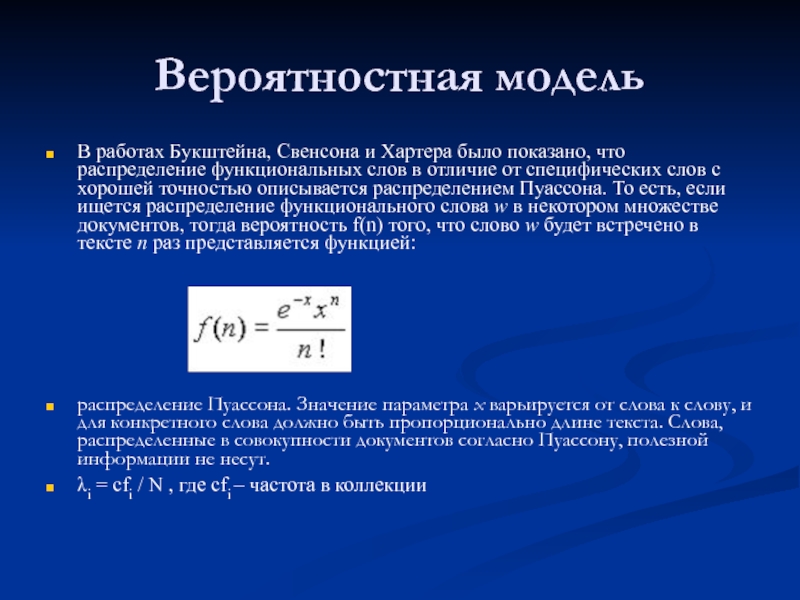

В работах Букштейна, Свенсона и Хартера было показано, что распределение

распределение Пуассона. Значение параметра x варьируется от слова к слову, и для конкретного слова должно быть пропорционально длине текста. Слова, распределенные в совокупности документов согласно Пуассону, полезной информации не несут.

λi = cfi / N , где cfi – частота в коллекции

Слайд 45Вероятностная модель

Допущения:

Вероятность термина в (коротком) фрагменте текста пропорциональна длине текста

Вероятность встретить

Вероятности встретить термин в непересекающихся фрагмеентах ткста независимы

Слайд 46Вероятностная модель

Оценки для 6 слов из корпуса New York Times

N(1-p(0;λi) –

Всего документов - 79291

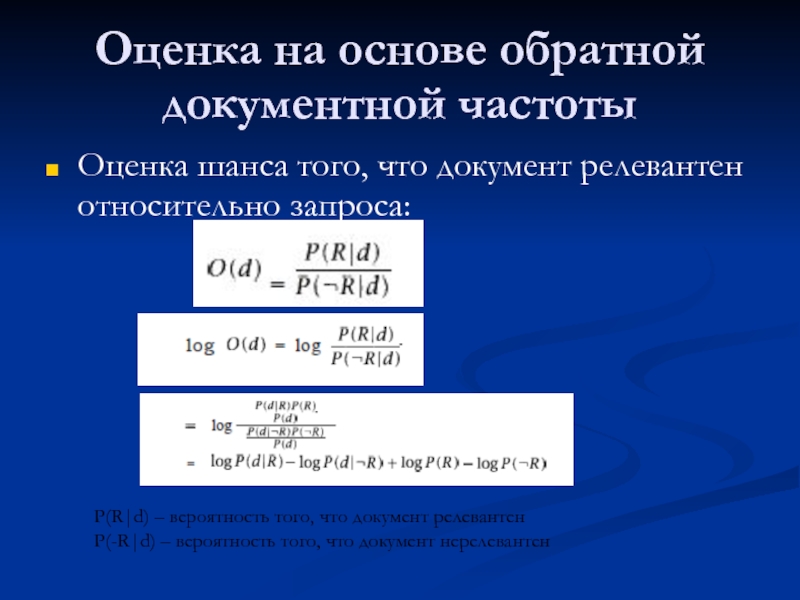

Слайд 47Оценка на основе обратной документной частоты

Оценка шанса того, что документ релевантен

P(R|d) – вероятность того, что документ релевантен

P(-R|d) – вероятность того, что документ нерелевантен

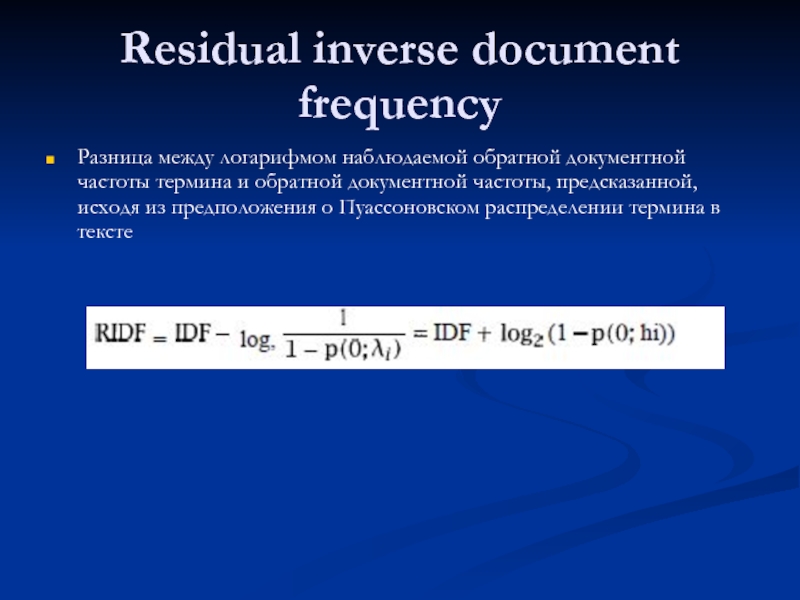

Слайд 48Residual inverse document frequency

Разница между логарифмом наблюдаемой обратной документной частоты термина

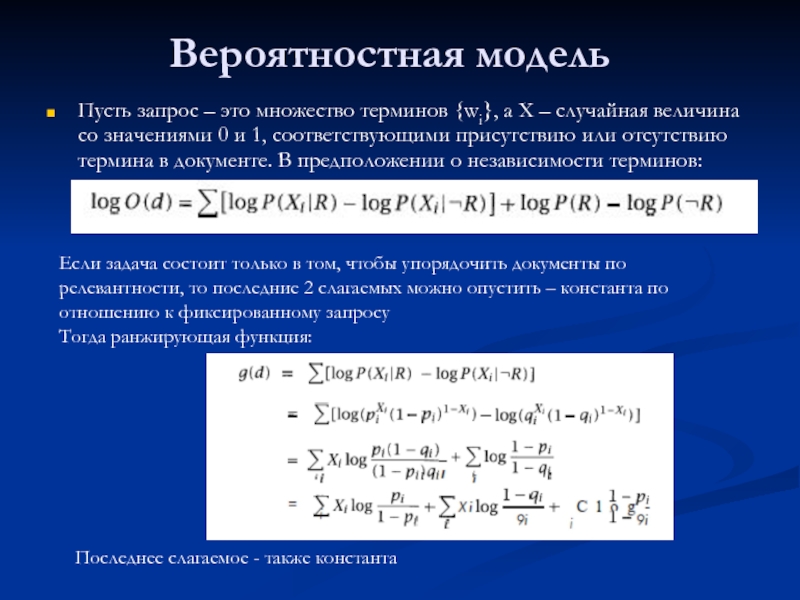

Слайд 49Вероятностная модель

Пусть запрос – это множество терминов {wi}, а X –

Если задача состоит только в том, чтобы упорядочить документы по релевантности, то последние 2 слагаемых можно опустить – константа по отношению к фиксированному запросу

Тогда ранжирующая функция:

Последнее слагаемое - также константа

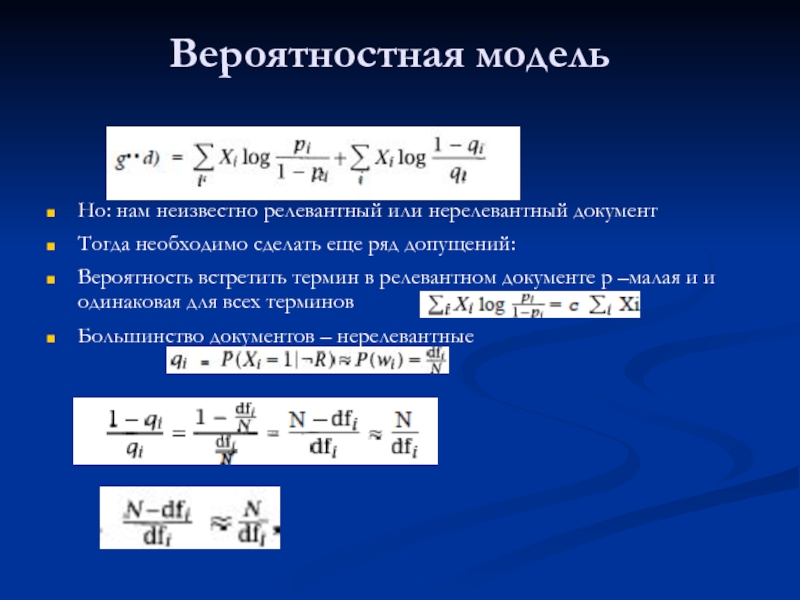

Слайд 50Вероятностная модель

Но: нам неизвестно релевантный или нерелевантный документ

Тогда необходимо сделать еще

Вероятность встретить термин в релевантном документе p –малая и и одинаковая для всех терминов

Большинство документов – нерелевантные

Слайд 51N - полное число документов в системе. R - число релевантных

Таблица представляет результаты запроса, направленного системе поиска. Представленная таблица должна существовать для каждого из индексных терминов.

Если мы обладаем всей информацией о релевантных и нерелевантных документах в коллекции документов, то применимы следующие оценки:

Коэффициент при xi показывает, до какой степени можно провести дискриминацию по i-тому термину в рассматриваемой коллекции документов. В действительности, N может рассматриваться не только как полное количество документов во всей коллекции, но и в некотором ее подмножестве.

Слайд 52Комбинированный подход

Okapi BM25

where f(qi,D) is qi's term frequency in the

Слайд 53

Векторная модель:

«Для построения пространства терминов обычно используются основы слов, отдельные слова,

Документы и запросы представляются в виде векторов, компоненты которых соответствуют весам терминов wt.

Чем больше используется терминов, тем сложнее понять какие подмножества слов являются общими для подобных документов»

Тематические веса расчитываются на основе частоты термина в документе и частоты термина по документам

Достоинства модели:

«Учет весов повышает эффективность поиска

Позволяет оценить степень соответствия документа запросу

Косинусная метрика удобна при ранжировании

Проблемы:

Нет достаточного теоретического обоснования для построения пространства терминов

Поскольку термины не являются независимыми друг от друга, то они не могут быть полностью ортогональными

Слайд 54

Вероятностные модели

Заключаются в оценке вероятности того, что документ d является релевантным

При ранжировании документов в выборке ключевым являет Принцип Ранжирования Вероятностей, согласно которому если каждый ответ поисковой системы представляет собой ранжированный по убыванию вероятности полезности для пользователя список документов, то общая эффективность системы для пользователей будет наилучшей.

Достоинства:

Хорошее теоретическое обоснование

При имеющейся информации дают наилучшие предсказания релевантности

Могут быть реализованы аналогично векторным моделям

Недостатки:

Требуется информация о релевантности или ее приближенные оценки

Структура документа описывается только терминами

Оптимальные результаты получаются только в процессе обучения на основе информации о релевантности

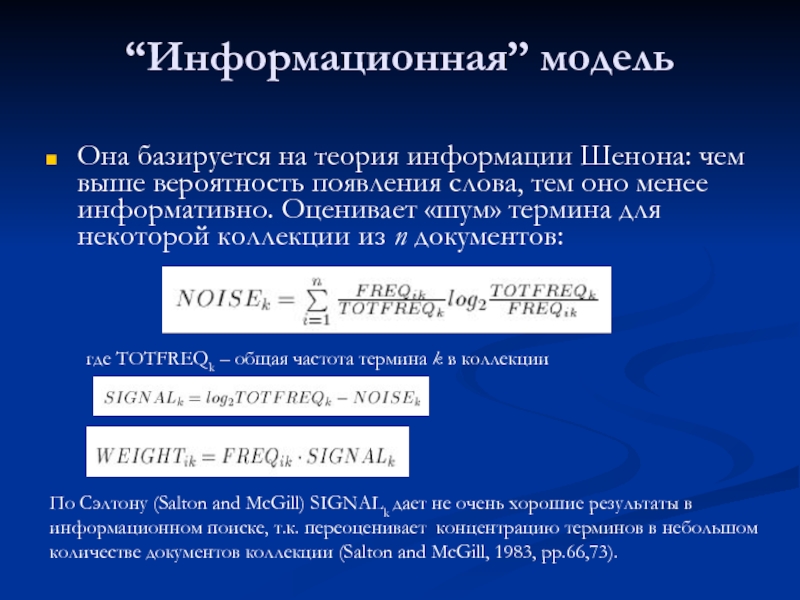

Слайд 55“Информационная” модель

Она базируется на теория информации Шенона: чем выше вероятность появления

где TOTFREQk – общая частота термина k в коллекции

По Сэлтону (Salton and McGill) SIGNALk дает не очень хорошие результаты в информационном поиске, т.к. переоценивает концентрацию терминов в небольшом количестве документов коллекции (Salton and McGill, 1983, pp.66,73).

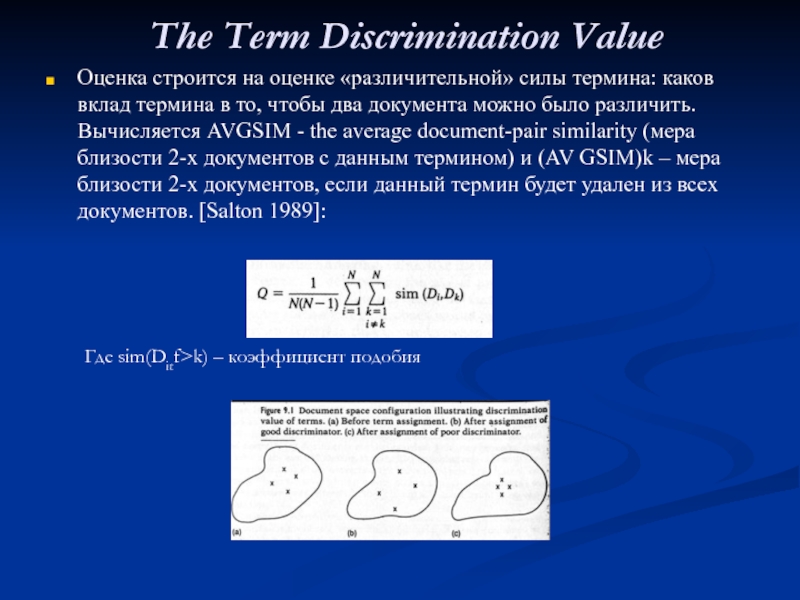

Слайд 56The Term Discrimination Value

Оценка строится на оценке «различительной» силы термина:

Где sim(Ditf>k) – коэффициент подобия

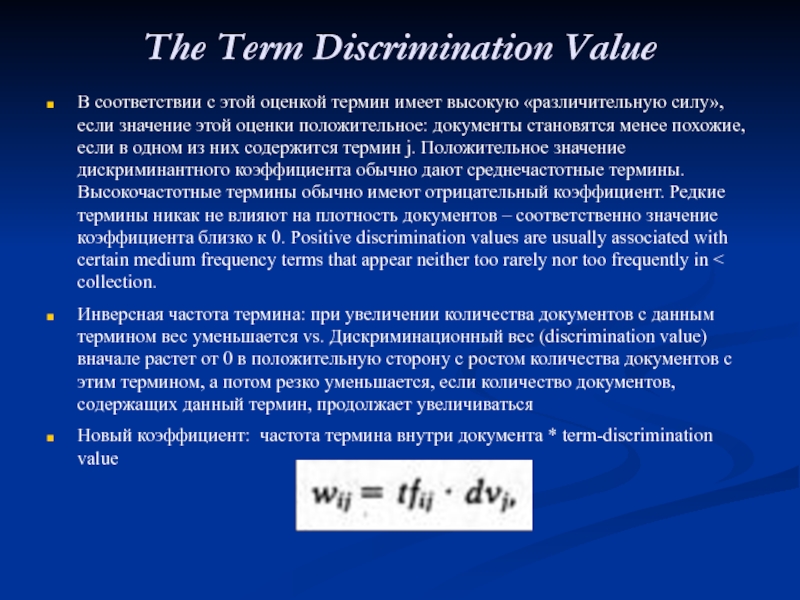

Слайд 57The Term Discrimination Value

В соответствии с этой оценкой термин имеет

Инверсная частота термина: при увеличении количества документов с данным термином вес уменьшается vs. Дискриминационный вес (discrimination value) вначале растет от 0 в положительную сторону с ростом количества документов с этим термином, а потом резко уменьшается, если количество документов, содержащих данный термин, продолжает увеличиваться

Новый коэффициент: частота термина внутри документа * term-discrimination value