Центр компьютерной физики

Кафедра общей физики и волновых процессов

Международный лазерный центр

- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Параллельное программированиедля ресурсоёмких задач численного моделирования в физике презентация

Содержание

- 1. Параллельное программированиедля ресурсоёмких задач численного моделирования в физике

- 2. Физический факультет МГУ им М.В.Ломоносова Лекция № 1

- 3. Физический факультет МГУ им М.В.Ломоносова Содержание курса

- 4. Структура курса лекции практические занятия самостоятельные задания ЗАЧЕТ Физический факультет МГУ им М.В.Ломоносова

- 5. Развитие инструментов для научного процесса Физический факультет

- 6. Области применения суперкомпьютеров Научно-исследовательские институты

- 7. Пример проблемы решаемой с помощью параллельного программирования

- 8. Сетка конечных элементов Физический факультет МГУ им М.В.Ломоносова

- 9. Архитектура ЭВМ Архитектура компьютера Организация компьютера Схема компьютера Физический факультет МГУ им М.В.Ломоносова

- 10. Архитектура фон Неймана Программа хранится в компьютере

- 11. Физический факультет МГУ им М.В.Ломоносова Архитектура фон Неймана II ПАМЯТЬ УСТРОЙСТВО УПРАВЛЕНИЯ АРИФМЕТИКО- ЛОГИЧЕСКОЕ УСТРОЙСТВО

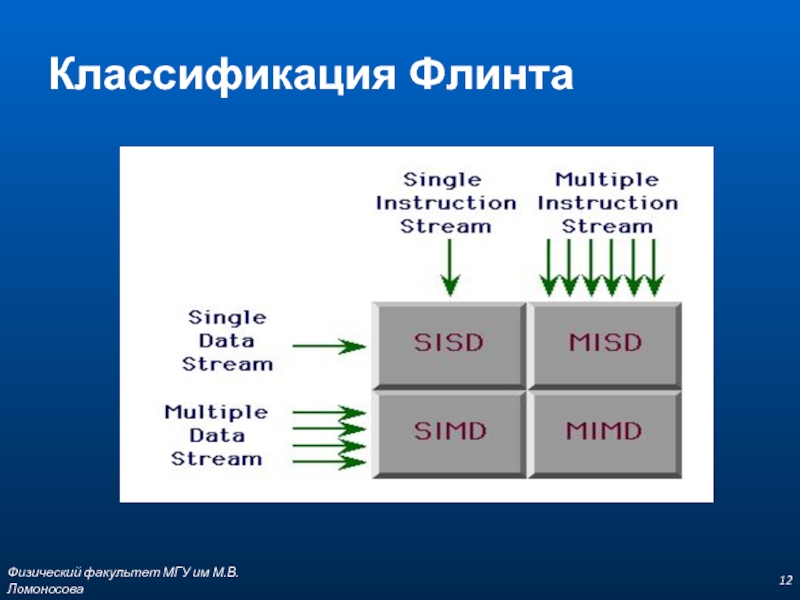

- 12. Классификация Флинта Физический факультет МГУ им М.В.Ломоносова

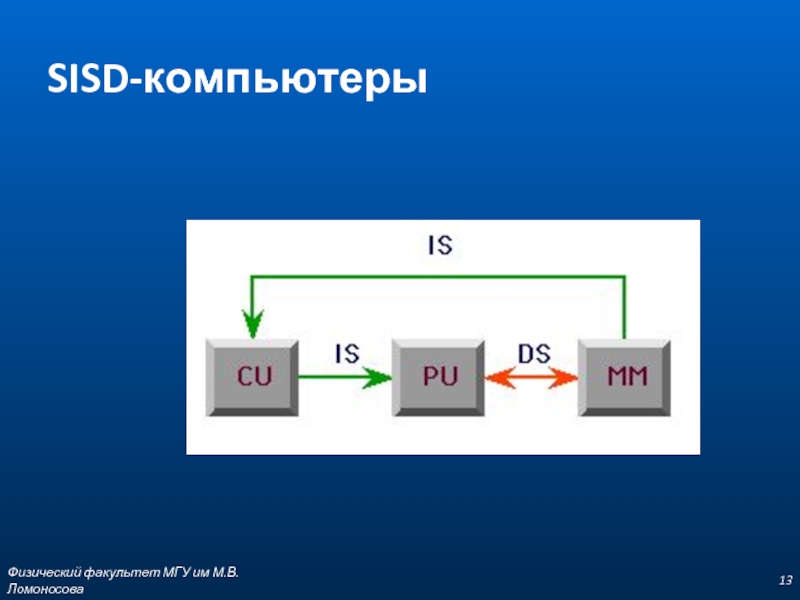

- 13. SISD-компьютеры Физический факультет МГУ им М.В.Ломоносова

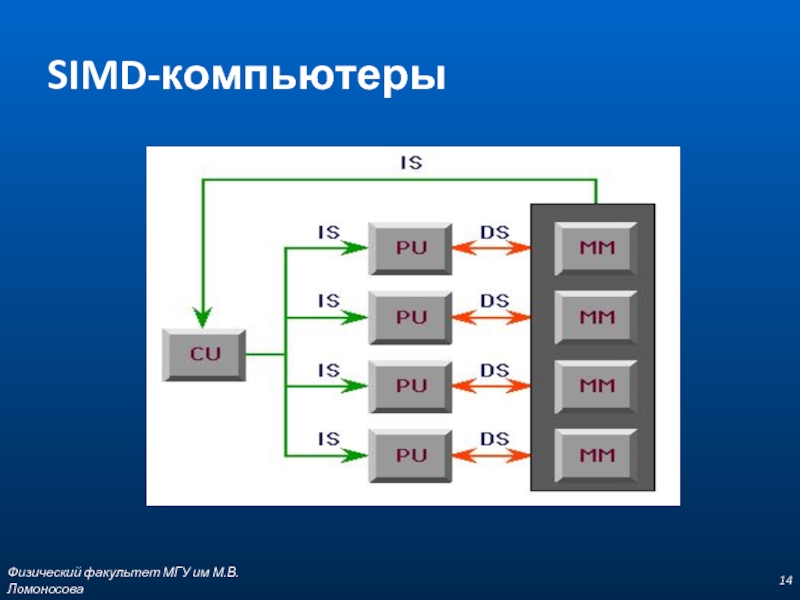

- 14. SIMD-компьютеры Физический факультет МГУ им М.В.Ломоносова

- 15. MISD-компьютеры Физический факультет МГУ им М.В.Ломоносова

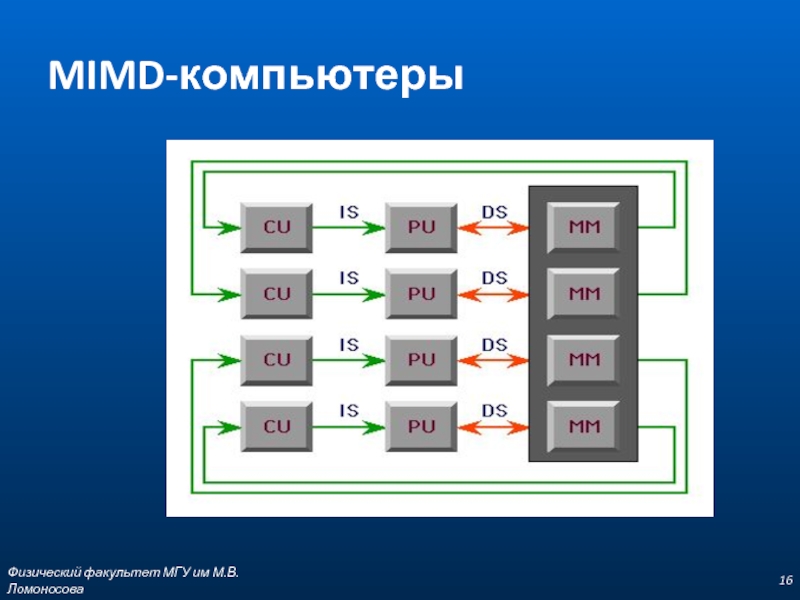

- 16. MIMD-компьютеры Физический факультет МГУ им М.В.Ломоносова

- 17. Компоненты компьютера Центральный процессор и оперативная память

- 18. Схема компьютера Физический факультет МГУ им М.В.Ломоносова

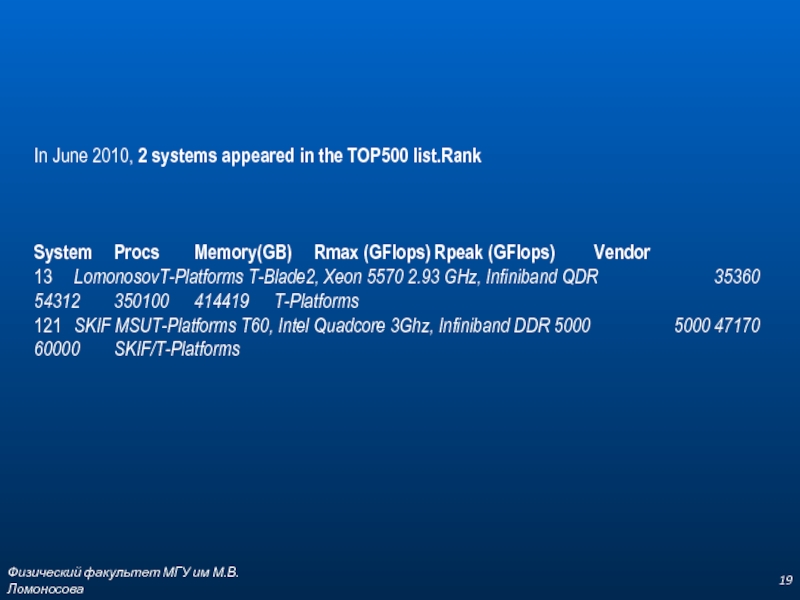

- 19. Физический факультет МГУ им М.В.Ломоносова In June

- 20. Технологии параллельного программирования “Все, что начинается хорошо,

- 21. Особенности программирования параллельных вычислений Физический факультет МГУ

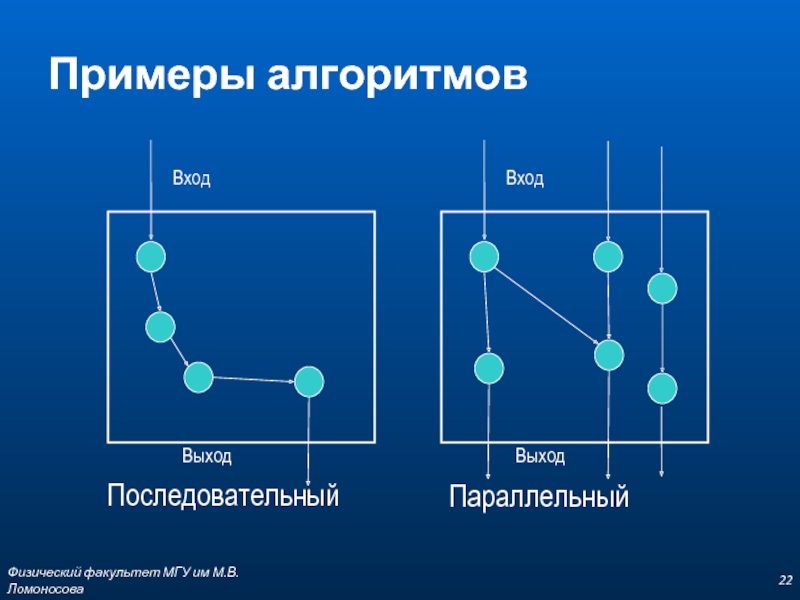

- 22. Примеры алгоритмов Последовательный Параллельный Физический факультет МГУ им М.В.Ломоносова

- 23. Основные черты последовательной модели Применение стандартных языков

- 24. Основные черты параллельной модели Высокая производительность программ

- 25. Фундаментальные требования к параллельным программам Параллелизм Локальность Масштабируемость Детерминизм Физический факультет МГУ им М.В.Ломоносова

- 26. Параллелизм Данных Задач Физический факультет МГУ им М.В.Ломоносова

- 27. Параллелизм данных Основные особенности подхода: Обработкой данных

- 28. Параллелизм задач Повышенная трудоёмкость разработки и отладки

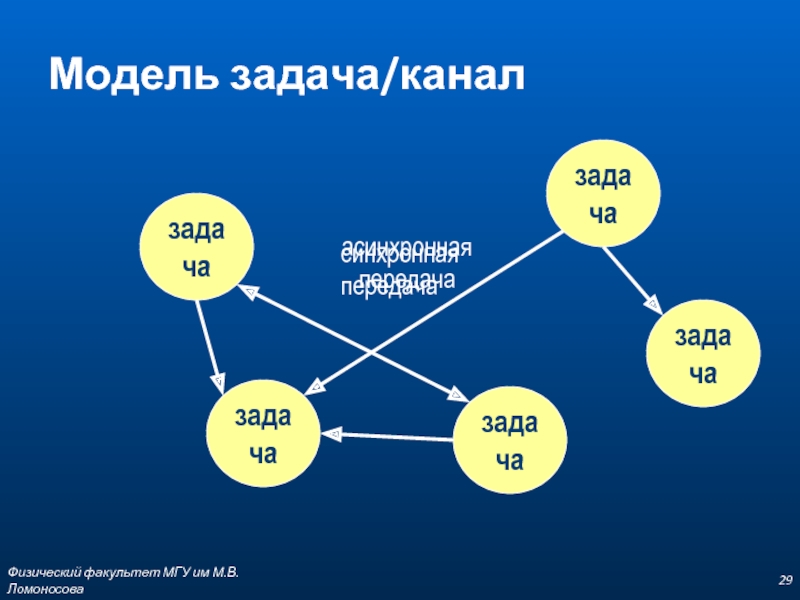

- 29. Модель задача/канал задача задача задача задача задача

- 30. Параллелизм задач Большая гибкость Большая свобода Физический факультет МГУ им М.В.Ломоносова Максимальное быстродействие

- 31. Масштабируемость Независимость результата выполнения параллельной программы от числа процессоров. Физический факультет МГУ им М.В.Ломоносова

- 32. Детерминизм Физический факультет МГУ им М.В.Ломоносова

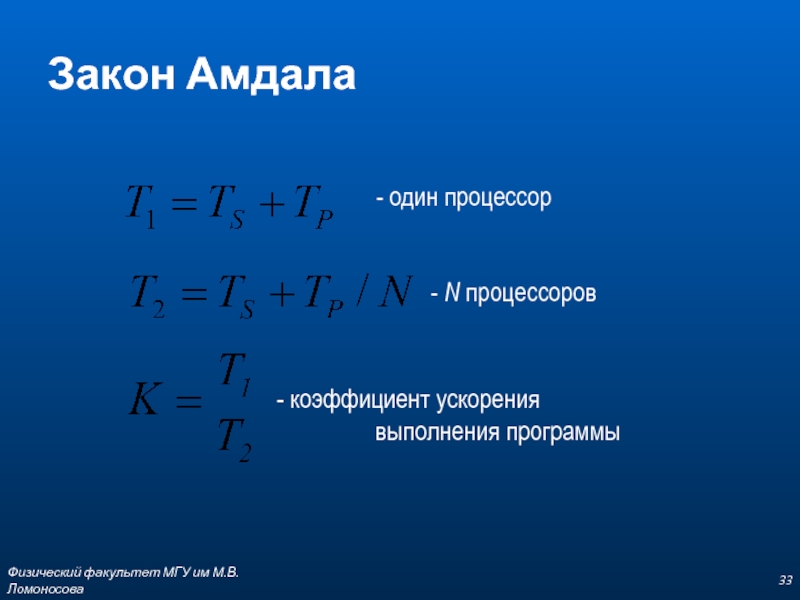

- 33. Закон Амдала - один процессор - N процессоров Физический факультет МГУ им М.В.Ломоносова

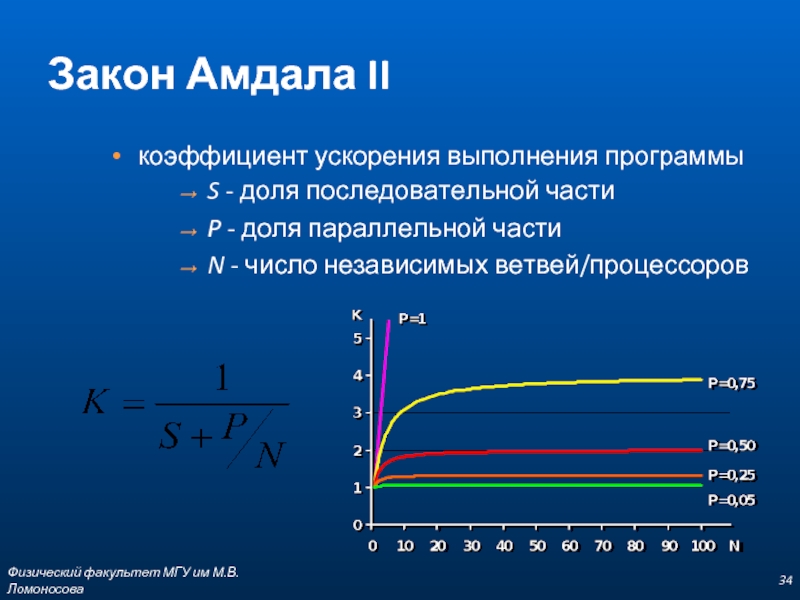

- 34. Закон Амдала II коэффициент ускорения выполнения программы

- 35. Две парадигмы параллельного программирования Равномерная загрузка процессоров

- 36. Базовый набор операций Операции управления данными Операции

- 37. Управление данными Физический факультет МГУ им М.В.Ломоносова

- 38. Операции над массивами Физический факультет МГУ им М.В.Ломоносова

- 39. Условные операции Физический факультет МГУ им М.В.Ломоносова

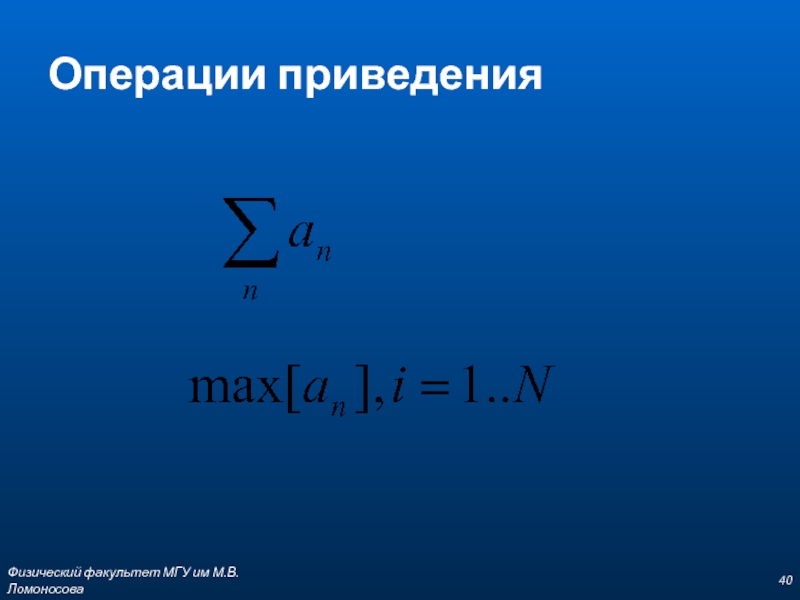

- 40. Операции приведения Физический факультет МГУ им М.В.Ломоносова

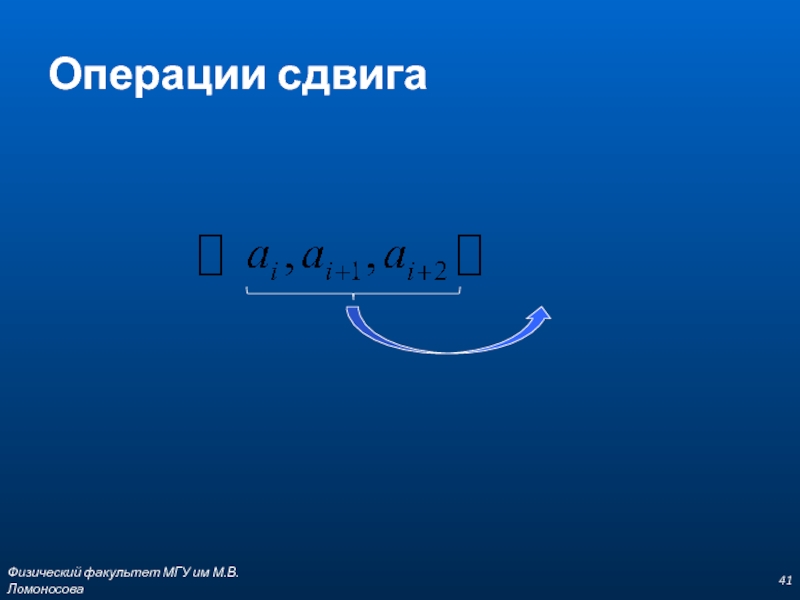

- 41. Операции сдвига Физический факультет МГУ им М.В.Ломоносова

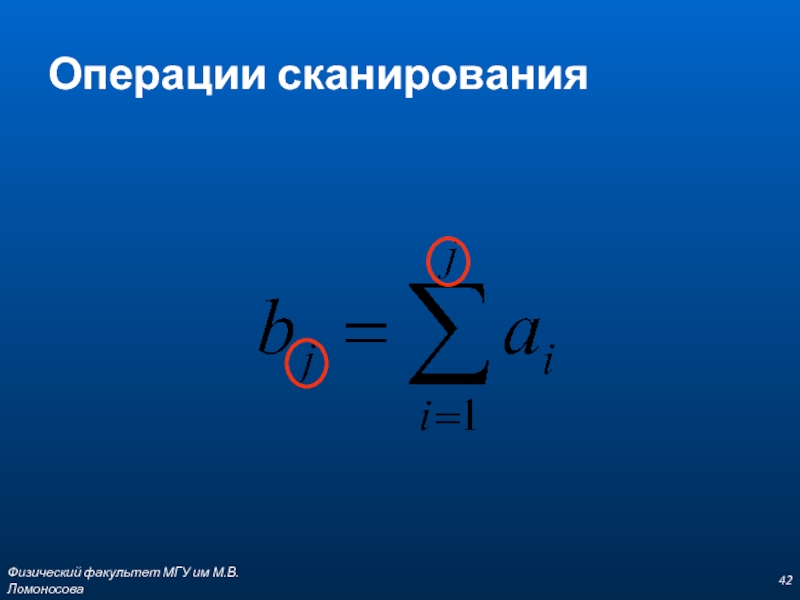

- 42. Операции сканирования Физический факультет МГУ им М.В.Ломоносова

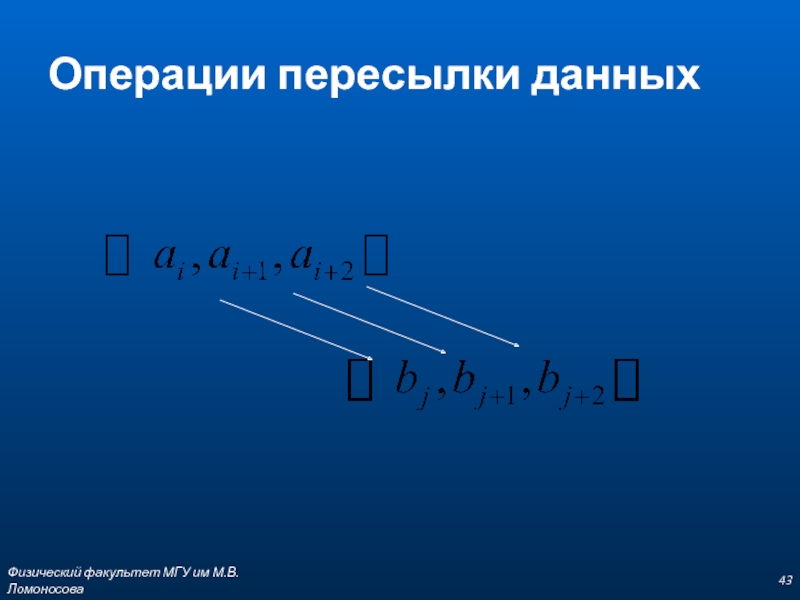

- 43. Операции пересылки данных Физический факультет МГУ им М.В.Ломоносова

- 44. Разработка параллельного алгоритма

- 45. Декомпозиция (сегментирование) Метод декомпозиции данных Метод функциональной декомпозиции Физический факультет МГУ им М.В.Ломоносова

- 46. Рекомендации по декомпозиции Количество подзадач должно на

- 47. “Зернистость” мелкозернистая среднеблочный крупноблочный < 20 ~

- 48. Независимость частей программы Независимость по данным Независимость

- 49. Проектирование коммуникаций Локальные Глобальные Структурированные Неструктурированные Статические

- 50. Рекомендации по проектированию коммуникаций Количество коммуникаций у

- 51. Тупиковые ситуации Физический факультет МГУ им М.В.Ломоносова

- 52. Реализация обмена сообщениями MPI (Message Passing Interface)

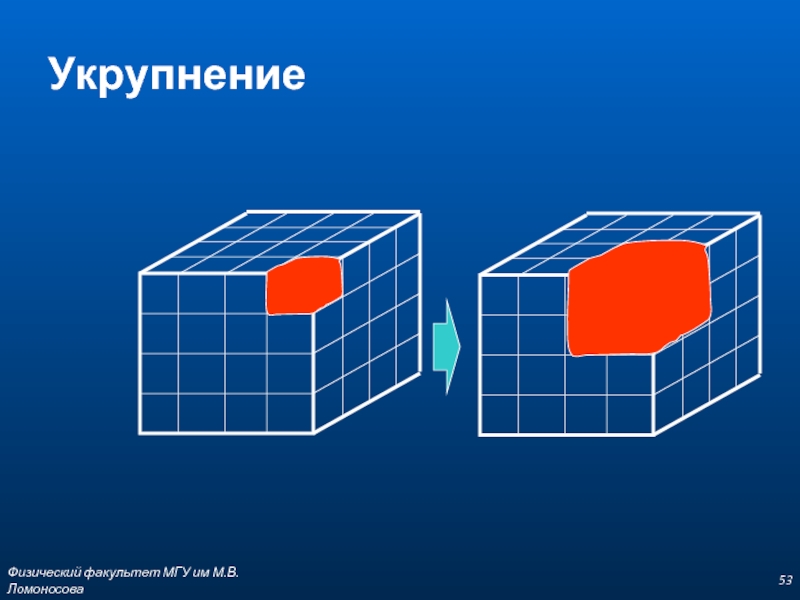

- 53. Укрупнение Физический факультет МГУ им М.В.Ломоносова

- 54. Укрупнение Снижение затрат на коммуникации При необходимом

- 55. Планирование вычислений Стратегия управления хозяин/работник Физический факультет МГУ им М.В.Ломоносова

- 56. Характеристики быстродействия Факторы влияющие на производительность Технология

- 57. Последовательность действий Разработка алгоритма Предварительный анализ быстродействия

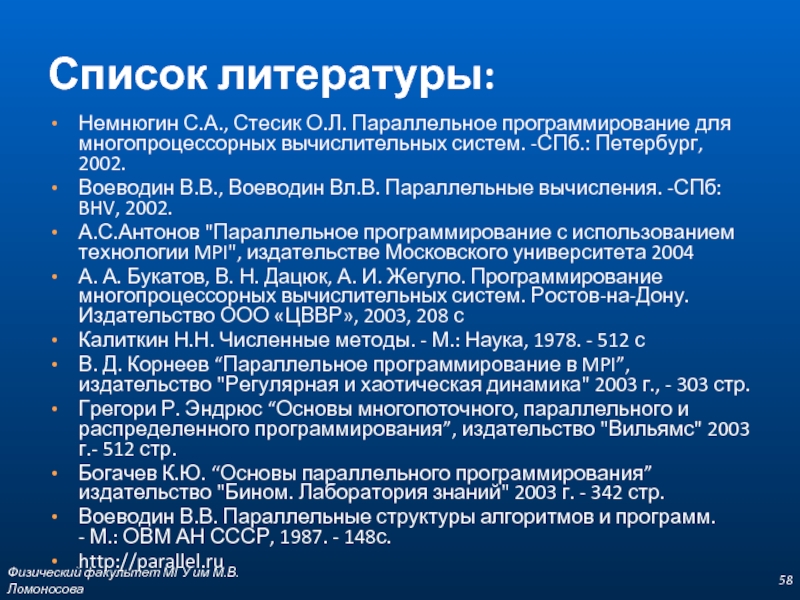

- 58. Список литературы: Немнюгин С.А., Стесик О.Л.

- 59. Физический факультет МГУ им М.В.Ломоносова

Слайд 1Параллельное программирование

для ресурсоёмких задач численного моделирования в физике

В.О. Милицин, Д.Н. Янышев,

Слайд 3Физический факультет МГУ им М.В.Ломоносова

Содержание курса

Введение

Архитектура высокопроизводительных систем

Особенности параллельных вычислений

Работа с

Технология OpenMP

Интерфейс передачи сообщений MPI

Моделирование физических задач средствами OpenMP и MPI

Слайд 4Структура курса

лекции

практические занятия

самостоятельные задания

ЗАЧЕТ

Физический факультет МГУ им М.В.Ломоносова

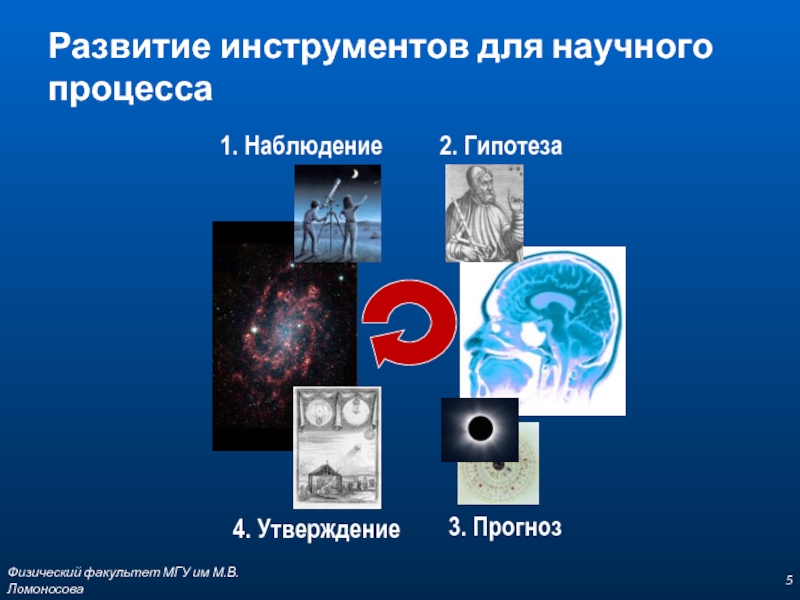

Слайд 5Развитие инструментов для научного процесса

Физический факультет МГУ им М.В.Ломоносова

1. Наблюдение

2. Гипотеза

4.

3. Прогноз

Слайд 6Области применения суперкомпьютеров

Научно-исследовательские институты

Университеты

Геофизика

Биология

Метеорология

Финансовая

Энергетика

Наукоемкие отрасли промышленности

Медицина

Генетика

Геологоразведка

Контроль за окружающей средой

Физический факультет МГУ им М.В.Ломоносова

Слайд 7Пример проблемы решаемой с помощью параллельного программирования

Car Crash Simulation:

Поверхность машины моделируется

Моделируется позиция каждого элемента во времени с учетом сил действующих на него и его свойств.

Каждый элемент взаимодействует только с соседними элементами

Физический факультет МГУ им М.В.Ломоносова

Слайд 9Архитектура ЭВМ

Архитектура компьютера

Организация компьютера

Схема компьютера

Физический факультет МГУ им М.В.Ломоносова

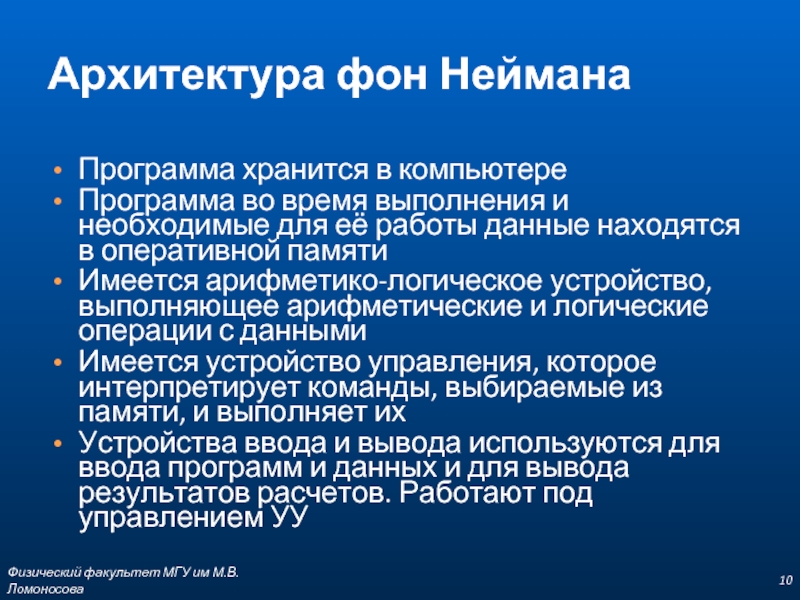

Слайд 10Архитектура фон Неймана

Программа хранится в компьютере

Программа во время выполнения и необходимые

Имеется арифметико-логическое устройство, выполняющее арифметические и логические операции с данными

Имеется устройство управления, которое интерпретирует команды, выбираемые из памяти, и выполняет их

Устройства ввода и вывода используются для ввода программ и данных и для вывода результатов расчетов. Работают под управлением УУ

Физический факультет МГУ им М.В.Ломоносова

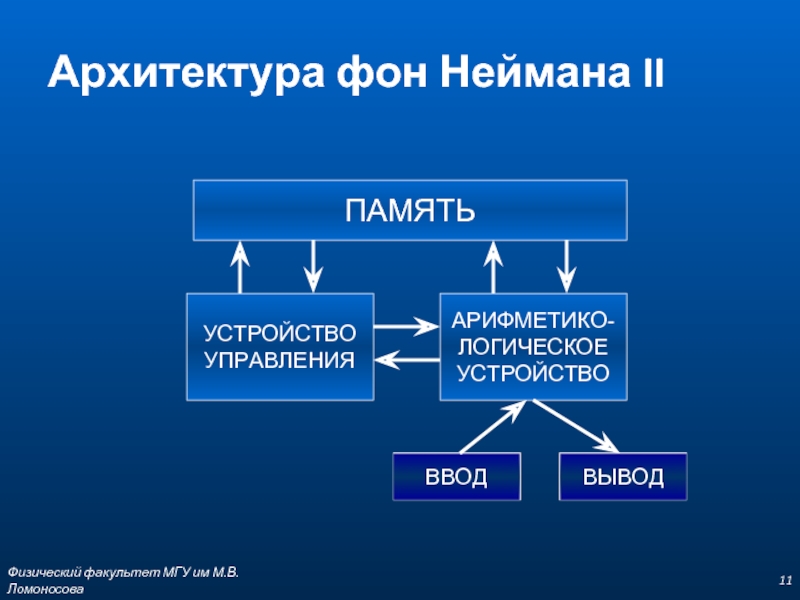

Слайд 11Физический факультет МГУ им М.В.Ломоносова

Архитектура фон Неймана II

ПАМЯТЬ

УСТРОЙСТВО

УПРАВЛЕНИЯ

АРИФМЕТИКО-

ЛОГИЧЕСКОЕ

УСТРОЙСТВО

Слайд 17Компоненты компьютера

Центральный процессор и оперативная память

ядро системы

Внешняя память и устройства ввода/вывода

«периферия»

Коммуникации

Физический факультет МГУ им М.В.Ломоносова

Слайд 19Физический факультет МГУ им М.В.Ломоносова

In June 2010, 2 systems appeared in

System Procs Memory(GB) Rmax (GFlops) Rpeak (GFlops) Vendor

13 LomonosovT-Platforms T-Blade2, Xeon 5570 2.93 GHz, Infiniband QDR 35360 54312 350100 414419 T-Platforms

121 SKIF MSUT-Platforms T60, Intel Quadcore 3Ghz, Infiniband DDR 5000 5000 47170 60000 SKIF/T-Platforms

Слайд 20Технологии параллельного программирования

“Все, что начинается хорошо, кончается плохо.

Все, что начинается плохо,

Из законов Мерфи

Физический факультет МГУ им М.В.Ломоносова

Слайд 21Особенности программирования параллельных вычислений

Физический факультет МГУ им М.В.Ломоносова

Модель программирования

Алгоритм

Информационный граф

Вход

Выход

(n, s)

(v,

Слайд 23Основные черты последовательной модели

Применение стандартных языков программирования

Хорошая переносимость программ

Невысокая производительность

Физический

Слайд 24Основные черты параллельной модели

Высокая производительность программ

Применение специальных приёмов программирования

Более высокая трудоёмкость

Проблемы с переносимостью программ

Физический факультет МГУ им М.В.Ломоносова

Слайд 25Фундаментальные требования к параллельным программам

Параллелизм

Локальность

Масштабируемость

Детерминизм

Физический факультет МГУ им М.В.Ломоносова

Слайд 27Параллелизм данных

Основные особенности подхода:

Обработкой данных управляет одна программа

Пространство имен является глобальным

Слабая

Параллельные операции над элементами массива выполняются одновременно на всех доступных процессорах

Физический факультет МГУ им М.В.Ломоносова

Слайд 28Параллелизм задач

Повышенная трудоёмкость разработки и отладки программы

Программист отвечает за равномерную и

Минимизация обмена данными между задачами

Возникновение конфликтов

Физический факультет МГУ им М.В.Ломоносова

Слайд 29Модель задача/канал

задача

задача

задача

задача

задача

асинхронная

передача

синхронная

передача

Физический факультет МГУ им М.В.Ломоносова

Слайд 30Параллелизм задач

Большая гибкость

Большая свобода

Физический факультет МГУ им М.В.Ломоносова

Максимальное быстродействие

Слайд 31Масштабируемость

Независимость результата выполнения параллельной программы от числа процессоров.

Физический факультет МГУ им

Слайд 34Закон Амдала II

коэффициент ускорения выполнения программы

S - доля последовательной части

P -

N - число независимых ветвей/процессоров

Физический факультет МГУ им М.В.Ломоносова

Слайд 35Две парадигмы параллельного программирования

Равномерная загрузка процессоров

Эффективная организация обмена информацией между задачами

Физический

Слайд 36Базовый набор операций

Операции управления данными

Операции над массивами в целом, а также

Условные операции

Операции приведения

Операции сдвига

Операции сканирования

Операции, связанные с пересылкой данных

Физический факультет МГУ им М.В.Ломоносова

Слайд 44

Разработка параллельного алгоритма

проблема

декомпозиция

коммуникации

укрупнение

планирование

вычислений

подзадачи

процессоры

Физический факультет МГУ им М.В.Ломоносова

Слайд 45Декомпозиция (сегментирование)

Метод декомпозиции данных

Метод функциональной декомпозиции

Физический факультет МГУ им М.В.Ломоносова

Слайд 46Рекомендации по декомпозиции

Количество подзадач должно на порядок превосходить количество процессоров

Следует избегать

Подзадачи должны быть примерно одного размера

С увеличением объема задачи количество подзадач увеличивалось

Физический факультет МГУ им М.В.Ломоносова

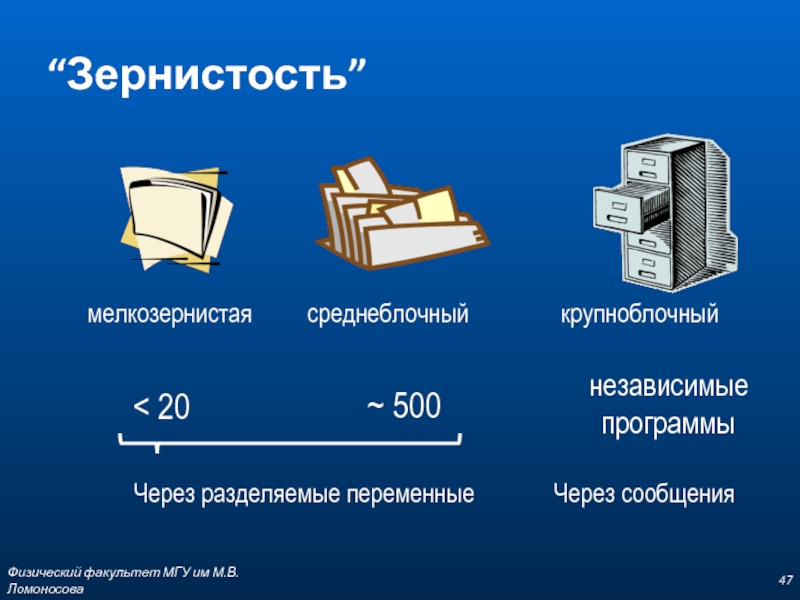

Слайд 47“Зернистость”

мелкозернистая

среднеблочный

крупноблочный

< 20

~ 500

независимые

программы

Через разделяемые переменные

Через сообщения

Физический факультет МГУ им М.В.Ломоносова

Слайд 48Независимость частей программы

Независимость по данным

Независимость по управлению

Независимость по ресурсам

do k =

if (a[k] < c) then

a[k] = 1

endif

enddo

do k = 1, m

if (a[k-1] < c) then

a[k] = 1

endif

enddo

Физический факультет МГУ им М.В.Ломоносова

Слайд 49Проектирование коммуникаций

Локальные

Глобальные

Структурированные

Неструктурированные

Статические

Динамические

Синхронные

Асинхронные

Физический факультет МГУ им М.В.Ломоносова

Слайд 50Рекомендации по проектированию коммуникаций

Количество коммуникаций у подзадач должно быть примерно одинаковым

Желательно

Коммуникации должны быть , по возможности, параллельными

Физический факультет МГУ им М.В.Ломоносова

Слайд 52Реализация обмена сообщениями

MPI (Message Passing Interface)

PVM (Parallel Virtual Machine)

RPC (Remote Procedure

CORBA (Common Object Request Broker Architecture)

DCOM (Distributed Component Object Model)

Физический факультет МГУ им М.В.Ломоносова

Слайд 54Укрупнение

Снижение затрат на коммуникации

При необходимом дублировании вычислений или данных не должно

Результирующие задачи должны иметь примерно одинаковую трудоёмкость

Сохранение масштабируемости

Сохранение возможности параллельного выполнения

Снижение стоимости и трудоёмкости разработки

Физический факультет МГУ им М.В.Ломоносова

Слайд 55Планирование вычислений

Стратегия управления хозяин/работник

Физический факультет МГУ им М.В.Ломоносова

Слайд 56Характеристики быстродействия

Факторы влияющие на производительность

Технология выполнения аппаратной части

Архитектура вычислительной системы

Методы управления

Эффективность параллельного алгоритма

Особенности структуры данных

Эффективность языка программирования

Квалификация программиста

Эффективность транслятора

Слайд 57Последовательность действий

Разработка алгоритма

Предварительный анализ быстродействия программы

Оценка трудоёмкости и целесообразности разработки параллельной

Кодирование

Физический факультет МГУ им М.В.Ломоносова

Слайд 58Список литературы:

Немнюгин С.А., Стесик О.Л. Параллельное программирование для многопроцессорных вычислительных систем.

Воеводин В.В., Воеводин Вл.В. Параллельные вычисления. -СПб: BHV, 2002.

А.С.Антонов "Параллельное программирование с использованием технологии MPI", издательстве Московского университета 2004

А. А. Букатов, В. Н. Дацюк, А. И. Жегуло. Программирование многопроцессорных вычислительных систем. Ростов-на-Дону. Издательство ООО «ЦВВР», 2003, 208 с

Калиткин Н.Н. Численные методы. - М.: Наука, 1978. - 512 с

В. Д. Корнеев “Параллельное программирование в MPI”, издательство "Регулярная и хаотическая динамика" 2003 г., - 303 стр.

Грегори Р. Эндрюс “Основы многопоточного, параллельного и распределенного программирования”, издательство "Вильямс" 2003 г.- 512 стр.

Богачев К.Ю. “Основы параллельного программирования” издательство "Бином. Лаборатория знаний" 2003 г. - 342 стр.

Воеводин В.В. Параллельные структуры алгоритмов и программ. - М.: ОВМ АН СССР, 1987. - 148с.

http://parallel.ru

Физический факультет МГУ им М.В.Ломоносова

![Независимость частей программыНезависимость по даннымНезависимость по управлениюНезависимость по ресурсамdo k = 1, m if (a[k]](/img/tmb/2/142225/5b280792e36ffac6de242ad9f606ff9a-800x.jpg)