- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Магистерский проект презентация

Содержание

- 1. Магистерский проект

- 2. Краткое содержание Введение SLAM используя

- 3. Введение: SLAM SLAM: Simultaneous Localization and Mapping

- 4. Введение: SLAM Допущение Маркова State transition: Observation function:

- 5. Введение: SLAM Method: Sequentially estimate the probability distribution p(xt) and update the map. Prior: p(x0)

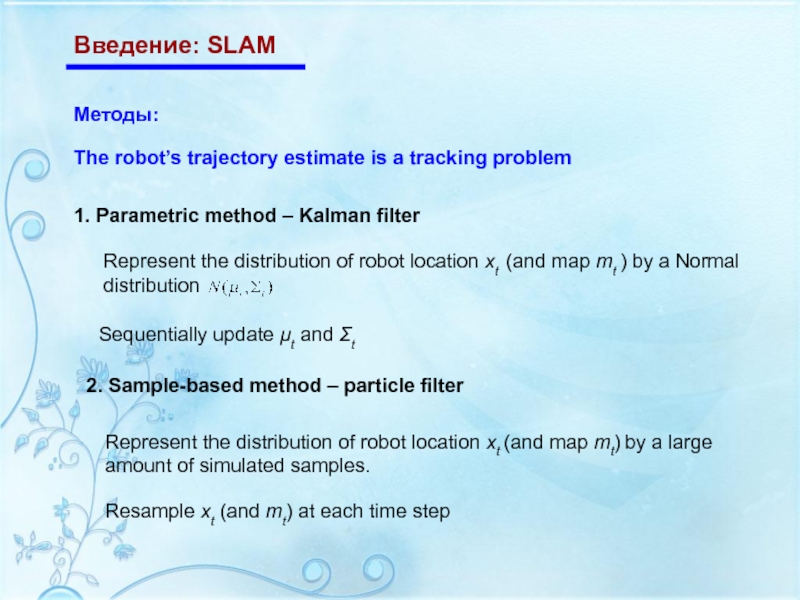

- 6. Введение: SLAM Методы: 1. Parametric method –

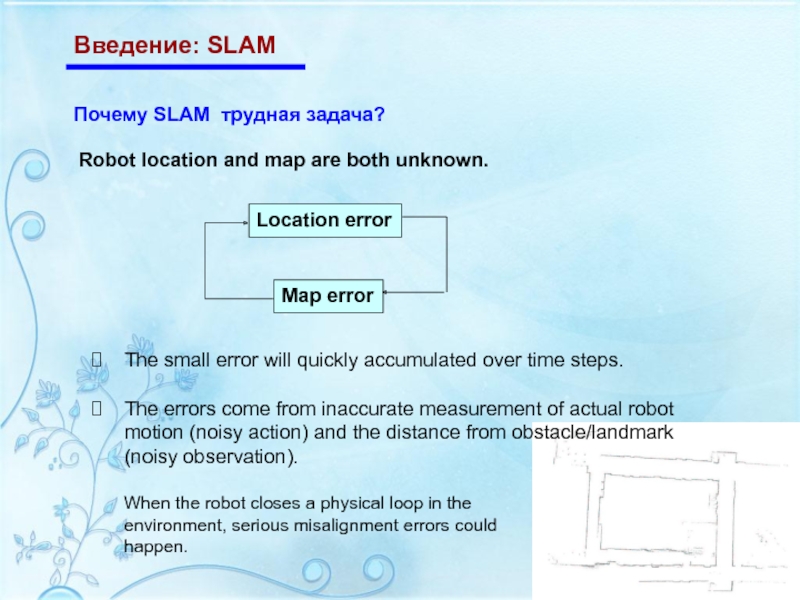

- 7. Введение: SLAM Почему SLAM трудная задача? Robot

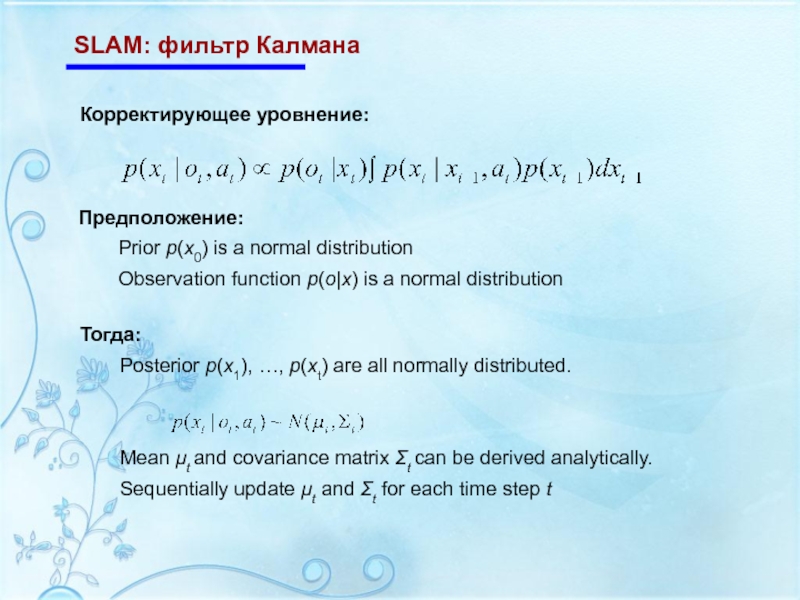

- 8. SLAM: фильтр Калмана Корректирующее уровнение: Предположение:

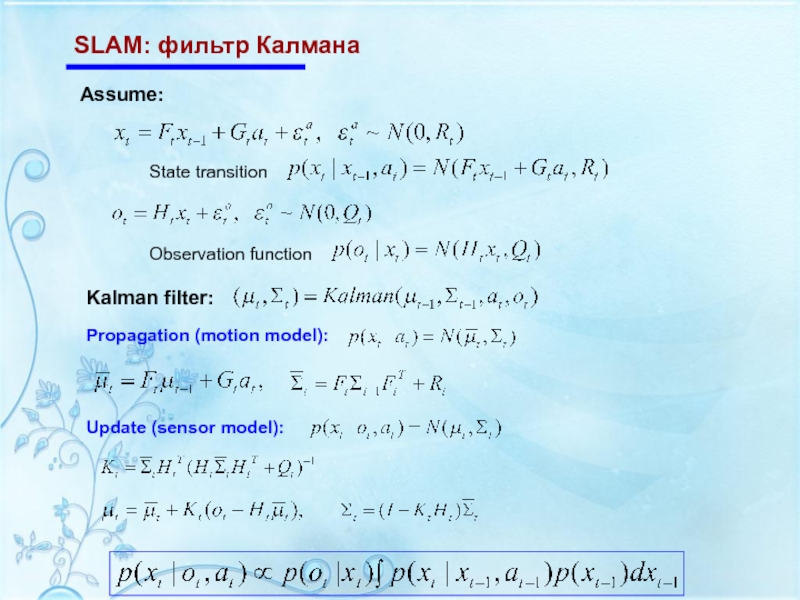

- 9. SLAM: фильтр Калмана

- 10. SLAM: фильтр Калмана The hidden state for

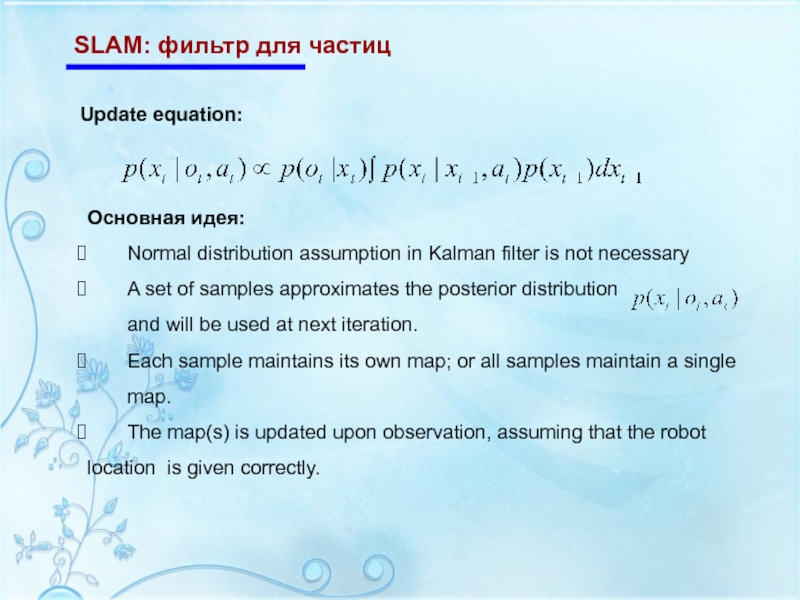

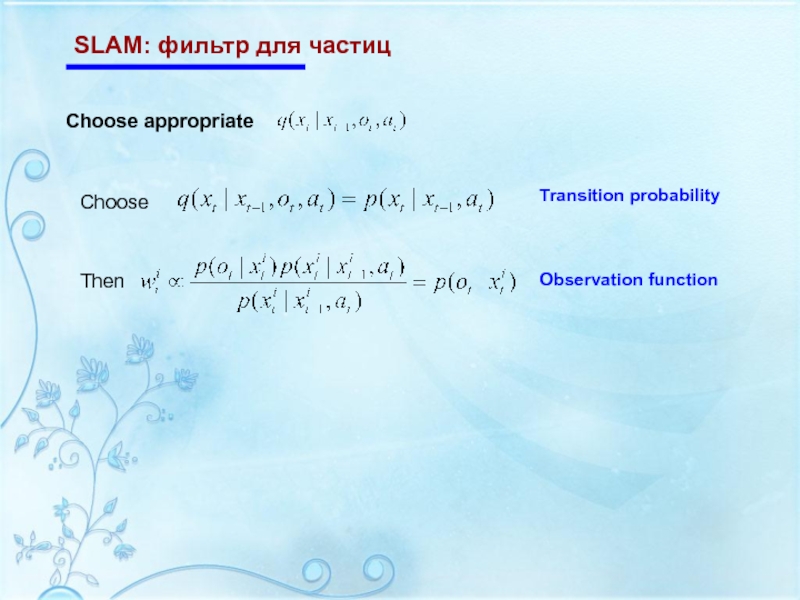

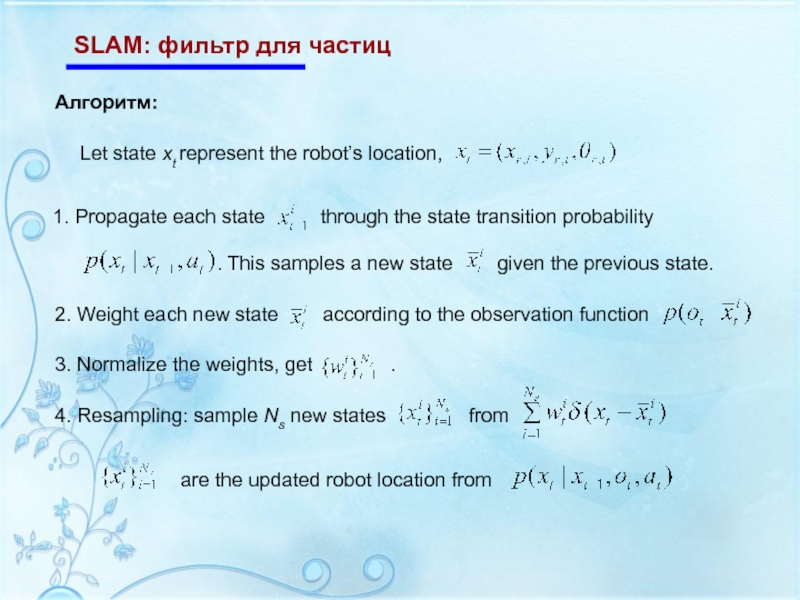

- 11. SLAM: фильтр для частиц Update equation:

- 12. SLAM: фильтр для частиц

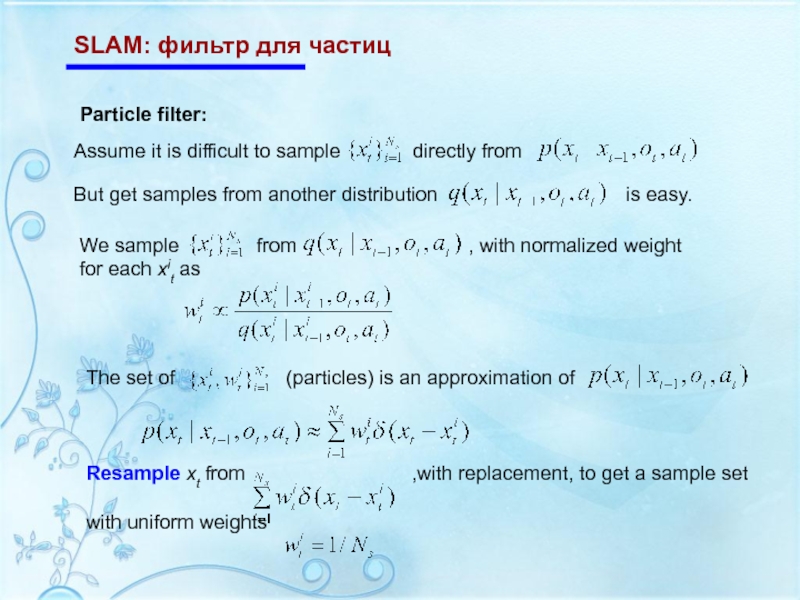

- 13. SLAM: фильтр для частиц

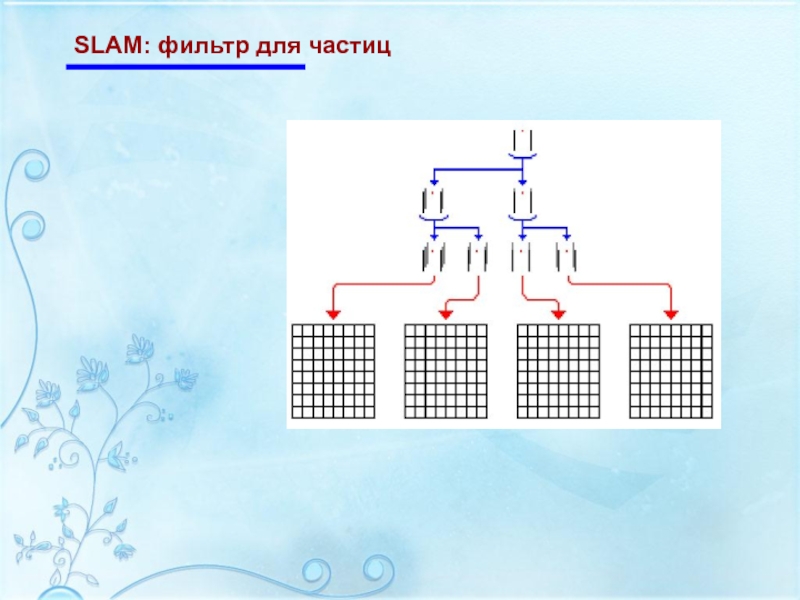

- 14. SLAM: фильтр для частиц

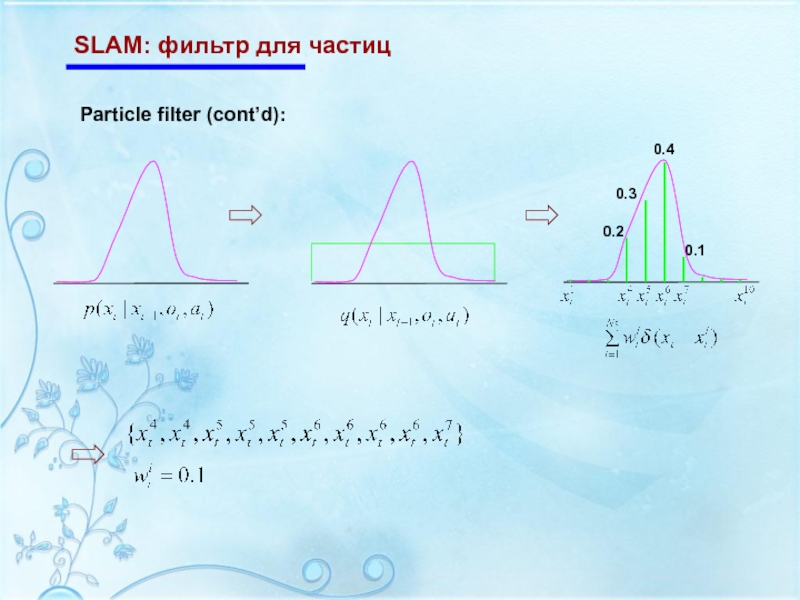

- 15. SLAM: фильтр для частиц

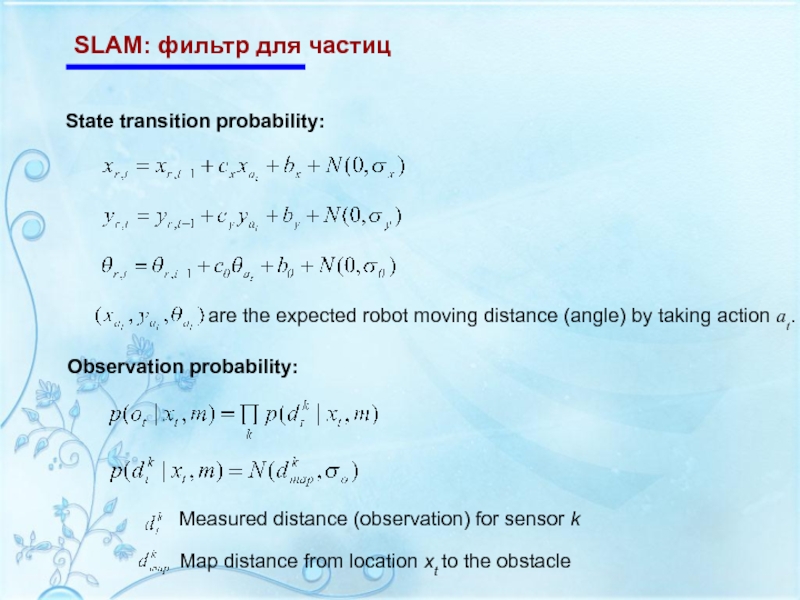

- 16. SLAM: фильтр для частиц State transition probability: Observation probability:

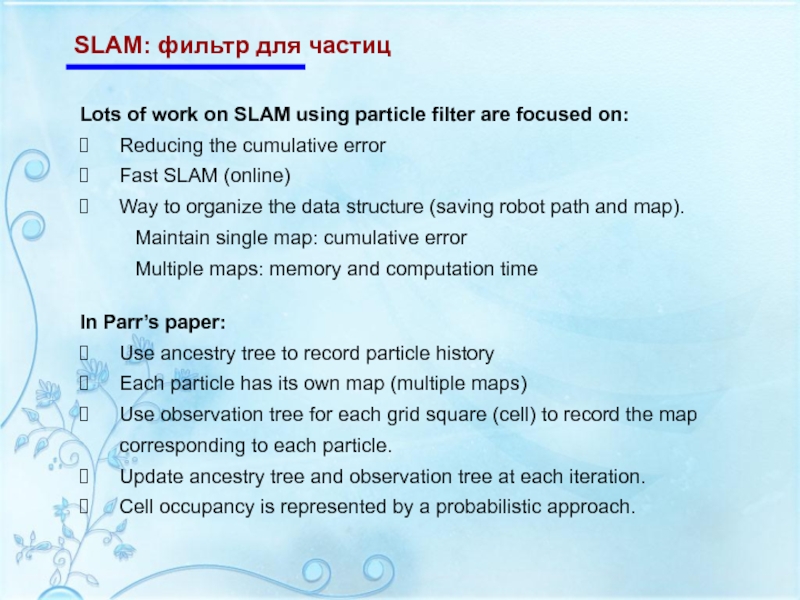

- 17. SLAM: фильтр для частиц Lots of work

- 18. SLAM: фильтр для частиц

- 19. Проблема поиска The agent doesn’t have map,

- 20. Проблема поиска Differences from SLAM Rough map

- 21. Проблема поиска Model: Environment is represented

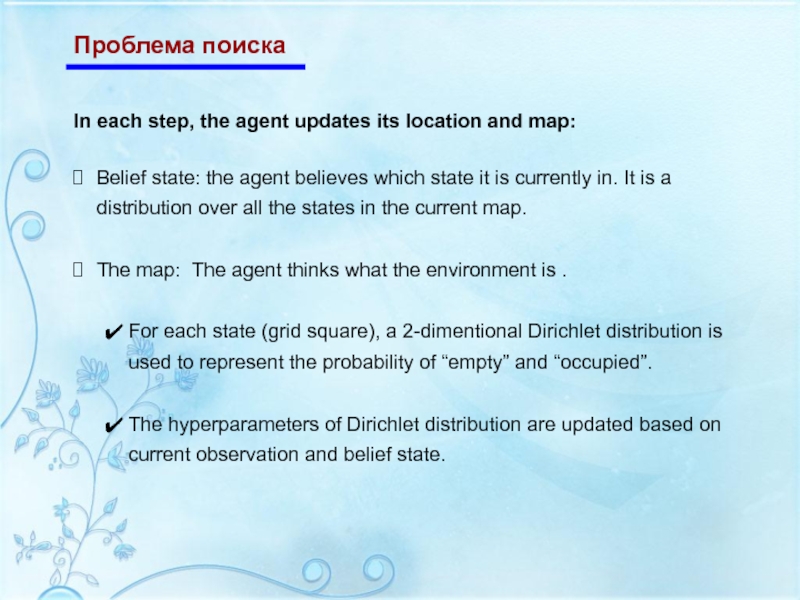

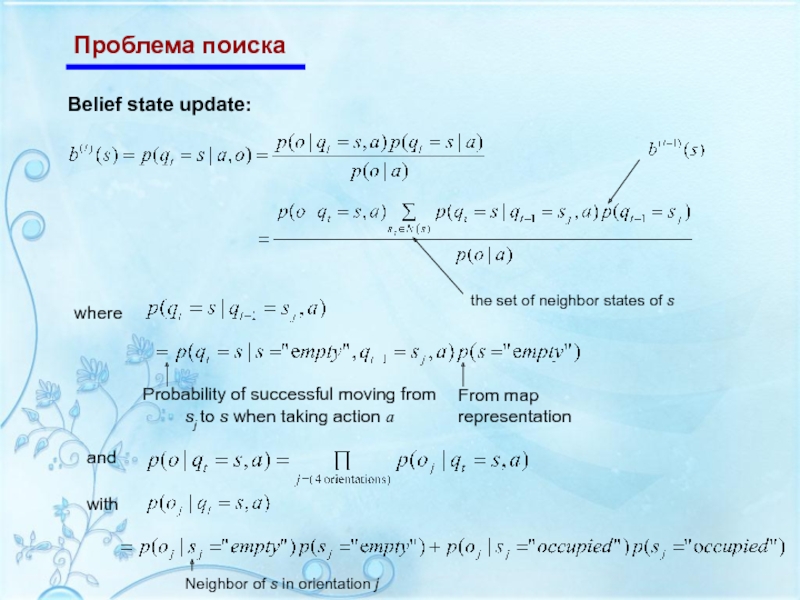

- 22. Проблема поиска In each step, the agent

- 23. Проблема поиска

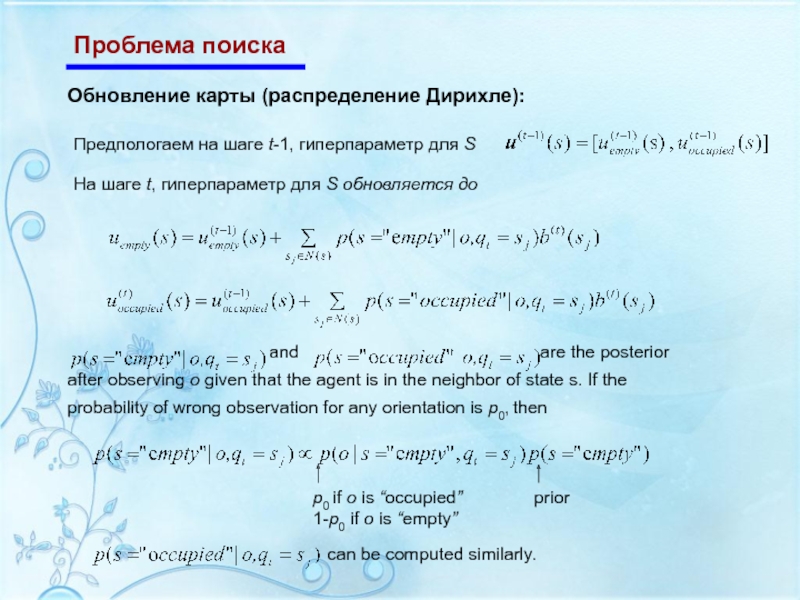

- 24. Проблема поиска Обновление карты (распределение Дирихле):

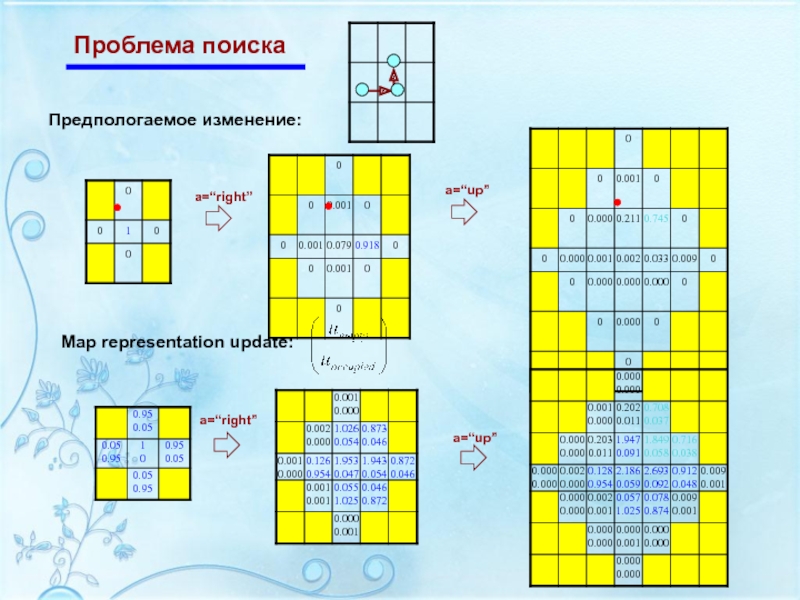

- 25. Проблема поиска Предпологаемое изменение: Map representation update:

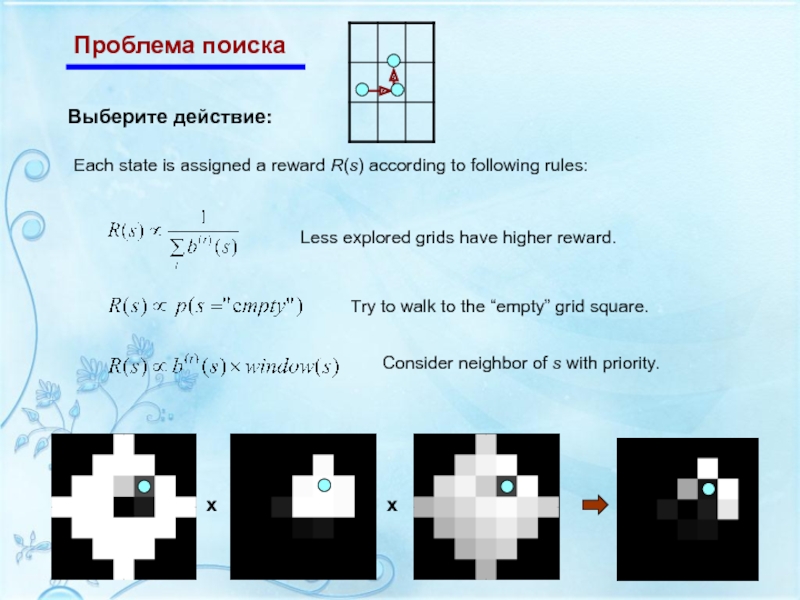

- 26. Проблема поиска Выберите действие: Each state is

- 27. Cпасибо за внимание

Слайд 1Магистерский проект

2008

Магистрант:

Матрунич

Сергей Анатольевич

Научный руководитель:

Зимянин Л.Ф.

Simultaneous localization

and mapping

Слайд 2Краткое содержание

Введение

SLAM используя фильтр Калмана

SLAM используя фильтр для частиц

Исследование :

Слайд 3Введение: SLAM

SLAM: Simultaneous Localization and Mapping

Робот изучает незнакомое, статическое окружение.

Дано:

Система управления роботом

Визуальные датчики

Оценка:

Положения робота -- localization

где Я ?

Детализация окружающего пространства – mapping

На что похоже то что вокруг меня?

Оба источника данных зашумлены.

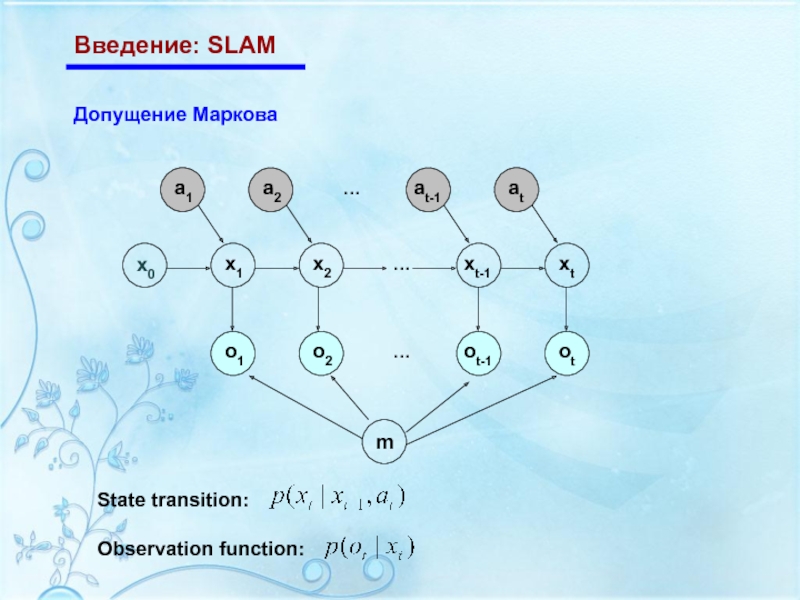

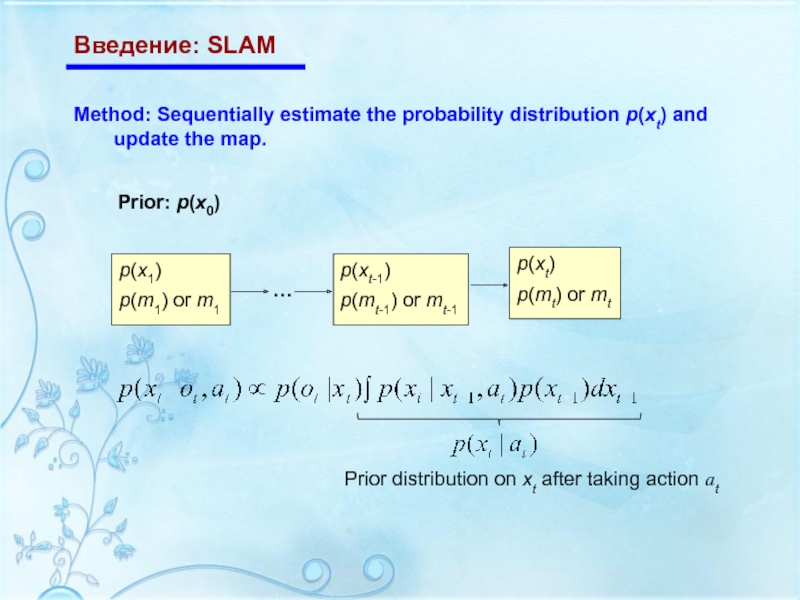

Слайд 5Введение: SLAM

Method: Sequentially estimate the probability distribution p(xt) and update the

Prior: p(x0)

Слайд 6Введение: SLAM

Методы:

1. Parametric method – Kalman filter

2. Sample-based method – particle

The robot’s trajectory estimate is a tracking problem

Sequentially update μt and Σt

Represent the distribution of robot location xt (and map mt) by a large amount of simulated samples.

Resample xt (and mt) at each time step

Слайд 7Введение: SLAM

Почему SLAM трудная задача?

Robot location and map are both unknown.

The

The errors come from inaccurate measurement of actual robot motion (noisy action) and the distance from obstacle/landmark (noisy observation).

When the robot closes a physical loop in the environment, serious misalignment errors could happen.

Слайд 8SLAM: фильтр Калмана

Корректирующее уровнение:

Предположение:

Prior p(x0) is a normal distribution

Observation function

Тогда:

Posterior p(x1), …, p(xt) are all normally distributed.

Mean μt and covariance matrix Σt can be derived analytically.

Sequentially update μt and Σt for each time step t

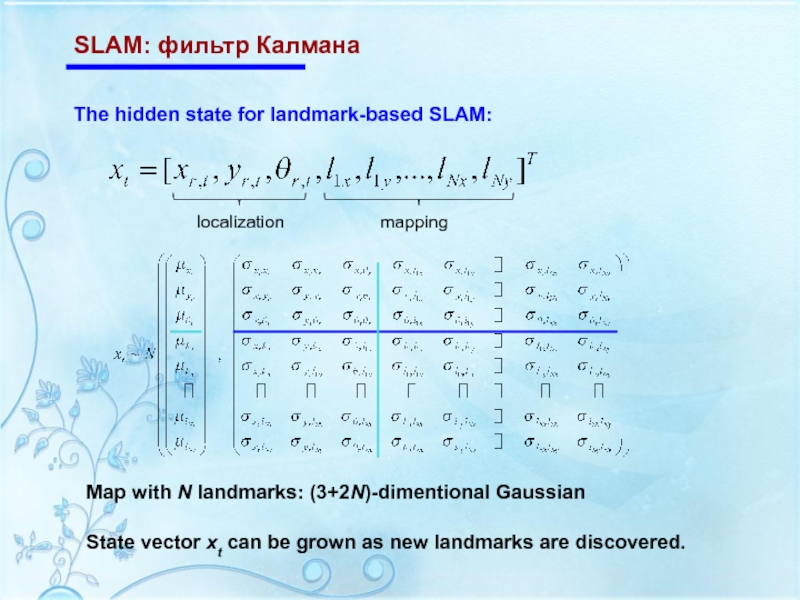

Слайд 10SLAM: фильтр Калмана

The hidden state for landmark-based SLAM:

Map with N landmarks:

State vector xt can be grown as new landmarks are discovered.

Слайд 17SLAM: фильтр для частиц

Lots of work on SLAM using particle filter

Reducing the cumulative error

Fast SLAM (online)

Way to organize the data structure (saving robot path and map).

Maintain single map: cumulative error

Multiple maps: memory and computation time

In Parr’s paper:

Use ancestry tree to record particle history

Each particle has its own map (multiple maps)

Use observation tree for each grid square (cell) to record the map corresponding to each particle.

Update ancestry tree and observation tree at each iteration.

Cell occupancy is represented by a probabilistic approach.

Слайд 19Проблема поиска

The agent doesn’t have map, doesn’t know the underlying model,

Agent has 2 sensors:

Camera: tell agent “occupied” or “empty” cells in 4 orientations, noisy sensor.

Acoustic sensor: find the orientation of the target, effective only within certain distance.

Noisy observation, noisy action.

Assumption:

Слайд 20Проблема поиска

Differences from SLAM

Rough map is enough; an accurate map is

Objective is to find the target. Robot need to actively select actions to find the target as soon as possible.

Similar to SLAM

To find the target, agent need build map and estimate its location.

Слайд 21Проблема поиска

Model:

Environment is represented by a rough grid;

Each grid square

The agent moves between the empty grid squares.

Actions: walk to any one of the 4 directions, or “stay”. Could fail in walking with certain probability.

Observations: observe 4 orientations of its neighbor grid squares: “occupied” or “empty”. Could make a wrong observation with certain probability.

State, action and observation are all discrete.

Слайд 22Проблема поиска

In each step, the agent updates its location and map:

Belief

The map: The agent thinks what the environment is .

For each state (grid square), a 2-dimentional Dirichlet distribution is used to represent the probability of “empty” and “occupied”.

The hyperparameters of Dirichlet distribution are updated based on current observation and belief state.

Слайд 25Проблема поиска

Предпологаемое изменение:

Map representation update:

a=“right”

a=“up”

a=“right”

a=“up”

Слайд 26Проблема поиска

Выберите действие:

Each state is assigned a reward R(s) according to

Less explored grids have higher reward.

Try to walk to the “empty” grid square.

Consider neighbor of s with priority.

x

x