- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

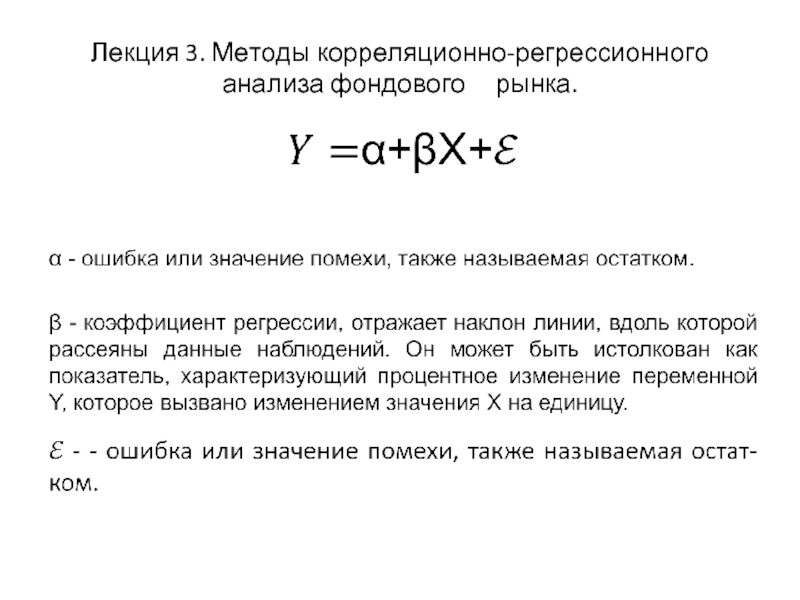

Методы корреляционно-регрессионного анализа фондового рынка презентация

Содержание

- 1. Методы корреляционно-регрессионного анализа фондового рынка

- 2. Определение параметров уравнения регрессии с помощью

- 4. Критерии значимости коэффициентов и в уравнении регрессии. Коэффициент детерминации .

- 5. При

- 6. Коэффициент детерминации

- 7. Иногда при

- 8. Для

- 9. Гетероскедастичность.

- 10. Гетероскедастичность Критерий Голдфелда-Кванта - это отношение суммы

- 11. Автокорреляция.

- 12. Автокорреляция Автокорреляция, также известная как сериальная корреляция,

- 13. Мультиколлинеарность Если некоторые или

- 14. Для уменьшения мультиколлинеарности может быть принято несколько

- 15. Фиктивные переменные Иногда необходимо

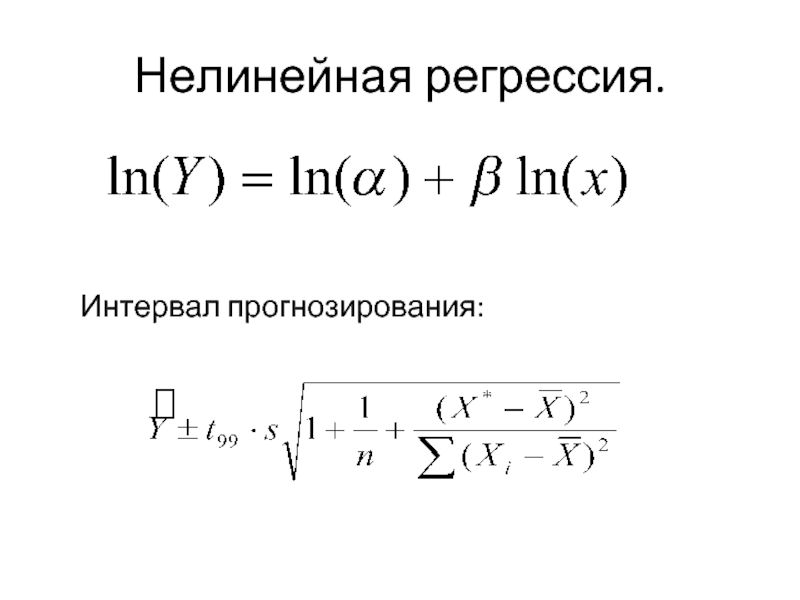

- 16. Нелинейная регрессия. Интервал прогнозирования:

- 17. Выявление наличия корреляционной связи между парой показателей

- 18. Оценка значимости коэффициента корреляции при малых объемах

- 19. Линейный коэффициент корреляции изменяется

- 20. Вычисленное по этой формуле

- 21. Матрица коэффициентов парной корреляции

- 22. Анализ матрицы

- 23. Множественный коэффициент корреляции

- 24. Решение первой задачи (определение тесноты связи одной

- 25. Частный коэффициент корреляции Если

- 26. Частный коэффициент корреляции

- 27. Частный коэффициент корреляции, так же как и

Слайд 3

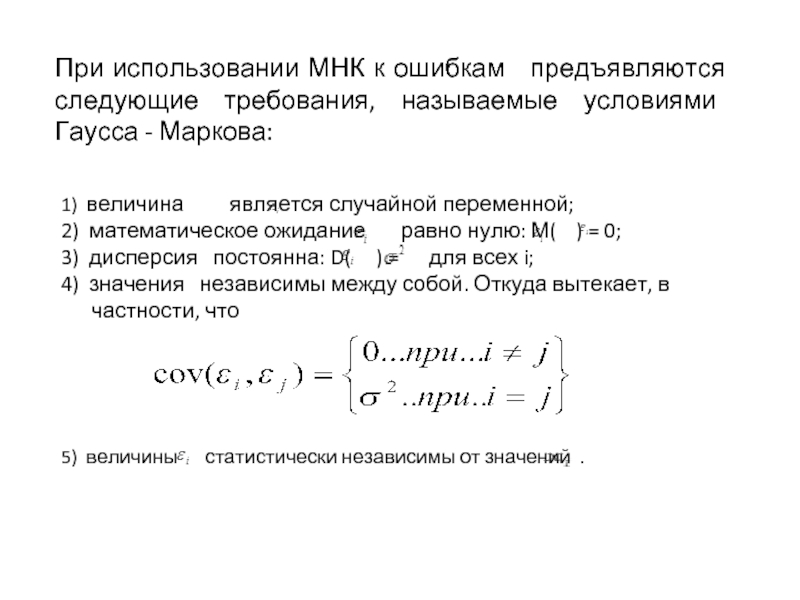

При использовании МНК к ошибкам предъявляются следующие требования, называемые условиями Гаусса - Маркова:

1) величина является случайной переменной;

2) математическое ожидание равно нулю: М( ) = 0;

3) дисперсия постоянна: D( ) = для всех i;

4) значения независимы между собой. Откуда вытекает, в

частности, что

5) величины статистически независимы от значений .

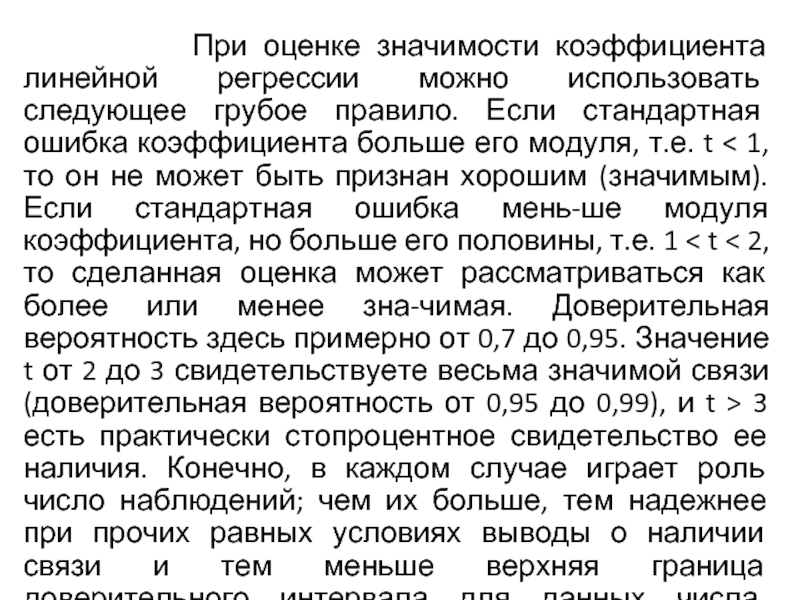

Слайд 5 При оценке значимости коэффициента линейной

Слайд 6 Коэффициент детерминации характеризует долю вариации (разброса)

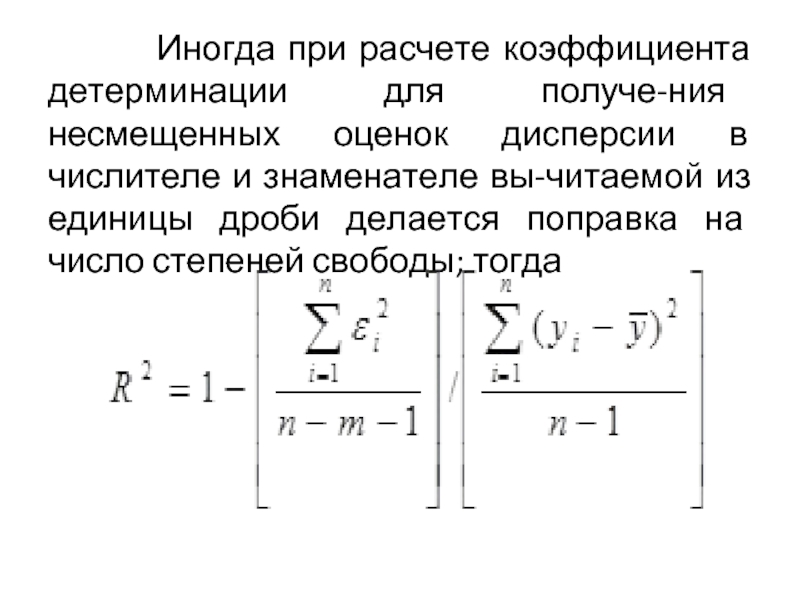

Слайд 7 Иногда при расчете коэффициента детерминации для

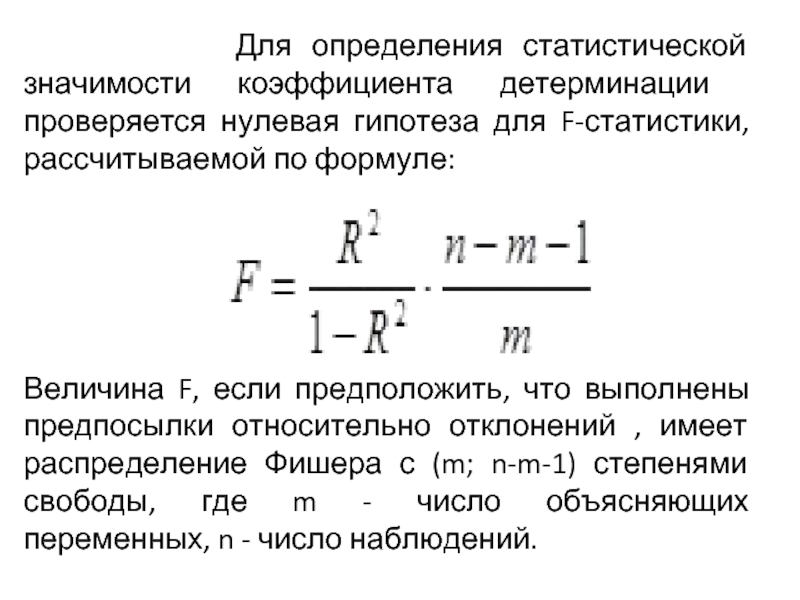

Слайд 8 Для определения статистической значимости коэффициента

Величина F, если предположить, что выполнены предпосылки относительно отклонений , имеет распределение Фишера с (m; n-m-1) степенями свободы, где m - число объясняющих переменных, n - число наблюдений.

Слайд 9

Гетероскедастичность.

Если остатки имеют постоянную

Гетероскедастичность приводит к тому, что коэффициенты регрессии больше не представляют собой лучшие оценки или не являются оценками с минимальной дисперсией, следовательно, они больше не являются наиболее эффективными коэффициентами.

Проверкой на гетероскедастичность служит тест Голдфелда-Кванта. Он требует, чтобы остатки были разделены на две группы из n наблюдений, одна группа с низкими, а другая - с высокими значениями. Обычно срединная одна шестая часть наблюдений удаляется после ранжирования в возрастающем порядке, чтобы улучшить разграничение между двумя группами.

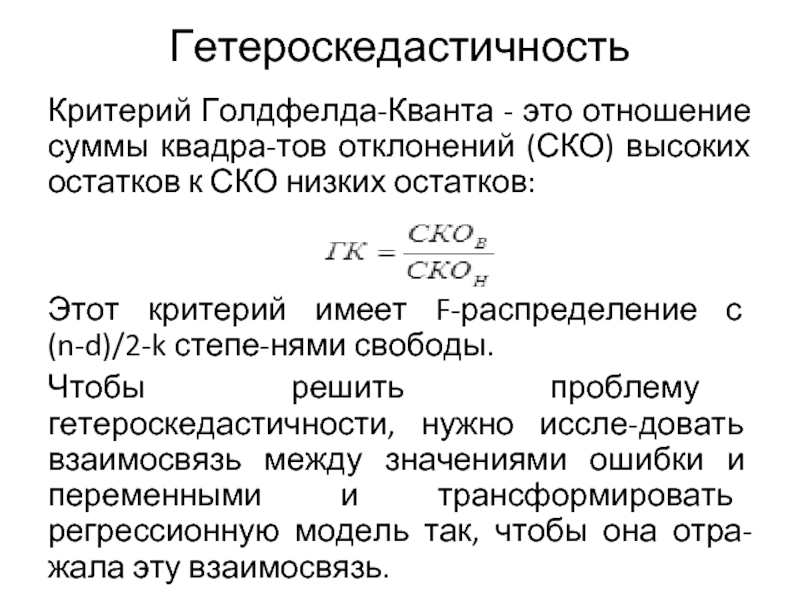

Слайд 10Гетероскедастичность

Критерий Голдфелда-Кванта - это отношение суммы квадратов отклонений (СКО) высоких остатков

Этот критерий имеет F-распределение с (n-d)/2-k степенями свободы.

Чтобы решить проблему гетероскедастичности, нужно исследовать взаимосвязь между значениями ошибки и переменными и трансформировать регрессионную модель так, чтобы она отражала эту взаимосвязь.

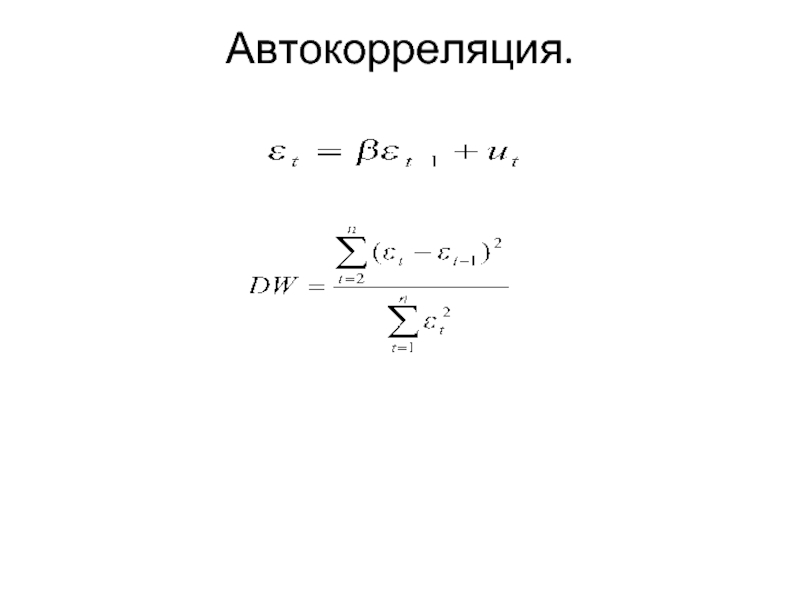

Слайд 12Автокорреляция

Автокорреляция, также известная как сериальная корреляция, имеет место, когда остатки не

Слайд 13Мультиколлинеарность

Если некоторые или все независимые переменные в множественной

Слайд 14Для уменьшения мультиколлинеарности может быть принято несколько мер:

Увеличивают объем выборки по

Исключают те переменные, которые высококоррелированны с остальными. Проблема здесь заключается в том, что возможно переменные были включены на теоретической основе, и будет неправомочным их исключение только лишь для того, чтобы сделать статистические результаты "лучше".

Слайд 15Фиктивные переменные

Иногда необходимо включение в регрессионную модель одной

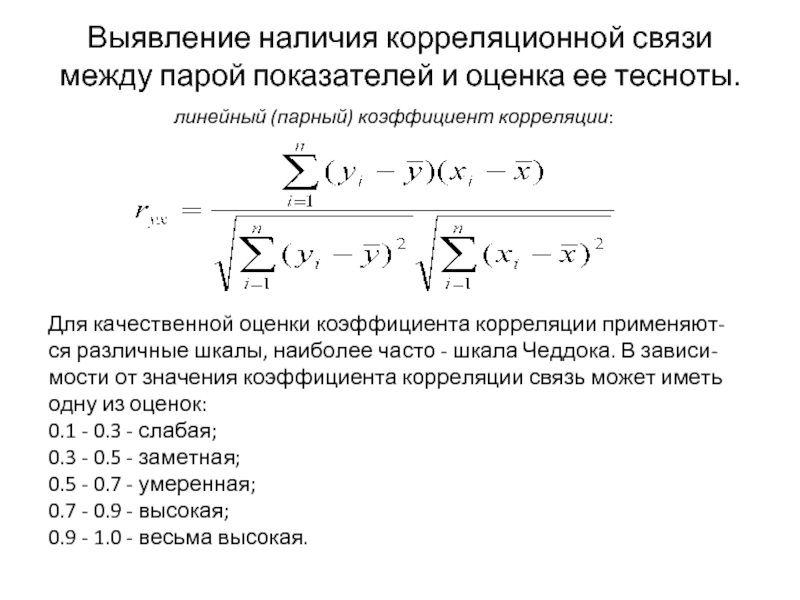

Слайд 17Выявление наличия корреляционной связи между парой показателей и оценка ее тесноты.

линейный

Для качественной оценки коэффициента корреляции применяются различные шкалы, наиболее часто - шкала Чеддока. В зависимости от значения коэффициента корреляции связь может иметь одну из оценок:

0.1 - 0.3 - слабая;

0.3 - 0.5 - заметная;

0.5 - 0.7 - умеренная;

0.7 - 0.9 - высокая;

0.9 - 1.0 - весьма высокая.

Слайд 18Оценка значимости коэффициента корреляции при малых объемах выборки выполняется с использованием

Слайд 19 Линейный коэффициент корреляции изменяется в пределах от -1

Слайд 20 Вычисленное по этой формуле значение tнабл сравнивается с

Если tнабл > tтаб, то полученное значение коэффициента корреляции признается значимым (т.е. нулевая гипотеза, утверждающая равенство нулю коэффициента корреляции, отвергается). И таким образом делается вывод, что между исследуемыми переменными есть тесная статистическая взаимосвязь.

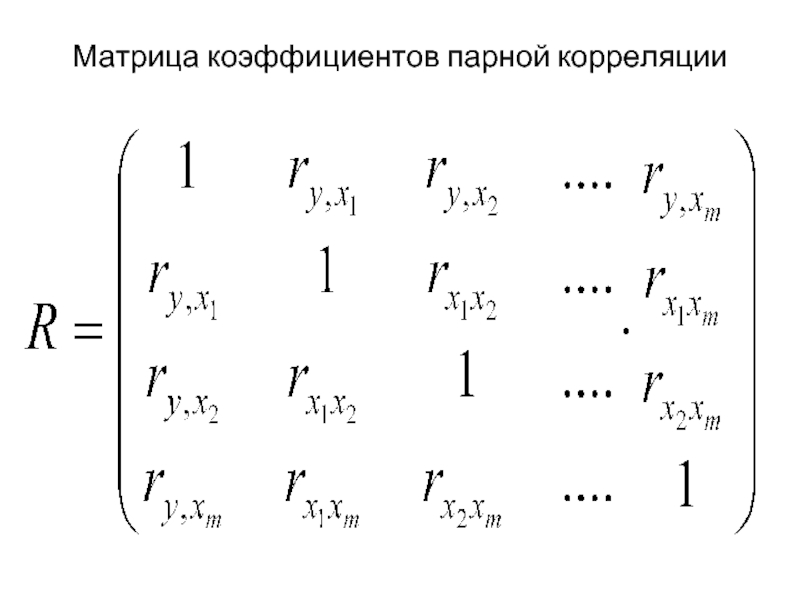

Слайд 22 Анализ матрицы коэффициентов парной корреляции используют

1. Определение тесноты связи одной случайной величины с совокупностью остальных величин, включенных в анализ.

2. Определение тесноты связи между двумя величинами при фиксировании или исключении влияния остальных величин.

Эти задачи решаются соответственно с помощью коэффициентов множественной и частной корреляции.

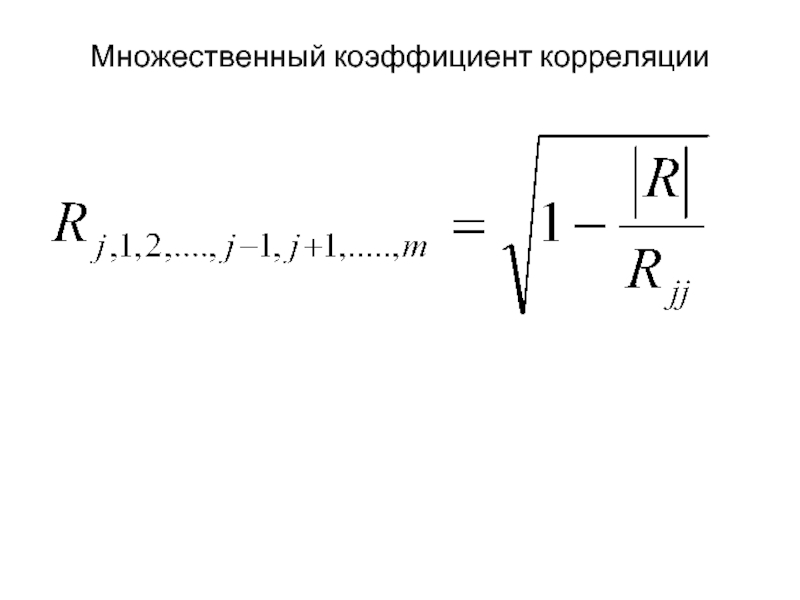

Слайд 24Решение первой задачи (определение тесноты связи одной случайной величины с совокупностью

элемента той же матрицы R.

Коэффициенты множественной корреляции и детерминации являются величинами положительными, принимающими значения в интервале от 0 до 1. При приближении коэффициента R2 к единице можно сделать вывод о тесноте взаимосвязи случайных величин, но не о ее направлении.

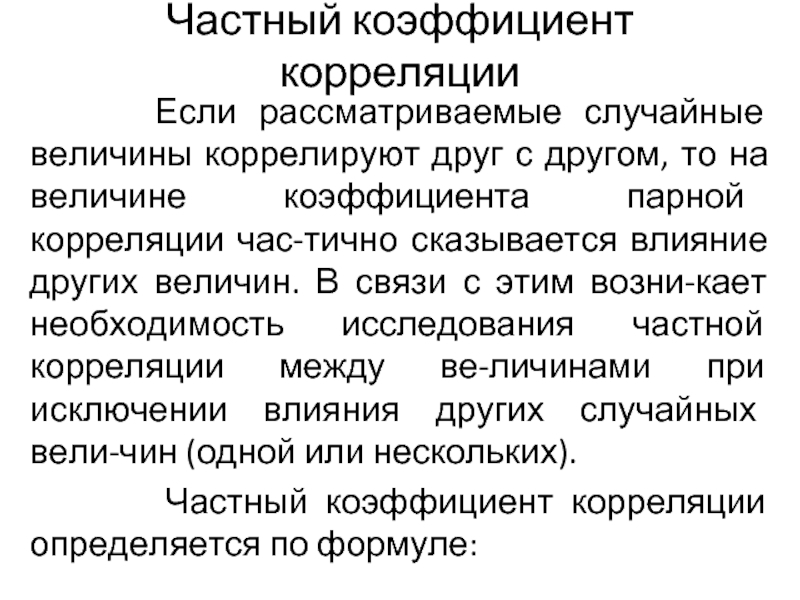

Слайд 25Частный коэффициент корреляции

Если рассматриваемые случайные величины коррелируют друг

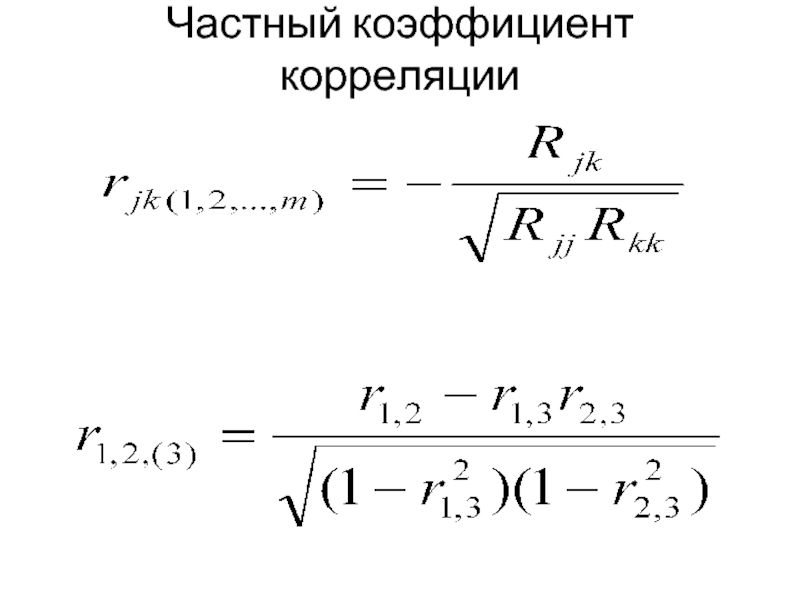

Частный коэффициент корреляции определяется по формуле:

Слайд 27Частный коэффициент корреляции, так же как и парный коэффициент корреляции, изменяется

Выражение при условии m = 3 будет иметь вид

Коэффициент называется коэффициентом корреляции между х1, и х2 при фиксированном х3. Он симметричен относительно первичных индексов 1, 2. Его вторичный индекс 3 относится к фиксированной переменной.