- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

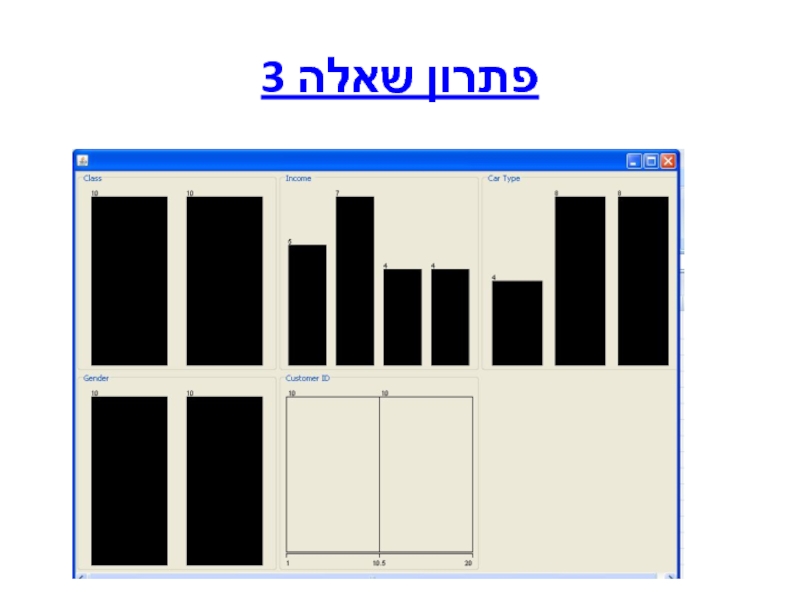

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

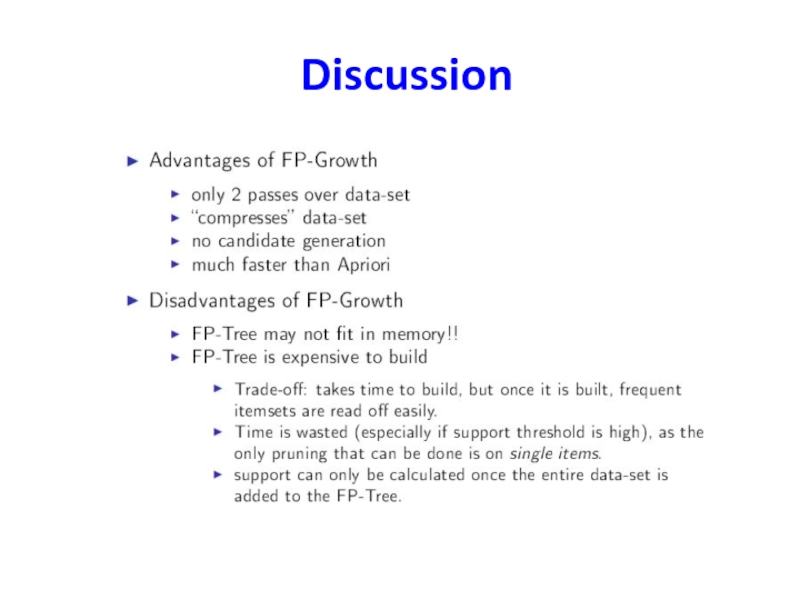

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

הבחינה כמו המטלות משמשת כלי ללימוד ,ומבטיחה הכנה טובה למבחן презентация

Содержание

- 1. הבחינה כמו המטלות משמשת כלי ללימוד ,ומבטיחה הכנה טובה למבחן

- 2. בחינת גמר לדוגמה שאלה 1 (20 נקודות)

- 3. פתרון שאלה 1 support(a) =25%

- 4. פתרון שאלה 1 ב = 0.2/0.25*0.9=0.88 =

- 5. שאלה 2 שאלה 2 (25 נקודות) –

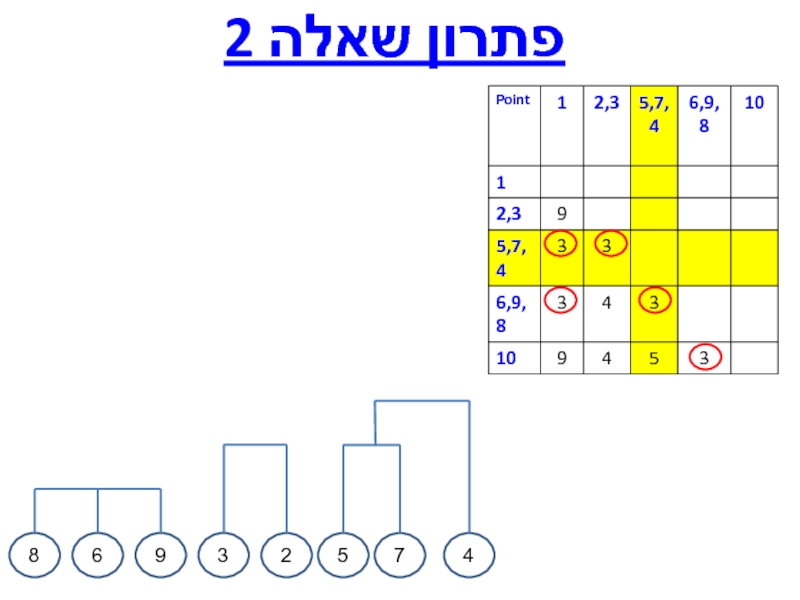

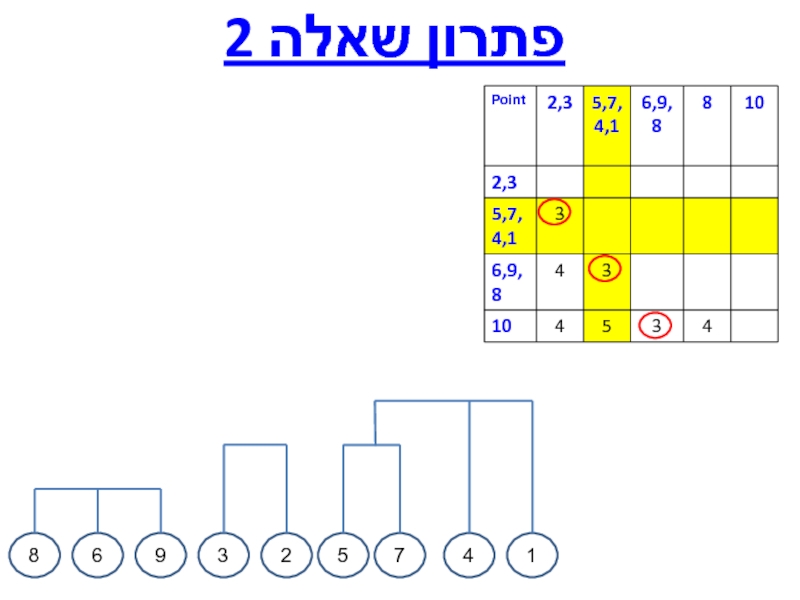

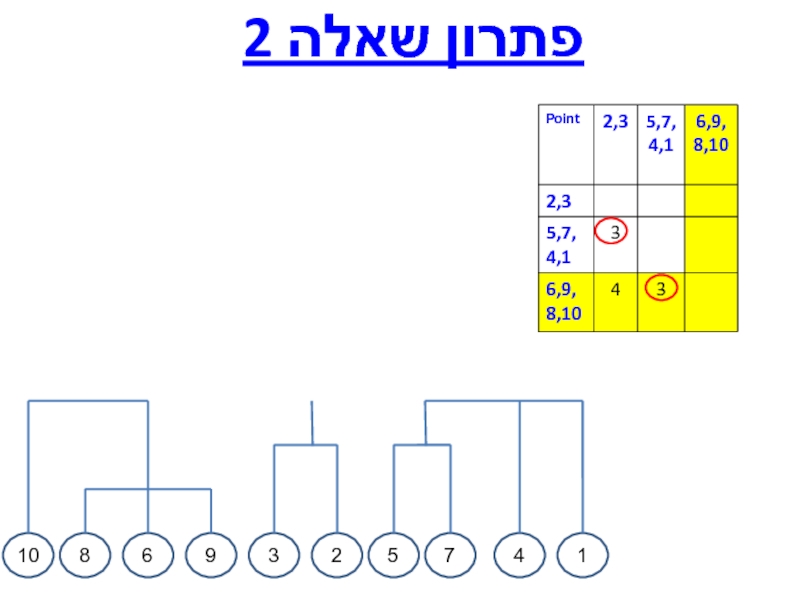

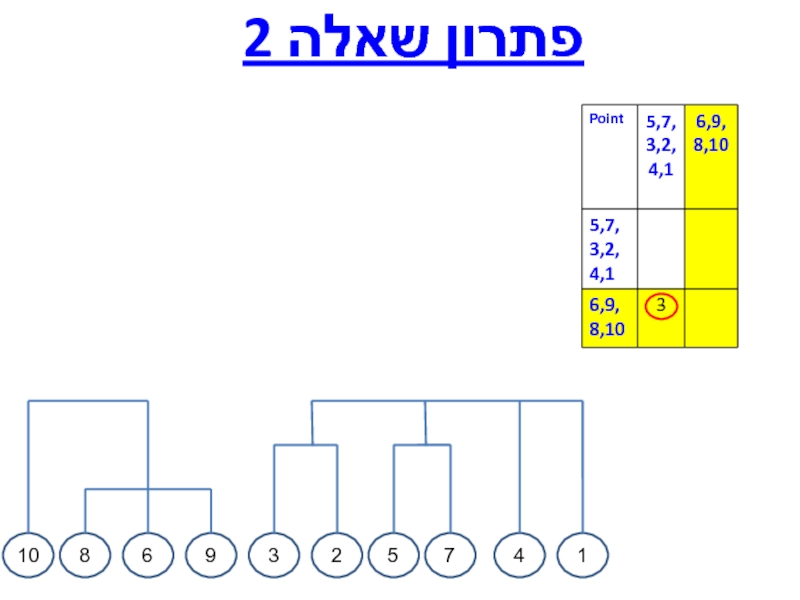

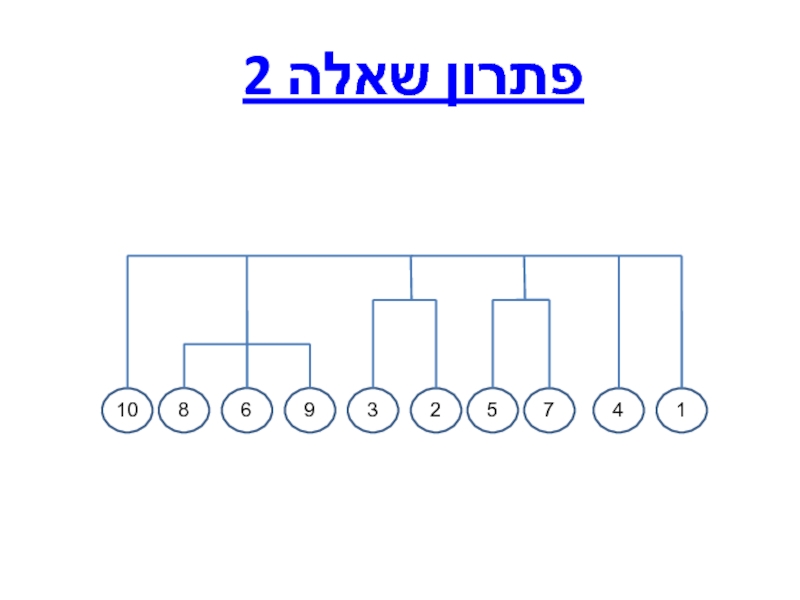

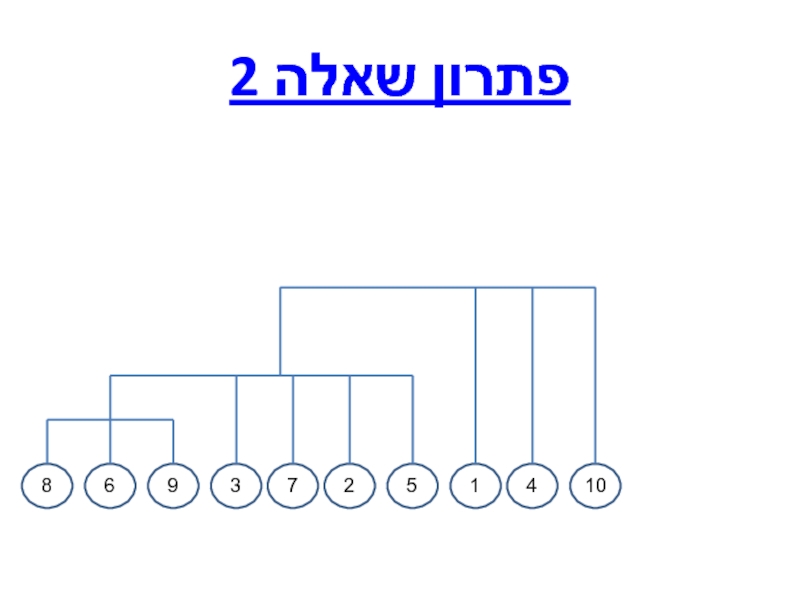

- 6. פתרון שאלה 2

- 7. פתרון שאלה 2

- 8. פתרון שאלה 2 6 9

- 9. פתרון שאלה 2 6 9 8

- 10. פתרון שאלה 2

- 11. פתרון שאלה 2

- 12. פתרון שאלה 2 4

- 13. פתרון שאלה 2 4 1

- 14. פתרון שאלה 2 4 1 10

- 15. פתרון שאלה 2 4 1 10

- 16. פתרון שאלה 2 4 1 10

- 17. פתרון שאלה 2 6 9

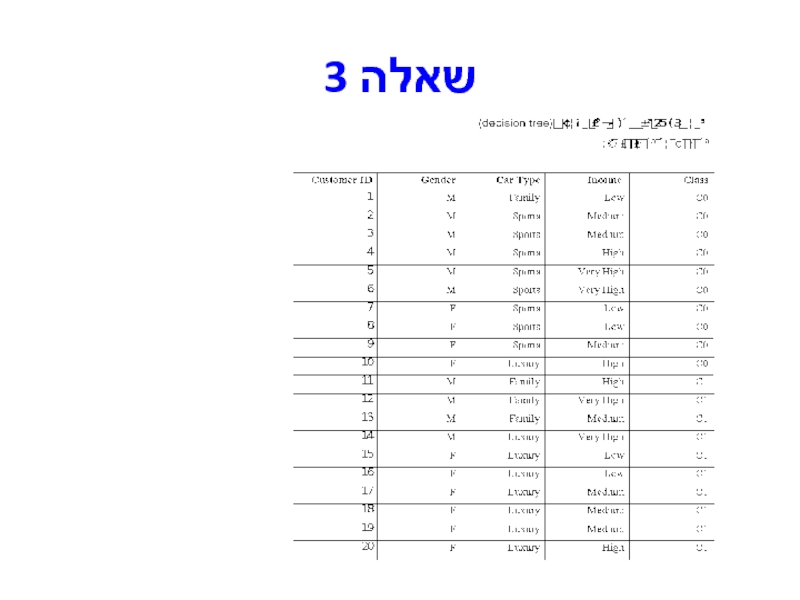

- 18. שאלה 3

- 19. שאלה 3 - המשך א. בנו עץ

- 20. פתרון שאלה 3

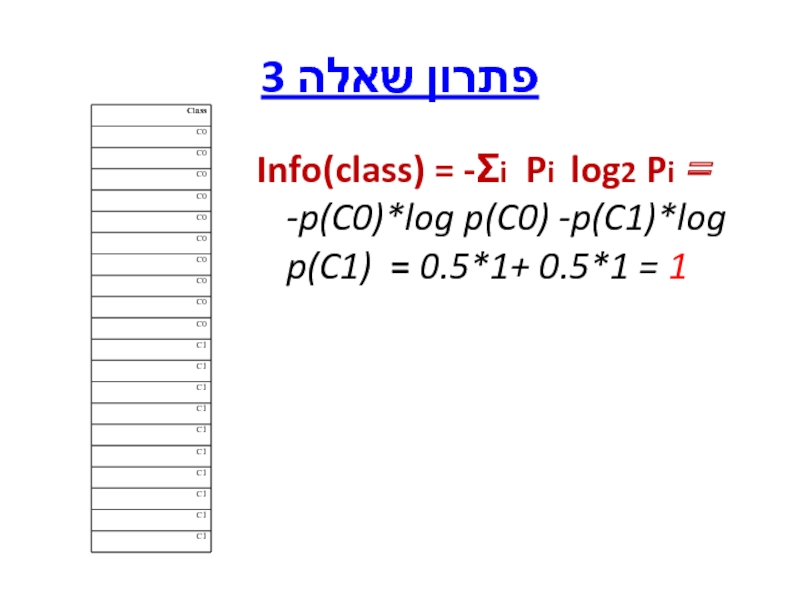

- 21. פתרון שאלה 3 Info(class) = -Σi Pi

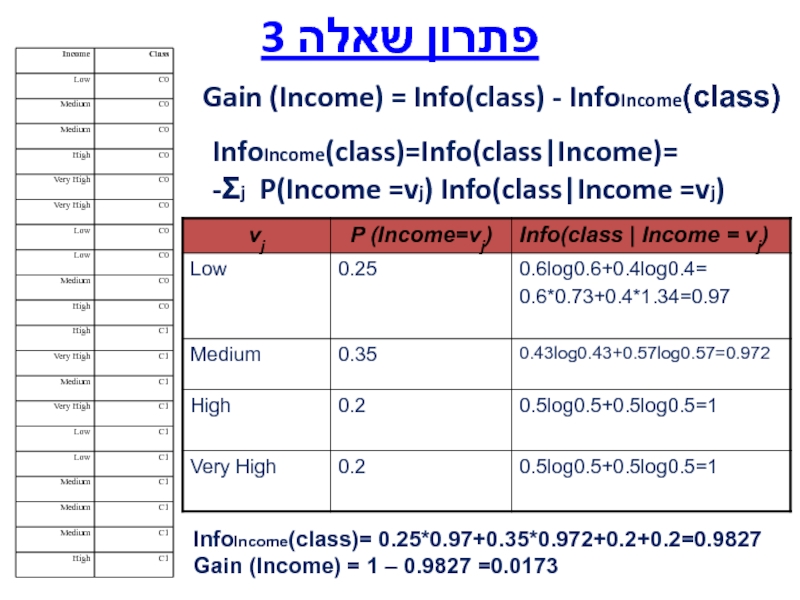

- 22. פתרון שאלה 3 Gain (Income) = Info(class)

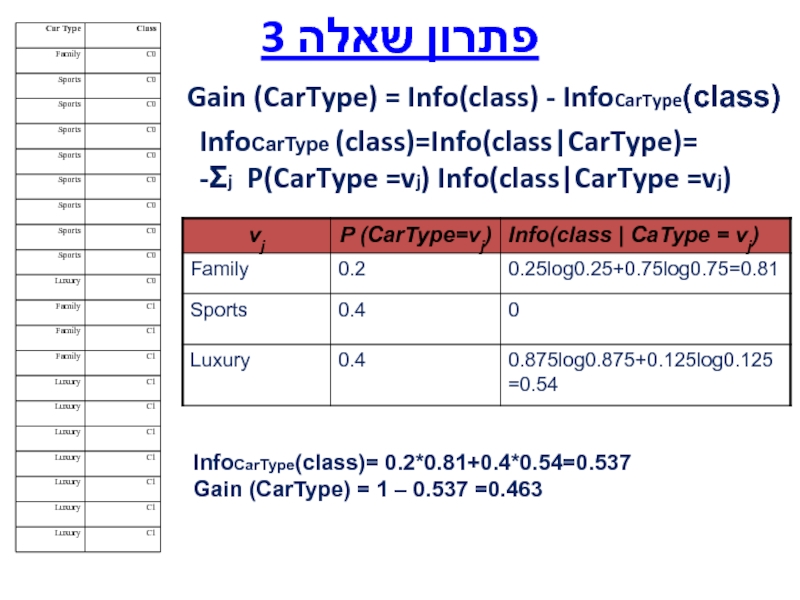

- 23. פתרון שאלה 3 Gain (CarType) = Info(class)

- 24. פתרון שאלה 3 Gain (Gender) = Info(class)

- 25. פתרון שאלה 3 Gain (Income) = 0.0173

- 26. פתרון שאלה 3 CarType sports luxury

- 27. שאלה 4 (20 נקודות)- סיווג וחיזוי (classification

- 28. פתרון שאלה 4 להלן עץ בינארי המחשב

- 29. פתרון שאלה 4 סריקת Pre-order של העץ

- 30. שאלה 5 (10 נקודות) במהלך קורס כריית

- 31. פתרון שאלה 5 בשאלה זו עליכם להתייחס

- 32. FP-Growth

- 33. Core Data Structure FP-Tree

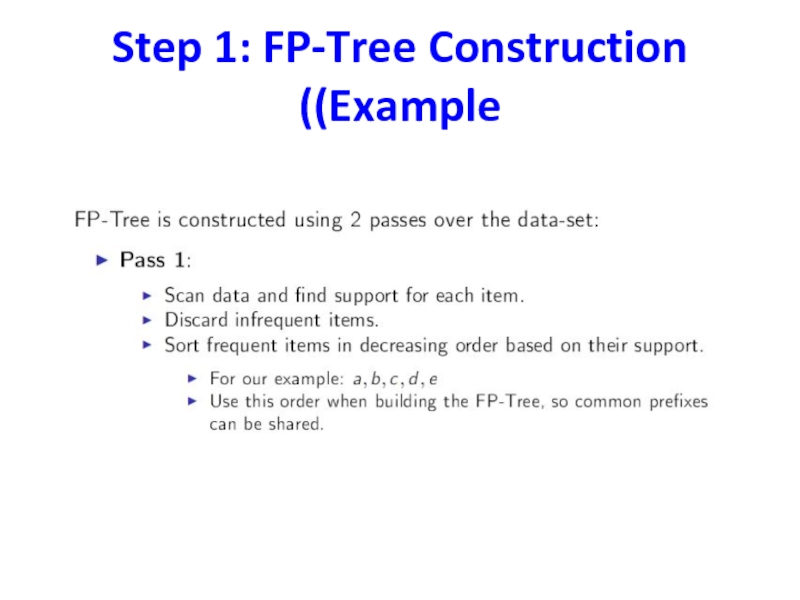

- 34. Step 1: FP-Tree Construction (Example)

- 35. Step 1: FP-Tree Construction (Example)

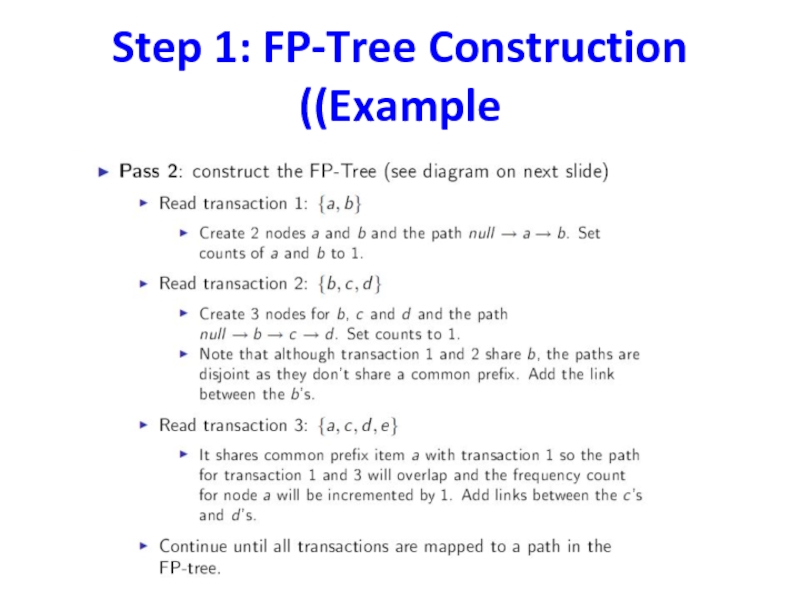

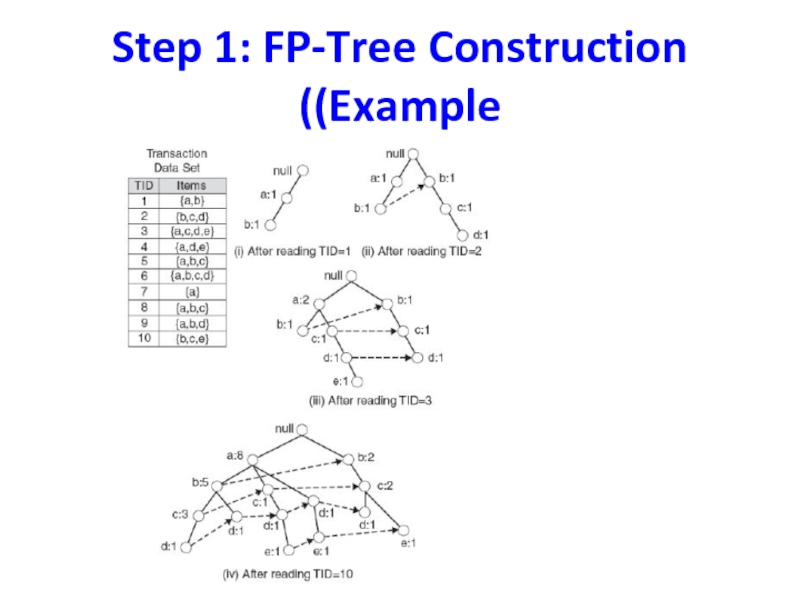

- 36. Step 1: FP-Tree Construction (Example)

- 37. FP-Tree size

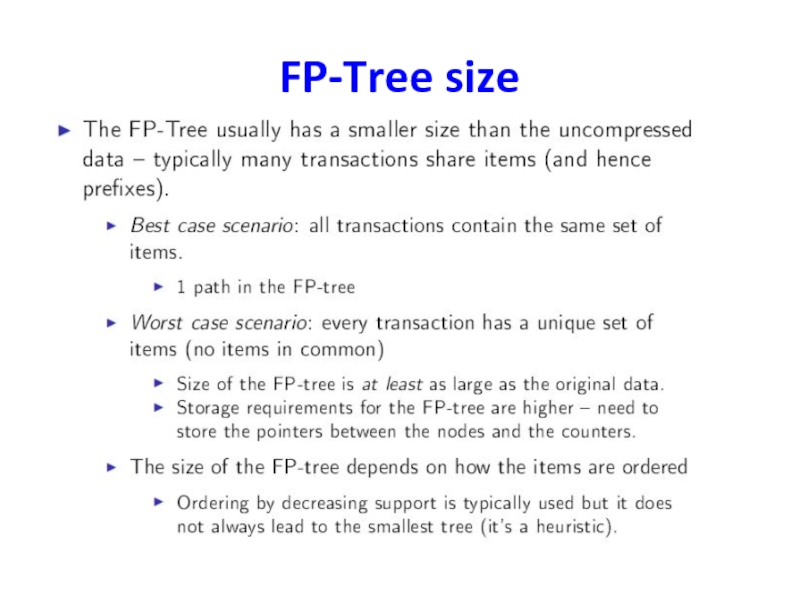

- 38. Step 2 : Frequent Itemset Generation

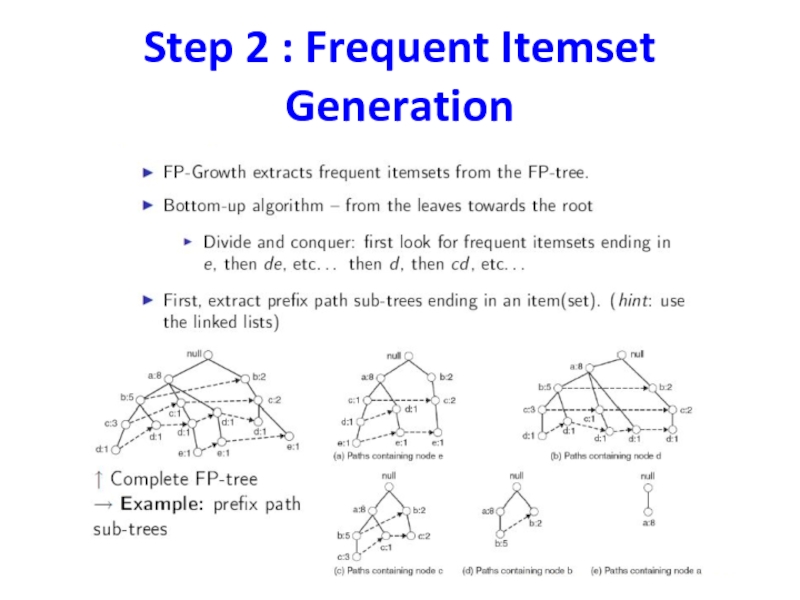

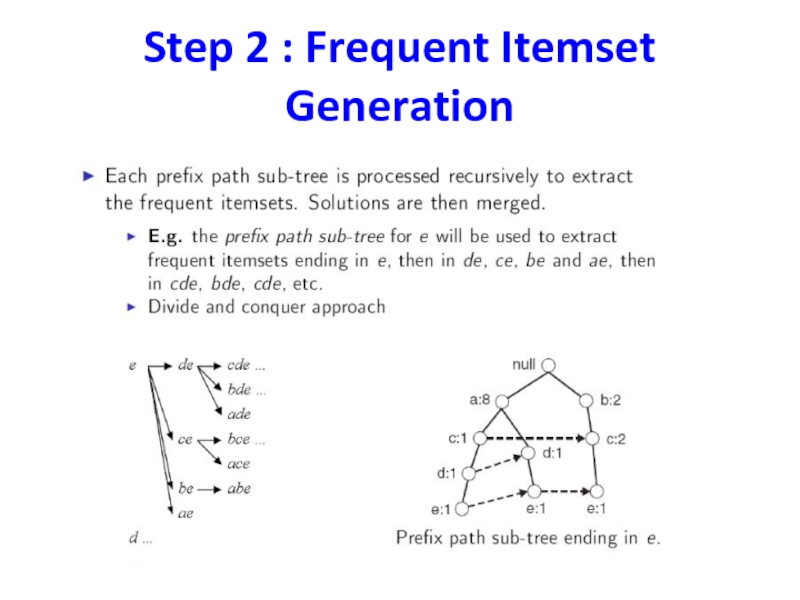

- 39. Step 2 : Frequent Itemset Generation

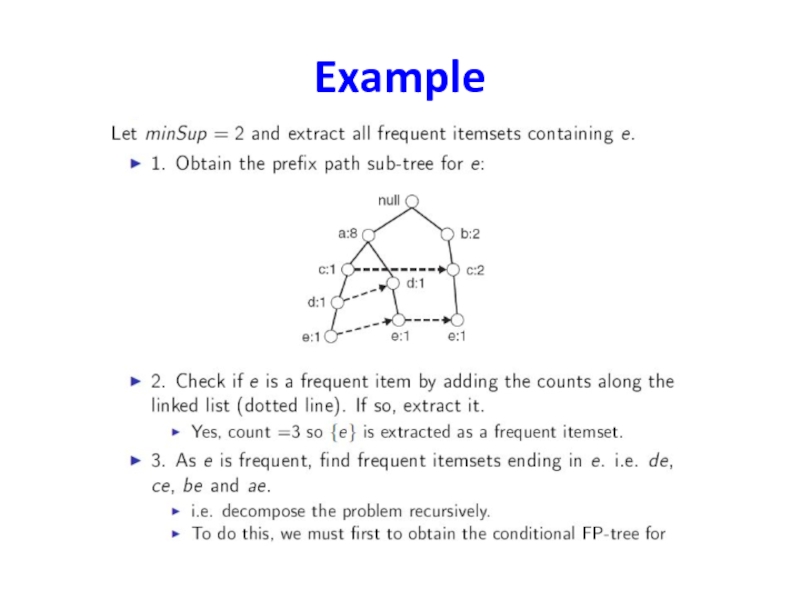

- 40. Example

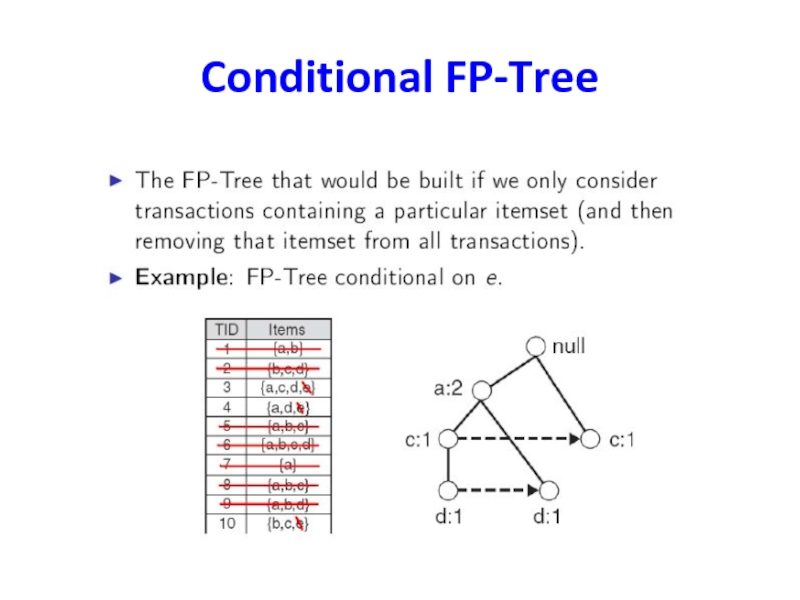

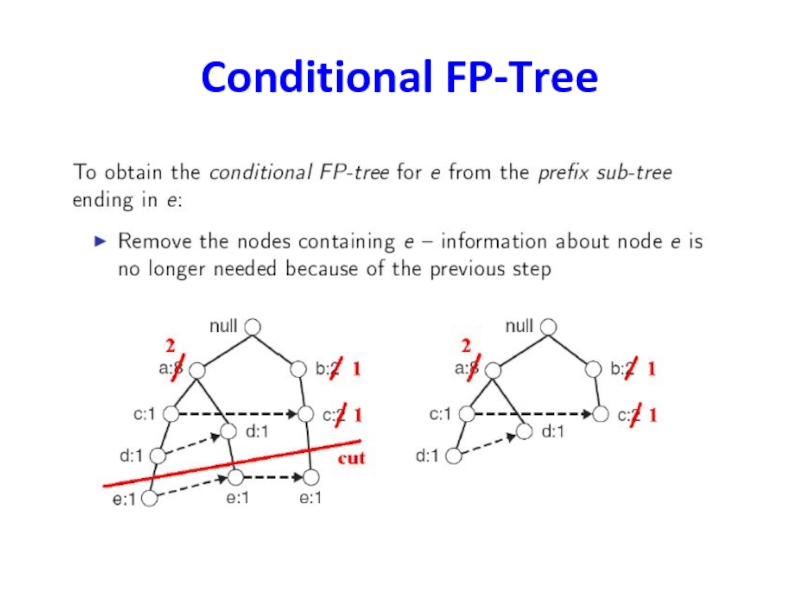

- 41. Conditional FP-Tree

- 42. Conditional FP-Tree

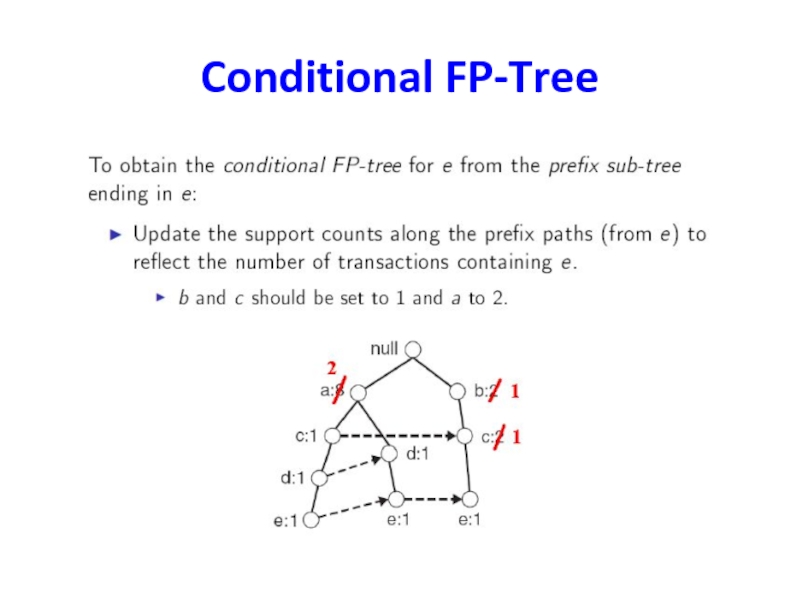

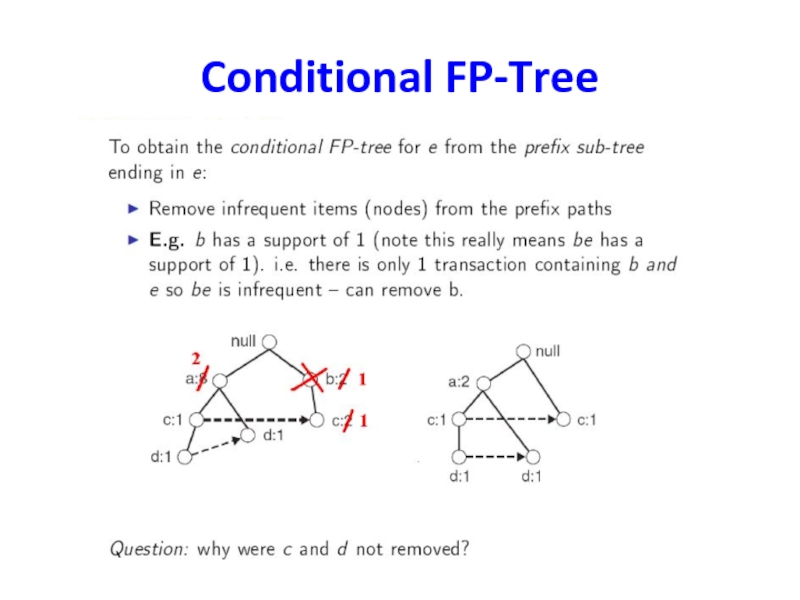

- 43. Conditional FP-Tree

- 44. Conditional FP-Tree

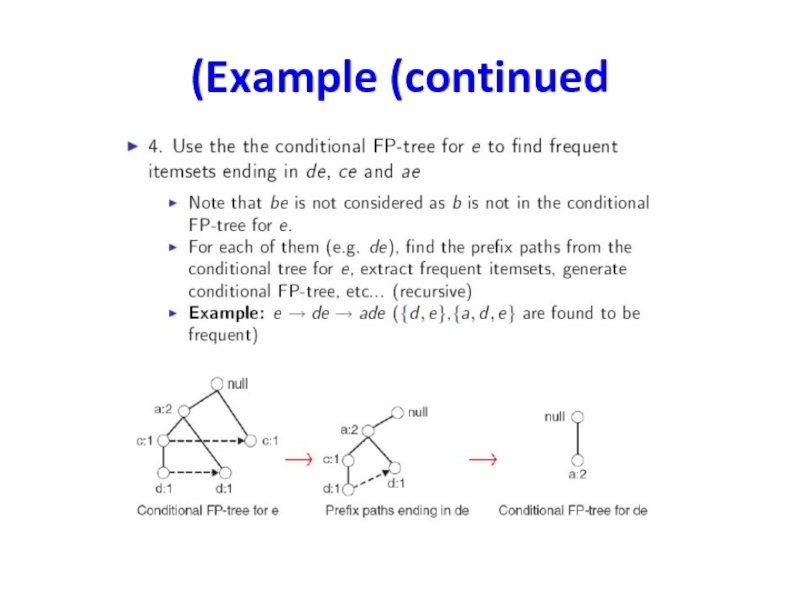

- 45. Example (continued)

- 46. Example (continued)

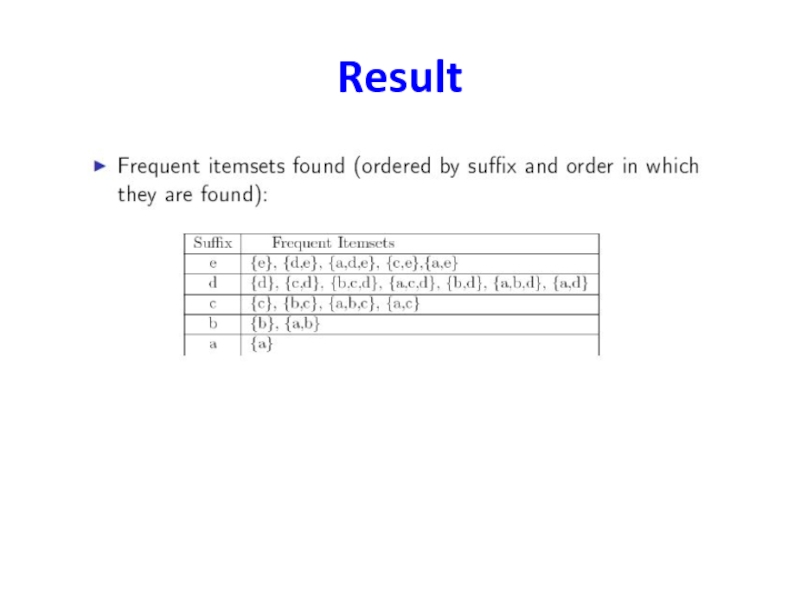

- 47. Result

- 48. Discussion

Слайд 1Data Mining 20595 - Class 7

Exam practice

שימו לב,

הבחינה לדוגמה שמופיעה להלן

אך אין כאן שום התחייבות מצידנו שהבחינות בסמסטר זה תהיינה זהות במבנה, באופי וכו' לבחינה שהפצנו.

הבחינה כמו המטלות משמשת כלי ללימוד, ומבטיחה הכנה טובה למבחן

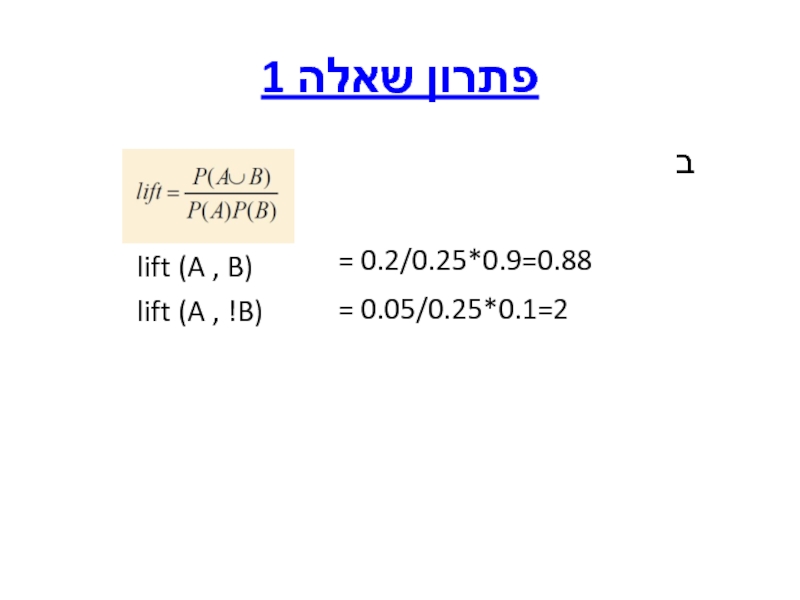

Слайд 2בחינת גמר לדוגמה

שאלה 1 (20 נקודות) – חוקי הקשר (association rules)

נתון

א. חשבו את הביטחון (confidence) עבור חוק ההקשר {a}?{b}

ב. בהמשך לסעיף א', האם החוק הוא בעל עניין (interesting) .

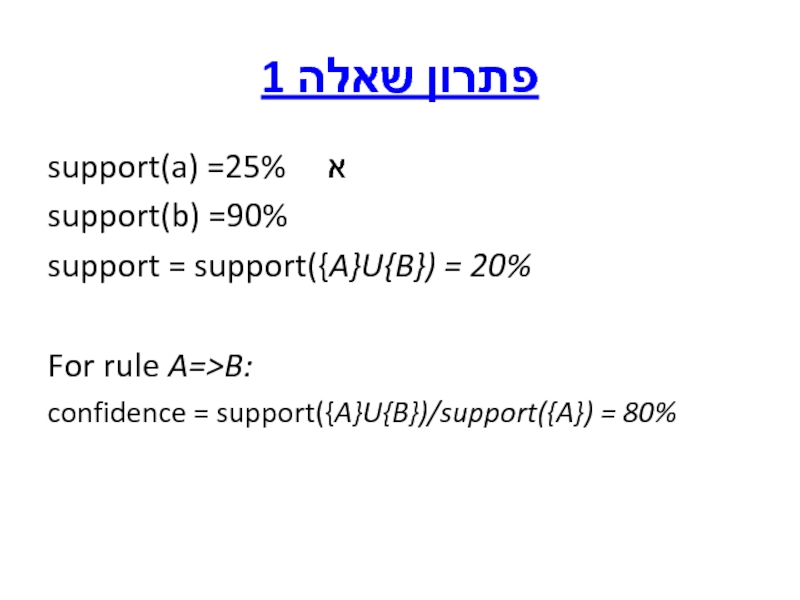

Слайд 3פתרון שאלה 1

support(a) =25% א

support(b) =90%

support = support({A}U{B}) = 20%

For rule A=>B:

confidence = support({A}U{B})/support({A}) = 80%

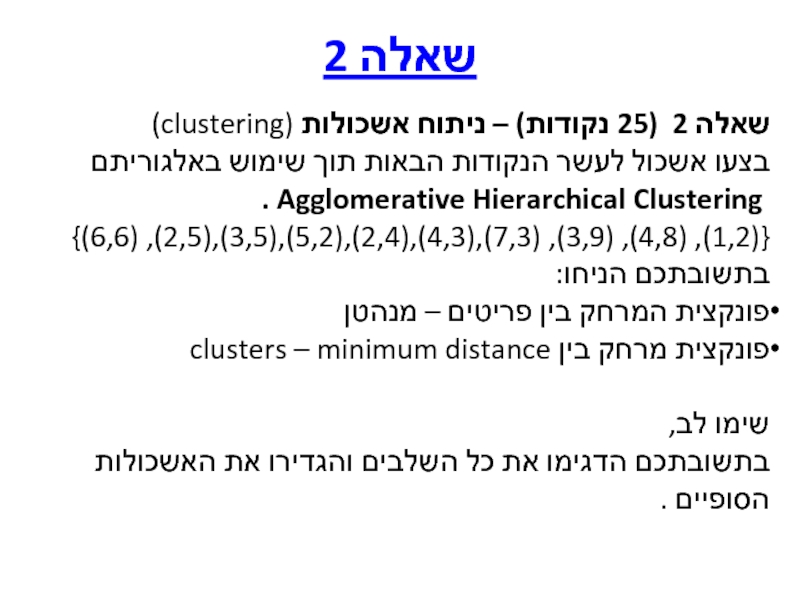

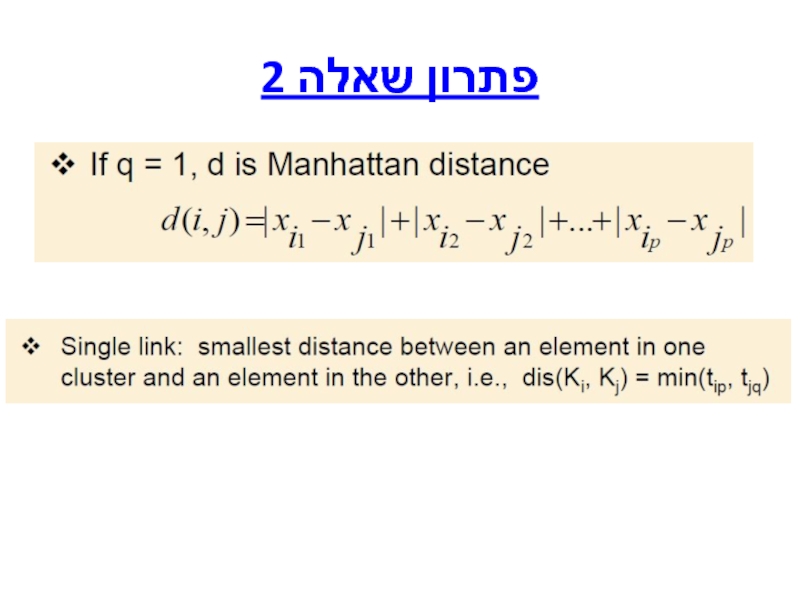

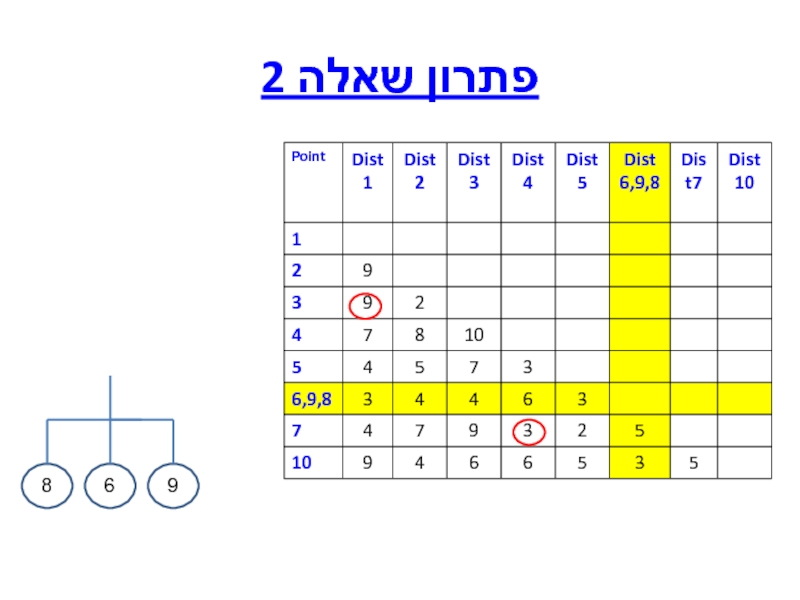

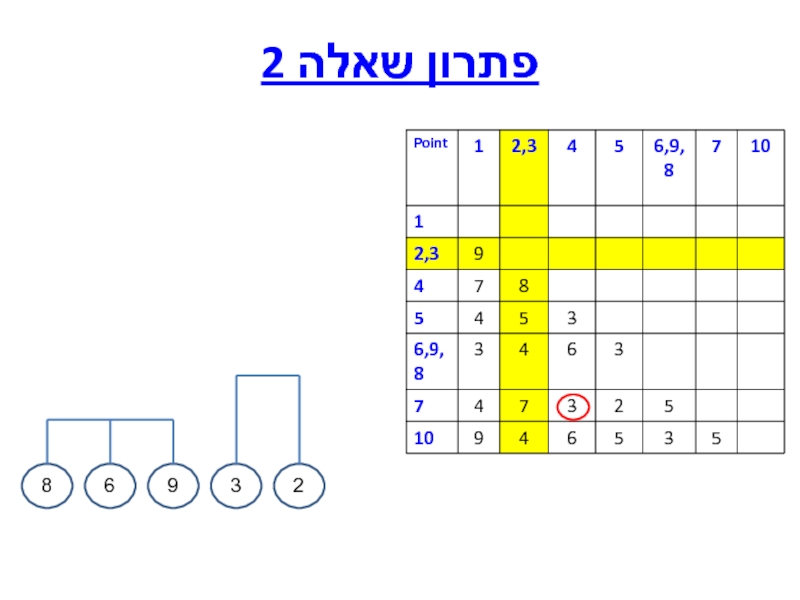

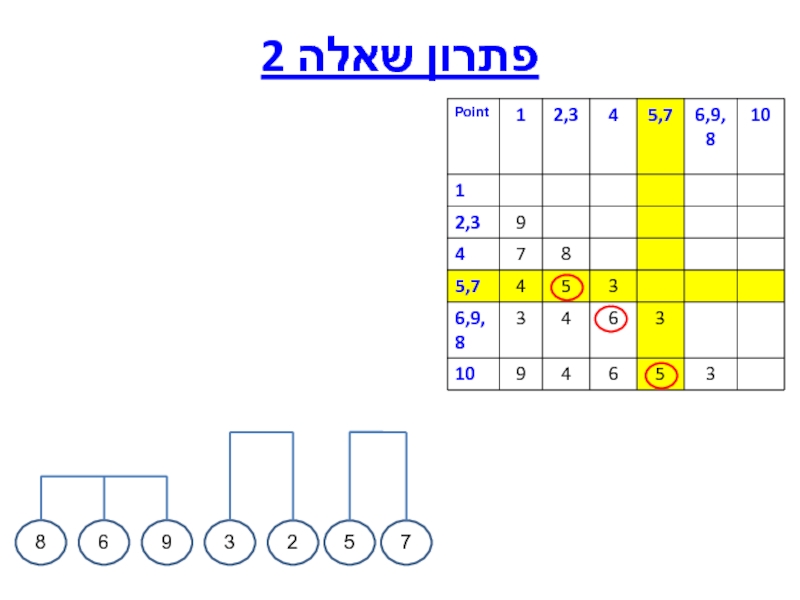

Слайд 5שאלה 2

שאלה 2 (25 נקודות) – ניתוח אשכולות (clustering)

בצעו אשכול לעשר

Agglomerative Hierarchical Clustering .

{(1,2), (4,8), (3,9), (7,3),(4,3),(2,4),(5,2),(3,5),(2,5), (6,6)}

בתשובתכם הניחו:

פונקצית המרחק בין פריטים – מנהטן

פונקצית מרחק בין clusters – minimum distance

שימו לב,

בתשובתכם הדגימו את כל השלבים והגדירו את האשכולות

הסופיים .

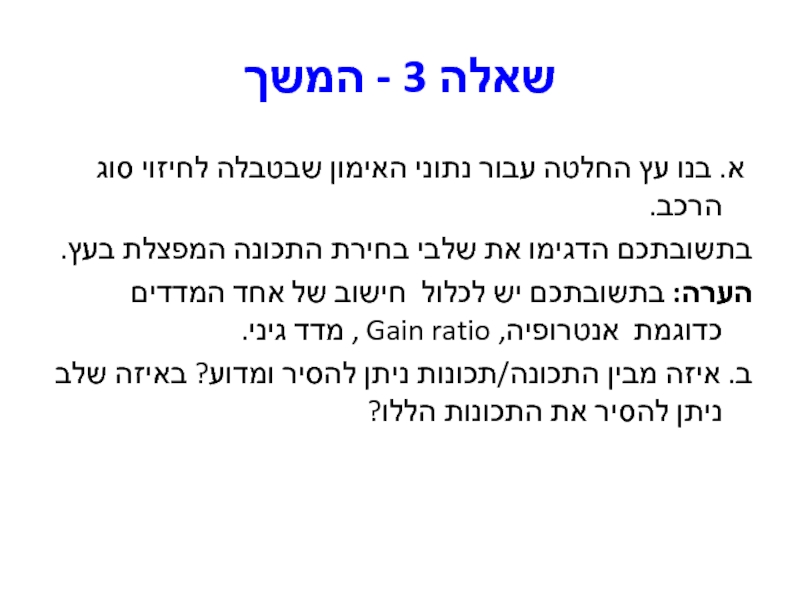

Слайд 19שאלה 3 - המשך

א. בנו עץ החלטה עבור נתוני האימון שבטבלה

בתשובתכם הדגימו את שלבי בחירת התכונה המפצלת בעץ.

הערה: בתשובתכם יש לכלול חישוב של אחד המדדים כדוגמת אנטרופיה, Gain ratio , מדד גיני.

ב. איזה מבין התכונה/תכונות ניתן להסיר ומדוע? באיזה שלב ניתן להסיר את התכונות הללו?

Слайд 21פתרון שאלה 3

Info(class) = -Σi Pi log2 Pi =

Слайд 22פתרון שאלה 3

Gain (Income) = Info(class) - InfoIncome(class)

InfoIncome(class)=Info(class|Income)=

-Σj P(Income =vj)

InfoIncome(class)= 0.25*0.97+0.35*0.972+0.2+0.2=0.9827

Gain (Income) = 1 – 0.9827 =0.0173

Слайд 23פתרון שאלה 3

Gain (CarType) = Info(class) - InfoCarType(class)

InfoCarType (class)=Info(class|CarType)=

-Σj P(CarType

InfoCarType(class)= 0.2*0.81+0.4*0.54=0.537

Gain (CarType) = 1 – 0.537 =0.463

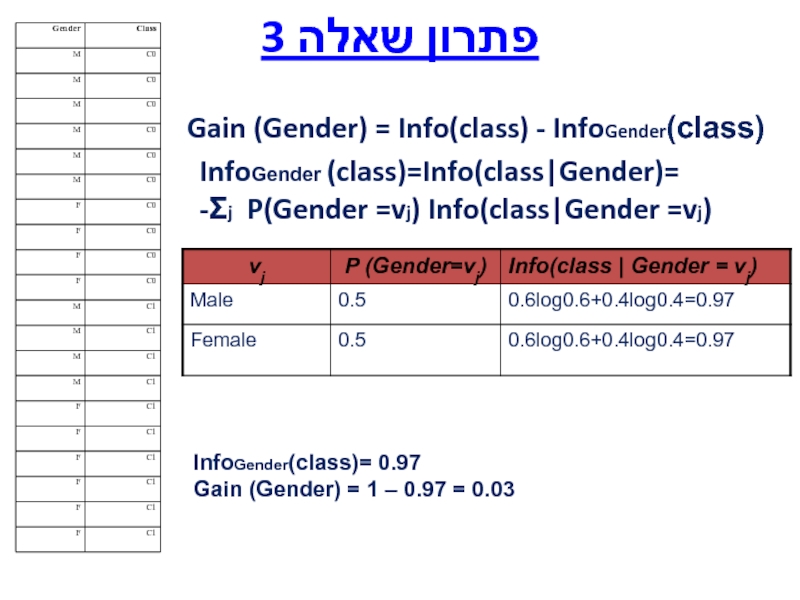

Слайд 24פתרון שאלה 3

Gain (Gender) = Info(class) - InfoGender(class)

InfoGender (class)=Info(class|Gender)=

-Σj P(Gender

InfoGender(class)= 0.97

Gain (Gender) = 1 – 0.97 = 0.03

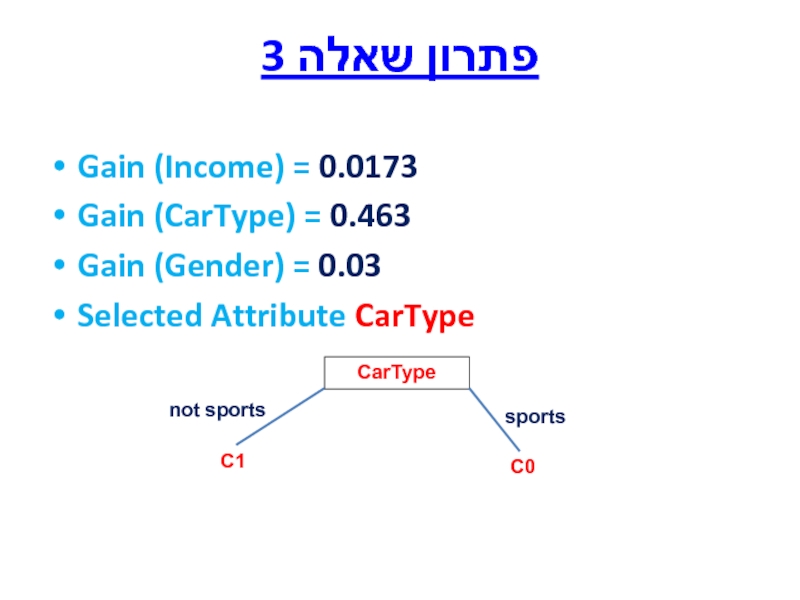

Слайд 25פתרון שאלה 3

Gain (Income) = 0.0173

Gain (CarType) = 0.463

Gain (Gender) =

Selected Attribute CarType

CarType

sports

not sports

C0

C1

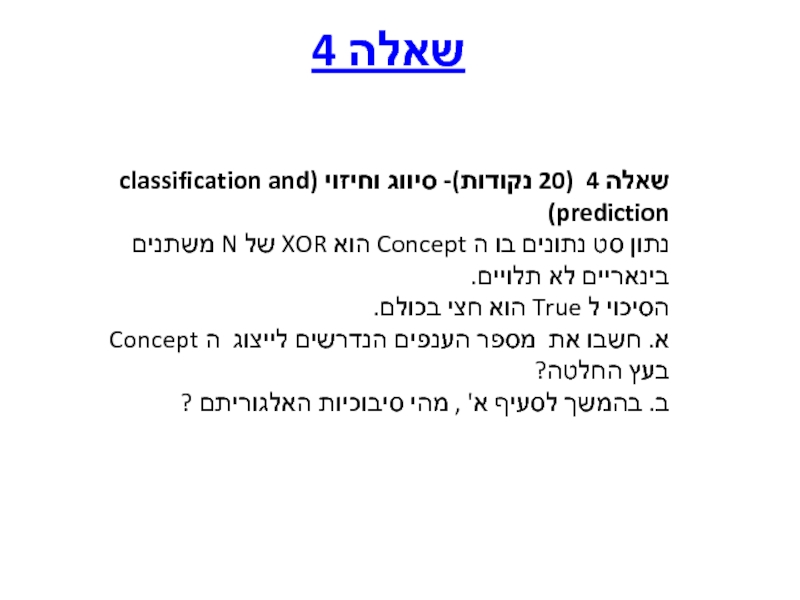

Слайд 27שאלה 4 (20 נקודות)- סיווג וחיזוי (classification and prediction)

נתון סט נתונים

הסיכוי ל True הוא חצי בכולם.

א. חשבו את מספר הענפים הנדרשים לייצוג ה Concept בעץ החלטה?

ב. בהמשך לסעיף א' , מהי סיבוכיות האלגוריתם ?

שאלה 4

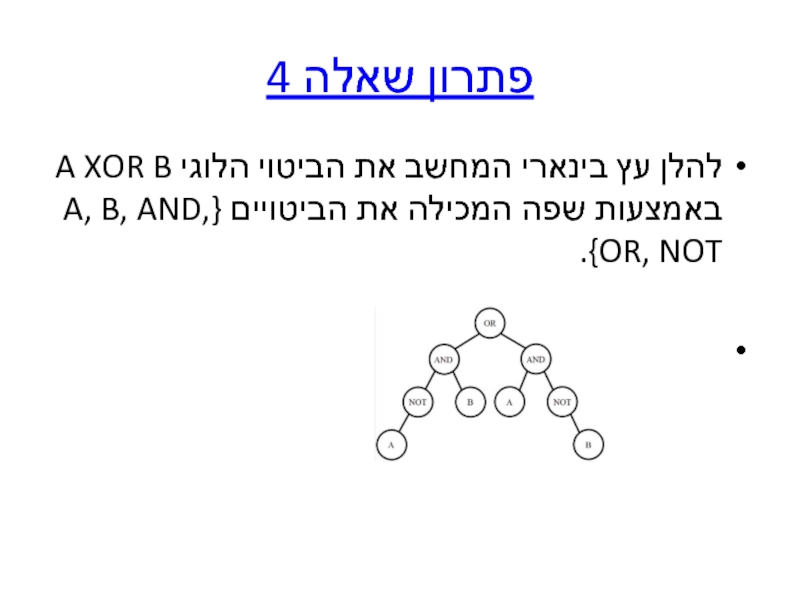

Слайд 28פתרון שאלה 4

להלן עץ בינארי המחשב את הביטוי הלוגי A XOR

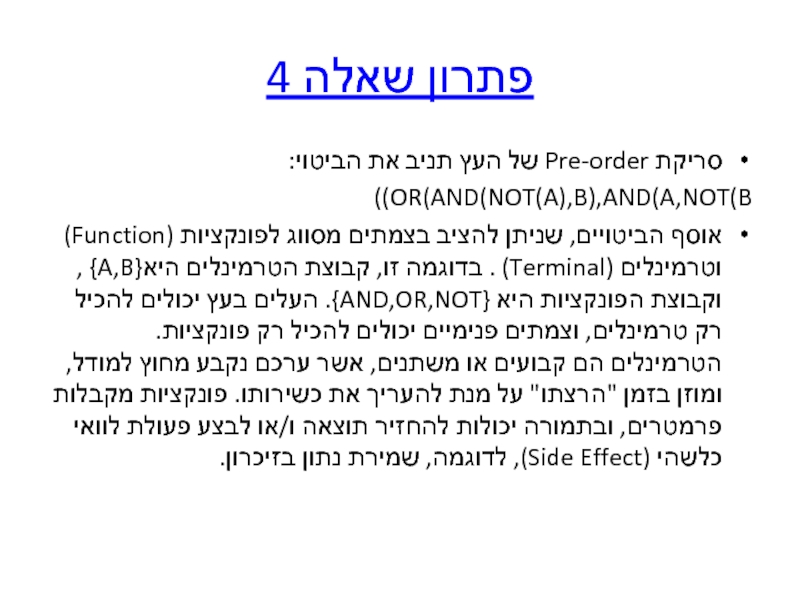

Слайд 29פתרון שאלה 4

סריקת Pre-order של העץ תניב את הביטוי:

OR(AND(NOT(A),B),AND(A,NOT(B))

אוסף הביטויים, שניתן

Слайд 30שאלה 5 (10 נקודות)

במהלך קורס כריית מידע טען אחד הסטודנטים "בחברה

חוו דעתכם

שאלה 5