- Главная

- Разное

- Дизайн

- Бизнес и предпринимательство

- Аналитика

- Образование

- Развлечения

- Красота и здоровье

- Финансы

- Государство

- Путешествия

- Спорт

- Недвижимость

- Армия

- Графика

- Культурология

- Еда и кулинария

- Лингвистика

- Английский язык

- Астрономия

- Алгебра

- Биология

- География

- Детские презентации

- Информатика

- История

- Литература

- Маркетинг

- Математика

- Медицина

- Менеджмент

- Музыка

- МХК

- Немецкий язык

- ОБЖ

- Обществознание

- Окружающий мир

- Педагогика

- Русский язык

- Технология

- Физика

- Философия

- Химия

- Шаблоны, картинки для презентаций

- Экология

- Экономика

- Юриспруденция

Открытый стандарт Open MP презентация

Содержание

- 1. Открытый стандарт Open MP

- 2. Хотим все, сразу и бесплатно Программисты всегда

- 3. OpenMP Открытый стандарт OpenMP Architecture Review Board Windows, Linux, Mac OS X, Solaris «Учредители»:

- 4. Поддержка OpenMP Microsoft Visual Studio 2005 и

- 5. Что такое OpenMP? Стандарт Библиотека времени выполнения Поддержка в компиляторе

- 6. Что такое OpenMP? OpenMP подразумевает маркировку параллельного

- 7. OpenMP-программа Типичная схема

- 8. Лучше один раз увидеть… double a[N], b[N],

- 9. Формат директив #pragma omp [directive] [clause [clause]

- 10. Подключение в C++ /openmp – флаг компилятору в VS

- 11. Инкрементальный параллелизм Не нужно выкидывать старую программу

- 12. Модель с разделяемой памятью Все потоки имеют

- 13. По умолчанию Все переменные shared общие, кроме: Индексов параллельных циклов Переменных, объявленных внутри параллельных регионов

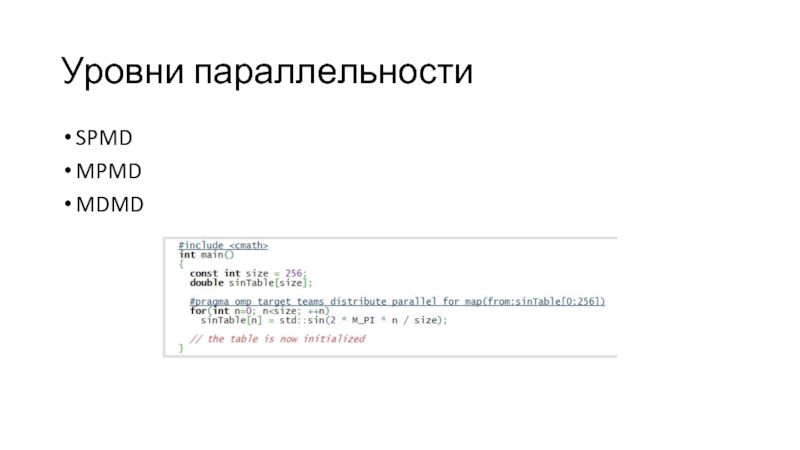

- 14. Уровни параллельности SPMD MPMD MDMD

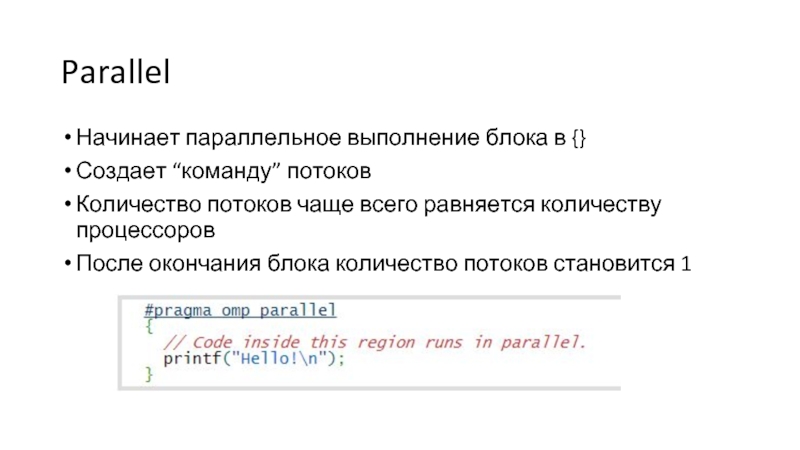

- 15. Parallel Начинает параллельное выполнение блока в {}

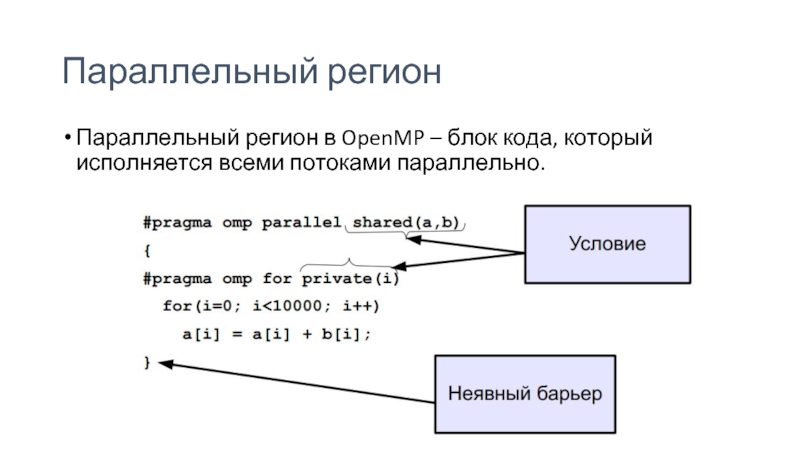

- 16. Параллельный регион Параллельный регион в OpenMP – блок кода, который исполняется всеми потоками параллельно.

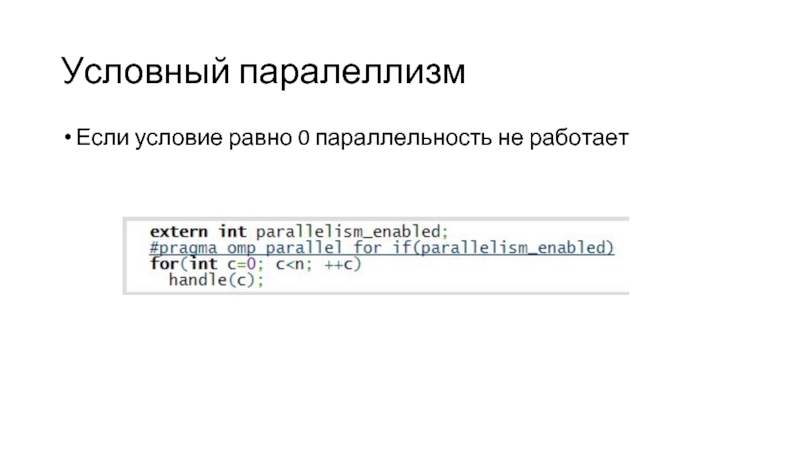

- 17. Условный паралеллизм Если условие равно 0 параллельность не работает

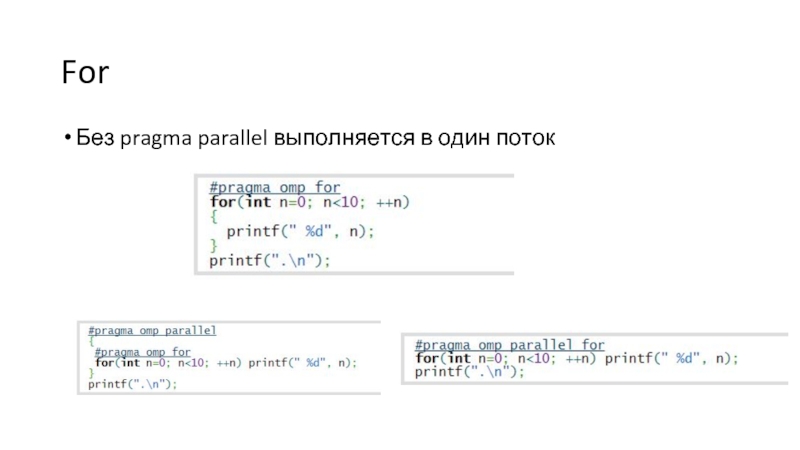

- 18. For Без pragma parallel выполняется в один поток

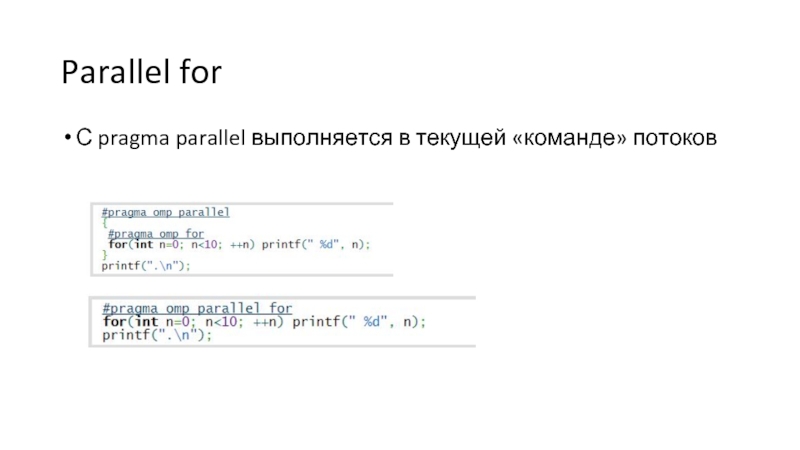

- 19. Parallel for С pragma parallel выполняется в текущей «команде» потоков

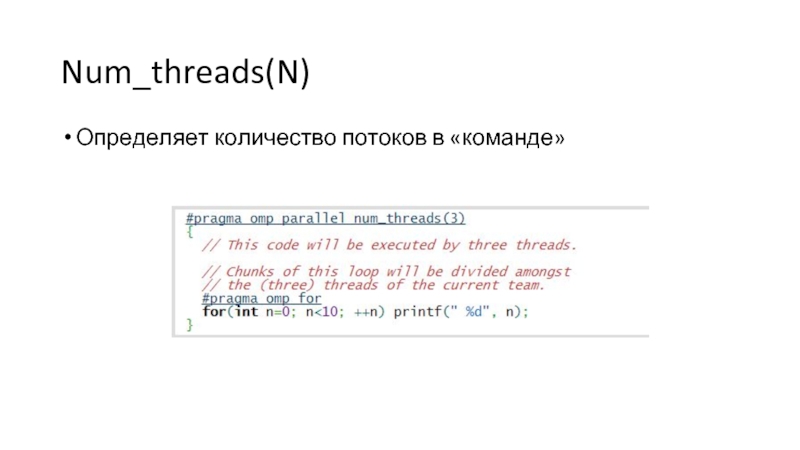

- 20. Num_threads(N) Определяет количество потоков в «команде»

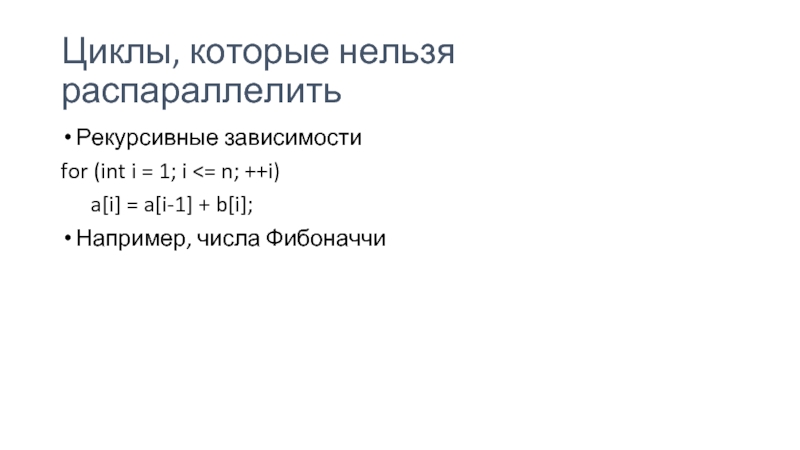

- 21. Циклы, которые нельзя распараллелить Рекурсивные зависимости for (int i = 1; i

- 22. Зависимости Решение зависимостей: перегруппировка кода переписывание алгоритмов

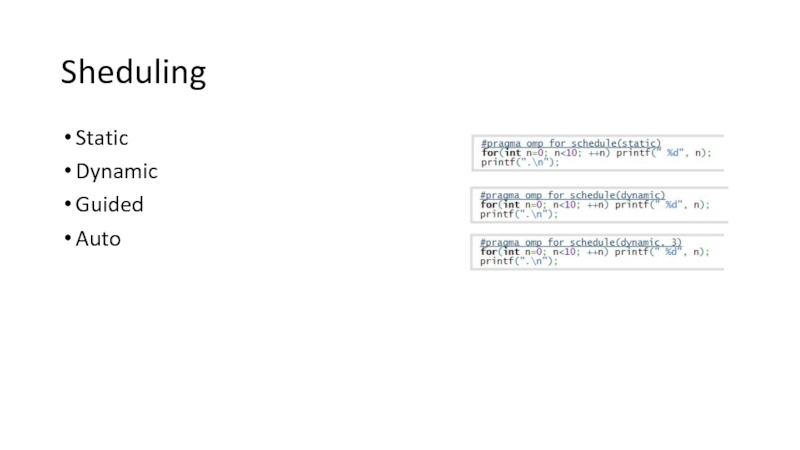

- 23. Sheduling Static Dynamic Guided Auto

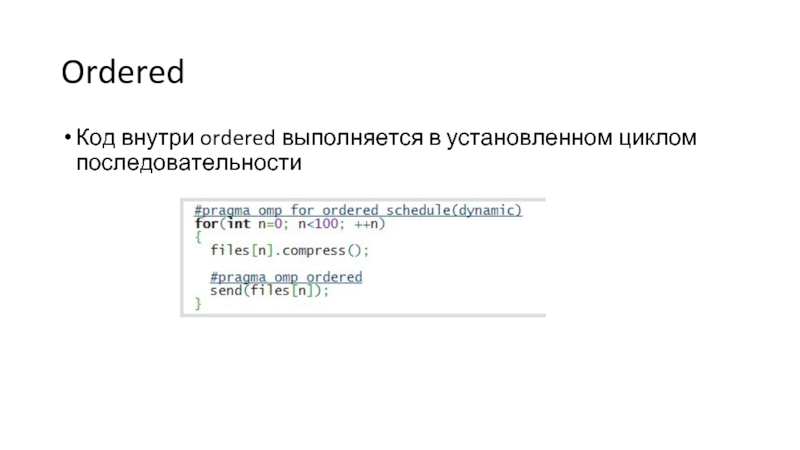

- 24. Ordered Код внутри ordered выполняется в установленном циклом последовательности

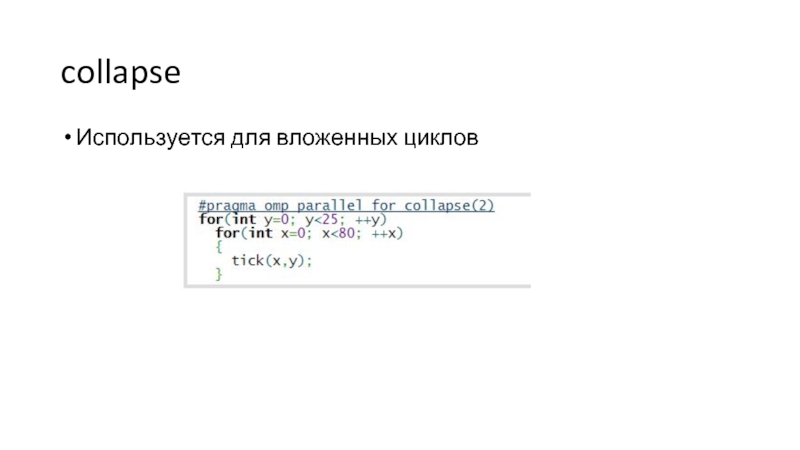

- 25. collapse Используется для вложенных циклов

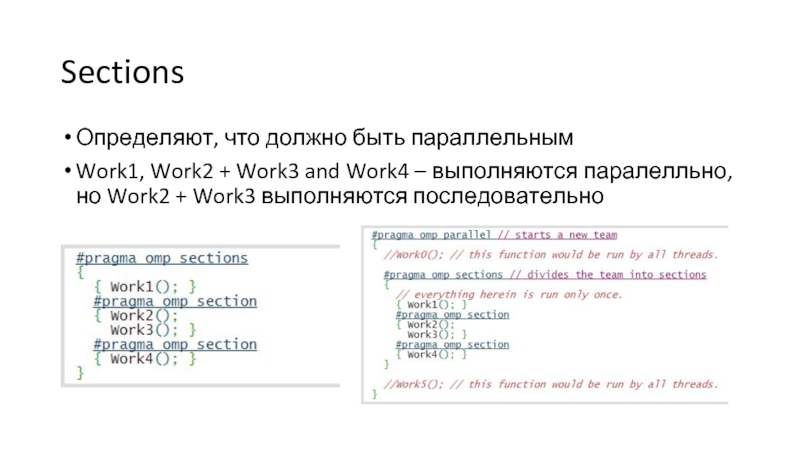

- 26. Sections Определяют, что должно быть параллельным Work1,

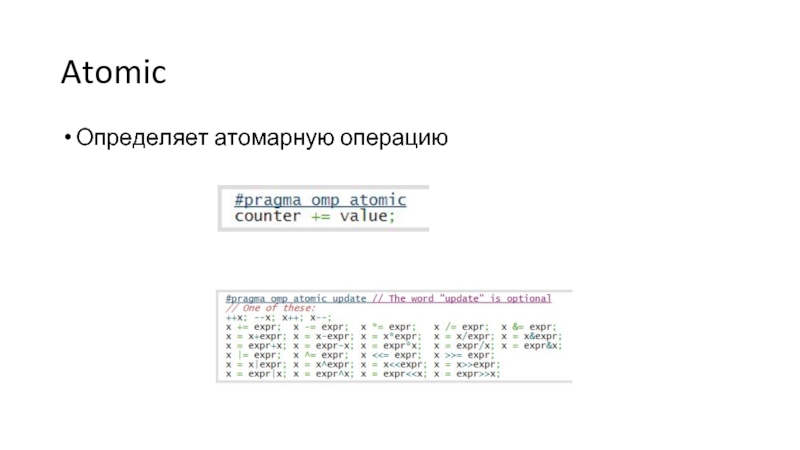

- 27. Atomic Определяет атомарную операцию

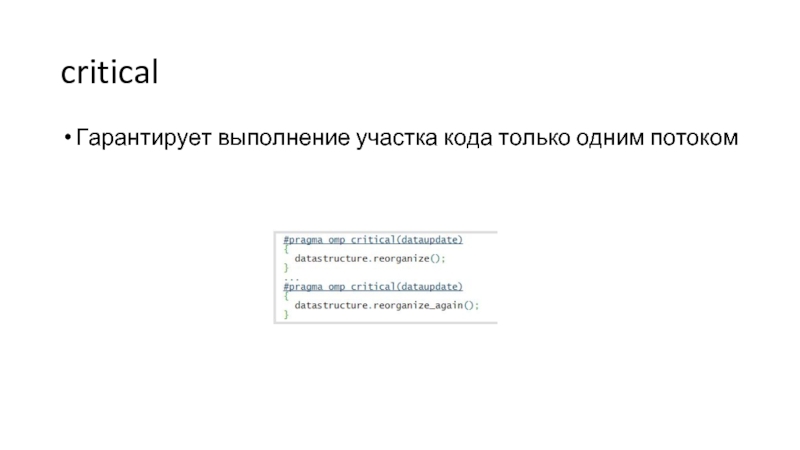

- 28. critical Гарантирует выполнение участка кода только одним потоком

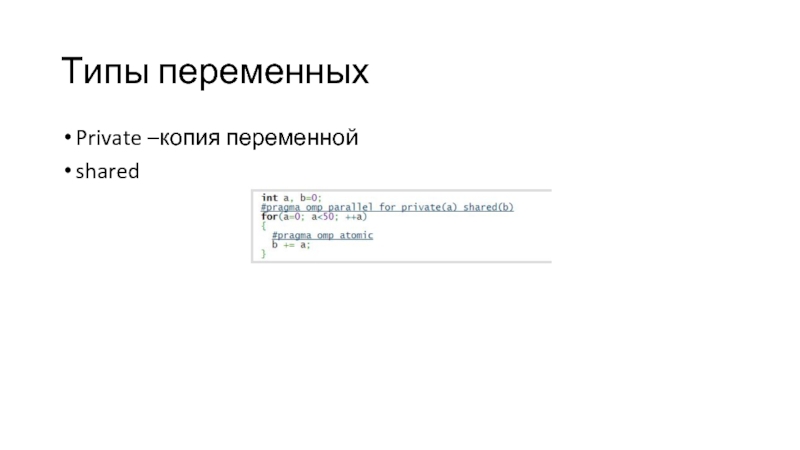

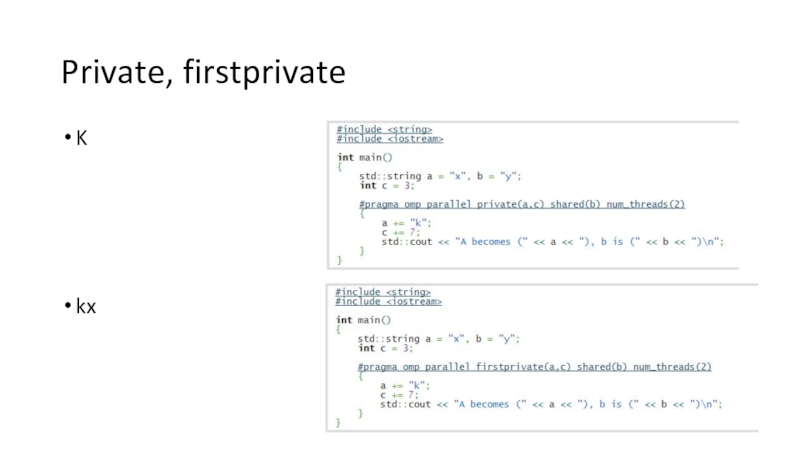

- 29. Типы переменных Private –копия переменной shared

- 30. Private, firstprivate K kx

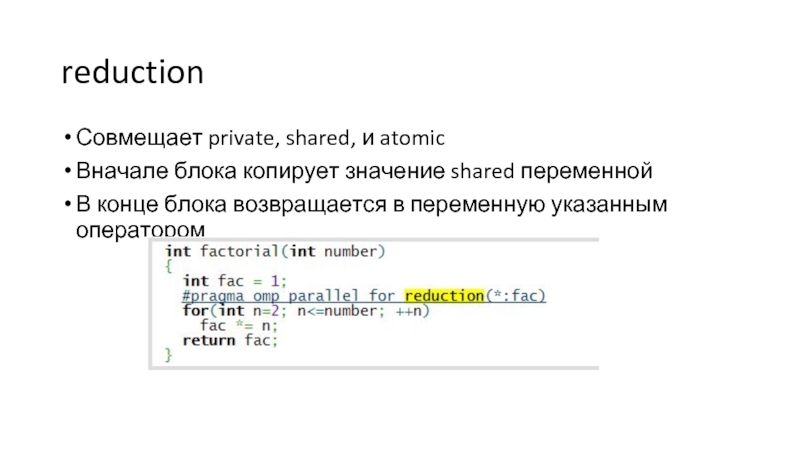

- 31. reduction Совмещает private, shared, и atomic Вначале

- 32. http://bisqwit.iki.fi/story/howto/openmp

Слайд 2Хотим все, сразу и бесплатно

Программисты всегда мечтали, что в их программы

параллелизм проберется сам, незаметно и не отвлекая их от более важных дел.

Слайд 3OpenMP

Открытый стандарт OpenMP Architecture Review Board

Windows, Linux, Mac OS X, Solaris

«Учредители»:

Слайд 4Поддержка OpenMP

Microsoft Visual Studio 2005 и 2008 поддерживает OpenMP 2.0 в

редакциях Professional и Team System, 2010 - в редакциях Professional, Premium и Ultimate, 2012 - во всех редакциях.

GCC 4.2 поддерживает OpenMP

Intel C++ Compiler поддерживает версию OpenMP 3.0.

GCC 4.2 поддерживает OpenMP

Intel C++ Compiler поддерживает версию OpenMP 3.0.

Слайд 6Что такое OpenMP?

OpenMP подразумевает маркировку параллельного кода специальными директивами. Параллелизация происходит

«почти автоматически».

Паралелльные участки кода соседствуют с последовательными

1997 г – Fortran,

1998 г – C++

ЧУДО!!!

Паралелльные участки кода соседствуют с последовательными

1997 г – Fortran,

1998 г – C++

ЧУДО!!!

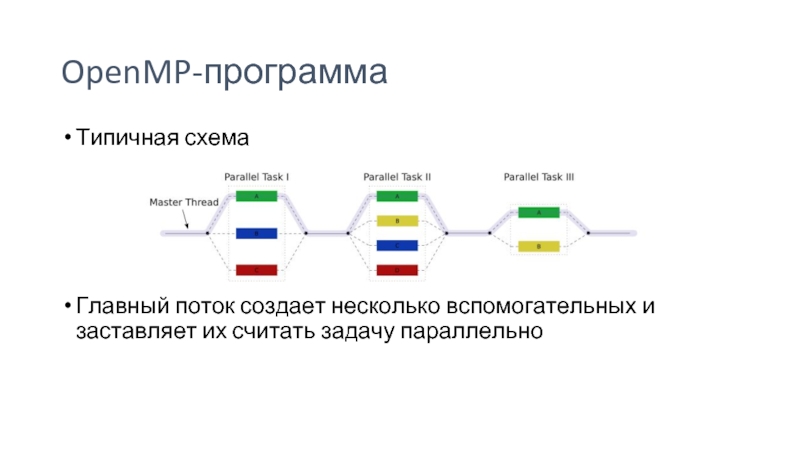

Слайд 7OpenMP-программа

Типичная схема

Главный поток создает несколько вспомогательных и заставляет их считать задачу

параллельно

Слайд 8Лучше один раз увидеть…

double a[N], b[N], c[N]; int i;

omp_set_dynamic(0);

omp_set_num_threads(10);

#pragma omp parallel

shared(a, b, c) private(i)

{

#pragma omp for

for (i = 0; i < N; i++)

c[i] = a[i] + b[i];

}

{

#pragma omp for

for (i = 0; i < N; i++)

c[i] = a[i] + b[i];

}

Слайд 9Формат директив

#pragma omp [directive] [clause [clause] …]

[directive] – название директивы

[clause] -

условие

Продление – «\» в конце

#pragma omp parallel private (i, j) \

shared (a, b, c)

Продление – «\» в конце

#pragma omp parallel private (i, j) \

shared (a, b, c)

Слайд 11Инкрементальный параллелизм

Не нужно выкидывать старую программу и писать новую

Можно постепенно переписывать

код на использование параллельных вычислений

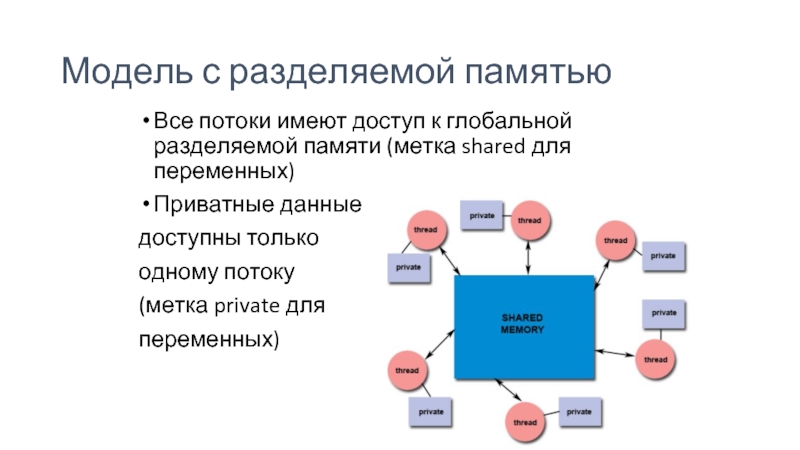

Слайд 12Модель с разделяемой памятью

Все потоки имеют доступ к глобальной разделяемой памяти

(метка shared для переменных)

Приватные данные

доступны только

одному потоку

(метка private для

переменных)

Приватные данные

доступны только

одному потоку

(метка private для

переменных)

Слайд 13По умолчанию

Все переменные shared общие, кроме:

Индексов параллельных циклов

Переменных, объявленных внутри параллельных

регионов

Слайд 15Parallel

Начинает параллельное выполнение блока в {}

Создает “команду” потоков

Количество потоков чаще всего

равняется количеству процессоров

После окончания блока количество потоков становится 1

После окончания блока количество потоков становится 1

Слайд 16Параллельный регион

Параллельный регион в OpenMP – блок кода, который исполняется всеми

потоками параллельно.

Слайд 21Циклы, которые нельзя распараллелить

Рекурсивные зависимости

for (int i = 1; i

n; ++i)

a[i] = a[i-1] + b[i];

Например, числа Фибоначчи

a[i] = a[i-1] + b[i];

Например, числа Фибоначчи

Слайд 22Зависимости

Решение зависимостей:

перегруппировка кода

переписывание алгоритмов

расстановка барьеров

Если зависимости есть, но мы с ними

ничего не сделали, компилятор не будет спорить, а программа будет работать неверно

Слайд 26Sections

Определяют, что должно быть параллельным

Work1, Work2 + Work3 and Work4 –

выполняются паралелльно, но Work2 + Work3 выполняются последовательно

Слайд 31reduction

Совмещает private, shared, и atomic

Вначале блока копирует значение shared переменной

В конце

блока возвращается в переменную указанным оператором

![Лучше один раз увидеть…double a[N], b[N], c[N]; int i;omp_set_dynamic(0);omp_set_num_threads(10);#pragma omp parallel shared(a, b, c) private(i){#pragma](/img/tmb/2/113803/02d5c7c6faadd48ef28795f996c9f69c-800x.jpg)

![Формат директив#pragma omp [directive] [clause [clause] …][directive] – название директивы[clause] - условиеПродление – «\» в](/img/tmb/2/113803/153810ff87ef1b2bb2e28d4fb9c63b00-800x.jpg)